Dossier Digitale Desinformation

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Deutscher Bundestag Drucksache 19/6961 11.01.2019 19

Deutscher Bundestag Drucksache 19/6961 11.01.2019 19. Wahlperiode ersetzt. - wird durch die lektorierte Version Vorabfassung Schriftliche Fragen mit den in der Woche vom 7. Januar 2019 eingegangenen Antworten der Bundesregierung Verzeichnis der Fragenden Abgeordnete Nummer Abgeordnete Nummer der Frage der Frage Amtsberg, Luise (BÜNDNIS 90/DIE GRÜNEN) .... 54 Dehm, Diether, Dr. (DIE LINKE.) ................... 29, 100 Andreae, Kerstin Domscheit-Berg, Anke (BÜNDNIS 90/DIE GRÜNEN) ................................ 24 (DIE LINKE.) ...................................... 30, 31, 74, 117 Badum, Lisa Ernst, Klaus (DIE LINKE.) .............................. 75, 118 (BÜNDNIS 90/DIE GRÜNEN) ........................ 55, 126 Faber, Marcus, Dr. (FDP) ....................................... 101 Baerbock, Annalena (BÜNDNIS 90/DIE GRÜNEN) Fricke, Otto (FDP) .............................................. 92, 93 ................................................................................. 114 Frömming, Götz, Dr. (AfD) ..................................... 61 Barrientos, Simone (DIE LINKE.) ..................... 1, 2, 3 Gastel, Matthias Bause, Margarete (BÜNDNIS 90/DIE GRÜNEN) ............................. 119 (BÜNDNIS 90/DIE GRÜNEN) .................... 25, 56, 57 Hänsel, Heike (DIE LINKE.) ................................... 76 Bayaz, Danyal, Dr. (BÜNDNIS 90/DIE GRÜNEN) .... 9, 10, 11, 12, 13, 14 Höferlin, Manuel (FDP) ..................................... 32, 33 Bayram, Canan Holm, Leif-Erik (AfD) ................................. 4, 5, 6, 34 (BÜNDNIS -

Drucksache 19/7724

Deutscher Bundestag Drucksache 19/7724 19. Wahlperiode 13.02.2019 Antrag der Abgeordneten Ulrike Schielke-Ziesing, Martin Hebner, Sebastian Münzenmaier, Jürgen Pohl, Jörg Schneider, Martin Sichert, René Springer, Uwe Witt, Marc Bernhard, Stephan Brandner, Marcus Bühl, Petr Bystron, Tino Chrupalla, Joana Cotar, Siegbert Droese, Dr. Michael Espendiller, Peter Felser, Dietmar Friedhoff, Dr. Anton Friesen, Markus Frohnmaier, Wilhelm von Gottberg, Kay Gottschalk, Armin-Paulus Hampel, Verena Hartmann, Dr. Roland Hartwig, Martin Hess, Karsten Hilse, Martin Hohmann, Dr. Bruno Hollnagel, Enrico Komning, Jörn König, Steffen Kotré, Rüdiger Lucassen, Dr. Birgit Malsack-Winkemann, Andreas Mrosek, Volker Münz, Christoph Neumann, Gerold Otten, Frank Pasemann, Martin Reichardt, Dr. Robby Schlund, Uwe Schulz, Thomas Seitz, Detlev Spangenberg, Dr. Dirk Spaniel, Dr. Harald Weyel, Dr. Christian Wirth und der Fraktion der AfD Sofortmaßnahme Armutsbekämpfung bei Rentnern Der Bundestag wolle beschließen: I. Der Deutsche Bundestag stellt fest: Die Höhe der Altersrente der gesetzlichen Rentenversicherung hängt im Wesentlichen von der Beitragsleistung ab, der sogenannten Beitragsäquivalenz. Die persönlichen Entgeltpunkte (§ 66 SGB VI) bilden dabei den individuellen Faktor der Rentenformel. Aus der grundsätzlich bestehenden Proportionalität zwischen Rentenansprüchen und Beitragszahlungen ergibt sich auch, dass die Verhinderung von Altersarmut system- bezogen nicht im Fokus steht. Dies gilt auch für die durch das „RV-Leistungsverbes- serungsgesetz“ vorgenommenen Verbesserungen hinsichtlich der Entgeltpunkte für Kindererziehungszeiten. Ein Teil der Altersrentner bezieht aus den unterschiedlichsten Gründen nur niedrige Renten, so etwa, weil sie mit Rücksicht auf die Kindererziehung über längere Zeit nicht oder nur in Teilzeit berufstätig waren, einen Familienangehörigen gepflegt haben, die Erwerbsbiografie aus gesundheitlichen Gründen unterbrochen wurde oder weil nur re- lativ niedrige Verdienste erzielt wurden. -

Drucksache 19/25305

Deutscher Bundestag Drucksache 19/25305 19. Wahlperiode 16.12.2020 Antrag der Abgeordneten Jörn König, Joana Cotar, Uwe Schulz, Dr. Michael Espendiller, Wolfgang Wiehle, Stephan Brandner, Peter Felser, Dr. Heiko Heßenkemper, Martin Hohmann, Stefan Keuter, Andreas Mrosek, Ulrich Oehme, Gerold Otten, Tobias Matthias Peterka, Dr. Robby Schlund, Uwe Schulz, Detlev Spangenberg, Dr. Dirk Spaniel, Dr. Christian Wirth und der Fraktion der AfD Steuerverwaltung mit Distributed-Ledger-Technologien – Zukunftsfähig durch Innovation im öffentlichen Sektor Der Bundestag wolle beschließen: I. Der Deutsche Bundestag stellt fest: In einer immer komplexer werdenden Gesellschaft, bei der Technologie in nahezu al- len Lebensbereichen unerlässlich geworden ist, fist das rühzeitige Erkennen der „Tech- nologie von Morgen“ von zentraler Bedeutung. Bei der Digitalisierung wünschen sich 75 % der Deutschen, dass Deutschland in diesem Bereich Spitzenreiter wird (https://gblogs.cisco.com/de/die-deutschen-wollen-bei-digitalisierung-weltspitze- sein/). In der Realität jedoch ist die Tendenz eine andere. Im aktuellen Cisco Digital Readiness Report von 2019 ist Deutschland von Rang 6 auf Rang 14 gerutscht. Mit- hilfe dieses Indexes kann der digitale Reifegrad eines Landes international gemessen werden. Dies liegt darin begründet, dass andere Länder bessere Rahmenbedingungen für die Digitalisierung schaffen als Deutschland. Um dieser Entwicklung entgegenzuwirken, müssen die großen Potentiale der moder- nen Technologien durch den Staat erkannt werden und schnellstmöglich -

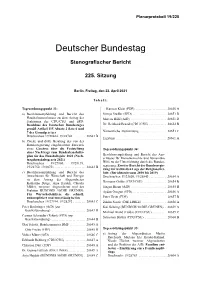

Plenarprotokoll 19/225

Plenarprotokoll 19/225 Deutscher Bundestag Stenografischer Bericht 225. Sitzung Berlin, Freitag, den 23. April 2021 Inhalt: Tagesordnungspunkt 33: Karsten Klein (FDP) . 28650 A a) Beschlussempfehlung und Bericht des Svenja Stadler (SPD) . 28651 B Haushaltsausschusses zu dem Antrag der Marcus Bühl (AfD) . 28651 D Fraktionen der CDU/CSU und SPD: Beschluss des Deutschen Bundestages Dr. Reinhard Brandl (CDU/CSU) . 28652 B gemäß Artikel 115 Absatz 2 Satz 6 und 7 des Grundgesetzes Namentliche Abstimmung . 28653 C Drucksachen 19/28464, 19/28740 . 28643 B Ergebnis . 28661 A b) Zweite und dritte Beratung des von der Bundesregierung eingebrachten Entwurfs eines Gesetzes über die Feststellung Tagesordnungspunkt 34: eines Nachtrags zum Bundeshaushalts- plan für das Haushaltsjahr 2021 (Nach- Beschlussempfehlung und Bericht des Aus- tragshaushaltsgesetz 2021) schusses für Menschenrechte und humanitäre Drucksachen 19/27800, 19/28139, Hilfe zu der Unterrichtung durch die Bundes- 19/28750, 19/28751 . 28643 B regierung: Zweiter Bericht der Bundesregie- rung zur weltweiten Lage der Religionsfrei- c) Beschlussempfehlung und Bericht des heit: (Berichtszeitraum 2018 bis 2019) Ausschusses für Wirtschaft und Energie Drucksachen 19/23820, 19/28843 . 28654 A zu dem Antrag der Abgeordneten Katharina Dröge, Anja Hajduk, Claudia Hermann Gröhe (CDU/CSU) . 28654 B Müller, weiterer Abgeordneter und der Jürgen Braun (AfD) . 28655 B Fraktion BÜNDNIS 90/DIE GRÜNEN: Aydan Özoğuz (SPD) . 28656 A Für Wirtschaftshilfen, die schnell, unkompliziert und zuverlässig helfen Peter Heidt (FDP) . 28657 B Drucksachen 19/27194, 19/28292 . 28643 C Zaklin Nastic (DIE LINKE) . 28658 A Peter Boehringer (AfD) (zur Kai Gehring (BÜNDNIS 90/DIE GRÜNEN) . 28659 A Geschäftsordnung) . 28643 D Michael Brand (Fulda) (CDU/CSU) . 28659 C Carsten Schneider (Erfurt) (SPD) (zur Sebastian Brehm (CDU/CSU) . -

Drucksache 19/11708 19

Deutscher Bundestag Drucksache 19/11708 19. Wahlperiode 16.07.2019 Kleine Anfrage der Abgeordneten Petr Bystron, Jürgen Braun, Dr. Lothar Maier, Dr. Rainer Kraft, Waldemar Herdt, Dr. Harald Weyel, Udo Theodor Hemmelgarn, Stefan Keuter, Andreas Mrosek, Enrico Komning, Martin Sichert, Paul Viktor Podolay, Jörn König, Uwe Witt, Franziska Gminder, Dr. Heiko Heßenkemper, Kay Gottschalk, Thomas Seitz, Jens Maier, Stephan Protschka, Martin Hess, Joana Cotar, Armin-Paulus Hampel, Wilhelm von Gottberg, Steffen Kotré, Thomas Ehrhorn, Tobias Matthias Peterka, Dietmar Friedhoff, Peter Boehringer und der Fraktion der AfD Hintergründe der Befreiung von Billy Six aus Venezuela Am 18. März 2019 kehrte der deutsche Journalist Billy Six nach Deutschland zu- rück. Zuvor hatte er 119 Tage in venezolanischer Haft verbracht – davon haupt- sächlich im berüchtigten Gefängnis „El Helicoide“, einer Einrichtung des politi- schen Geheimdiensts SEBIN (www.berliner-zeitung.de/32228696?dmcid=sm_tw). Billy Six ist am 17. November 2018 in Venezuela verhaftet worden. Dies auf- grund seiner Tätigkeit als freischaffender Reporter, der über die angespannte Lage des Landes berichtet hatte (www.spiegel.de/politik/ausland/venezuela- deutscher-reporter-billy-six-in-venezuela-verhaftet-a-1244013.html). Als Zivilist ist er vor einem Militärgericht unter anderem wegen „Spionage“ und „Rebellion“ angeklagt worden. Diese Vorwürfe wurden bereits vor seiner Haftentlassung vom 15. März 2019 fallen gelassen (www.tagesspiegel.de/politik/billy-six-deutscher- reporter-aus-haft-in-venezuela-entlassen/24110970.html). -

Drucksache 19/2392

Deutscher Bundestag Drucksache 19/2392 19. Wahlperiode 30.05.2018 Antrag der Abgeordneten Dr. Bernd Baumann, Marc Bernhard, Andreas Bleck, Peter Boehringer, Stephan Brandner, Jürgen Braun, Marcus Bühl, Matthias Büttner, Petr Bystron, Tino Chrupalla, Joana Cotar, Dr. Gottfried Curio, Siegbert Droese, Thomas Ehrhorn, Berengar Elsner von Gronow, Dr. Michael Espendiller, Peter Felser, Dietmar Friedhoff, Dr. Anton Friesen, Dr. Götz Frömming, Markus Frohnmaier, Dr. Alexander Gauland, Dr. Axel Gehrke, Albrecht Glaser, Franziska Gminder, Wilhelm von Gottberg, Kay Gottschalk, Armin-Paulus Hampel, Mariana Harder-Kühnel, Verena Hartmann, Dr. Roland Hartwig, Jochen Haug, Martin Hebner, Udo Theodor Hemmelgarn, Waldemar Herdt, Lars Herrmann, Martin Hess, Dr. Heiko Heßenkemper, Karsten Hilse, Nicole Höchst, Martin Hohmann, Dr. Bruno Hollnagel, Leif-Erik Holm, Johannes Huber, Fabian Jacobi, Dr. Marc Jongen, Uwe Kamann, Jens Kestner, Stefan Keuter, Norbert Kleinwächter, Enrico Komning, Jörn König, Steffen Kotré, Dr. Rainer Kraft, Rüdiger Lucassen, Frank Magnitz, Jens Maier, Dr. Lothar Maier, Dr. Birgit Malsack-Winkemann, Corinna Miazga, Andreas Mrosek, Hansjörg Müller, Volker Münz, Sebastian Münzenmaier, Christoph Neumann, Jan Ralf Nolte, Ulrich Oehme, Gerold Otten, Frank Pasemann, Tobias Matthias Peterka, Paul Viktor Podolay, Jürgen Pohl, Stephan Protschka, Martin Reichardt, Martin Erwin Renner, Roman Reusch, Ulrike Schielke-Ziesing, Dr. Robby Schlund, Jörg Schneider, Uwe Schulz, Thomas Seitz, Martin Sichert, Detlev Spangenberg, Dr. Dirk Spaniel, René Springer, Beatrix von Storch, Dr. Alice Weidel, Dr. Harald Weyel, Wolfgang Wiehle, Dr. Heiko Wildberg, Dr. Christian Wirth, Uwe Witt und der Fraktion der AfD Einsetzung eines Untersuchungsausschusses Asyl- und Migrationspolitik Der Bundestag wolle beschließen: A. Der Deutsche Bundestag beschließt: Es wird ein Untersuchungsausschuss gemäß Artikel 44 des Grundgesetzes eingesetzt. -

Vorabfassung

Deutscher Bundestag Drucksache 19/30438 19. Wahlperiode 09.06.2021 Beschlussempfehlung und Bericht des Verteidigungsausschusses (12. Ausschuss) zu dem Antrag der Abgeordneten Joana Cotar, Uwe Schulz, Dr. Michael Espendiller, weiterer Abgeordneter und der Fraktion der AfD – Drucksache 19/29783 – Anreizprogramme für IT-Sicherheit bei der Bundeswehr ausbauen A. Problem Die immer weiter voranschreitende Digitalisierung der Bundeswehr betreffe die gesamten Organisationsstrukturen über alle Einheiten hinweg. Für die Streitkräfte sei die Digitalisierung der Schlüssel zur Informations-, Führungs- und Wirkungs- überlegenheit wie auch zur Verbesserung der Durchsetzungs- und Reaktionsfä- higkeit. Die Komplexität der IT-Infrastruktur stelle die Bundeswehr hinsichtlich eines sicheren Betriebs der zum Einsatz kommenden Technologien vor besondere Herausforderungen. Eine wesentliche Gefahr seien Hacker-Angriffe. Es sei davon auszugehen, dass der Umfang an Bedrohungen in Zukunft noch weiter steigen. Um diesen Bedrohungen entgegenzuwirken, betreibe die Bundeswehr seit Okto- ber 2020 ein Bug Bounty-Programm namens Vulnerability Disclosure Policy (VDPBw). Hierbei überprüften sogenannte White Hat Hacker die IT-Infrastruktur auf sicherheitsrelevante Schwachstellen. Momentan sei das Bug Bounty-Pro- gramm der Bundewehr für White Hat Hacker weitestgehend unattraktiv, da die Bundeswehr lediglich eine Danksagung auf ihrer Webseite anbiete. Andere Län- der wie die Vereinigten Staaten von Amerika hätten hier bereits eine Vorreiter- rolle inne. B. Lösung Ablehnung -

Plenarprotokoll 19/167

Plenarprotokoll 19/167 Deutscher Bundestag Stenografischer Bericht 167. Sitzung Berlin, Freitag, den 19. Juni 2020 Inhalt: Tagesordnungspunkt 26: Zusatzpunkt 25: a) Erste Beratung des von den Fraktionen der Erste Beratung des von den Fraktionen der CDU/CSU und SPD eingebrachten Ent- CDU/CSU und SPD eingebrachten Entwurfs wurfs eines Zweiten Gesetzes zur Umset- eines Gesetzes über begleitende Maßnah- zung steuerlicher Hilfsmaßnahmen zur men zur Umsetzung des Konjunktur- und Bewältigung der Corona-Krise (Zweites Krisenbewältigungspakets Corona-Steuerhilfegesetz) Drucksache 19/20057 . 20873 D Drucksache 19/20058 . 20873 B in Verbindung mit b) Erste Beratung des von der Bundesregie- rung eingebrachten Entwurfs eines Zwei- ten Gesetzes über die Feststellung eines Zusatzpunkt 26: Nachtrags zum Bundeshaushaltsplan Antrag der Fraktionen der CDU/CSU und für das Haushaltsjahr 2020 (Zweites SPD: Beschluss des Bundestages gemäß Ar- Nachtragshaushaltsgesetz 2020) tikel 115 Absatz 2 Satz 6 und 7 des Grund- Drucksache 19/20000 . 20873 B gesetzes Drucksache 19/20128 . 20874 A c) Antrag der Abgeordneten Kay Gottschalk, Marc Bernhard, Jürgen Braun, weiterer Abgeordneter und der Fraktion der AfD: in Verbindung mit Arbeitnehmer, Kleinunternehmer, Frei- berufler, Landwirte und Solo-Selbstän- Zusatzpunkt 27: dige aus der Corona-Steuerfalle befreien Antrag der Abgeordneten Dr. Dirk Spaniel, und gleichzeitig Bürokratie abbauen Wolfgang Wiehle, Leif-Erik Holm, weiterer Drucksache 19/20071 . 20873 C Abgeordneter und der Fraktion der AfD: d) Antrag der Abgeordneten Caren Lay, Deutscher Automobilindustrie zeitnah hel- Simone Barrientos, Dr. Gesine Lötzsch, fen, Bahnrettung statt Konzernrettung, Be- weiterer Abgeordneter und der Fraktion richte des Bundesrechnungshofs auch in DIE LINKE: Clubs und Festivals über der Krise beachten und umsetzen die Corona-Krise retten Drucksache 19/20072 . -

Framing of “Us-Vs-Them” in Right-Wing Communication How Tweets Are Used As Forms of Communication by a German Right-Wing Party

HELSINGIN YLIOPISTO UNIVERSITY OF HELSINKI FACULTY OF SOCIAL SCIENCES FRAMING OF “US-VS-THEM” IN RIGHT-WING COMMUNICATION HOW TWEETS ARE USED AS FORMS OF COMMUNICATION BY A GERMAN RIGHT-WING PARTY MASTER’S THESIS BY ANNA-LENA KRUG Tiedekunta – Fakultet – Faculty Koulutusohjelma – Utbildingsprogram – Degree Programme Faculty of Social Sciences Global Politics and Communication Tekijä – Författare – Author Anna-Lena Krug Työn nimi – Arbetets titel – Title Framing of ”Us-vs.-Them” in Right-Wing Communication – How Tweets are used as Forms of Communication by a German Right- Wing Party Oppiaine/Opintosuunta – Läroämne/Studieinriktning – Subject/Study track Governance, Organisations and Communication Työn laji – Arbetets art – Level Aika – Datum – Month and year Sivumäärä – Sidoantal – Number of pages Master’s of Social Sciences May 2020 85 Tiivistelmä – Referat – Abstract The world in which we live and communicate is complicated and complex. This is also true for political communication, which has moved, in some part, to newer forms of media, such as social media platforms. Politicians have gained the opportunity to communicate directly with their followers online, without any mediators. This allows political actors to present the image of themselves and the version of reality they want to convey. Twitter is one example of such a platform, which provides an interactive channel of communication between political actors and their audience. This thesis aims to analyse how the 280 characters long tweets are used as forms of communication by employing and combining Erving Goffman’s concepts of framing and self-presentation. Frames are interpretative frameworks which are activated by our brains to make sense of situations and events and the understanding of self-presentation describes how actors portray themselves in social settings. -

Wird Durch Die Lektorierte Fassung Ersetzt. Vorabfassung Deutscher Bundestag Drucksache 19/17787

Vorabfassung - wird durch die lektorierte Fassung ersetzt. Deutscher Bundestag Drucksache 19/17787 19. Wahlperiode 11.03.2020 Antrag der Abgeordneten Uwe Witt, Jürgen Pohl, Ulrike Schielke-Ziesing, Jörg Schneider, Martin Sichert, René Springer, Marc Bernhard, Stephan Brandner, Jürgen Braun, Joana Cotar, Dr. Gottfried Curio, Siegbert Droese, Thomas Ehrhorn, Peter Felser, Dietmar Friedhoff, Dr. Anton Friesen, Markus Frohnmaier, Dr. Götz Frömming, Wilhelm von Gottberg, Kay Gottschalk, Armin-Paulus Hampel, Marianna Harder-Kühnel, Udo Hemmelgarn, Dr. Heiko Heßenkemper, Karsten Hilse, Martin Hohmann, Norbert Kleinwächter, Jörn König, Steffen Kotré, Dr. Rainer Kraft, Rüdiger Lucassen, Frank Magnitz, Jens Maier, Volker Münz, Sebastian Münzenmaier, Jan Ralf Nolte, Ulrich Oehme, Gerold Otten, Frank Pasemann, Martin Reichardt, Dr. Robby Schlund, Detlev Spangenberg, Dr. Dirk Spaniel, René Springer, Dr. Harald Weyel, Dr. Christian Wirth und der Fraktion der AfD Auszahlungen von Sozialleistungen auf ausländische Konten Der Bundestag wolle beschließen: I. Der Deutsche Bundestag stellt fest: u. a. mit dem SEPA-Begleitgesetz (BT-Drs. 17/10038) wurden durch Änderungen bundesgesetzlicher Vorschriften die Auszahlung von Leistungen nach den Sozialgesetzbüchern auf Konten zugelassen, für welche die Verordnung (EU) Nr. 260/2012 des Europäischen Parlaments und des Rates vom 14. März 2012 zur Festlegung der technischen Vorschriften und der Geschäftsanforderungen für Überweisungen und Lastschriften in Euro und zur Änderung der Verordnung (EG) Nr. 924/2009 gilt. Damit sollten die Vorgaben der vorgenannten Verordnung in nationales Recht übernommen werden. Die Angabe einer ausländischen Bankverbindung im Rahmen des Leistungsantrags ist nicht nur hinsichtlich der Gewährleistung des Sicherstellungsauftrags der Sozialleistungsträger nach § 17 SGB I, sondern auch für das Forderungsmanagement eine Herausforderung. So wird beispielsweise das vom Bundeszentralamt für Steuern (BZSt) durchgeführte Kontenabrufverfahren (§ 93(b) Abgabenordnung) bislang nur für inländische Bankverbindungen bzw. -

20210421 6-Data.Pdf

Deutscher Bundestag 223. Sitzung des Deutschen Bundestages am Mittwoch, 21. April 2021 Endgültiges Ergebnis der Namentlichen Abstimmung Nr. 6 Gesetzentwurf der Fraktionen der CDU/CSU und SPD Entwurf eines Vierten Gesetzes zum Schutz der Bevölkerung bei einer epidemischen Lage von nationaler Tragweite - Drs. 19/28444, 19/28692 und 19/28732 Abgegebene Stimmen insgesamt: 656 Nicht abgegebene Stimmen: 53 Ja-Stimmen: 342 Nein-Stimmen: 250 Enthaltungen: 64 Ungültige: 0 Berlin, den 21.04.2021 Beginn: 14:53 Ende: 15:27 Seite: 1 Seite: 2 Seite: 2 CDU/CSU Name Ja Nein Enthaltung Ungült. Nicht abg. Dr. Michael von Abercron X Stephan Albani X Norbert Maria Altenkamp X Peter Altmaier X Philipp Amthor X Artur Auernhammer X Peter Aumer X Dorothee Bär X Thomas Bareiß X Norbert Barthle X Maik Beermann X Manfred Behrens (Börde) X Veronika Bellmann X Sybille Benning X Dr. André Berghegger X Melanie Bernstein X Christoph Bernstiel X Peter Beyer X Marc Biadacz X Steffen Bilger X Peter Bleser X Norbert Brackmann X Michael Brand (Fulda) X Dr. Reinhard Brandl X Dr. Helge Braun X Silvia Breher X Sebastian Brehm X Heike Brehmer X Ralph Brinkhaus X Dr. Carsten Brodesser X Gitta Connemann X Astrid Damerow X Alexander Dobrindt X Michael Donth X Marie-Luise Dött X Hansjörg Durz X Thomas Erndl X Dr. Dr. h. c. Bernd Fabritius X Hermann Färber X Uwe Feiler X Enak Ferlemann X Axel E. Fischer (Karlsruhe-Land) X Dr. Maria Flachsbarth X Thorsten Frei X Dr. Hans-Peter Friedrich (Hof) X Maika Friemann-Jennert X Michael Frieser X Hans-Joachim Fuchtel X Ingo Gädechens X Dr. -

Plenarprotokoll 19/224

Plenarprotokoll 19/224 Deutscher Bundestag Stenografischer Bericht 224. Sitzung Berlin, Donnerstag, den 22. April 2021 Inhalt: Tagesordnungspunkt 10: sierungsgesetz – Den Schutz von Ver- braucherinnen und Verbrauchern in a) – Zweite und dritte Beratung des von der den Mittelpunkt stellen Bundesregierung eingebrachten Ent- wurfs eines Gesetzes zur Umsetzung – zu dem Antrag der Abgeordneten der Richtlinie (EU) 2018/1972 des Dr. Konstantin von Notz, Tabea Rößner, Europäischen Parlaments und des Margit Stumpp, weiterer Abgeordneter Rates vom 11. Dezember 2018 über und der Fraktion BÜNDNIS 90/DIE den europäischen Kodex für die elekt- GRÜNEN: Telekommunikationsmo- ronische Kommunikation (Neufas- dernisierungsgesetz – Datenschutz, sung) und zur Modernisierung des IT-Sicherheit und Bürgerrechte Telekommunikationsrechts (Telekom- sichern munikationsmodernisierungsgesetz) Drucksachen 19/26117, 19/26531, Drucksachen 19/26108, 19/26964, 19/26532, 19/26533, 19/28865 . 28401 D 19/27035 Nr. 1.9, 19/28865 . 28401 B d) Beschlussempfehlung und Bericht des – Bericht des Haushaltsausschusses ge- Ausschusses für Inneres und Heimat zu mäß § 96 der Geschäftsordnung dem Antrag der Abgeordneten Jimmy Drucksache 19/28866 . 28401 B Schulz, Stephan Thomae, Renata Alt, wei- terer Abgeordneter und der Fraktion der b) Beschlussempfehlung und Bericht des FDP: Recht auf Verschlüsselung – Pri- Ausschusses für Wirtschaft und Energie vatsphäre und Sicherheit im digitalen – zu dem Antrag der Abgeordneten Raum stärken Reinhard Houben, Manuel Höferlin, Drucksachen 19/5764, 19/27325 . 28401 D Michael Theurer, weiterer Abgeordneter e) Beschlussempfehlung und Bericht des und der Fraktion der FDP: Gigabit-Aus- Ausschusses für Verkehr und digitale In- bau voranbringen – Upgrade für das frastruktur zu dem Antrag der Abgeordne- Nebenkostenprivileg ten Daniela Kluckert, Frank Sitta, – zu dem Antrag der Abgeordneten Margit Grigorios Aggelidis, weiterer Abgeordne- Stumpp, Tabea Rößner, Dr.