Digitale Archive Und Bibliotheken

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Annual Report 2018–2019 Artmuseum.Princeton.Edu

Image Credits Kristina Giasi 3, 13–15, 20, 23–26, 28, 31–38, 40, 45, 48–50, 77–81, 83–86, 88, 90–95, 97, 99 Emile Askey Cover, 1, 2, 5–8, 39, 41, 42, 44, 60, 62, 63, 65–67, 72 Lauren Larsen 11, 16, 22 Alan Huo 17 Ans Narwaz 18, 19, 89 Intersection 21 Greg Heins 29 Jeffrey Evans4, 10, 43, 47, 51 (detail), 53–57, 59, 61, 69, 73, 75 Ralph Koch 52 Christopher Gardner 58 James Prinz Photography 76 Cara Bramson 82, 87 Laura Pedrick 96, 98 Bruce M. White 74 Martin Senn 71 2 Keith Haring, American, 1958–1990. Dog, 1983. Enamel paint on incised wood. The Schorr Family Collection / © The Keith Haring Foundation 4 Frank Stella, American, born 1936. Had Gadya: Front Cover, 1984. Hand-coloring and hand-cut collage with lithograph, linocut, and screenprint. Collection of Preston H. Haskell, Class of 1960 / © 2017 Frank Stella / Artists Rights Society (ARS), New York 12 Paul Wyse, Canadian, born United States, born 1970, after a photograph by Timothy Greenfield-Sanders, American, born 1952. Toni Morrison (aka Chloe Anthony Wofford), 2017. Oil on canvas. Princeton University / © Paul Wyse 43 Sally Mann, American, born 1951. Under Blueberry Hill, 1991. Gelatin silver print. Museum purchase, Philip F. Maritz, Class of 1983, Photography Acquisitions Fund 2016-46 / © Sally Mann, Courtesy of Gagosian Gallery © Helen Frankenthaler Foundation 9, 46, 68, 70 © Taiye Idahor 47 © Titus Kaphar 58 © The Estate of Diane Arbus LLC 59 © Jeff Whetstone 61 © Vesna Pavlovic´ 62 © David Hockney 64 © The Henry Moore Foundation / Artists Rights Society (ARS), New York 65 © Mary Lee Bendolph / Artist Rights Society (ARS), New York 67 © Susan Point 69 © 1973 Charles White Archive 71 © Zilia Sánchez 73 The paper is Opus 100 lb. -

University of Oklahoma Graduate College Performing Gender: Hell Hath No Fury Like a Woman Horned a Thesis Submitted to the Gradu

UNIVERSITY OF OKLAHOMA GRADUATE COLLEGE PERFORMING GENDER: HELL HATH NO FURY LIKE A WOMAN HORNED A THESIS SUBMITTED TO THE GRADUATE FACULTY in partial fulfillment of the requirements for the Degree of MASTER OF ARTS By GLENN FLANSBURG Norman, Oklahoma 2021 PERFORMING GENDER: HELL HATH NO FURY LIKE A WOMAN HORNED A THESIS APPROVED FOR THE GAYLORD COLLEGE OF JOURNALISM AND MASS COMMUNICATION BY THE COMMITTEE CONSISTING OF Dr. Ralph Beliveau, Chair Dr. Meta Carstarphen Dr. Casey Gerber © Copyright by GLENN FLANSBURG 2021 All Rights Reserved. iv TABLE OF CONTENTS Abstract ........................................................................................................................................... vi Introduction .................................................................................................................................... 1 Heavy Metal Reigns…and Quickly Dies ....................................................................................... 1 Music as Discourse ...................................................................................................................... 2 The Hegemony of Heavy Metal .................................................................................................. 2 Theory ......................................................................................................................................... 3 Encoding/Decoding Theory ..................................................................................................... 3 Feminist Communication -

Album Reviews

Album Reviews I’ve written over 150 album reviews as a volunteer for CHIRPRadio.org. Here are some examples, in alphabetical order: Caetano Veloso Caetano Veloso (A Little More Blue) Polygram / 1971 Brazilian Caetano Veloso’s third self-titled album was recorded in England while in exile after being branded ‘subversive’ by the Brazilian government. Under colorful plumes of psychedelic folk, these songs are cryptic stories of an outsider and traveller, recalling both the wonder of new lands and the oppressiveness of the old. The whole album is recommended, but gems include the autobiographical “A Little More Blue” with it’s Brazilian jazz acoustic guitar, the airy flute and warm chorus of “London, London” and the somber Baroque folk of “In the Hot Sun of a Christmas Day” tells the story of tragedy told with jazzy baroque undertones of “God Rest Ye Merry Gentlemen.” The Clash London Calling Epic / 1979 London Calling, considered one of the greatest rock & roll albums ever recorded, is far from a straightforward: punk, reggae, ska, R&B and rockabilly all have tickets to this show of force that’s both pop and revolutionary. The title track opens with a blistering rallying cry of ska guitar and apocalypse. The post-disco “Clampdown” is a template for the next decade, a perfect mix of gloss and message. “The Guns of Brixton” is reggae-punk in that order, with rocksteady riffs and rock drums creating an intense portrait of defiance. “Train in Vain” is a harmonica puffing, Top 40 gem that stands at the crossroads of punk and rock n’ roll. -

Janette Cohen Scalie Redoctane +46 (0)8 44 18 615 [email protected]

FOR IMMEDIATE RELEASE For media inquiries, please contact: Janette Cohen Scalie RedOctane +46 (0)8 44 18 615 [email protected] GUITAR HERO® CATALOG EXPANDS WITH NEW MUSIC FROM ROCK ‘N’ ROLL ICONS QUEEN AND JIMI HENDRIX THIS MONTH Six Additional Tracks from Countries throughout Europe and the James Bond Theme Song Further Add to Guitar Hero World Tour’s Downloadable Content Set List SANTA MONICA, CA – March 3, 2009 – This month, gamers will again be able to expand their virtual set lists with over a dozen new downloadable tracks for Activision Publishing, Inc.’s (Nasdaq: ATVI) Guitar Hero® World Tour. With over 37 million songs downloaded for the franchise to date, Guitar Hero® fans will soon be able to experience more awesome music – from the likes of English rock ‘n’ roll icons Queen, guitar legend Jimi Hendrix, a host of European superstars and more – which will join the more than 550 songs rocking the Guitar Hero catalog already. On March 5th, Guitar Hero World Tour’s global music library will continue to grow with three additional tracks from some of Europe’s greatest bands. The third European Track Pack, which includes the hit song “Break It Out” by Italian pop punk band Vanilla Sky and “In the Shadows” by one of Finland’s most successful bands, The Rasmus, will also contain “Cʹest Comme Ça” the top single from French pop rock duo Les Rita Mitsouko’s 1986 album The No Comprendo. As a follow‐up to the third European Track Pack, rockers from the Netherlands, Germany and Spain will also be contributing to Guitar Hero World Tour’s increasing catalog of downloadable content. -

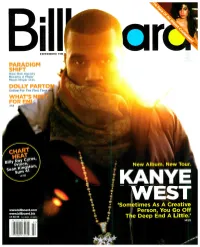

`Sometimes As a Creative

EXPERIENCE THE PARADIGM SHIFT How One Agency Became A Major Music Player >P.25 DOLLY PARTO Online For The First Tim WHAT'S FOR >P.8 New Album. New Tour. KANYE WEST `Sometimes As A Creative www.billboard.com Person, You Go Off www.billboard.biz US $6.99 CAN $8.99 UK E5.50 The Deep End A Little.' >P.22 THE YEAR MARK ROHBON VERSION THE CRITICS AIE IAVIN! "HAVING PRODUCED AMY WINEHOUSE AND LILY ALLEN, MARK RONSON IS ON A REAL ROLL IN 2007. FEATURING GUEST VOCALISTS LIKE ALLEN, IN NOUS AND ROBBIE WILLIAMS, THE WHOLE THING PLAYS LIKE THE ULTIMATE HIPSTER PARTY MIXTAPE. BEST OF ALL? `STOP ME,' THE MOST SOULFUL RAVE SINCE GNARLS BARKLEY'S `CRAZY." PEOPLE MAGAZINE "RONSON JOYOUSLY TWISTS POPULAR TUNES BY EVERYONE FROM RA TO COLDPLAY TO BRITNEY SPEARS, AND - WHAT DO YOU KNOW! - IT TURNS OUT TO BE THE MONSTER JAM OF THE SEASON! REGARDLESS OF WHO'S OH THE MIC, VERSION SUCCEEDS. GRADE A" ENT 431,11:1;14I WEEKLY "THE EMERGING RONSON SOUND IS MOTOWN MEETS HIP -HOP MEETS RETRO BRIT -POP. IN BRITAIN, `STOP ME,' THE COVER OF THE SMITHS' `STOP ME IF YOU THINK YOU'VE HEARD THIS ONE BEFORE,' IS # 1 AND THE ALBUM SOARED TO #2! COULD THIS ROCK STAR DJ ACTUALLY BECOME A ROCK STAR ?" NEW YORK TIMES "RONSON UNITES TWO ANTITHETICAL WORLDS - RECENT AND CLASSIC BRITPOP WITH VINTAGE AMERICAN R &B. LILY ALLEN, AMY WINEHOUSE, ROBBIE WILLIAMS COVER KAISER CHIEFS, COLDPLAY, AND THE SMITHS OVER BLARING HORNS, AND ORGANIC BEATS. SHARP ARRANGING SKILLS AND SUITABLY ANGULAR PERFORMANCES! * * * *" SPIN THE SOUNDTRACK TO YOUR SUMMER! THE . -

12.16 11 Cadogan Gardens, London the Royal Mint

12.16 Cover 11 CADOGAN GARDENS, LONDON Blavatnik School of A revealing renovation of a boutique Chelsea Government, hotel proves a test for ReardonSmith Oxford University The Herzog & de Meuron building’s structure bags an international award THE ROYAL MINT EXPERIENCE for Pell Frischmann A presentation box of a visitor centre in Wales page 05 SPECIFY JJI-JOISTS AND WE’LL GIVE YOU AN I-FULL. You can rely on JJI-Joists to succeed–whatever the challenge, because JJI-Joists are jam packed with features to make your life easier, and the job quicker. We are the most popular I-Joist in the UK and the I-joist most specified by architects and engineers. So, whether designing or building, choose JJI-Joists with confidence. You’ll find there’s so much more to them than meets the eye. WEB: www.jamesjones.co.uk/ewp EMAIL: [email protected] CONTENTS 12.16 NEWS, VIEWS & INSIGHTS PRODUCTS 04 Industry news & events 41 Planning & design 12 International Focus 42 Structural elements 14 CPD Focus 42 Groundworks 15 Viewpoint 48 External envelope 27 Nigel Ostime of Hawkins\Brown 62 Insulation Architects 62 Heating, ventilation & services 17 Practice Profile 66 Interiors Norman Hayden meets 2020 70 Accessibility Architects – a Northern Irish team 73 Safety & security with a vision 74 Landscaping & external works 19 Appointments & news 75 Classified & directory PROJECT REPORTS 27 A case of presentation Rio Architects has brought some creative sparkle to its design for a visitor centre near Cardiff which shines a light on the work of The Royal Mint. Ray Philpott investigates 35 Revealing Victorian secrets The sensitive interior upgrade of a boutique hotel in Chelsea revealed itself to be an even bigger challenge for the architects, once they discovered the myriad of secrets the building held. -

Emergindo Das Trevas: Análise Do Discurso Metal Sinfônico Em Within Temptation

UNIVERSIDADE PRESBITERIANA MACKENZIE PROGRAMA DE PÓS-GRADUAÇÃO EM LETRAS MESTRADO EM LETRAS TALES DOS SANTOS EMERGINDO DAS TREVAS: ANÁLISE DO DISCURSO METAL SINFÔNICO EM WITHIN TEMPTATION São Paulo 2017 TALES DOS SANTOS EMERGINDO DAS TREVAS: ANÁLISE DO DISCURSO METAL SINFÔNICO EM WITHIN TEMPTATION Dissertação de mestrado apresentada à banca examinadora da Universidade Presbiteriana Mackenzie como requisito parcial para a obtenção do título de Mestre em Letras. Orientadora: Profa. Dra. Neusa Maria Oliveira Barbosa Bastos. São Paulo 2017 S237e Santos, Tales dos. Emergindo das trevas: análise do discurso metal sinfônico em Within Temptation / Tales dos Santos – São Paulo, 2017. 112 f. : il. ; 30 cm. Dissertação (Mestrado em Letras) - Universidade Presbiteriana Mackenzie, 2017. Orientador: Neusa Maria Oliveira Barbosa Bastos Referência bibliográfica: p. 95-98. 1. Heavy metal. 2. Metal sinfônico. 3. Análise do discurso. 4. Letras de música. Título. CDD 401.41 TALES DOS SANTOS EMERGINDO DAS TREVAS: ANÁLISE DO DISCURSO METAL SINFÔNICO EM WITHIN TEMPTATION Dissertação aprovada em: ____/____/________ BANCA EXAMINADORA: Profa. Dra. Neusa Maria Oliveira Barbosa Bastos – Orientadora Universidade Presbiteriana Mackenzie - UPM Profa. Dra. Diana Luz Pessoa de Barros – Avaliadora interna Universidade Presbiteriana Mackenzie - UPM Profa. Dra. Maria Mercedes Saraiva Hackerott – Avaliadora externa Universidade Paulista - UNIP Dedicatória Aos meus amigos Lucas Seiji Watanabe, Pedro Henrique Camargo e Pietro Beires Marzani Silva que compartilham do mesmo -

The Analysis of Presupposition Found in Song Lyrics of the Heart of Everything Album by Within Temptation Band and Its Application in Teaching Listening

THE ANALYSIS OF PRESUPPOSITION FOUND IN SONG LYRICS OF THE HEART OF EVERYTHING ALBUM BY WITHIN TEMPTATION BAND AND ITS APPLICATION IN TEACHING LISTENING A THESIS Submitted in Partial Fulfillment of the Requirements to Acquire Sarjana Pendidikan Degree in the English Education Program of Teacher Training and Education Faculty Muhammadiyah University of Purworejo ARDIYAN TRI CAHYONO 112120075 ENGLISH EDUCATION PROGRAM TEACHER TRAINING AND EDUCATION FACULTY MUHAMMADIYAH UNIVERSITY OF PURWOREJO 2016 APPROVAL SHEET i THE ANALYSIS OF PRESUPPOSITION FOUND IN SONG LYRICS OF THE HEART OF EVERYTHING ALBUM BY WITHIN TEMPTATION BAND AND ITS APPLICATION IN TEACHING LISTENING A THESIS ARDIYAN TRI CAHYONO 112120075 This thesis has been approved to be defended in front of the team of Thesis Examiner Approved by: The Head of English Education Program Sri Widodo, S.S., M.Hum NIDN.0628057302 Consultant I Consultant II Zulia Chasanah, S.S.,M.Pd Sri Widodo, S.S., M.Hum NIDN. 0616127401 NIDN. 0628057302 ii THE ANALYSIS OF PRESUPPOSITION FOUND IN SONG LYRICS OF THE HEART OF EVERYTHING ALBUM BY WITHIN TEMPTATION BAND AND ITS APPLICATION IN TEACHING LISTENING ARDIYAN TRI CAHYONO 112120075 The thesis has been defended in front of the team of Thesis Examiners Teacher Training and Education Faculty Muhammadiyah University of Purworejo on the date of February, 2016 The Board of Examiners First Examiner Second Examiner Third Examiner Titi Rokhayati, M. Pd. Sri Widodo, S.S, M.Hum. Zulia Chasanah, S.S, M.Pd. NIDN. 0631057301 NIDN. 0628057302 NIDN.0616127401 Purworejo, February 2016 The Dean of Faculty of Teacher Training and Education Yuli Widiyono, M.Pd. -

The Wheel of Time the Roleplaying Game Star Wars Saga Edition Conversion

The Wheel of Time The Roleplaying Game Star Wars Saga Edition Conversion By Randall Bruner With abundant help from the Call of the Horn Roleplaying Game Community at http://www.pencil-pushers.net TABLE OF CONTENTS Chapter One: The Wheel of Time . 3 Chapter Two: Backgrounds . 5 Chapter Three: Heroic Classes . 17 Chapter Four: Skills . 30 Chapter Five: Feats . 33 Chapter Six: Heroic Traits . 38 Chapter Seven: Equipment . 41 Chapter Eight: Combat . 54 Chapter Nine: The One Power . 62 Chapter Ten: Latent Abilities . 87 Chapter Eleven: Advanced Classes . 95 Chapter Twelve: The Westlands and Beyond . 116 Chapter Thirteen: Organizations . 125 Chapter Fourteen: Gamemastering . 141 Chapter Fifteen: Eras of Play . 149 Chapter Sixteen: Allies and Enemies . 151 CHAPTER ONE THE WHEEL OF TIME This is the Star Wars: Saga Edition conversion of the Wheel of Time roleplaying game. should converse about the characters and what legends they become. Most importantly, The Wheel of Time is a great setting for roleplaying, with a few unique characteristics remember that the story is the seed of the eventual legend, so it doesn’t need to be played that make it unlike any other fantasy setting. out exactly like the legend, though there should be many similarities. In many cases, an individual is a reborn person from a past age, or from several ages DIFFERENCES FROM STAR WARS before. Perhaps in such a previous life they were someone of greatness, whether for good or evil. However, not every person is someone who has lived lives before the present There are some obvious differences between Star Wars and the Wheel of Time settings. -

Rock Album Discography Last Up-Date: September 27Th, 2021

Rock Album Discography Last up-date: September 27th, 2021 Rock Album Discography “Music was my first love, and it will be my last” was the first line of the virteous song “Music” on the album “Rebel”, which was produced by Alan Parson, sung by John Miles, and released I n 1976. From my point of view, there is no other citation, which more properly expresses the emotional impact of music to human beings. People come and go, but music remains forever, since acoustic waves are not bound to matter like monuments, paintings, or sculptures. In contrast, music as sound in general is transmitted by matter vibrations and can be reproduced independent of space and time. In this way, music is able to connect humans from the earliest high cultures to people of our present societies all over the world. Music is indeed a universal language and likely not restricted to our planetary society. The importance of music to the human society is also underlined by the Voyager mission: Both Voyager spacecrafts, which were launched at August 20th and September 05th, 1977, are bound for the stars, now, after their visits to the outer planets of our solar system (mission status: https://voyager.jpl.nasa.gov/mission/status/). They carry a gold- plated copper phonograph record, which comprises 90 minutes of music selected from all cultures next to sounds, spoken messages, and images from our planet Earth. There is rather little hope that any extraterrestrial form of life will ever come along the Voyager spacecrafts. But if this is yet going to happen they are likely able to understand the sound of music from these records at least. -

Graduation June 2021 Yindyamarra Winhanganha

Graduation June 2021 Yindyamarra Winhanganha “...the wisdom of respectfully knowing how to live well in a world worth living in.” Welcome On behalf of the Charles Sturt University community, it is my pleasure to invite you to celebrate this momentous occasion. Graduation is an important milestone that marks the completion of your current studies and the beginning of a new chapter in your lives. Your paths may be varied as you go on to take first jobs, promotions, research, perhaps another degree... but you all share something special. You are now lifelong members of the Charles Sturt University family. As Australia’s largest regional university, we are proud of the continuing contributions our graduates make to communities and the world around them. You too are ready to make your mark on this world. I encourage you all to take forward the ethos of Charles Sturt University as you embark on your future endeavours – and apply the wisdom of respectfully knowing how to live well in a world worth living in. Dr Michele Allan Chancellor Yindyamarra Winhanganha Our ethos “...the wisdom of Yindyamarra winhanganha. This is a Wiradjuri phrase meaning ‘the wisdom of respectfully respectfully knowing knowing how to live well in a world worth living in’. It’s at the heart of everything we stand for how to live well in a here at Charles Sturt University. world worth living in.” It’s the reason we strive to create a world worth living in. It ties us to the traditional Indigenous Australians whose land we are fortunate and proud to share, and to the diverse communities across Australia that we serve. -

Preach the Word Vol

Preach the Word Vol. 18, No. 5 May/June 2015 A Clean Set of Clothes By Tom Westra Some Sundays it’s louder than others, but every Sunday it’s there. That Like Joshua, we know what it is to stand before the LORD in filthy voice whispering: “You? You are stepping onto that chancel to speak clothes. We’ve not done the good we want. And the evil we abhor, for a holy God? Are you kidding me?” we’ve done. We know the struggle. We wear our sins like filthy Like a courtroom prosecutor, it badgers, “Remember what you did garments. We know what it is to cry out in brokenness “what a last week? …what kind of husband you have been? …the angry wretched man I am.” and impatient words you directed at your wife? How does she look you in the eye as you stand up there, ‘as a called servant of Christ’? Remember the guy with the addiction who came for help? Remember We know what it is to cry out in our thinking, ‘God, I thank you that I am not like other men, like this brokenness, “what a wretched man that I am.” addict’? How dare you put on a stole on Sundays when you’ve put yourself on a pedestal all week?” It’s relentless. “You slandered your co-worker. You gossiped about your neighbor. And your thoughts? Do I need to go there? What if your And the Accuser, when he smells blood in the water, circles in for the congregation could see your impure thoughts playing on a screen? kill.