Anpassung Von Filmmischungen an Verschiedene Frameraten

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Christian Lerch

Christian Lerch www.agentur-midpoint.com Agentur MIDPOINT Phone: +49 89 890 58053 Email: [email protected] Website: www.agentur-midpoint.com © Adrian Schätz Information Acting age 38 - 45 years Nationality German Year of birth 1966 Languages German: native-language Height (cm) 194 English: medium Eye color gray green French: medium Hair color Black Dialects Bairisch Stature very slim Instruments Guitar: medium Place of residence München Piano: medium Housing options Wasserburg Am Inn bei Drums: medium München Sport Aikido, Alpine skiing, Horse riding Dance Argentine tango: medium Profession Actor Other Education & Training Hochschule für Musik und darstellende Kunst in Graz Awards 2008 Die Perlmutterfarbe - Prädikat: besonders wertvoll 2006 Wer früher stirbt ist länger tot - Deutscher Filmpreis in der Kategorien: "Bestes Drehbuch" Teilnahme an zahlreichen Festivals u.a. LOLA Festival, Berlinale, Filmfest München Film 2016 In Our Country Role: Leading role Director: Louisa Wagener 2016 Amelie rennt Role: Supporting role Director: Tobias Wiemann 2015 Runter Role: Leading role Director: Katharina Bischof 2012 Rico, Oskar und die Tieferschatten Director: Nele Lena Vollmar 2011 Was weg is, is weg 2010 Der Sommer der Gaukler Role: Vorarbeiter Director: Marcus H. Rosenmüller 2009 Vita Christian Lerch by www.castupload.com — As of: 2021-04- 21 Page 1 of 6 Bernd Trautmann Director: Marcus H. Rosenmüller 2008 Die Perlmutterfarbe Role: Herr Gumberger Director: Marcus H. Rosenmüller 2007 Räuber Kneissl Role: Anton Wörndl Director: Marcus -

Filmhighlights 2014

Filmhighlights 2014 Eine Auswahl von Produktionen des Bayerischen Rundfunks für Das Erste, das Bayerische Fernsehen und das Kino BR-Filmhighlights 2014 Inhaltsverzeichnis 4 Vorwort Bettina Ricklefs 28 Dokumentarfilme Programmbereichsleiterin Spiel-Film-Serie 28 24h Jerusalem 29 Beerland 6 Fernsehfilme im Ersten 29 Country Roads 6 Der Prediger 30 Die Reporter von Fukushima (AT) 7 Landauer (AT) 31 Flucht aus dem Todeslager / Camp 14 – Nordkorea 8 Das Ende der Geduld 32 Guerilla Köche 9 Der blinde Fleck 33 Verlorener Horizont (AT) 10 Let’s go! 33 Letzte Chance (AT) 12 Ein neues Leben (AT) 34 You Drive Me Crazy 13 Die Spiegel-Affäre 35 Crossmediales Filmprojekt / Dokumentarfilm 14 Sonntagskrimis im Ersten 35 Mit leichtem Gepäck 14 Tatort: Am Ende des Flurs 15 Polizeiruf 110: Morgengruß (AT) 36 Koproduktionen im Kino 36 Hannas Reise 16 Filmdebüt im Ersten 37 Die Schwarzen Brüder 16 Kohlhaas oder Die Verhältnismäßigkeit der Mittel 38 Alles inklusive 17 Kaddisch für einen Freund 39 Lauf Junge lauf 40 Agnieszka 18 Serien im Ersten 40 Beste Chance 18 Monaco 110 41 Charleen macht Schluss 20 Hubert und Staller 42 Der Bau 21 München 7 43 Hirngespinster 44 Phoenix 22 Bayerisches Fernsehen 45 Quatsch 22 Die reichen Leichen. Ein Starnbergkrimi 46 …und Äktschn! 23 Im Schleudergang 47 Wir sind die Neuen 24 Dahoam is Dahoam 25 Kurzfilmnächte 26 Lebenslinien Dreharbeiten zu Der Prediger 3 VORWORT VORWORT Unsere Mittwochsfilme im Ersten sind 2014 wieder starke Einzelstücke. Im Bayerischen Fernsehen wird die Heimatkrimi-Reihe mit Filme auf der großen Leinwand zu sehen, ist – auch 120 Jahre nach In Der Prediger möchte ein verurteilter Mörder, der zu Gott ge- Dominik Grafs Die reichen Leichen fortgesetzt, dieses Mal steht der Erfindung des Kinos – ein unvergleichliches Erlebnis: kunstvoll, funden hat, mit der offiziellen Unterstützung der Kirche Theologie Starnberg im Mittelpunkt des Geschehens: Ein Wiedergänger des unterhaltsam, fordernd und phantasievoll. -

Annual Report 2017 Fraunhofer

FRAUNHOFER INSTITUTE FOR SYSTEMS AND INNOVATION RESEARCH ISI ANNUAL REPORT CONTENTS PREFACE BOARD OF TRUSTEES LOOKING BACK ON A SUCCESSFUL YEAR AND AHEAD TO A PROMISING FUTURE 4 ADVICE FROM SCIENCE, INDUSTRY, POLITICS AND ADMINISTRATION 26 INTERVIEW “WE SHOULD FOCUS MORE ON THE POSITIVE ASPECTS OF DIGITALIZATION“ 6 ANNEX GROUPS AND ALLIANCES 28 FACTS AND FIGURES 10 ACADEMIC TEACHING 28 ORGANIZATION 12 DISSERTATIONS 29 PROJECTS 34 COMPETENCE CENTER VISITING RESEARCHERS 42 CC ENERGY POLICY AND ENERGY MARKETS 14 CC ENERGY TECHNOLOGY AND ENERGY SYSTEMS 16 IMPRINT 44 CC FORESIGHT 18 PHOTO CREDITS 45 CC SUSTAINABILITY AND INFRASTRUCTURE SYSTEMS 20 CC EMERGING TECHNOLOGIES 22 CC POLICY – INDUSTRY – INNOVATION 24 2 | 3 PREFACE LOOKING BACK ON A SUCCESSFUL YEAR AND AHEAD TO A PROMISING FUTURE Fraunhofer Institute for Systems and Innovation Research ISI looks back on a successful year 2017: As these projects can only give you an exemplary insight into our activities, you will find a list of all Around 220 highly motivated staff worked on roughly 400 projects in order to provide our clients from the projects we worked on in 2017 at the end of this report. The extensive annex also provides infor- industry, politics and science with options and perspectives for important decisions. This generated mation about the teaching activities and lectures of our scientists, the doctoral theses completed in an operating budget of almost 24 million euros. the past year and our visiting researchers. At the beginning of 2018, we honored particularly innovative colleagues with the Fraunhofer ISI We hope you enjoy reading this report and we would be delighted to receive your personal comments Prize. -

Quarterly 4 · 2007

German Films Quarterly 4 · 2007 AT ROME Official Selection Cinema 2007 Out of Competition LOVE LIFE by Maria Schrader PORTRAITS Marcus H. Rosenmueller, Helma Sanders-Brahms, Kordes & Kordes Film, Hinnerk Schoenemann SPECIAL REPORT Television in Germany – Evolution of the Medium German Films Quarterly 4 · 2007 4 THE EVOLUTION OF THE MEDIUM focus on Television in Germany directors’ portraits 10 SOMETHING WILD A portrait of Marcus H. Rosenmueller 12 FALLEN FOR FILM A portrait of Helma Sanders-Brahms producers’ portrait 14 SISTER ACT! A portrait of Kordes & Kordes Film actor’s portrait 16 FOR THE LOVE OF FILM A portrait of Hinnerk Schoenemann 18 news in production 24 ALLE ANDEREN Maren Ade 24 BERLIN CALLING Hannes Stoehr 25 BEYOND REMEDY (AKA FEAR) Gerhard Hross 26 DWK 5 – DIE WILDEN KERLE Joachim Masannek 27 FRIEDLICHE ZEITEN Neele Leana Vollmar 28 DAS GEHEIMNIS DES GLUECKS Lola Randl 28 HEXE LILLI Stefan Ruzowitzky 29 MAERZMELODIE Martin Walz 30 MEIN FREUND AUS FARO Nana Neul 31 DER MONDBAER Michael Maurus 32 MUTTERLIEBE Emily Atef 32 PRINZESSIN LILLIFEE Alan Simpson 33 DER ROTE PUNKT Marie Miyayama 34 SCHATTENWELT Connie Walther 35 SELBSTGESPRAECHE André Erkau 36 SOMMER Mike Marzuk 36 WARTEN AUF ANGELINA Hans-Christoph Blumenberg new german films 38 BENDE SIRA – ICH BIN DRAN IT’S MY TURN Ismet Erguen 39 BESTE ZEIT BEST TIMES Marcus H. Rosenmueller 40 DÉBROUILLEZ-VOUS MAKE ENDS MEET Markus Passera 41 DEM PANZERKREUZER POTEMKIN AUF DER SPUR ON THE TRAIL OF BATTLESHIP POTEMKIN Artem Demenok 42 EIN DORF IN EUROPA A VILLAGE IN EUROPE Robert -

BOLZANO FILM FESTIVAL BOZEN! Benvenuti Alla 31Esima Edizione Di BOLZANO FILM FESTIVAL BOZEN!

05. – 09.04. 2017 www.filmfestival.bz.it AUTONOME PROVINCIA PROVINZ AUTONOMA BOZEN DI BOLZANO SÜDTIROL ALTO ADIGE Innenteil2017_148x210mm_92seiten.indd 1 15.03.17 09:49 Filme im Programm film in programma Spielfilme im Wettbewerb [7] lungometraggi in concorso Dokumentarfilme im Wettbewerb [15] documentari in concorso Preise und Jurys [23] premi e giurie Hommage an den Ehrengast Michele Placido [28] omaggio all’ospite d’onore Michele Placido Focus Europa: Luxembourg [31] Werkschau Miramonte Film [35] rassegna Miramonte Film Cinema Ritrovato [41] Local artists [45] Panorama [55] Made in Südtirol [67] Extra/s [83] Innenteil2017_148x210mm_92seiten.indd 2 15.03.17 09:49 Ich bedanke mich / un cordiale ringraziamento beim Festivalteam / al team del festival: Helene Christanell, Martin Kaufmann, Antonella Arseni, Alma Vallazza bei den FilmclubmitarbeiterInnen / ai collaboratori e alle collaboratrici del Filmclub: Maruska Bertolini, Oswald Lang, Raimund Obkircher beim Technikerteam / al team dei tecnici: Mike Ramsauer, Andreas Cuel, Oliver Oppitz, Alberto Malfatti bei den vielen ehrenamtlichen MitarbeiterInnen: FotografInnen, MusikerInnen und allen am Gelingen des Filmfestivals Beteiligten / alle numerose volontarie e ai numerosi volontari: fotograf/e/i, musicisti e a tutti coloro che hanno contribuito alla realizzazione del festival und postum bei Christian Friedel († am 1. 2. 2017), Ideengeber der Bozner Filmtage und über die Jahre Förderer und Unterstützer unseres Filmclubs. In memoria di Christian Friedel († 1. 2. 2017), ideatore del festival, fautore e sostenitore del nostro Filmclub. Dorothea Vieider Präsidentin des Filmclubs / presidente del Filmclub 3 Innenteil2017_148x210mm_92seiten.indd 3 15.03.17 09:49 Willkommen zum 31. BOLZANO FILM FESTIVAL BOZEN! Benvenuti alla 31esima edizione di BOLZANO FILM FESTIVAL BOZEN! Haben Sie Lust, fünf Tage lang in neue oder neu zu entdeckende Welten einzutauchen? Die Filme der diesjährigen Festivalausgabe laden dazu ein, spannende Geschichten zu erleben, interessante Themen und die Menschen hinter den Filmen kennen zu lernen. -

The Summer Issue

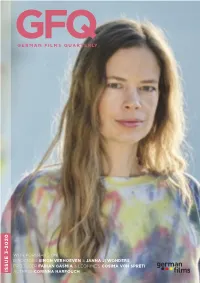

GFQ GERMAN FILMS QUARTERLY THE SUMMER ISSUE NEW GERMAN FILMS IN LOCARNO, VENICE, TORONTO & SAN SEBASTIAN DIRECTORS Karin Jurschick & Marco Kreuzpaintner PRODUCER Felix von Boehm of Lupa Film ISSUE 3-2019 ACTRESS Anne Ratte-Polle CONTENTS GFQ 3-2019 16 18 20 21 22 23 25 26 27 29 30 33 2 GFQ 3-2019 CONTENTS IN THIS ISSUE PORTRAITS NEW DOCUMENTARIES PRACTICING POLITICAL DOCUMENTARY ANOTHER REALITY A portrait of director Karin Jurschick .............................................. 4 Noël Dernesch, Olli Waldhauer ...................................................... 30 “MY WORKSPACE IS MY HAPPY PLACE” B.B. UND DIE SCHULE AM FLUSS A portrait of director Marco Kreuzpaintner ...................................... 6 B.B. AND THE SCHOOL BY THE RIVER Detlev F. Neufert .............................................................................. 30 REMAINING INDEPENDENT A portrait of production company Lupa Film ................................. 8 INTERTANGO – EINE VERBINDUNG FÜRS LEBEN INTERTANGO – A CONNECTION FOR LIFE A WOMAN OF MANY TALENTS Hanne Weyh .................................................................................. 31 A portrait of actress Anne Ratte-Polle ............................................ 10 MATERA. VERBORGENE HEIMAT MATERA. MOTHER OF STONE NEWS & NOTES ................................................................................ 12 Alessandro Soetje ............................................................................ 31 NEW FEATURES NEW SHORTS 7500 BOJE Andreas Cordes, Robert Köhler ............................................ -

Gfq 3-2020 Contents I N This Issue

GFQ GERMAN FILMS QUARTERLY 3-2020 WITH PORTRAITS ON DIRECTORS SIMON VERHOEVEN & JANNA JI WONDERS PRODUCER FABIAN GASMIA & LEONINE’S COSIMA VON SPRETI ISSUE ACTRESS CORINNA HARFOUCH OPENING THE DOORS TO GERMAN CINEMA WORLDWIDE GFQ 3-2020 CONTENTS I N THIS ISSUE PORTRAITS NEW SHORTS GREAT ENTERTAINMENT FOR A BIG AUDIENCE DER ENGEL DER GESCHICHTE A portrait of director Simon Verhoeven .......................................... 4 THE ANGEL OF HISTORY Eric Esser .............................................. 26 ROOTED IN FILMMAKING FOR YOUR SAKE A portrait of director Janna Ji Wonders ........................................... 6 Ronja Hemm .................................................................................... 27 MOTIVATOR & FACILITATOR SERIAL PARALLELS A portrait of producer Fabian Gasmia ............................................. 8 Max Hattler ..................................................................................... 28 SHARING A CREATIVE VISION A portrait of LEONINE’s Head of Co-Finance and Co-Production, Cosima von Spreti .......................................... 10 UPCOMING FILMS VARIETY & DIVERSITY ALLES IN BESTER ORDNUNG A portrait of actress Corinna Harfouch ........................................... 12 Natja Brunckhorst .......................................................................... 30 ALMOST FLY Florian Gaag ...................................................................................... 30 NEW FEATURES FOLLOW ME BABY BITCHKA Joya Thome ..................................................................................... -

Deut§¬E Film/Fern§Ehen-Unterhaltungsrunde Frühling 2015 Arsht Hall Mittwochs Um 11:30

Deut§¬e Film/Fern§ehen-Unterhaltungsrunde Frühling 2015 Arsht Hall Mittwochs um 11:30 Schön freundliche und gesellige Unterhaltung in der deutschen Sprache steht auf der Wunschliste vieler deutschsprechenden Mitglieder. Die Film/TV- Unterhaltungsrunde kommt diesem Wunsch nach und bietet unterschiedliche deutsche Filme und TV-Sendungen, die die Gruppe ansehen und diskutieren kann. Stille Liebe (2001) 88 Min. DfHg schweizer Film S2 In "Stille Liebe" verlieben sich nicht nur eine Nonne und ein Taschendieb ineinander, die beiden sind auch noch gehörlos. Nicht nur auf der Leinwand, sondern auch im richtigen Leben. Es wurde tatsächlich am Set "mit den Händen gearbeitet", was dem Resultat eine zusätzliche Authentizität verleiht. Das weiße Band (2009) 138 Min. DfHg S5 Dorf im protestantischen Norden Deutschlands. 1913/14. Vorabend des Ersten Weltkriegs. Die Ge- schichte des vom Dorflehrer geleiteten Schul- und Kirchenchors. Seine kindlichen und jugendlichen Sänger und deren Familien: Gutsherr, Pfarrer, Gutsverwalter, Hebamme, Arzt, Bauern - ein Quer- schnitt eben. Seltsame Unfälle passieren und nehmen nach und nach den Charakter ritueller Bstra- fungen an. Soul Kitchen (2009) 99 Min. ohne Untertitel S18 SOUL KITCHEN ist ein Heimatfilm der neuen Art: Die Welt ist nicht mehr so heil und das Dorf ist ein Restaurant. Es geht um Familie und Freunde, um Liebe, Vertrauen und Loyalität - und um den Kampf für die Heimat als einen Ort, den es in einer zunehmend unberechenbaren Welt zu schützen gilt. Groupies bleiben nicht zum Frühstück (2010) 104 Min. DfHg S35 Als Lila nach einem Jahr in den USA nach Berlin zurückkehrt, lernt sie zufällig Chriz kennen und verliebt sich in ihn. Was Lila allerdings nicht weiß, Chriz ist der Frontmann der inzwischen ange- sagtesten Band Deutschlands mit dem Namen "Berlin Mitte". -

2014 18 Lifetime Achivement Award 2014 20

INDEX PAGE INTRODUCTION JURY COORDINATORS 10 THE PRIX EUROPA AWARDS 2014 18 LIFETIME ACHIVEMENT AWARD 2014 20 COMPETING TELEVISION ENTRIES TV DOCUMENTARY 22 TV FICTION 46 TV CURRENT AFFAIRS 74 TV IRIS 92 PRIX GENEVE-EUROPE 108 COMPETING RADIO ENTRIES RADIO DOCUMENTARY 120 RADIO CURRENT AFFAIRS 156 RADIO FICTION 174 RADIO MUSIC 210 COMPETING ONLINE ENTRIES ONLINE 232 SPECIAL EVENTS 264 2 If I were to pick one word to describe the PRIX EUROPA, I would choose ‘gathering’. This year, for the 28th time, the PRIX EUROPA will gather the cream of the crop of European media. From all over the continent, people who share the same passion for television, radio and web will come to Berlin to compete against each other, and so pay testament to the dynamism of European public broadcasting. However, the strength of the festival goes beyond the competition itself. Its real virtue is that it gets young and old from different cultures, religions and languages communicating with and learning from each other. What’s more, this sort of collaboration helps us to understand each other – and that is of crucial moral, civil, social and cultural value in the turbulent world of the moment. I look forward to this exceptional event and to meeting you there. Yours sincerely, Roger de Weck PRIX EUROPA President Director General of Schweizerische Radio- und Fernsehgesellschaft - SRG SSR Welcome to Berlin, where PRIX EUROPA has built its home - with good reason. It is a city where ideas count more than high salaries, imagination defeats protocol, and talent can find space to develop. -

Quarterly 3 · 2011

S01_CoverGFQ3_GFQ1_2010_u4motiv 22.07.11 13:28 Seite 2 German Films Quarterly 3 · 2011 PORTRAITS Directors Matthias Glasner & Pia Marais Producer Jochen Laube (teamWorx) Actress Steffi Kühnert IN LOCARNO: PIAZZA GRANDE HELL by Tim Fehlbaum S02-03_Inhaltsverz_Inhaltsverz_GFQ2_2010.qxp 22.07.11 10:48 Seite 1 German Films Quarterly 3 · 2011 director portraits 4 HE FILMS A portrait of director Matthias Glasner 6 WAYS TO FREEDOM A portrait of director Pia Marais producer portrait 8 A FREE HAND AND GREAT PASSION A portrait of teamWorx producer Jochen Laube actress portrait 10 COMING FULL CIRCLE A portrait of actress Steffi Kühnert 12 news in production 16 1000 KÖNIGE Bidzina Kancheveli ANLEITUNG ZUM UNGLÜCKLICHSEIN Sherry Hormann 17 BLUTZBRÜDAZ Özgür Yildirim EUROPE & BOMBER Felix Stienz 18 GOLD Marc Brasse HOTEL DESIRE Sergei Moya 19 JESUS LOVES ME Florian David Fitz KANN DENN LIEBE SÜNDE SEIN? Saara Aila Waasner 20 KLEINE MORDE Adnan G. Köse DER KLEINE RABE SOCKE Ute von Münchow-Pohl, Sandor Jesse 21 SAME WAY Daria Onyshchenko SCHILF Claudia Lehmann 22 UNTER FRAUEN Hansjörg Thurn WAS WEG IS, IS WEG Christian Lerch new german films 24 205 – ZIMMER DER ANGST ROOM 205 Rainer Matsutani 25 AMEISEN GEHEN ANDERE WEGE Catharina Deus 26 ARSCHKALT NO MORE MR. ICE GUY André Erkan S02-03_Inhaltsverz_Inhaltsverz_GFQ2_2010.qxp 22.07.11 10:48 Seite 2 27 DIE AUSBILDUNG THE EDUCATION Dirk Lütter 28 BEACH BOY Hannes Hirsch 29 DAS BLAUE VOM HIMMEL PROMISING THE MOON Hans Steinbichler 30 DEATH OF A SUPERHERO Ian FitzGibbon 31 DREAMING MALI Barbara Kowa 32 DER GANZ GROSSE TRAUM LESSONS OF A DREAM Sebastian Grobler 33 HALT AUF FREIER STRECKE STOPPED ON TRACK Andreas Dresen 34 HELL Tim Fehlbaum 35 HOMIES HIPHOP EXPRESS Adnan G. -

Why German Film Needs Immigrants

TV FICTION Details of all programmes nominated for PRIX EUROPA 2020 are based on the information provided by the submitting organisation. TV FICTION Programmes in Competition 2020 01 Vienna Blood Austria 02 Blackout Belgium 03 Actor Czech Republic 04 Traitor Estonia 05 Peacemaker Finland 06 Merkel Germany 07 The Turncoat - Part 1 Germany 08 The Windermere Children Germany 09 Unterleuten Germany 10 The Minister Iceland 11 My Brilliant Friend - The Story of a New Name Italy 12 ANNE+Sara The Netherlands 13 Bitch The Netherlands 14 22 July Norway 15 The Butler Poland 16 24 Land – The Spy Portugal 17 Spring on the Last Lake Serbia 18 Quarantine Diaries Spain 19 The Paradise Spain 20 Caliphate Sweden 21 Limboland Sweden 22 Labyrinth of Peace Switzerland 23 No. 47 - Sophie Switzerland 24 Anthony United Kingdom 26 Foodie Love Spain TV FICTION Vienna Blood, Episode 1 Vienna Blood Vienna Blood is set in 1900s Vienna: a hot bed of philosophy, science and art, where a clash of cultures and ideas play out in the city’s grand cafes and opera houses. Max Liebermann is a brilliant young English doctor, studying under the famed psychoanalyst Sigmund Freud. Max is keen to understand the criminal mind and begins to observe Oskar Rheinhardt, a Detective Inspector in the Vienna Police Department, who is struggling with a perplexing case. Max’s extraordinary skills of perception and forensics, and his deep understanding of human behaviour and deviance, help Oskar solve Vienna’s most mysterious cases. In ‘The Last Séance’ Junior doctor Max Liebermann is undertaking research in the new discipline of psychotherapy much to the disgust of his professor. -

Festivals Und Preise Übersicht Preise Und Nominierungen 2017

Festivals und Preise Übersicht Preise und Nominierungen 2017 N O O P M n R I H F l E N Preis/Festival Preis | Auszeichnung | Nominierung Anmerkung F S i I I n S E e R T Der Preis für den "Besten Jugendfilm" geht an den 38. Bayerischer Filmpreis | 1 Produzenten Marco Mehlitz für „Tschick“ 1 1 20.01.17 | München (Degeto/BR/NDR/rbb) Cinematographie-Preis (für die Kameraführung von Sundance Film Festival | 19.- 2 Manuel Dacosse) für "Axolotl Overkill" (rbb/BR) nach LEUCHTSTOFF 1 1 29.01.17 Park City | USA | dem Erstlingsroman von Helene Hegemann Preis für die rbb-Koproduktion (Degeto/rbb) "Terror - Ihr Urteil" in der Kategorie "Beste Regie" für Lars Deutscher Fernsehpreis | Kraume 3 1 2 1 02.02.17 | Düsseldorf außerdem Nominierungen in der Kategorie "Bester Fernsehfilm" und "Bester Schauspieler" für Lars Eidinger Preis in der Kategorie "Bester Dokumentarfilm" für Ulrike Ottingers Film "Chamissos Schatten" (3sat, ZDF, rbb), Preis für "Fado" von Jonas Rothlaender in der Kategorie "Bestes Spielfilmdebüt" Nominierungen in der Kategorie "Bester Dokumentarfilm" für "Landstück" von Volker Koepp und Preise wurden "Eines Tages - And-Ek Ghes..." im Rahmen der Nominierung in der Kategorie "Bestes Spielfilm" für Berlinale Preis der deutschen Filmkritik | 4 "Fado" vergeben | 2 8 2 13.02.17 | Berlin Nominierung von Luise Heyer für ihre Rolle in "Fado" in "Fado" und der Kategorie "Beste Darstellerin" "Landstück" > Nominierung in der Kategorie "Beste Kamera" für LEUCHTSTOFF "Eines Tages - And-Ek Ghes..." Nominierung in der Kategorie "Bester Schnitt" für "Chamissos Schatten" Nominierung in der Kategorien "Bestes Drehbuch" und "Bester Darsteller " für "Tschick" Berlinale | Internationale 2.