Jugador Virtual Del Go, Basado En El Algoritmo De Monte Carlo

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

SZ 31082018 Tuija Komi Kopie

30. August 2018, 22:16 Uhr München Sing, sing, sing "Es war niemand dafür: nur ich", sagt die gebürtige Finnin Tuija Komi über ihren Entschluss, mit 37 Jahren den Job als IT-Projektmanagerin an den Nagel zu hängen und als Jazzsängerin ihr Geld zu verdienen. Mittlerweile hat sie ihr eigenes Quartett und fünf CDs aufgenommen. Von Franziska Gerlach Tuija Komi muss nicht lange überlegen, wie sich die Entscheidung für den Gesang angefühlt hat: Es waren nur noch wenige Tage bis Weihnachten, damals, im Jahr 2005, die Dunkelheit sank schon früh am Abend über die Münchner Straßen. Die gebürtige Finnin lag im Bett, äußerlich war sie ruhig, doch in ihr tobte der Kampf zwischen Gefühl und Vernunft. Bleib da, das ist ein sicherer Job, bleib da, habe der Kopf ihr geraten. Doch der Bauch, der wollte eben etwas anderes, ein Leben auf der Bühne. Noch immer spricht die Frau, die da mit einer türkisfarbenen Blume im hellblonden Haar auf der Veranda der Seidlvilla vor einem sitzt, von "einer Fügung", die sie zum Gesang gebracht hat. (Foto: Robert Haas) Am Ende gewann der Bauch dieses Kräfte verschlingende Hin und Her, gegen die Bedenken von Freunden und Kollegen. "Es war niemand dafür, nur ich." Doch das reichte: Komi, heute 50 Jahre alt, macht sich damals als Jazzsängerin selbständig, manchmal arbeitet sie auch als Sprecherin für finnische Hörbücher oder E-Learning- Programme, moderiert Musik- und Kulturfestivals oder gibt Workshops an der Münchner Volkshochschule. In ihren früheren Beruf als Projektmanagerin in der IT eines großen Münchner Unternehmens aber sollte sie nie wieder zurückkehren. Noch immer spricht die Frau, die da mit einer türkisfarbenen Blume im hellblonden Haar auf der Veranda der Seidlvilla vor einem sitzt, von "einer Fügung", die sie zum Gesang gebracht hat. -

Downloads/GHS ANNUAL REPORT 2016 N.Pdf

Pi-Bansa et al. Parasites & Vectors (2018) 11:672 https://doi.org/10.1186/s13071-018-3260-3 RESEARCH Open Access Implementing a community vector collection strategy using xenomonitoring for the endgame of lymphatic filariasis elimination Sellase Pi-Bansa1,2,3*, Joseph Harold Nyarko Osei3,4, Joannitta Joannides3, Maame Esi Woode5, David Agyemang6, Elizabeth Elhassan6, Samuel Kweku Dadzie3, Maxwell Alexander Appawu3, Michael David Wilson3, Benjamin Guibehi Koudou5,7, Dziedzom Komi de Souza3, Jürg Utzinger1,2 and Daniel Adjei Boakye3 Abstract Background: The global strategy for elimination of lymphatic filariasis is by annual mass drug administration (MDA). Effective implementation of this strategy in endemic areas reduces Wuchereria bancrofti in the blood of infected individuals to very low levels. This minimises the rate at which vectors successfully pick microfilariae from infected blood, hence requiring large mosquito numbers to detect infections. The aim of this study was to assess the feasibility of using trained community vector collectors (CVCs) to sample large mosquito numbers with minimal supervision at low cost for potential scale-up of this strategy. Methods: CVCs and supervisors were trained in mosquito sampling methods, i.e. human landing collections, pyrethrum spray collections and window exit traps. Mosquito sampling was done over a 13-month period. Validation was conducted by a research team as quality control for mosquitoes sampled by CVCs. Data were analyzed for number of mosquitoes collected and cost incurred by the research team and CVCs during the validation phase of the study. Results: A total of 31,064 and 8720 mosquitoes were sampled by CVCs and the research team, respectively. -

5892 Cisco Category: Standards Track August 2010 ISSN: 2070-1721

Internet Engineering Task Force (IETF) P. Faltstrom, Ed. Request for Comments: 5892 Cisco Category: Standards Track August 2010 ISSN: 2070-1721 The Unicode Code Points and Internationalized Domain Names for Applications (IDNA) Abstract This document specifies rules for deciding whether a code point, considered in isolation or in context, is a candidate for inclusion in an Internationalized Domain Name (IDN). It is part of the specification of Internationalizing Domain Names in Applications 2008 (IDNA2008). Status of This Memo This is an Internet Standards Track document. This document is a product of the Internet Engineering Task Force (IETF). It represents the consensus of the IETF community. It has received public review and has been approved for publication by the Internet Engineering Steering Group (IESG). Further information on Internet Standards is available in Section 2 of RFC 5741. Information about the current status of this document, any errata, and how to provide feedback on it may be obtained at http://www.rfc-editor.org/info/rfc5892. Copyright Notice Copyright (c) 2010 IETF Trust and the persons identified as the document authors. All rights reserved. This document is subject to BCP 78 and the IETF Trust's Legal Provisions Relating to IETF Documents (http://trustee.ietf.org/license-info) in effect on the date of publication of this document. Please review these documents carefully, as they describe your rights and restrictions with respect to this document. Code Components extracted from this document must include Simplified BSD License text as described in Section 4.e of the Trust Legal Provisions and are provided without warranty as described in the Simplified BSD License. -

Kyrillische Schrift Für Den Computer

Hanna-Chris Gast Kyrillische Schrift für den Computer Benennung der Buchstaben, Vergleich der Transkriptionen in Bibliotheken und Standesämtern, Auflistung der Unicodes sowie Tastaturbelegung für Windows XP Inhalt Seite Vorwort ................................................................................................................................................ 2 1 Kyrillische Schriftzeichen mit Benennung................................................................................... 3 1.1 Die Buchstaben im Russischen mit Schreibschrift und Aussprache.................................. 3 1.2 Kyrillische Schriftzeichen anderer slawischer Sprachen.................................................... 9 1.3 Veraltete kyrillische Schriftzeichen .................................................................................... 10 1.4 Die gebräuchlichen Sonderzeichen ..................................................................................... 11 2 Transliterationen und Transkriptionen (Umschriften) .......................................................... 13 2.1 Begriffe zum Thema Transkription/Transliteration/Umschrift ...................................... 13 2.2 Normen und Vorschriften für Bibliotheken und Standesämter....................................... 15 2.3 Tabellarische Übersicht der Umschriften aus dem Russischen ....................................... 21 2.4 Transliterationen veralteter kyrillischer Buchstaben ....................................................... 25 2.5 Transliterationen bei anderen slawischen -

Journeys 2008 Web.Indd

Journeys An Anthology of Adult Student Writings Freed Spirit Donald Egge, Duluth Journeys 2008 An Anthology of Adult Student Writings Journeys is a project of the Minnesota Literacy Council, a nonprofi t organization dedicated to improving literacy statewide. Our mission is to share the power of learning through education, community building and advocacy. Special thanks to our editors: Elissa Cottle, Katie McMillen and Christopher Pommier, and to Minnesota Literacy Council staff members Guy Haglund, Jane Cagle-Kemp, Cathy Grady and Allison Runchey for their work on this year’s Journeys. Th is is our 19th year of publishing writing by adults enrolled in reading, English as a Second Language, GED, and other adult basic education classes in Minnesota. Please also see Journeys online at www.theMLC.org/Journeys. Submit writing for Journeys by contacting www.theMLC.org, 651-645-2277 or 800-225-READ. Join the journey of the Minnesota Literacy Council by: - Referring adults in need of literacy assistance to the Adult Literacy Hotline at 800-222-1990 or www.theMLC.org/hotline. - Tutoring adults in reading, ESL, citizenship or GED. Contact [email protected]. - Distributing fl iers and emails or hosting events. Call 651-645-2277 for materials. - Making tax deductible contributions. Send donations to the Minnesota Literacy Council, 756 Transfer Road, St. Paul, MN 55114. For other giving options, contact 651-645-2277, 800-225-READ or www.theMLC.org/donate. TABLE OF CONTENTS 3 i remember 19 america the foreign 27 it’s so different from home 37 my successes -

Participation Rules Dokomi Contests Partdiecadilipne Afor Tsuibominssi Onr Ius Thle 1S1s T Odf Juoly K202o1 Amt 11I:5 9C P.Mo

PPPaaarrrtttiiiccciiipppaaatttiiiooonnn rrruuullleeesss DDDoooKKKooommmiii CCCooonnnttteeessstttsss Zeichnung: Magdalena Proszowska §1 Prerequisites for attending Participation rules DoKomi Contests PartDiecadilipne afor tsuibominssi onr ius thle 1s1s t oDf Juoly K202o1 amt 11i:5 9C p.mo. Snubtmeisssiotnss after this date can not be allowed. Only for the art contest: Your picture and all parts of it have to be designed by yourself. Plagiarism, known as fanarts, are not allowed. Excepted are all mascots of the DoKomi. They can be used freely. The forms for participation have to be filled out true. Only full particulars can be regarded. You can submit several works, but only one work per person can win a prize. §2 Presentation of submitted works Submitted works can be printed and shown at the DoKomi or can be published at the DoKomi website. We will use the full names of the persons who submit the works! The works won't be used by anybody else than DoKomi. Submissions of the winners will be shown at the stage program during the prize-giving. §3 Winners and prizes Winners will be announced for the first time during the prize-giving at the convention. Participants who win and are present during the prize-giving can pick up their prizes locally. If the winner is not present he or she can send a delegate who can pick up the prize. The winner or delegate has to show a photo ID of himself in order to receive the prize. If nobody is present to pick up the prize, it will be posted to the winner after the con. -

Peugeot 404,Benzine-Injectie Motor

PE:.UCaE:.OT met benzine-injectie motor INSTRUCTIEBOEKJE Importrice: GEBR. NEFKENS' AUTOMOBIEL MIJ. N.V. - UTRECHT Biltstraat 106 - Telefoon 16523 (4 lijnen) NADRUFi VERBODEN BELANGRIJK SMERING EN ONDERHOUD De importrice verstrekt bij elke nieuwe auto eell "smeer- en onderhoudsschema", alsmede een garan tiekaart. Het is van het grootste belang dat de daarin gegeven voorschriften nauwkeurig worden opge- volgd. * Laat uw wagen uitsluitend verzorgen door een er kend PEUGEOT-dealer, aangezien deze beschikt over de ORIGINELE onderdelen en de benodigde speciale gereedschappen. 5-'65 Aanduiding der plaatsen( waar chassis- en motor nummer zijn ingeslagen q ~ 4313450 q S fiRlE· tIUM~ER MOTOR·HUMMER Chnssisnummer : op rachlar voorwielknsl, ondor de molorknp. Motornummer: op linkerknnt vun het motorhlok, hoven de stnrtmotor. Vermold hij nllo evonluele correspondontie nllijd het sedenummer van de wagon, .!7nhoud Pagina 1. Algemene gegevens 5 2. Gebruiksvoorschriften 7 3. Smering en onderhoud 23 4. Diverse afstellingen 39 5. Nuttige wenken . 45 A - Accu 34-46 Achterbank 10 Achterbrug 27-35 Aftappen van de motorolie . 26 Airconditioning 14 Amperemeter 20 Antivries 22 Asbakjes 8-10 B - Bagageruimte 13 Banden 5-34-36 Bekleding 52 Benzine . 20 Benzinefilter en benzinepomp 38 Benzinetankdop 13 Bougies . 35-37-40 C - Cardanas 29 Claxons . 18 Clignoteurs 21 -47 Controle onder het rijden 19 D - Distributie 39 Dynamo. 35 E - Elektrische installatie 10-12-54 F - Fusees 28 G - Gereedschapbergplaats . 13 Gloeilampen 47-48 H - Handrem. 6 I - Inhouden 5 Inrijden . 21 Instrumentenbord 6 Injectiepomp . 25-42 K - l'lleptuimelaars 39 l'llokje 9 l'lofferdeksel . 33 2 Pagina Fiofferscharnieren 33 Fioffersluiting 33 Fioplampen 48 Fioppelingsdruklager 30 Fioppelingspedaal . -

ISO/IEC International Standard 10646-1

JTC1/SC2/WG2 N3381 ISO/IEC 10646:2003/Amd.4:2008 (E) Information technology — Universal Multiple-Octet Coded Character Set (UCS) — AMENDMENT 4: Cham, Game Tiles, and other characters such as ISO/IEC 8824 and ISO/IEC 8825, the concept of Page 1, Clause 1 Scope implementation level may still be referenced as „Implementa- tion level 3‟. See annex N. In the note, update the Unicode Standard version from 5.0 to 5.1. Page 12, Sub-clause 16.1 Purpose and con- text of identification Page 1, Sub-clause 2.2 Conformance of in- formation interchange In first paragraph, remove „, the implementation level,‟. In second paragraph, remove „, and to an identified In second paragraph, remove „with an implementation implementation level chosen from clause 14‟. level‟. In fifth paragraph, remove „, the adopted implementa- Page 12, Sub-clause 16.2 Identification of tion level‟. UCS coded representation form with imple- mentation level Page 1, Sub-clause 2.3 Conformance of de- vices Rename sub-clause „Identification of UCS coded repre- sentation form‟. In second paragraph (after the note), remove „the adopted implementation level,‟. In first paragraph, remove „and an implementation level (see clause 14)‟. In fourth and fifth paragraph (b and c statements), re- move „and implementation level‟. Replace the 6-item list by the following 2-item list and note: Page 2, Clause 3 Normative references ESC 02/05 02/15 04/05 Update the reference to the Unicode Bidirectional Algo- UCS-2 rithm and the Unicode Normalization Forms as follows: ESC 02/05 02/15 04/06 Unicode Standard Annex, UAX#9, The Unicode Bidi- rectional Algorithm, Version 5.1.0, March 2008. -

Cyrillic # Version Number

############################################################### # # TLD: xn--j1aef # Script: Cyrillic # Version Number: 1.0 # Effective Date: July 1st, 2011 # Registry: Verisign, Inc. # Address: 12061 Bluemont Way, Reston VA 20190, USA # Telephone: +1 (703) 925-6999 # Email: [email protected] # URL: http://www.verisigninc.com # ############################################################### ############################################################### # # Codepoints allowed from the Cyrillic script. # ############################################################### U+0430 # CYRILLIC SMALL LETTER A U+0431 # CYRILLIC SMALL LETTER BE U+0432 # CYRILLIC SMALL LETTER VE U+0433 # CYRILLIC SMALL LETTER GE U+0434 # CYRILLIC SMALL LETTER DE U+0435 # CYRILLIC SMALL LETTER IE U+0436 # CYRILLIC SMALL LETTER ZHE U+0437 # CYRILLIC SMALL LETTER ZE U+0438 # CYRILLIC SMALL LETTER II U+0439 # CYRILLIC SMALL LETTER SHORT II U+043A # CYRILLIC SMALL LETTER KA U+043B # CYRILLIC SMALL LETTER EL U+043C # CYRILLIC SMALL LETTER EM U+043D # CYRILLIC SMALL LETTER EN U+043E # CYRILLIC SMALL LETTER O U+043F # CYRILLIC SMALL LETTER PE U+0440 # CYRILLIC SMALL LETTER ER U+0441 # CYRILLIC SMALL LETTER ES U+0442 # CYRILLIC SMALL LETTER TE U+0443 # CYRILLIC SMALL LETTER U U+0444 # CYRILLIC SMALL LETTER EF U+0445 # CYRILLIC SMALL LETTER KHA U+0446 # CYRILLIC SMALL LETTER TSE U+0447 # CYRILLIC SMALL LETTER CHE U+0448 # CYRILLIC SMALL LETTER SHA U+0449 # CYRILLIC SMALL LETTER SHCHA U+044A # CYRILLIC SMALL LETTER HARD SIGN U+044B # CYRILLIC SMALL LETTER YERI U+044C # CYRILLIC -

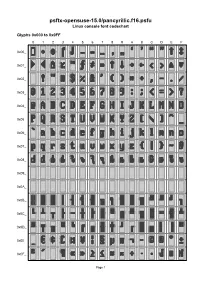

Psftx-Opensuse-15.0/Pancyrillic.F16.Psfu Linux Console Font Codechart

psftx-opensuse-15.0/pancyrillic.f16.psfu Linux console font codechart Glyphs 0x000 to 0x0FF 0 1 2 3 4 5 6 7 8 9 A B C D E F 0x00_ 0x01_ 0x02_ 0x03_ 0x04_ 0x05_ 0x06_ 0x07_ 0x08_ 0x09_ 0x0A_ 0x0B_ 0x0C_ 0x0D_ 0x0E_ 0x0F_ Page 1 Glyphs 0x100 to 0x1FF 0 1 2 3 4 5 6 7 8 9 A B C D E F 0x10_ 0x11_ 0x12_ 0x13_ 0x14_ 0x15_ 0x16_ 0x17_ 0x18_ 0x19_ 0x1A_ 0x1B_ 0x1C_ 0x1D_ 0x1E_ 0x1F_ Page 2 Font information 0x017 U+221E INFINITY Filename: psftx-opensuse-15.0/pancyrillic.f16.p 0x018 U+2191 UPWARDS ARROW sfu PSF version: 1 0x019 U+2193 DOWNWARDS ARROW Glyph size: 8 × 16 pixels 0x01A U+2192 RIGHTWARDS ARROW Glyph count: 512 Unicode font: Yes (mapping table present) 0x01B U+2190 LEFTWARDS ARROW 0x01C U+2039 SINGLE LEFT-POINTING Unicode mappings ANGLE QUOTATION MARK 0x000 U+FFFD REPLACEMENT 0x01D U+2040 CHARACTER TIE CHARACTER 0x01E U+25B2 BLACK UP-POINTING 0x001 U+2022 BULLET TRIANGLE 0x002 U+25C6 BLACK DIAMOND, 0x01F U+25BC BLACK DOWN-POINTING U+2666 BLACK DIAMOND SUIT TRIANGLE 0x003 U+2320 TOP HALF INTEGRAL 0x020 U+0020 SPACE 0x004 U+2321 BOTTOM HALF INTEGRAL 0x021 U+0021 EXCLAMATION MARK 0x005 U+2013 EN DASH 0x022 U+0022 QUOTATION MARK 0x006 U+2014 EM DASH 0x023 U+0023 NUMBER SIGN 0x007 U+2026 HORIZONTAL ELLIPSIS 0x024 U+0024 DOLLAR SIGN 0x008 U+201A SINGLE LOW-9 QUOTATION 0x025 U+0025 PERCENT SIGN MARK 0x026 U+0026 AMPERSAND 0x009 U+201E DOUBLE LOW-9 QUOTATION MARK 0x027 U+0027 APOSTROPHE 0x00A U+2018 LEFT SINGLE QUOTATION 0x028 U+0028 LEFT PARENTHESIS MARK 0x00B U+2019 RIGHT SINGLE QUOTATION 0x029 U+0029 RIGHT PARENTHESIS MARK 0x02A U+002A ASTERISK -

MSR-4: Annotated Repertoire Tables, Non-CJK

Maximal Starting Repertoire - MSR-4 Annotated Repertoire Tables, Non-CJK Integration Panel Date: 2019-01-25 How to read this file: This file shows all non-CJK characters that are included in the MSR-4 with a yellow background. The set of these code points matches the repertoire specified in the XML format of the MSR. Where present, annotations on individual code points indicate some or all of the languages a code point is used for. This file lists only those Unicode blocks containing non-CJK code points included in the MSR. Code points listed in this document, which are PVALID in IDNA2008 but excluded from the MSR for various reasons are shown with pinkish annotations indicating the primary rationale for excluding the code points, together with other information about usage background, where present. Code points shown with a white background are not PVALID in IDNA2008. Repertoire corresponding to the CJK Unified Ideographs: Main (4E00-9FFF), Extension-A (3400-4DBF), Extension B (20000- 2A6DF), and Hangul Syllables (AC00-D7A3) are included in separate files. For links to these files see "Maximal Starting Repertoire - MSR-4: Overview and Rationale". How the repertoire was chosen: This file only provides a brief categorization of code points that are PVALID in IDNA2008 but excluded from the MSR. For a complete discussion of the principles and guidelines followed by the Integration Panel in creating the MSR, as well as links to the other files, please see “Maximal Starting Repertoire - MSR-4: Overview and Rationale”. Brief description of exclusion -

MSR-3-Annotated-Non-CJK-Tables-20180115

Maximal Starting Repertoire - MSR-3 Annotated Repertoire Tables, Non-CJK Integration Panel Date: 2018-1-15 How to read this file: This file shows all non-CJK characters that are included in the MSR-3 with a yellow background. The set of these code points matches the repertoire specified in the XML format of the MSR. Where present, annotations on individual code points indicate some or all of the languages a code point is used for. This file lists only those Unicode blocks containing non-CJK code points included in the MSR. Code points listed in this document, which are PVALID in IDNA2008 but excluded from the MSR for various reasons are shown with pinkish annotations indicating the primary rationale for excluding the code points, together with other information about usage background, where present. Code points shown with a white background are not PVALID in IDNA2008. Repertoire corresponding to the CJK Unified Ideographs: Main (4E00-9FFF), Extension-A (3400-4DBF), Extension B (20000-2A6DF), and Hangul Syllables (AC00-D7A3) are included in separate files. For links to these files see "Maximal Starting Repertoire - MSR-3: Overview and Rationale". How the repertoire was chosen: This file only provides a brief categorization of code points that are PVALID in IDNA2008 but excluded from the MSR. For a complete discussion of the principles and guidelines followed by the Integration Panel in creating the MSR, as well as links to the other files, please see “Maximal Starting Repertoire - MSR-3: Overview and Rationale”. Brief description of exclusion