Textbasierte Annotation Von Abbildungen Mit Kategorien Von Wikimedia

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Animal Spot Animal Spot Uses Intriguing Specimens from Cincinnati Museum Center’S Collections to Teach Children How Each Animal Is Unique to Its Environment

Animal Spot Animal Spot uses intriguing specimens from Cincinnati Museum Center’s collections to teach children how each animal is unique to its environment. Touch a cast of an elephant’s skull, feel a real dinosaur fossil, finish a three-layer fish puzzle, observe live fish and use interactives to explore how animals move, “dress” and eat. Case 1: Modes of Balance and Movement (Case design: horse legs in boots) Animals walk, run, jump, fly, and/or slither to their destination. Animals use many different parts of their bodies to help them move. The animals in this case are: • Blue Jay (Cyanocitta cristata) • Grasshopper (Shistocerca americana) • Locust (Dissosteira carolina) • Broad-wing damselfly (Family: Calopterygidae) • King Rail (Rallus elegans) • Eastern Mole (Scalopus aquaticus) • Brown trout (Salmo trutta) • Gila monster (Heloderma suspectum) • Damselfly (Agriocnemis pygmaea) • Pufferfish (Family: Tetraodontidae) • Bullfrog (Rona catesbrana) • Cicada (Family: Cicadidae) • Moths and Butterflies (Order: Lepidoptera) • Sea slugs (Order: Chepalaspidea) • Koala (Phascolarctos cinereus) • Fox Squirrel (Sciurus niger) • Giant Millipede (Subspecies: Lules) Case 2: Endo/Exoskeleton (Case design: Surrounded by bones) There are many different kinds of skeletons; some inside the body and others outside. The animals with skeletons on the inside have endoskeletons. Those animals that have skeletons on the outside have exoskeletons. Endoskeletons • Hellbender salamander (Genus: Cryptobranchus) • Python (Family: Boidae) • Perch (Genus: Perca) -

Field Keys to Common Hawaiian Marine Animals and Plants

DOCUMENT RESUME ED 197 993 SE 034 171 TTTTE Field Keys to Common Hawaiian Marine Animals and Plants: INSTITUTTON Hawaii State Dept. of Education, Honolulu. Officeof In::tructional Services. SEPOPT NO RS-78-5247 PUB DATE Mar 78 NOT? 74p.: Not available in he*:dcopy due to colored pages throughout entire document. EDRS PRICE MFO1 Plus Postage. PC Not Available frcm EPRS. DESCRIPTORS *Animals: Biology: Elementary Secondary Education: Environmental Education: *Field Trips: *Marine Biology: Outdoor Education: *Plant Identification: Science Educat4on TDENTIFTERS Hawaii ABSTRACT Presented are keys for identifyingcommon Hawaiian marine algae, beach plants, reef corals,sea urci.ins, tidepool fishes, and sea cucumbers. Nearly all speciesconsidered can be distinguished by characte-istics visible to- thenaked eye. Line drawings illustrate most plants atd animals included,and a list of suggested readings follows each section. (WB) *********************************************************************** Reproductions supplied by FDPS are the best thatcan be lade from the original document. **************************t***************************************** Field Keys to Common Hawaiian Marine Animals and Plants Office of Instructional Services/General Education Branch Department of Education State of Hawaii RS 78-5247 March 1978 "PERMISSION TO REPRODUCE THIS U S DEPARTMENT OF HEALTH. MATERIAL HAS BEEN GRANTED BY EDUCATION &WELFARE NATIONAL INSTITUTE OF EDUCATION P. Tz_urylo THIS DOCUMENT HAS BEEN qEPRO. DuCED EXACTLY AS PECE1VEDPO.` THE PE PSON OP OPC,AN7ATION ORIGIN. TING IT POINTS Or vIEW OR OPINIONS SATED DO NOT NECESSARILY PE PPE. TO THE EDUCATIONAL RESOURCES SENTO<<IC I AL NATIONAL INSTITUTE 0, INFORMATION CENTER (ERIC)." EDuCA T,ON POSIT.ON OR CY O A N 11 2 The Honorable George R. Arlyoshl Governor, State of Hawaii BOARD OF EDUCATION Rev. -

Systematics and Paleoenvironment of Quaternary Corals and Ostracods in Dallol Carbonates, North Afar

ADDIS ABABA UNIVERSITY SCHOOL OF EARTH SCIENCES SYSTEMATICS AND PALEOENVIRONMENT OF QUATERNARY CORALS AND OSTRACODS IN DALLOL CARBONATES, NORTH AFAR ADDIS HAILU ENDESHAW NOV., 2017 ADDIS ABABA, ETHIOPIA i Systematics and Paleoenvironments of Quaternary Corals and Ostracods in Dallol Carbonates; North Afar Addis Hailu Endeshaw Advisor – Dr. Balemwal Atnafu A Thesis Submitted to School of Earth Sciences Presented in Partial Fulfillment of the Requirements for the Degree of Masters of Science in Earth Sciences (Paleontology and Paleoenvironment) Addis Ababa University Addis Ababa, Ethiopia Nov., 2017 ii iii ABSTRACT Systematics and Paleoenvironment of Quaternary Corals and Ostracods in Dallol Carbonates, North Afar Addis Hailu Endeshaw Addis Ababa University, 2017 There are reef structures developed in Dallol during the Quaternary Period as a result of flooding of the area by the Red Sea at least two times. Dallol area is situated in the northern most part of the Eastern African Rift system. The studied coral outcrops are aligned along the northwestern margin of the Afar rift. This research focused on the investigation of systematics of corals and associated fossils of mollusca, echinoidea, ostracoda and foraminifera together with the reconstruction of past environmental conditions. Different scientific methods were followed in order to achieve the objectives of the study. These are detailed insitu morphological descriptions; field observations and measurements; laboratory preparations and microscopic examinations; comparison of the described specimens with type specimens; and paleoecological calculations using PAST-3 software. Total of 164 fossil and 9 sediment samples are collected from the field and examined. The Dallol corals are classified into 12 Families, 29 Genera and 60 Species. -

The Northern Bay of Safaga (Red Sea, Egypt): an Actuopalaeontological Approach III

ZOBODAT - www.zobodat.at Zoologisch-Botanische Datenbank/Zoological-Botanical Database Digitale Literatur/Digital Literature Zeitschrift/Journal: Beiträge zur Paläontologie Jahr/Year: 1992 Band/Volume: 17 Autor(en)/Author(s): Nebelsick James H. Artikel/Article: The Northern Bay of Safaga (Red Sea, Egypt): An Actuopalaeontological Approach III. Distribution of Echinoids. Die Nördliche Bucht von Safaga (Rotes Meer, Ägypten): ein aktuopaläontologisches Beispiel III. Verteilung von Echiniden 5-79 ©Verein zur Förderung der Paläontologie am Institut für Paläontologie, Geozentrum Wien Beitr. Paläont. Osterr., 17:5-79, Wien 1992 The Northern Bay of Safaga (Red Sea, Egypt): An Actuopalaeontological Approach III. Distribution of Echinoids Die Nördliche Bucht von Safaga (Rotes Meer, Ägypten): ein aktuopaläontologisches Beispiel III. Verteilung von Echiniden by James H. NEBELSICK" NEBELSICK, J. H., 1992. The Northern Bay of Safaga (Red Sea, Egypt): an actuopalaeontological approach. III. Distribution of echinoids. — Beitr. Palaont. Osterr. 17: 5-79, Wien. Contents 5. Conclusions 45 6. Acknowledgements 48 Abstract 5 7. References 48 Zusammenfassung 6 1. Introduction .... 6 2. Methods 10 Abstract 3. Results 14 Actuopalaeontological investigations have been con 3.1. Distribution of echinoids and ducted on the echinoid fauna from the Northern Bay fragments . 14 of Safaga, Red Sea, Egypt. This area was chosen for 3.1.1. Regular echinoids 14 study as it represents a highly structured, shallow 3.1.2. Irregular echinoids ...24 water, tropical, carbonate environment. Echinoids 3.2. Correlation of echinoids .30 fragments were common in 67 bulk sediment samples 3.3. Multivariate statistical analysis .. 30 which were collected in a variety of bottom and sed 3.3.1. Analysis of all echinoid fragment imentary facies down to a depth of 57 m. -

Assessment of Species Composition, Diversity and Biomass in Marine Habitats and Subhabitats Around Offshore Islets in the Main Hawaiian Islands

ASSESSMENT OF SPECIES COMPOSITION, DIVERSITY AND BIOMASS IN MARINE HABITATS AND SUBHABITATS AROUND OFFSHORE ISLETS IN THE MAIN HAWAIIAN ISLANDS January 2008 COVER Colony of Pocillopora eydouxi ca. 2 m in longer diameter, photographed at 9 m depth on 30-Aug- 07 outside of Kāpapa Islet, O‘ahu. ASSESSMENT OF SPECIES COMPOSITION, DIVERSITY AND BIOMASS IN MARINE HABITATS AND SUBHABITATS AROUND OFFSHORE ISLETS IN THE MAIN HAWAIIAN ISLANDS Final report prepared for the Hawai‘i Coral Reef Initiative and the National Fish and Wildlife Foundation S. L. Coles Louise Giuseffi Melanie Hutchinson Bishop Museum Hawai‘i Biological Survey Bishop Museum Technical Report No 39 Honolulu, Hawai‘i January 2008 Published by Bishop Museum Press 1525 Bernice Street Honolulu, Hawai‘i Copyright © 2008 Bishop Museum All Rights Reserved Printed in the United States of America ISSN 1085-455X Contribution No. 2008-001 to the Hawaii Biological Survey EXECUTIVE SUMMARY The marine algae, invertebrate and fish communities were surveyed at ten islet or offshore island sites in the Main Hawaiian Islands in the vicinity of Lāna‘i (Pu‘u Pehe and Po‘o Po‘o Islets), Maui (Kaemi and Hulu Islets and the outer rim of Molokini), off Kaulapapa National Historic Park on Moloka‘i (Mōkapu, ‘Ōkala and Nāmoku Islets) and O‘ahu (Kāohikaipu Islet and outside Kāpapa Island) in 2007. Survey protocol at all sites consisted of an initial reconnaissance survey on which all algae, invertebrates and fishes that could be identified on site were listed and or photographed and collections of algae and invertebrates were collected for later laboratory identification. -

Brandt, M. 2003. Influencia Del Erizo Lapicero (Eucidaris Thouarsii)

Universidad San Francisco de Quito Colegio Ciencias de la Vida Influencia del erizo lapicero (Eucidaris thouarsii) en la estructura de la comunidad submarina de la cara norte del Islote Caamaño, Galápagos. MARGARITA BRANDT Tesis para la obtención del grado de Baccalaureus Scientiae (B.S.), especialización en Ecología Aplicada Quito, enero del 2003 RESUMEN El erizo lapicero, Eucidaris thouarsii, es la especie de erizo más abundante y está ampliamente distribuido en las Islas Galápagos. Este estudio consistió en medir los efectos que tienen las distintas densidades de esta especie de erizo de mar en la cara norte del Islote Caamaño. Se establecieron tres cuadrantes permanentes de 36 m2 entre 4 y 6 m de profundidad. El primer cuadrante sirvió de control, en el segundo se duplicaron las densidades originales de los erizos y del tercero se removieron todos los individuos de E. thouarsii. No obstante las densidades originales de los erizos y las condiciones de las comunidades fuesen diferentes en los distintos cuadrantes antes de iniciar el experimento, el efecto del erizo lapicero se resume en que sus altas densidades mantienen comunidades marinas dominadas por algas incrustantes y roca desnuda, lo que podría conllevar a efectos secundarios en otras taxas competitivamente inferiores. Esto tiene una fuerte implicación en la conservación de la biodiversidad de los ecosistemas submarinos de Galápagos, porque si se llega a determinar que la abundancia del erizo lapicero está desplazando competitivamente a otras especies, podría pensarse en la regulación de sus densidades para recuperar la estructura de las comunidades. _______________ Margarita Brandt 1 HOJA DE APROBACIÓN Margarita Brandt Influencia del erizo lapicero (Eucidaris thouarsii) en la estructura de la comunidad submarina de la cara norte del Islote Caamaño, Galápagos. -

The Complete Devewpment of the Deep-Sea Cidaroid Urchin

View metadata, citation and similar papers at core.ac.uk brought to you by CORE provided by University of Oregon Scholars' Bank THE COMPLETE DEVEWPMENT OF THE DEEP-SEA CIDAROID URCHIN CIDARIS BLAKEI (AGASSIZ, 1878) WITH AN EMPHASIS ON THE HYALINE LAYER by KATHLEEN BENNETT A THESIS Presented to the Department ofBiology and the Graduate School ofthe University ofOregon in partial fulfillment ofthe requirements for the degree of Master ofScience December 2009 11 "The Complete Development ofthe Deep-Sea Cidaroid Urchin Cidaris blakei (Agassiz, 1878) With an Emphasis on the Hyaline Layer," a thesis prepared by Kathleen Bennett in partial fulfillment ofthe requirements for the Master ofScience degree in the Department ofBiology. This thesis has been approved and accepted by: Al 'Sb1ilAld;, C air ofthe Examining Committee Date Committee in Charge: Alan Shanks, Chair Richard Emlet Craig Young Accepted by: Dean ofthe Graduate School III © 2009 Kathleen Bennett IV An Abstract ofthe Thesis of Kathleen Bennett for the degree of Master ofScience in the Department ofBiology to be taken December 2009 Title: THE COMPLETE DEVELOPMENT OF THE DEEP-SEA CIDAROID URCHIN CIDARIS BLAKEI(AGASSIZ, 1878) WITH AN EMPHASIS ON THE HYALINE LAYER Approved: Alan Shanks Living echinoids comprise two major sister clades, the Euechinoidea and the Cidaroidea. Cidaroids first appeared during the lower Permian (~255 mya) and are considered to represent the primitive form ofall other living echinoids. The present study ofCidaris blakei, a deep-sea planktotrophic cidaroid urchin, provides a description ofdevelopment from fertilization through early juvenile stages and is the first report ofa deep-sea organism reared through metamorphosis. -

Asterocheres Siphunculus, a New Species of Asterocheridae

Zoosymposia 8: 29–38 (2012) ISSN 1178-9905 (print edition) www.mapress.com/zoosymposia/ ZOOSYMPOSIA Copyright © 2012 · Magnolia Press ISSN 1178-9913 (online edition) urn:lsid:zoobank.org:pub:2C9E7C09-D147-4D22-A47A-9069FA752C91 Asterocheres siphunculus, a new species of Asterocheridae (Copepoda, Siphonostomatoida) associated with Eucidaris tribuloides (Lamarck, 1816) (Echinodermata, Echinoidea) in Brazil CRISTIANO BAHIA1, ROBERTA CANÁRIO2, ELIZABETH G. NEVES3 & RODRIGO JOHNSSON4,5 Universidade Federal da Bahia, Inst. Biologia, Dept. Zoologia, LABIMAR – Crustacea, Cnidaria & Fauna Associada, Av. Adhemar de Barros, s/n, Campus de Ondina, Bahia, BRAZIL - CEP: 40170-290. Emails: [email protected]; [email protected]; [email protected]; [email protected] 5Corresponding author Abstract Asterocheres Boeck, 1859 is the most speciose genus within the copepod family Asterocheridae Giesbrecht, 1899. Its main hosts are sponges, cnidarians, bryozoans, and echinoderms. Among the latter there are records of Asterocheres associations with some species of the echinoid genus Eucidaris Pomel, 1883. Despite the wide distribution of Eucidaris tribuloides (Lamarck, 1883) in the coastal waters of Brazil, no records exist as yet of any copepod associated with this species. Asterocheres siphunculus sp. nov. is described herein based on samples collected from E. tribuloides sampled from two different sites off the coast of Salvador city, Bahia state, in northeastern Brazil. The new species shares a 20-segmented antennule with 20 congeners, but differs from them by having a very short siphon that reaches the insertion of the maxilla, a very wide rostrum that occupies the entire area between the antennules, and a pedigerous somite 4 with pointed and narrow posterolateral corners and a concave posterior margin. -

Echinodermata

Echinodermata Gr : spine skin 6500 spp all marine except for few estuarine, none freshwater 1) pentamerous radial symmetry (adults) *larvae bilateral symmetrical 2) spines 3) endoskeleton mesodermally-derived ossicles calcareous plates up to 95% CaCO3, up to 15% MgCO3, salts, trace metals, small amount of organic materials 4) water vascular system (WVS) 5) tube feet (podia) Unicellular (acellular) Multicellular (metazoa) protozoan protists Poorly defined Diploblastic tissue layers Triploblastic Cnidaria Porifera Ctenophora Placozoa Uncertain Acoelomate Coelomate Pseudocoelomate Priapulida Rotifera Chaetognatha Platyhelminthes Nematoda Gastrotricha Rhynchocoela (Nemertea) Kinorhyncha Entoprocta Mesozoa Acanthocephala Loricifera Gnathostomulida Nematomorpha Protostomes Uncertain (misfits) Deuterostomes Annelida Mollusca Echinodermata Brachiopoda Hemichordata Arthropoda Phoronida Onychophora Bryozoa Chordata Pentastomida Pogonophora Sipuncula Echiura 1 Chapter 14: Echinodermata Classes: 1) Asteroidea (Gr: characterized by star-like) 1600 spp 2) Ophiuroidea (Gr: snake-tail-like) 2100 spp 3) Echinoidea (Gr: hedgehog-form) 1000 spp 4) Holothuroidea (Gr: sea cucumber-like) 1200 spp 5) Crinoidea (Gr: lily-like) stalked – 100 spp nonstalked, motile comatulid (feather stars)- 600 spp Asteroidea sea stars/starfish arms not sharply marked off from central star shaped disc spines fixed pedicellariae ambulacral groove open tube feet with suckers on oral side anus/madreporite aboral 2 Figure 22.01 Pincushion star, Culcita navaeguineae, preys on coral -

Echinodermata: Echinoidea) Alexander Ziegler*1, Cornelius Faber2 and Thomas Bartolomaeus3

Frontiers in Zoology BioMed Central Research Open Access Comparative morphology of the axial complex and interdependence of internal organ systems in sea urchins (Echinodermata: Echinoidea) Alexander Ziegler*1, Cornelius Faber2 and Thomas Bartolomaeus3 Address: 1Institut für Immungenetik, Charité-Universitätsmedizin Berlin, Freie Universität Berlin, Thielallee 73, 14195 Berlin, Germany, 2Institut für Klinische Radiologie, Universitätsklinikum Münster, Westfälische Wilhelms-Universität Münster, Waldeyerstraße 1, 48149 Münster, Germany and 3Institut für Evolutionsbiologie und Zooökologie, Rheinische Friedrich-Wilhelms-Universität Bonn, An der Immenburg 1, 53121 Bonn, Germany Email: Alexander Ziegler* - [email protected]; Cornelius Faber - [email protected]; Thomas Bartolomaeus - [email protected] * Corresponding author Published: 9 June 2009 Received: 4 December 2008 Accepted: 9 June 2009 Frontiers in Zoology 2009, 6:10 doi:10.1186/1742-9994-6-10 This article is available from: http://www.frontiersinzoology.com/content/6/1/10 © 2009 Ziegler et al; licensee BioMed Central Ltd. This is an Open Access article distributed under the terms of the Creative Commons Attribution License (http://creativecommons.org/licenses/by/2.0), which permits unrestricted use, distribution, and reproduction in any medium, provided the original work is properly cited. Abstract Background: The axial complex of echinoderms (Echinodermata) is composed of various primary and secondary body cavities that interact with each other. In sea urchins (Echinoidea), structural differences of the axial complex in "regular" and irregular species have been observed, but the reasons underlying these differences are not fully understood. In addition, a better knowledge of axial complex diversity could not only be useful for phylogenetic inferences, but improve also an understanding of the function of this enigmatic structure. -

A Preliminary Quantitative Survey of the Echinoid Fauna of Kealakekua and Honaunau Bays, Hawaii' THOMAS A

A Preliminary Quantitative Survey of the Echinoid Fauna of Kealakekua and Honaunau Bays, Hawaii' THOMAS A. EBERT2 DURING 8 DAYS in early August and October, author; in October, the team consisted of E. 1968, the members of an expedition from the Brecknock and D. Kelso. University of Hawaii examined the distribution and abundance of sea urchins in two bays along ORGANISMS the Kona (leeward) Coast of the Island of Hawaii (Fig. 1) : Kealakekua Bay (19 0 28' N; Edmondson (1946) lists 14 regular urchins 155 0 55' W) and Honaunau Bay (19 0 25' N ; found as members of shallow-water benthic as 155 0 55' W). The major sampling effort was semblages in Hawaiian waters. Eleven of these expended in Kealakekua, the larger of the two were found in Kealakekua and Honaunau bays bays. The expedition was part of a program to and are listed below. The classification of Hy survey the biota of Kealakekua. Information man (1955) is used. gathered from this survey will form a baseline Order Cidaroidea for assessing changes that may be brought about Family Cidaridae by the activities of tourists and shoreline resi Chondrocidaris gigantea A. Agassiz dents. At the present time, there is a small vil Eucidaris metularia (Lamarck) lage on Kealakekua (Napoopoo) plus a small Order Diadematoidea number of homes at the middle and south ends Family Diadematidae of the bay. The north end, by Captain Cook Diadema pa1lcispina A. Agassiz Monument, is uninhabited. At Honaunau Bay Echinothrix calamaris (Pallas) there is a small village, Honaunau, and the E. diadema (Linnaeus) City of Refuge National Historical Park. -

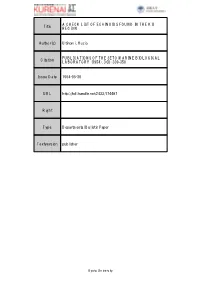

Title a CHECK LIST of ECHINOIDS FOUND in the KII REGION Author(S)

A CHECK LIST OF ECHINOIDS FOUND IN THE KII Title REGION Author(s) Utinomi, Huzio PUBLICATIONS OF THE SETO MARINE BIOLOGICAL Citation LABORATORY (1954), 3(3): 339-358 Issue Date 1954-05-30 URL http://hdl.handle.net/2433/174487 Right Type Departmental Bulletin Paper Textversion publisher Kyoto University 1 A CHECK LIST OF ECHINOIDS FOUND IN THE KII REGION ) Huzro UTINOMI Seto Marine Biological Laboratory, Sirahama With one Text-figure Introduction The Echinoderm fauna of the Kii region, Middle Japan, has never been made the object of special investigation. A number of species of the Echinoidea have hitherto been recorded from various places along the Kii Peninsula, but such records are scattered in various works dealing with the embryological or ecological subject, and are, naturally, not all of them quite reliable taxonomically. Whereas recently a preliminary record on the regular-formed echinoids of Wakayama Prefecture has been given by SAKAGUCHI, basing on the identification by the late echinologist Hayato IKEDA, in "Kisyil Dosyokubutu", vol. II, no. 2 (1935), no special work on this group has been given till now, excepting my two short mimeo graphed papers. I therefore thpught that a catalogue of all the known echinoids hitherto recorded or described from the Kii region would be of some value to stu dents interested to these animals. The echinoids given in the present paper amount to 53 species in all, of which 33 belong to the Regularia and 20 to the Irregularia. Among them, 45 species are seen in materials at hand and thus their occurrence has been confirmed by myself.