Reutilización De Ontologías En Un Dominio Restringido

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Les Lycéens Et Jeanne Granier

Troisième Année — N° 108 LE NUMÉRO : 15 CENTIMES Samedi 31 Mars 1883 igg-y!-».,^,»».»^,,,,.,^.!..^..^, .j1.,^^---.,fm . .nui %u. D'ASCO A. I>e LATOUR (Lyon) ADMINISTRAT!'! UR £. DESCLAUZAS d»aris) ABONNEMENTS RÉDACTEURS EN CHEF Lyon UN AN Fr. 10 ABONNEMENTS Paris et Départements. — ••' Lyon UN AN Fr. 10 On reçoit les lâteonifëhïéttts de TROIS paris et Départements. ,-g i* et, SIX MOr. .-aii", ft>ais diujs ions les liinvuix ite posta On reçoit les abonnements de TROIS et de SIX mois —\mU&'' Les Minonces et Réclames Journal d'Indiscrétions, Littéraire, Satirique, Mondain, Théâtral, Financier sont exclusivement reçues Rédaction i Administration à l'Agence, V. FOURNIER Mieux est de ris que de larmes escripre, 14, Rue Confort, Lyon .,-. 6, place des Terreaux, 8 PARAISSANT LE JEUDI EN PROVINCE ET LE SAMEDI A PARIS Pour ce que tire est le propre de l'homme. i Paris, à l'Agence HAVAS xssroTsr Françoys RABKLAIS. 8, place de la Bourse LES LYCÉENS ET JEANNE GRANIER MORTE DE FAIM. --• LE COUP D'ÉTAT mère m'attend, Marguerite Méphisto, que le mien, puis Fistulanus, puis Thi- l'eau grasse — ramena un pauvre diable révolution était utile, elle naîtrait de Seine ; elle coulait, sinistre, avec un Annette Bassin, Elisa du Fer, Joséphine baul, puis Mermex, puis Gapitou, puis tout tremblant .. C'était un collégien, la décomposition de ce cadavre de clapotement lugubre sous les ponts : la plantureuse, Fonfon, Marthe de la tous les onze enfin, avaient reçu la pâle, défait, hâve. jeune fille. Tu as. pensé que cette robe liquide Roche. — Tiens I s'écria un potache en irait bien à ton cadavre vert. -

Copyrighted Material

37_599100 bindex.qxd 8/31/05 8:21 PM Page 353 Index basics of card games. See Ninety-Nine, 143–148 • A • also card games; cards Oh Hell!, 137–138 Accordion, 22–26 deck of cards, 10 Partnership Auction aces around, 205, 222 etiquette for playing, 17 Pinochle, 220–221 Alexander the Great (La playing a game, 14–17 Setback, 227–228 Belle Lucie), 31–35 preparing to play, 11–14 Spades, 163–169, 171 all pass (in President), 255 ranking card order, 11 big blind (in Poker), 285 allin (in Poker), 287 selecting a game, 17–19 Black Jack (Switch), American Contract Bridge Beggar My Neighbor (Beat 108–110 League (Web site), 185 Your Neighbor Out of Black Maria, 199 American Cribbage Con- Doors), 45–47 Black Peter card, 57 gress (Web site), 252 beggars (in President), 256 Blackjack Animals, 49–50 beginning to play. See basics aces and going high or announcement, 13 of card games low, 276–277 ante, 112, 285, 302 Benny (Best Bower), 154 betting in Casino auction (in Bridge), 13, 185 bets Blackjack, 271–272 Auction Pinochle anteing up (in Poker), 285 betting in Social bidding, 211–212, 213–214, bidding versus, 13 Blackjack, 265–266 218–219 calling (in Poker), 286 card values, 264 conceding your hand, 219 opening (in Poker), Casino Blackjack, 271–277 dealing, 212 294–296 croupiers, shoes, banks, discarding, 214–215 out of turn (in Poker), 288 pit bosses, 271 kitty, 212, 215–216 seeing (in Poker), 286 dealing in Casino Black- melds, 214–215 Bid Whist, 133–134 jack, 272–273 scoring, 216–218 bidding dealing in Social Black- strategies for play, betting versus, 13 jack, 263, 264–265 218–219 blind nil, 164, 167–168 doubling down, 275 Authors, 53–54 defined, 13 five or sixcard tricks, 269 dropping, 214 kibitzer, 271 listening to, 348 naturals, 267, 268 • B • for nil (zero), 164, origin of, 265 166–169, 171 paying players, 268 balanced hands (in COPYRIGHTED MATERIAL overbids, 214 selecting banker/ Spades), 166 safe, 214 dealer, 263 banker (in Blackjack), shooting the moon, Social Blackjack, 263–270 263–264, 266, 268, 271 196–197, 230, 234 splitting cards, 266, banking card games. -

Bar-Tender's Guide Or How to Mix Drinks

JERRY THOMAS' BAR-TENDERS GUIDE НOW TO MIX DRINKS NEW YORK. DIС AND FITZGERALD, PUBLISHERS. THE BAR-TENDERS GUIDE; OR, HOW TO MIX ALL KINDS OF PLAIN AND FANCY DRINKS, CONTAINING CLEAR AND RELIABLE DIRECTIONS FOB MIXING ALL THE BEVERAGES USED IN THE UNITED STATES, TOGETHER WITH THE MOST POPULAR BRITISH, FRENCH, GERMAN, ITALIAN, EUSSIAN, AND SPANISH RECIPES ; EMBRACING PUNCHES, JULEPS, COBBLERS, ETC., ETC., IN ENDLESS VARIETY. BY JERRY THOMAS, Formerly Principal Bar-Tender at the Metropolitan Hotel, New York, and the Planters' House, 81. Louis. NEW YORK: DICK & FITZGERALD, PUBLISHERS, No. 18 ANN STREET. Entered according to Act of Congress, in the year 1862, by DICK & FITZGERALD, In the Clerk's Office of the District Court of the United States, for the Southern District of New York. - Entered according to Act of Congress, in the year 1876, BY DICK & FITZGERALD, In the Office of the Librarian of Congress, at Washington, D. C. PREFACE. In all ages of the world, and in all countries, men have in dulged in "so cial drinks." They have al ways possess ed themselves of some popu lar beverage apart from water and those of the breakfast and tea table. Whether it is judicious that mankind should con tinue to indulge in such things, or whether it would be wiser to abstain from all enjoyments of that character, it is not our province to decide. We leave that question to the moral philosopher. We simply contend that a relish for "social drinks" is universal; that those drinks exist in greater variety in the United States than in any other country in the world; and that he, therefore, who proposes to impart to these drink not only the most palatable but the most wholesome characteristics of which they may be made susceptible, is a genuine public benefactor. -

N° 44 • Juillet - Ao

JMn44 13/08/07 16:05 Page 2 Journal de laN° Ville 44 Juillet/Août 2007 Numéro spécial Numéro Journal de la ville Actu Le point sur… Culture Les quais de la Marine Le Cœur de Ville La Saison Culturelle 2007-2008 JMn44 13/08/07 16:05 Page 3 Somma N° 44 • Juillet - Ao Actu Gilles D’Ettore, Député de l’Hérault . .p. 4 “Les Hérault du Cinéma”, un Festival de courts métrages qui joue désormais dans la cour des grands . .p. 6 Inauguration des quais de la Marine . .p. 12 Caroline Belda, la nouvelle Commissaire de Police d’Agde . .p. 14 Environnement Nouveau sentier sous-marin : venez photographier les fonds marins du Cap d’Agde . .p. 15 Le service Environnement se bouge pour la qualité et la sécurité de nos plages . .p. 16 Le point sur… Le Cœur de Ville, un héritage millénaire et un projet d’avenir . .p. 18 Patrimoine “Agde, 2600 ans déjà”, un voyage dans le temps le temps d’un week-end . .p. 24 Un nouveau circuit touristique en Cœur de Ville pour promouvoir son remarquable patrimoine . .p. 26 Culture La 3ème Nuit des Musées… a duré 3 nuits . .p. 27 Saison Culturelle 2007-2008, une sixième édition riche et variée . .p. 28 Comités de Quartier 105 représentants pour améliorer notre qualité de vie . p. 31 Au Conseil Séance du 23 mai 2007 . .p. 32 JMn44 13/08/07 16:05 Page 4 maire Août 2007 Bloc-notes Arrivée des renforts de police . p. 36 David Augeix rêve à nouveau de Bahia . p. 37 Election : un nouvel Adjoint pour Agde . -

Ontologías Protègè

Instituto de Computación – Facultad de Ingeniería Universidad de la República Oriental del Uruguay Tesis de Maestría en Ingeniería en Computación Reuso de Reglas de Negocio: Una experiencia de reuso de ontologías en un dominio restringido. Enrique Latorres Supervisor: Juan Echagüe Diciembre 2002 C:\Documents and Settings\latorres\Mis documentos\Public\tesis\Tesis Latorres.doc Autor: enriqueCreac. 24/02/2003 08:39 Imp. 19/03/2003 05:03 Guard. latorres. Página 1 de 29 INDICE 1 Reconocimientos ......................................................................................3 2 Resúmen ..................................................................................................4 3 Introducción ..............................................................................................4 3.1 Ontologías .........................................................................................8 3.2 Aplicaciones para el desarrollo del software....................................10 3.3 Descripción de la investigación y los experimentos.........................10 3.4 Aportes de este trabajo....................................................................11 3.5 Organización del Trabajo.................................................................11 4 Diseño experimental ...............................................................................11 4.1 Hipótesis de los experimentos.........................................................11 4.2 Experimentos realizados .................................................................13 -

The Golden Wheel Dream-Book and Fortune-Teller

ONTAINE'S^ : Sent Free of Postage on Receipt of Price. Dick's One Hundred Amy.senients for Evening Parties, Pienics and Social Gatherings. TMa book is fall of Oiagiiial !N"ov"elties. It contains Kew and Attractive Grames, clearly illus- A variety of new and ingenious puzzles. trated hy means of Witty Examples, Comical Illusions, fully described. These showing how each may he most success- surprising and grotesque illusions are fully picked. very startling in their effects, and Surprising Trichs, easy ofperformance. present little or no difficulty in their Musical aaid other innocent sells. preparation. Also as Entirely '^ew Tersion of the Celebrated "Mrs. Jarley's TTax Works.'' THE flexible GIAITT. A COMIO ILLUSION. Elustrated and explained by sixty fine wood engravings. Illuminated paper covers 30 cts* Bonnd in boards, with cloth back 50 cts. : 8eat Free of t^osrage on Receipt ©f l»rlce. The Art and Etiquette of Making Love, a Maaual of Love, Courtship and Matiimony. It tells Mow to Cure Bashfulness; How to Commence a Courtship^ How to Please a Sweetheart or Loveft How to Write a Love-Letter; Mow to '' Pop the Question'"'; Mow to Act Before and After a Fto= posal) Mow to Acceptor lieject j, ProposaZj Mow to Break off an Engagemerd; Mow to Act After an Bngagement; Mow to Act as Bridesmaid or Groomg* man; Mow the Etiquette of a Wedding and ths After-Reception Should be Observedt And, in fact, how to Puifill eveiy duty and meet every contin- gency connected with courtship and matrimony. j;t includes also a choice collection of sensible Letters suitable for all tha contiagencies of Love and Courtship. -

Website Listing Ajax

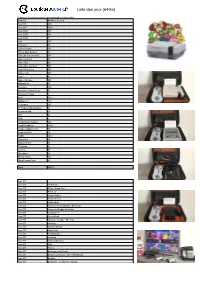

Liste des jeux (64Go) Cliquez sur le nom des consoles pour descendre au bon endroit Console Nombre de jeux Atari ST 274 Atari 800 5627 Atari 2600 457 Atari 5200 101 Atari 7800 51 C64 150 Channel F 34 Coleco Vision 151 Family Disk System 43 FBA Libretro (arcade) 647 Game & watch 58 Game Boy 621 Game Boy Advance 951 Game Boy Color 501 Game gear 277 Lynx 84 Mame (arcade) 808 Nintento 64 78 Neo-Geo 152 Neo-Geo Pocket Color 81 Neo-Geo Pocket 9 NES 1812 Odyssey 2 125 Pc Engine 291 Pc Engine Supergraphx 97 Pokémon Mini 26 PS1 54 PSP 2 Sega Master System 288 Sega Megadrive 1030 Sega megadrive 32x 30 Sega sg-1000 59 SNES 1461 Stellaview 66 Sufami Turbo 15 Thomson 82 Vectrex 75 Virtualboy 24 Wonderswan 102 WonderswanColor 83 Total 16877 Atari ST Atari ST 10th Frame Atari ST 500cc Grand Prix Atari ST 5th Gear Atari ST Action Fighter Atari ST Action Service Atari ST Addictaball Atari ST Advanced Fruit Machine Simulator Atari ST Advanced Rugby Simulator Atari ST Afterburner Atari ST Alien World Atari ST Alternate Reality - The City Atari ST Anarchy Atari ST Another World Atari ST Apprentice Atari ST Archipelagos Atari ST Arcticfox Atari ST Artificial Dreams Atari ST Atax Atari ST Atomix Atari ST Backgammon Royale Atari ST Balance of Power - The 1990 Edition Atari ST Ballistix Atari ST Barbarian : Le Guerrier Absolu Atari ST Battle Chess Atari ST Battle Probe Atari ST Battlehawks 1942 Atari ST Beach Volley Atari ST Beastlord Atari ST Beyond the Ice Palace Atari ST Black Tiger Atari ST Blasteroids Atari ST Blazing Thunder Atari ST Blood Money Atari ST BMX Simulator Atari ST Bob Winner Atari ST Bomb Jack Atari ST Bumpy Atari ST Burger Man Atari ST Captain Fizz Meets the Blaster-Trons Atari ST Carrier Command Atari ST Cartoon Capers Atari ST Catch 23 Atari ST Championship Baseball Atari ST Championship Cricket Atari ST Championship Wrestling Atari ST Chase H.Q. -

Klondike Solitaire Kings Lataa Torrent Crack by Fitgirl

Klondike Solitaire Kings Lataa torrent crack by FitGirl Tietoja pelistä Famous Card game also known as Klondike. We kept the game true to the spirit of the classic Solitaire (also known as Klondike or Patience) Klondike Solitaire Kings features a beautiful custom designed card set in high resolution with 300+ levels, playing Patience on your desktop never looked this good! Features: Fun Addicting Games of Solitaire Classic 300+ levels Klondike Solitaire Draw 1 card Klondike Solitaire Draw 3 cards Winning Deals: Increase the challenge Vegas Cumulative: Keep your score rolling over Addicting, unique ways to play Customizable beautiful themes Daily challenges with different levels Clean and user-friendly menus Big and easy to see cards Auto-collect cards on completion Feature to UNDO moves Feature to use hints Standard or Vegas scoring How to Play Klondike Solitaire Klondike Solitaire is the most widely known solitaire game, popularised originally by being part of Windows 3.0 when it was released in 1990. Originally it was included to help teach people how to use a mouse correctly, but surely became one of the most popular little games to fill up a few minutes around the globe. It's quite relaxing and offers a good chance of winning with some basic playing techniques. Setting Up Klondike Solitaire Klondike Solitaire is played with a standard deck of 52 cards with all jokers removed. As you can see from the picture below, you must deal 7 columns of cards with the card at the bottom shown face up. The first column is one card (face up), the second is two cards with one card face up and the number of cards in each column increases by one until the final column is made of seven cards with the final card face up as with the other columns. -

A Casual Revolution Reinventing Video Games and Their Players

A CASUAL REVOLUTION REINVENTING VIDEO GAMES AND THEIR PLAYERS JESPER JUUL ACASUALREVOLUTION ACASUALREVOLUTION Reinventing Video Games and Their Players Jesper Juul The MIT Press Cambridge, Massachusetts London, England 8 2010 Jesper Juul All rights reserved. No part of this book may be reproduced in any form by any electronic or mechanical means (including photocopying, recording, or informa- tion storage and retrieval) without permission in writing from the publisher. For information about special quantity discounts, please email [email protected] This book was set in Scala Serif and Scala Sans on 3B2 by Asco Typesetters, Hong Kong. Printed and bound in the United States of America. Library of Congress Cataloging-in-Publication Data Juul, Jesper, 1970– A casual revolution : reinventing video games and their players / Jesper Juul. p. cm. Includes bibliographical references and index. ISBN 978-0-262-01337-6 (hardcover : alk. paper) 1. Video games—Psychological aspects. 2. Video gamers—Psychology. I. Title. GV1469.34.P79J88 2010 794.8—dc22 2009009091 10987654321 Contents Acknowledgments vii 1 A Casual Revolution 1 2 What Is Casual? 25 3 All the Games You Played Before 65 4 Innovations and Clones: The Gradual Evolution of Downloadable Casual Games 79 5 Return to Player Space: The Success of Mimetic Interface Games 103 6 Social Meaning and Social Goals 121 7 Casual Play in a Hardcore Game 129 8 Players, Developers, and the Future of Video Games 145 Appendix A: Player Survey 153 Appendix B: Player Stories 157 Appendix C: Developer Interviews 175 Notes 219 References 233 Index 247 Acknowledgments First, I must thank colleagues and students for the knowledge, helpful- ness, and discussions that made this book infinitely better than it would have been otherwise. -

1455189355674.Pdf

THE STORYTeller’S THESAURUS FANTASY, HISTORY, AND HORROR JAMES M. WARD AND ANNE K. BROWN Cover by: Peter Bradley LEGAL PAGE: Every effort has been made not to make use of proprietary or copyrighted materi- al. Any mention of actual commercial products in this book does not constitute an endorsement. www.trolllord.com www.chenaultandgraypublishing.com Email:[email protected] Printed in U.S.A © 2013 Chenault & Gray Publishing, LLC. All Rights Reserved. Storyteller’s Thesaurus Trademark of Cheanult & Gray Publishing. All Rights Reserved. Chenault & Gray Publishing, Troll Lord Games logos are Trademark of Chenault & Gray Publishing. All Rights Reserved. TABLE OF CONTENTS THE STORYTeller’S THESAURUS 1 FANTASY, HISTORY, AND HORROR 1 JAMES M. WARD AND ANNE K. BROWN 1 INTRODUCTION 8 WHAT MAKES THIS BOOK DIFFERENT 8 THE STORYTeller’s RESPONSIBILITY: RESEARCH 9 WHAT THIS BOOK DOES NOT CONTAIN 9 A WHISPER OF ENCOURAGEMENT 10 CHAPTER 1: CHARACTER BUILDING 11 GENDER 11 AGE 11 PHYSICAL AttRIBUTES 11 SIZE AND BODY TYPE 11 FACIAL FEATURES 12 HAIR 13 SPECIES 13 PERSONALITY 14 PHOBIAS 15 OCCUPATIONS 17 ADVENTURERS 17 CIVILIANS 18 ORGANIZATIONS 21 CHAPTER 2: CLOTHING 22 STYLES OF DRESS 22 CLOTHING PIECES 22 CLOTHING CONSTRUCTION 24 CHAPTER 3: ARCHITECTURE AND PROPERTY 25 ARCHITECTURAL STYLES AND ELEMENTS 25 BUILDING MATERIALS 26 PROPERTY TYPES 26 SPECIALTY ANATOMY 29 CHAPTER 4: FURNISHINGS 30 CHAPTER 5: EQUIPMENT AND TOOLS 31 ADVENTurer’S GEAR 31 GENERAL EQUIPMENT AND TOOLS 31 2 THE STORYTeller’s Thesaurus KITCHEN EQUIPMENT 35 LINENS 36 MUSICAL INSTRUMENTS -

The Coco Commuh . 11--Zty

the CoCo Commuh11--z . ty -r_ JOr The August 1991 vo1. x1 No. 1 From Computer Plus to YOU ... PLUS after PL�' �e�0��;;;, '' � ' -�-··-' -....··.-..... _-3',....- - ---· --. �- · · � ..,,.!..;:� ...........,,, ��';· - . ��- Color Computer Disk Drive DMP-134 269 Drive O $239 Drive 1 $149 TandyFax 1010 $619 BIG SAVINGS ON A FULL COMPLEMENT OF RADIO SHACK COMPUTER PRODUCTS COMPUTERS COLOR COMPUTER MISC. Tandy Educatioal Software 2.00 Tandy1000 RLXHD 1 Drive1MegRAM 999.00 Tandy Drive Controller 89.00. Spinnaker Software 2.00 Tandy 1500HD1 Drive 64 0K 1179 .00 * Extended Basic Rom Ki t (28 pin) 14.95 Max 10 by Colorware 79 .95 Tandy 28 10HD1 Drive 1 Meg RAM 2049.00 64KRam Upgrade Ki t (2 or 8 chip) 39 .00 AutoTerm by PXE Com puting 29 .95 '.)9 .95 Tandy 1000 RLHD-1 Drive-5 12K 769.00 * Tandy Deluxe Keyboard Kit 24 .95 TW-80 by Spectrum (COCO 3) 39.95 Tandy 1100FD1 Drive 640K 689.00 HI-RES Joystick Interface 8.95 TeleWriter 64 49 .95 59.95 PRINTERS Color Computer Deluxe Mouse 44 .00 TeleWriter 128 79.95 Tandy DMP-107 120 CPS 159 00. Multi Pak Pal Chip for COCO 3 14.95 Elite Word 80 79 .95 Tandy DMP-302 270 CPS 469.00 COCO 3 Service Man ual 29 .95 Elite Cale 3.0 69.95 Tandy DMP-202 180 CPS 299 .00 Serial to Parallel Converter 59 .95 CoCo3 512KSuperRam Disk 19.95 Tandy DMP-4 42 300 CPS 539 .00 Tandy Deluxe Joystick 19 .95 Home Publishing by Tandy (Coco 3) 35 .95 Tandy LP-950 Laser Printer 1299 .00 Magnavox 8135 RGB Monitor 299 .00 Sub Battle Sim. -

Generating Solitaire Games

Generating Solitaire Games A Major Qualifying Project report: Submitted to the Faculty of WORCESTER POLYTECHNIC INSTITUTE In partial fulfillment of the requirements for the degree of Bachelor of Science March 1, 2019 Submitted by: Drew Ciccarelli Ian MacGregor Simon Redding Advisor: Professor George T. Heineman This report represents work of WPI undergraduate students submitted to the faculty as evidence of a degree requirement. WPI routinely publishes these reports on its web site without editorial or peer review. For more information about the projects program at WPI, see http://www.wpi.edu/Academics/Projects. Abstract Applied combinatory logic synthesis has the potential to greatly improve the efficiency of software development. This project is an exploration of implementing CLS in an existing software platform, and an analysis of its impacts on the development process. Table of Contents Abstract 2 I Introduction 4 II Background 5 Existing Paradigm Overview 5 Solitaire Overview 5 Generation - A new Paradigm 6 Impacts of Generation 7 Project History 7 III Design 8 Design of the Synthesizer 8 Design of the Solitaire Models 8 Abstraction for Solitaire Families 9 Java vs Scala Modeling 9 Design of Generated Code 10 IV: Development 12 Tools and IDEs 12 Development Cycle - Creating New Variations 12 Debugging and Testing 14 Compiler, Client, and Generation Overview 14 IV Results 17 Base Solitaire Games 17 Families and Variations 20 Development Time Across Game Types 24 Life as a Modeler 25 V Conclusion & Recommendations 26 References 28 Appendix A: Solitaire Creation Tutorial 29 Appendix B: Modeling Needed for Golf 42 I Introduction Software developers attempting to work with complex frameworks are faced with a steep learning curve (Fayad and Schmidt, 1997).