L'application Des Paramètres Compositionnels Au Traitement Sonore

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Karlheinz Stockhausen: Hudba a Prostor

Ústav hudební vědy Filosofická fakulta Masarykovy univerzity v Brně Martin Flašar Bakalářská práce Karlheinz Stockhausen: hudba a prostor 'i. .,-Í.JLV , J v V/L •- » -i_ *"- Vedoucí práce: Prof. PhDr. Miloš Štědroň, Csc. V Brně 8. května 2003 Potvrzuji, že tuto práci, kterou podávám jako bakalářskou práci na Ústavu hudební védy FF MU v Brně, jsem napsal v souladu se svým nejlepším svědomím s využitím vlastních skrovných duševních schopností, nezralého rozhledu v celé problematice a bez nároku na postižení celé šíře dané problematiky. Martin Flašar Obsah Obsah 1 Předmluva 2 Úvod 2 1. Hudba a prostor - teoretický kontext 3 1.1 Prostor - pokus o definici 3 1.2 Walter Gieseler - kategorie zvaná prostor 5 1.3 Gisela Nauck - zkoumání prostoru..... 7 2. Případ Stockhausen 12 2.1 Hudba a prostor 12 2.2 Nutnost prostorové hudby 15 2.3 Pět hudebních revolucí od r. 1950 17 2.4 Stručná chronologie zvukově-prostorových kompozic 18 2.5 Hudba v prostoru - dvě cesty 22 2.6 Prostor pro hudbu 24 2.7 Pole für 2 (1969-70) a Expo für 3 (1969-70) 26 2.7.1 Notace prostorového pohybu zvuku 28 2.8 Dienstag z cyklu licht - Oktophonie (1990-91) 29 2.8.1 Postup práce - prostorová distribuce zvuku 35 2.8.2 Vrstvy a jejich pohyb v prostoru 38 Závěr ." 44 Resumé 45 Seznam pramenů 46 Použitá literatura: 47 Předmluva Za vedení práce bych rád poděkoval prof. PhDr. Miloši Štědroňovi, CSc. Dále nemohu opominout inspirační zdroj pro moji práci, kterým byla velmi podnetná série přednášek Dr. Marcuse Bandura na Albert-Ludwigs-Universität Freiburg. -

The Evolution of the Performer Composer

CONTEMPORARY APPROACHES TO LIVE COMPUTER MUSIC: THE EVOLUTION OF THE PERFORMER COMPOSER BY OWEN SKIPPER VALLIS A thesis submitted to the Victoria University of Wellington in fulfillment of the requirements for the degree of Doctor of Philosophy Victoria University of Wellington 2013 Supervisory Committee Dr. Ajay Kapur (New Zealand School of Music) Supervisor Dr. Dugal McKinnon (New Zealand School of Music) Co-Supervisor © OWEN VALLIS, 2013 NEW ZEALAND SCHOOL OF MUSIC ii ABSTRACT This thesis examines contemporary approaches to live computer music, and the impact they have on the evolution of the composer performer. How do online resources and communities impact the design and creation of new musical interfaces used for live computer music? Can we use machine learning to augment and extend the expressive potential of a single live musician? How can these tools be integrated into ensembles of computer musicians? Given these tools, can we understand the computer musician within the traditional context of acoustic instrumentalists, or do we require new concepts and taxonomies? Lastly, how do audiences perceive and understand these new technologies, and what does this mean for the connection between musician and audience? The focus of the research presented in this dissertation examines the application of current computing technology towards furthering the field of live computer music. This field is diverse and rich, with individual live computer musicians developing custom instruments and unique modes of performance. This diversity leads to the development of new models of performance, and the evolution of established approaches to live instrumental music. This research was conducted in several parts. The first section examines how online communities are iteratively developing interfaces for computer music. -

A Symphonic Poem on Dante's Inferno and a Study on Karlheinz Stockhausen and His Effect on the Trumpet

Louisiana State University LSU Digital Commons LSU Doctoral Dissertations Graduate School 2008 A Symphonic Poem on Dante's Inferno and a study on Karlheinz Stockhausen and his effect on the trumpet Michael Joseph Berthelot Louisiana State University and Agricultural and Mechanical College, [email protected] Follow this and additional works at: https://digitalcommons.lsu.edu/gradschool_dissertations Part of the Music Commons Recommended Citation Berthelot, Michael Joseph, "A Symphonic Poem on Dante's Inferno and a study on Karlheinz Stockhausen and his effect on the trumpet" (2008). LSU Doctoral Dissertations. 3187. https://digitalcommons.lsu.edu/gradschool_dissertations/3187 This Dissertation is brought to you for free and open access by the Graduate School at LSU Digital Commons. It has been accepted for inclusion in LSU Doctoral Dissertations by an authorized graduate school editor of LSU Digital Commons. For more information, please [email protected]. A SYMPHONIC POEM ON DANTE’S INFERNO AND A STUDY ON KARLHEINZ STOCKHAUSEN AND HIS EFFECT ON THE TRUMPET A Dissertation Submitted to the Graduate Faculty of the Louisiana State University and Agriculture and Mechanical College in partial fulfillment of the requirements for the degree of Doctor of Philosophy in The School of Music by Michael J Berthelot B.M., Louisiana State University, 2000 M.M., Louisiana State University, 2006 December 2008 Jackie ii ACKNOWLEDGEMENTS I would like to thank Dinos Constantinides most of all, because it was his constant support that made this dissertation possible. His patience in guiding me through this entire process was remarkable. It was Dr. Constantinides that taught great things to me about composition, music, and life. -

Holmes Electronic and Experimental Music

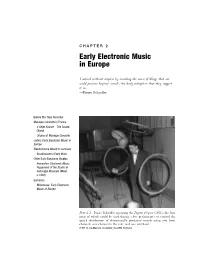

C H A P T E R 2 Early Electronic Music in Europe I noticed without surprise by recording the noise of things that one could perceive beyond sounds, the daily metaphors that they suggest to us. —Pierre Schaeffer Before the Tape Recorder Musique Concrète in France L’Objet Sonore—The Sound Object Origins of Musique Concrète Listen: Early Electronic Music in Europe Elektronische Musik in Germany Stockhausen’s Early Work Other Early European Studios Innovation: Electronic Music Equipment of the Studio di Fonologia Musicale (Milan, c.1960) Summary Milestones: Early Electronic Music of Europe Plate 2.1 Pierre Schaeffer operating the Pupitre d’espace (1951), the four rings of which could be used during a live performance to control the spatial distribution of electronically produced sounds using two front channels: one channel in the rear, and one overhead. (1951 © Ina/Maurice Lecardent, Ina GRM Archives) 42 EARLY HISTORY – PREDECESSORS AND PIONEERS A convergence of new technologies and a general cultural backlash against Old World arts and values made conditions favorable for the rise of electronic music in the years following World War II. Musical ideas that met with punishing repression and indiffer- ence prior to the war became less odious to a new generation of listeners who embraced futuristic advances of the atomic age. Prior to World War II, electronic music was anchored down by a reliance on live performance. Only a few composers—Varèse and Cage among them—anticipated the importance of the recording medium to the growth of electronic music. This chapter traces a technological transition from the turntable to the magnetic tape recorder as well as the transformation of electronic music from a medium of live performance to that of recorded media. -

Kreuzspiel, Louange À L'éternité De Jésus, and Mashups Three

Kreuzspiel, Louange à l’Éternité de Jésus, and Mashups Three Analytical Essays on Music from the Twentieth and Twenty-First Centuries Thomas Johnson A thesis submitted in partial fulfillment of the requirements for the degree of Master of Arts University of Washington 2013 Committee: Jonathan Bernard, Chair Áine Heneghan Program Authorized to Offer Degree: Music ©Copyright 2013 Thomas Johnson Johnson, Kreuzspiel, Louange, and Mashups TABLE OF CONTENTS Page Chapter 1: Stockhausen’s Kreuzspiel and its Connection to his Oeuvre ….….….….….…........1 Chapter 2: Harmonic Development and The Theme of Eternity In Messiaen’s Louange à l’Éternité de Jésus …………………………………….....37 Chapter 3: Meaning and Structure in Mashups ………………………………………………….60 Appendix I: Mashups and Constituent Songs from the Text with Links ……………………....103 Appendix II: List of Ways Charles Ives Used Existing Musical Material ….….….….……...104 Appendix III: DJ Overdub’s “Five Step” with Constituent Samples ……………………….....105 Bibliography …………………………………........……...…………….…………………….106 i Johnson, Kreuzspiel, Louange, and Mashups LIST OF EXAMPLES EXAMPLE 1.1. Phase 1 pitched instruments ……………………………………………....………5 EXAMPLE 1.2. Phase 1 tom-toms …………………………………………………………………5 EXAMPLE 1.3. Registral rotation with linked pitches in measures 14-91 ………………………...6 EXAMPLE 1.4. Tumbas part from measures 7-9, with duration values above …………………....7 EXAMPLE 1.5. Phase 1 tumba series, measures 7-85 ……………………………………………..7 EXAMPLE 1.6. The serial treatment of the tom-toms in Phase 1 …………………………........…9 EXAMPLE 1.7. Phase two pitched mode ………………………………………………....……...11 EXAMPLE 1.8. Phase two percussion mode ………………………………………………....…..11 EXAMPLE 1.9. Pitched instruments section II …………………………………………………...13 EXAMPLE 1.10. Segmental grouping in pitched instruments in section II ………………….......14 EXAMPLE 1.11. -

Strahleninduzierten Mammakarzinoms

Elke A. Nekolla EPIDEMIOLOGIE DES STRAHLENINDUZIERTEN MAMMAKARZINOMS Aus dem Strahlenbiologischen Institut der Ludwig-Maximilians-Universität München Vorstand: Prof. Dr. A. M. Kellerer EPIDEMIOLOGIE DES STRAHLENINDUZIERTEN MAMMAKARZINOMS Dissertation zum Erwerb des Doktorgrades der Humanbiologie an der Medizinischen Fakultät der Ludwig-Maximilians-Universität zu München vorgelegt von Elke Anna Nekolla München 2004 Mit Genehmigung der Medizinischen Fakultät der Universität München Berichterstatter: Prof. Dr. A. M. Kellerer Mitberichterstatter: Prof. Dr. E. Dühmke Prof. Dr. M. Keßler Dekan: Prof. Dr. Dr. h.c. K. Peter Tag der mündlichen Prüfung: 21.01.2004 Für Emma & Alexander Die meisten und schlimmsten Übel, die der Mensch dem Menschen zugefügt hat, entsprangen dem felsenfesten Glauben an die Richtigkeit falscher Überzeugungen. B. Russell Überzeugungen sind gefährlichere Feinde der Wahrheit als Lügen. F. Nietzsche INHALT 1 1. EINLEITUNG ............................................................................. 3 1.A EINFÜHRUNG IN DIE EPIDEMIOLOGIE DES MAMMAKARZINOMS ........................................ 5 1.B ZIELSETZUNG DER VORLIEGENDEN ARBEIT ...............................................................16 2. MATERIAL UND METHODEN ........................................................ 19 2.A AUFBAU DER ARBEIT..........................................................................................21 2.B ABSCHÄTZUNG STRAHLENBEDINGT ERHÖHTER KREBSRATEN ..........................................23 2.C METHODIK DER VISUALISIERUNG...........................................................................25 -

Die Studie II Von Karlheinz Stockhausen Als Tonbandkomposition Author(S): RALPH KOGELHEIDE Source: Archiv Für Musikwissenschaft, 73

Die Studie II von Karlheinz Stockhausen als Tonbandkomposition Author(s): RALPH KOGELHEIDE Source: Archiv für Musikwissenschaft, 73. Jahrg., H. 1. (2016), pp. 65-79 Published by: Franz Steiner Verlag Stable URL: https://www.jstor.org/stable/43818936 Accessed: 12-05-2020 10:49 UTC JSTOR is a not-for-profit service that helps scholars, researchers, and students discover, use, and build upon a wide range of content in a trusted digital archive. We use information technology and tools to increase productivity and facilitate new forms of scholarship. For more information about JSTOR, please contact [email protected]. Your use of the JSTOR archive indicates your acceptance of the Terms & Conditions of Use, available at https://about.jstor.org/terms Franz Steiner Verlag is collaborating with JSTOR to digitize, preserve and extend access to Archiv für Musikwissenschaft This content downloaded from 134.106.227.90 on Tue, 12 May 2020 10:49:01 UTC All use subject to https://about.jstor.org/terms H ARCHIV FÜR MUSIKWISSENSCHAFT 73, 20l6/l, 65-79 RALPH KOGELHEIDE Die Studie II von Karlheinz Stockhausen als Tonbandkomposition* The original tape of Karlheinz Stockhausens Studie II (1954) bears visible and audible traces of the compositional process. Beyond this, the materiality and functioning principles of that recording medium guide compositional decisions and even prejudice the serial organization of the musical work. For this reason, a differentiation between the written composition of Studie II and its subordinate realization proves to be problematic. All the more important is the fact that most of the published recordings of Studie II are base on an authorized, reworked version from 1983, which audibly deviates from the realization of the original tape through the use of, among other things, equalizers and reverberation. -

Utvärdering Av Metoder I Hälso- Och Sjukvården Och Insatser I Socialtjänsten

sbu:s handbok Utvärdering av metoder i hälso- och sjukvården och insatser i socialtjänsten statens beredning för medicinsk och social utvärdering Innehåll 1 Utvärdering av metoder inom vård och omsorg 7 – inledning 2 En översikt av stegen i en systematisk utvärdering 13 3 Strukturera och avgränsa översiktens frågor 19 4 Litteratursökning 25 5 Bedömning av en studies relevans 41 6 Kvalitetsgranskning av studier 45 7 Tillförlitlighet av tester och bedömningsmetoder 59 8 Värdering och syntes av studier utförda med kvalitativ 69 analysmetodik 9 Sammanvägning av resultat 107 10 Evidensgradering 127 11 Hälsoekonomiska utvärderingar 139 12 Etiska och sociala aspekter 159 Bilagor (publicerade på www.sbu.se/metodbok) Bilaga 1. Mall för bedömning av relevans Bilaga 2. Mall för kvalitetsgranskning av randomiserade studier Bilaga 3. Mall för kvalitetsgranskning av observationsstudier Bilaga 4. Mall för kvalitetsgranskning av diagnostiska studier (QUADAS) Bilaga 5. Mall för kvalitetsgranskning av studier med kvalitativ forskningsmetodik – patient- och brukarupplevelse Bilaga 6. Mall för kvalitetsgranskning av systematiska översikter enligt AMSTAR Bilaga 7. Mall för kvalitetsgranskning av empiriska hälsoekonomiska studier Bilaga 8. Mall för kvalitetsgranskning av hälsoekonomiska modellstudier Bilaga 9. Etiska aspekter på åtgärder inom hälso- och sjukvården Bilaga 10 Statistiska begrepp i medicinska utvärderingar Bilag a11 Allmänt om forskningsinsatser med kvalitativ metod Förord Detta är den tredje upplagan av SBU:s metodbok. Syftet med metodboken är att vara en vägledning för SBU:s medarbetare och sakkunniga i arbetet med att systematiskt, enhetligt och transparent ta fram SBU:s rapporter. Metodboken kan också vara ett stöd för andra som gör systematiska utvärderingar. Även för den som tar del av utvärderingsrapporter och vill förstå mer av processerna bakom, kan metodboken innehålla värdefull information. -

Une Discographie De Robert Wyatt

Une discographie de Robert Wyatt Discographie au 1er mars 2021 ARCHIVE 1 Une discographie de Robert Wyatt Ce présent document PDF est une copie au 1er mars 2021 de la rubrique « Discographie » du site dédié à Robert Wyatt disco-robertwyatt.com. Il est mis à la libre disposition de tous ceux qui souhaitent conserver une trace de ce travail sur leur propre ordinateur. Ce fichier sera périodiquement mis à jour pour tenir compte des nouvelles entrées. La rubrique « Interviews et articles » fera également l’objet d’une prochaine archive au format PDF. _________________________________________________________________ La photo de couverture est d’Alessandro Achilli et l’illustration d’Alfreda Benge. HOME INDEX POCHETTES ABECEDAIRE Les années Before | Soft Machine | Matching Mole | Solo | With Friends | Samples | Compilations | V.A. | Bootlegs | Reprises | The Wilde Flowers - Impotence (69) [H. Hopper/R. Wyatt] - Robert Wyatt - drums and - Those Words They Say (66) voice [H. Hopper] - Memories (66) [H. Hopper] - Hugh Hopper - bass guitar - Don't Try To Change Me (65) - Pye Hastings - guitar [H. Hopper + G. Flight & R. Wyatt - Brian Hopper guitar, voice, (words - second and third verses)] alto saxophone - Parchman Farm (65) [B. White] - Richard Coughlan - drums - Almost Grown (65) [C. Berry] - Graham Flight - voice - She's Gone (65) [K. Ayers] - Richard Sinclair - guitar - Slow Walkin' Talk (65) [B. Hopper] - Kevin Ayers - voice - He's Bad For You (65) [R. Wyatt] > Zoom - Dave Lawrence - voice, guitar, - It's What I Feel (A Certain Kind) (65) bass guitar [H. Hopper] - Bob Gilleson - drums - Memories (Instrumental) (66) - Mike Ratledge - piano, organ, [H. Hopper] flute. - Never Leave Me (66) [H. -

Analytical Techniques of Electroacoustic Music”

David Huff Proposal for “Analytical Techniques of Electroacoustic Music” Introduction The foundations of musical analysis have long been tested by the weight of music from the periods of tonal practice. There is a rich and expansive repertory of techniques from which the analyst may choose in approaching music composed in the tonal tradition of the Eighteenth and Nineteenth Centuries. The Twentieth Century saw an expansion of compositional strategies, which in turn charged theorists and musicologists with the tasks of developing and adopting new methods of analysis. Analysts met these challenges by employing a range of techniques nearly as varied as the post-tonal compositions themselves. Pitch-class set theory and twelve-tone serial techniques have been the most widely adopted analytical methods for the post- tonal repertory, representing rigorous, quasi-scientific approaches to what is often extremely complex music. This expansion of compositional and analytical techniques coincided with the development of technology that eventually made its way into the hands of composers. Technology’s influence on composition in the mid-Twentieth Century formed in the concurrent strands of musique concrète and elektronische Musik, one concerned with the use of recorded sound as a malleable medium, the other with generating sounds themselves through electronic means. The two approaches eventually converged, with varying degrees of cohesion, into what is generally referred to as electroacoustic music.1 1 Leigh Landy discusses various titles applied to strands of electronic-based music in Landy 2006. While the proposed dissertation will summarize these terminological aspects the present proposal will simply use the term “electroacoustic music” to mean any music composed with the full or partial use of electronic means. -

C:\Documents and Settings\Hubert Howe\My Documents\Courses

Musical works of Karlheinz Stockhausen (b. 1928) [Information taken from www.stockhausen.org.] Nr. Chöre für Doris for choir a capella, 1950 Drei Lieder for chorus and chamber orchestra, 1950 Chorale for four-part choir a capella, 1950 Sonatine for violin and piano, 1951 Kreuzspiel (“Cross-play”) for oboe, bass clarinet, piano, percussion, 1951 Formel (“Formula”) for orchestra, 1951 Etüde, musique concrète, 1952 Spiel (“Play”) for orchestra, 1952 Schlagtrio (percussion trio), for piano and 3x2 timpani, 1952 Punkte (“Points”) for orchestra, 1952 (revised, 1962) 1 Kontra-Punkte (“Counter-points”) for 10 instruments, 1952-3 2 Klavierstücke I-IV (Piano pieces I-IV), 1952-3 (Klavierstück IV revised 1961) 3/I Studie I, electronic music, 1954 3/II Studie II, electronic music, 1954 4 Klavierstücke V-X, (Piano pieces V-X), 1954-5 (Klavierstück X revised 1961) 5 Zeitmasze (“Tempi”) for woodwind quintet, 1955-6 6 Gruppen (“Groups”) for three orchestras, 1955-57 7 Klavierstück XI (Piano piece XI), 1956 8 Gesang der Jünglinge (“Song of the Youths”), electronic music, 1955-6 9 Zyklus (“Cycle”) for one percussionist, 1959 10 Carré for four orchestras and choruses, 1959-60 11 Refrain for three players, 1959 12 Kontakte (“Contacts”) for electronic sounds, 1959-60 Kontakte for electronic sounds, piano and percussion, 1959-60 Originale (“Originals”), musical theater with Kontakte, 1961 13 Momente (“Moments”) for soprano, four choral groups and 13 instruments, 1962-4 (Revised 1965, 1998) 14 Plus/Minus 2 x 7 pages for elaboration, 1963 15 Mikrophonie I (“Microphony -

Composing with Process

Research > COMPOSING WITH PROCESS: COMPOSING WITH PROCESS: PERSPECTIVES ON GENERATIVE AND PERSPECTIVES ON GENERATIVE AND SYSTEMS MUSIC SYSTEMS MUSIC #4.1 Generative music is a term used to describe music which has Time been composed using a set of rules or system. This series of six episodes explores generative approaches (including This episode looks at the relationship between time and music. It examines the algorithmic, systems-based, formalised and procedural) to impact of technological development and how time is treated within a range of composition and performance primarily in the context of musical idioms. experimental technologies and music practices of the latter part of the twentieh century and examines the use of determinacy and indeterminacy in music and how these 01. Summary relate to issues around control, automation and artistic intention. The fourth episode in this series introduces the idea of time and its relationship to musical practices. The show opens with thoughts about time drawn from Each episode in the series is accompanied by an additional philosophy, science and musicology and shows how these are expressed in programme featuring exclusive or unpublished sound pieces musical form, and looks at the origins of sonic action, musical behaviors and by leading sound artists and composers working in the field. notational systems as a way of engaging with the temporal realm. With a specific reference to the emergence of sound recording technologies – both vinyl and tape – the show examines how new technologies have impacted musical vocabularies and changed the relationship between sound, time and music. It closes with a PDF Contents: brief look at how computer based editing has extended this paradigm and opened the way for stochastic methods of sound generation.