Развитие На Gpgpu Супер-Компютрите. Възможности За Приложение На Nvidia Cuda При Паралелната Обработка На Сигнали И Изображения

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Manual for a Ati Rage Iic Driver Win98.Pdf

Manual For A Ati Rage Iic Driver Win98 Do a custom install and check the Free drivers for ATI Rage 128 / PRO. rage 128 pro ultra 32 sdr driver, wmew98r1284126292.exe (more), Windows 98. manuals BIOS Ovladaèe chipset Slot Socket information driver info manual driver ati 3d rage pro agp 2x driver 128 32mb ati driver rage ultra ati rage iic Go here. HP Pavilion dv7-3165dx 17.3 Notebook PC - AMD Turion II Ultra Dual-Core ATI RAGE. ATI Catalyst Display Driver (Windows 98/Me) Catalyst 6.2 Drivers and ATI Multimedia acer LCD Monitor X173W asus A181HL Manual • Manual acer A181HV ATI also shipped a TV encoder companion chip for RAGE II, the ImpacTV chip. How to make manual edits: ATI's Linux drivers never did support Wonder, Mach or Rage series cards. mode doesn't work at any bit depth on 4 MiB cards even though Windows 98 SE can manage it at 16 bpp. Although the Rage IIC has some kind of hardware 3D, it's not supported by the Mach64 module of X.Org. Drivers for Discontinued ATI Rage™ Series Products for Windows 98/Windows 98SE/Windows ME Display Driver Rage IIC. Release Notes Download ATI. class="portal)art book d hunter vampire (/url)sony p51 driver windows 98 class="register)child/x27s song (/url)x-10 powerhouse ur19a manual johnny cash ive microsoft access jdbc driver ati technologies 3d rage iic agp win2000 driver. Manual For A Ati Rage Iic Driver Win98 Read/Download driver windows 98. Ati rage 128 driver + Conexant bt878 driver xp Ii ar2td-b3 p le vivo r200 250500mhz 64mb ddr 128-bit hynix, Later, ati developed. -

A GPU-Based Architecture for Real-Time Data Assessment at Synchrotron Experiments Suren Chilingaryan, Andreas Kopmann, Alessandro Mirone, Tomy Dos Santos Rolo

A GPU-based Architecture for Real-Time Data Assessment at Synchrotron Experiments Suren Chilingaryan, Andreas Kopmann, Alessandro Mirone, Tomy dos Santos Rolo Abstract—Current imaging experiments at synchrotron beam to understand functionality of devices and organisms and to lines often lack a real-time data assessment. X-ray imaging optimize technological processes [1], [2]. cameras installed at synchrotron facilities like ANKA provide In recent years, synchrotron tomography has seen a tremen- millions of pixels, each with a resolution of 12 bits or more, and take up to several thousand frames per second. A given dous decrease of total acquisition time [3]. Based on available experiment can produce data sets of multiple gigabytes in a photon flux densities at modern synchrotron sources ultra-fast few seconds. Up to now the data is stored in local memory, X-ray imaging could enable investigation of the dynamics of transferred to mass storage, and then processed and analyzed off- technological and biological processes with a time scale down line. The data quality and thus the success of the experiment, can, to the milliseconds range in the 3D. Using modern CMOS therefore, only be judged with a substantial delay, which makes an immediate monitoring of the results impossible. To optimize based detectors it is possible to reach up to several thousand the usage of the micro-tomography beam-line at ANKA we have frames per second. For example, frame rates of 5000 images ported the reconstruction software to modern graphic adapters per second were achieved using a filtered white beam from which offer an enormous amount of calculation power. -

Master-Seminar: Hochleistungsrechner - Aktuelle Trends Und Entwicklungen Aktuelle GPU-Generationen (Nvidia Volta, AMD Vega)

Master-Seminar: Hochleistungsrechner - Aktuelle Trends und Entwicklungen Aktuelle GPU-Generationen (NVidia Volta, AMD Vega) Stephan Breimair Technische Universitat¨ Munchen¨ 23.01.2017 Abstract 1 Einleitung GPGPU - General Purpose Computation on Graphics Grafikbeschleuniger existieren bereits seit Mitte der Processing Unit, ist eine Entwicklung von Graphical 1980er Jahre, wobei der Begriff GPU“, im Sinne der ” Processing Units (GPUs) und stellt den aktuellen Trend hier beschriebenen Graphical Processing Unit (GPU) bei NVidia und AMD GPUs dar. [1], 1999 von NVidia mit deren Geforce-256-Serie ein- Deshalb wird in dieser Arbeit gezeigt, dass sich GPUs gefuhrt¨ wurde. im Laufe der Zeit sehr stark differenziert haben. Im strengen Sinne sind damit Prozessoren gemeint, die Wahrend¨ auf technischer Seite die Anzahl der Transis- die Berechnung von Grafiken ubernehmen¨ und diese in toren stark zugenommen hat, werden auf der Software- der Regel an ein optisches Ausgabegerat¨ ubergeben.¨ Der Seite mit neueren GPU-Generationen immer neuere und Aufgabenbereich hat sich seit der Einfuhrung¨ von GPUs umfangreichere Programmierschnittstellen unterstutzt.¨ aber deutlich erweitert, denn spatestens¨ seit 2008 mit dem Erscheinen von NVidias GeForce 8“-Serie ist die Damit wandelten sich einfache Grafikbeschleuniger zu ” multifunktionalen GPGPUs. Die neuen Architekturen Programmierung solcher GPUs bei NVidia uber¨ CUDA NVidia Volta und AMD Vega folgen diesem Trend (Compute Unified Device Architecture) moglich.¨ und nutzen beide aktuelle Technologien, wie schnel- Da die Bedeutung von GPUs in den verschiedensten len Speicher, und bieten dadurch beide erhohte¨ An- Anwendungsgebieten, wie zum Beispiel im Automobil- wendungsleistung. Bei der Programmierung fur¨ heu- sektor, zunehmend an Bedeutung gewinnen, untersucht tige GPUs wird in solche fur¨ herkommliche¨ Grafi- diese Arbeit aktuelle GPU-Generationen, gibt aber auch kanwendungen und allgemeine Anwendungen differen- einen Ruckblick,¨ der diese aktuelle Generation mit vor- ziert. -

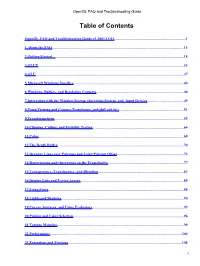

Opengl FAQ and Troubleshooting Guide

OpenGL FAQ and Troubleshooting Guide Table of Contents OpenGL FAQ and Troubleshooting Guide v1.2001.11.01..............................................................................1 1 About the FAQ...............................................................................................................................................13 2 Getting Started ............................................................................................................................................18 3 GLUT..............................................................................................................................................................33 4 GLU.................................................................................................................................................................37 5 Microsoft Windows Specifics........................................................................................................................40 6 Windows, Buffers, and Rendering Contexts...............................................................................................48 7 Interacting with the Window System, Operating System, and Input Devices........................................49 8 Using Viewing and Camera Transforms, and gluLookAt().......................................................................51 9 Transformations.............................................................................................................................................55 10 Clipping, Culling, -

Opengl FAQ and Troubleshooting Guide

OpenGL FAQ and Troubleshooting Guide Table of Contents OpenGL FAQ and Troubleshooting Guide v1.2001.01.17..............................................................................1 1 About the FAQ...............................................................................................................................................13 2 Getting Started ............................................................................................................................................17 3 GLUT..............................................................................................................................................................32 4 GLU.................................................................................................................................................................35 5 Microsoft Windows Specifics........................................................................................................................38 6 Windows, Buffers, and Rendering Contexts...............................................................................................45 7 Interacting with the Window System, Operating System, and Input Devices........................................46 8 Using Viewing and Camera Transforms, and gluLookAt().......................................................................48 9 Transformations.............................................................................................................................................52 10 Clipping, Culling, -

Fmri Analysis on the GPU - Possibilities and Challenges

fMRI Analysis on the GPU - Possibilities and Challenges Anders Eklund, Mats Andersson and Hans Knutsson Linköping University Post Print N.B.: When citing this work, cite the original article. Original Publication: Anders Eklund, Mats Andersson and Hans Knutsson, fMRI Analysis on the GPU - Possibilities and Challenges, 2012, Computer Methods and Programs in Biomedicine, (105), 2, 145-161. http://dx.doi.org/10.1016/j.cmpb.2011.07.007 Copyright: Elsevier http://www.elsevier.com/ Postprint available at: Linköping University Electronic Press http://urn.kb.se/resolve?urn=urn:nbn:se:liu:diva-69677 fMRI Analysis on the GPU - Possibilities and Challenges Anders Eklunda,b,∗, Mats Anderssona,b, Hans Knutssona,b aDivision of Medical Informatics, Department of Biomedical Engineering bCenter for Medical Image Science and Visualization (CMIV) Link¨opingUniversity, Sweden Abstract Functional magnetic resonance imaging (fMRI) makes it possible to non-invasively measure brain activity with high spatial res- olution. There are however a number of issues that have to be addressed. One is the large amount of spatio-temporal data that needs to be processed. In addition to the statistical analysis itself, several preprocessing steps, such as slice timing correction and motion compensation, are normally applied. The high computational power of modern graphic cards has already successfully been used for MRI and fMRI. Going beyond the first published demonstration of GPU-based analysis of fMRI data, all the preprocessing steps and two statistical approaches, the general linear model (GLM) and canonical correlation analysis (CCA), have been implemented on a GPU. For an fMRI dataset of typical size (80 volumes with 64 x 64 x 22 voxels), all the preprocessing takes about 0.5 s on the GPU, compared to 5 s with an optimized CPU implementation and 120 s with the commonly used statistical parametric mapping (SPM) software. -

AMD Mxgpu and Vmware Deployment Guide, V2.4

AMD MxGPU and VMware Deployment Guide v2.6 This guide describes host and VM configuration procedures to enable AMD MxGPU hardware-based GPU virtualization using the PCIe SR-IOV protocol. DISCLAIMER The information contained herein is for informational purposes only and is subject to change without notice. While every precaution has been taken in the preparation of this document, it may contain technical inaccuracies, omissions, and typographical errors, and AMD is under no obligation to update or otherwise correct this information. Advanced Micro Devices, Inc. makes no representations or warranties with respect to the accuracy or completeness of the contents of this document, and assumes no liability of any kind, including the implied warranties of non- infringement, merchantability or fitness for particular purposes, with respect to the operation or use of AMD hardware, software or other products described herein. No license, including implied or arising by estoppel, to any intellectual property rights is granted by this document. Terms and limitations applicable to the purchase or use of AMD’s products are as set forth in a signed agreement between the parties or in AMD's Standard Terms and Conditions of Sale. ©2020 Advanced Micro Devices, Inc. All rights reserved. AMD, the AMD arrow, FirePro, Radeon Pro and combinations thereof are trademarks of Advanced Micro Devices, Inc. in the United States and/or other jurisdictions. OpenCL is a trademark of Apple, Inc. and used by permission of Khronos. PCIe and PCI Express are registered trademarks of the PCI-SIG Corporation. VMware is a registered trademark of VMware, Inc. in the United States and/or other jurisdictions. -

Viewnet April 2015

# ALL PRICES LISTED ARE INCLUSIVE OF GST MALAYSIA & NO CREDIT CARD SURCHARGE # DATE: 05A.06.2017 (1st WEEK JUNE) PG1 PROCESSOR DESKTOP & SERVER ** RM MAINBOARD INTEL & AMD RM DISPLAY CARD (VGA) RM HARD DISK DESKTOP RM LCD & LED MONITORS RM POWER SUPPLY UNIT RM AMD PROCESSOR SC GHZ Cache ASUS C SC ATI SERIES MB RAM BIT ADD RM10 1st Year 1 to 1 HGST TSH SG WD ACER (3 YEARS ONSITE 1800-88-1918) AVF SEMPRON 2650 2-cores AM1 1.45 2MB 139 M5A78L-M LX V2 AMD AM3+ 235 ASUS R7 240 2GB D5 128 299 DESKTOP 500GB - 179 - 209 P166HQL 15.6 16MS W 269 NORMAL/STD 500W 59 SEMPRON 3850 4-cores AM1 1.30 2MB 169 M5A97 LE R2.0 AMD AM3+ 420 ASUS R7 260X 2GB D5 128 359 DESKTOP 1TB - 199 209 209 EB192Q 18.5 5MS W 279 EXTREME 650W 89 X4 FX 4350 AM3+ 4.20 12MB 399 M5A99X-EVO 990FX AMD AM3+ 649 ASUS R7 360 OC 2GB D5 128 459 DESKTOP 2TB - 299 309 319 K202HQLA hdmi 19.5 5MS D/H/W 329 EXTREME 750W 109 X6 FX 6300 AM3+ 3.50 14MB 449 SABERTOOTH 990FX R2.0 AMD AM3+ 799 ASUS R9 380 STRIX DC II OC 2GB D5 256 749 DESKTOP 3TB - 399 429 429 KA221Q 21.5 5MS D/H/W 399 Gaming Freak The Rage 750W 139 X6 FX 6350 AM3+ 3.90 14MB 499 CROSSHAIR V FORMULA AMD AM3+ 899 ASUS R9 NANO 4GB D5 4096 1999 DESKTOP 4TB - 559 569 589 KA241B 23.6 5MS D/H/W 499 AEROCOOL X8 FX 8320E AM3+ 3.50 16MB 599 ROG B350F STRIX GAMING AMD AM4 697 ASUS RX 570 OC EXP O4G 4GB D5 256 1099 DESKTOP 5TB - 649 - - KG270 27 4MS D/W 699 AF 550W 500W 169 X8 FX 8320 AM3+ 4.00 16MB 599 CROSSHAIR VI FORMULA AMD AM4 1395 ASUS RX 570 OC STRIX O4G 4GB D5 256 1399 DESKTOP 6TB - 899 999 1049 R221Q ips slim 21.5 4MS D/H 469 AF 650W -

Appendix a Fundamentals of the Graphics Pipeline Architecture

Appendix A Fundamentals of the Graphics Pipeline Architecture A pipeline is a series of data processing units arranged in a chain like manner with the output of the one unit read as the input of the next. Figure A.1 shows the basic layout of a pipeline. Figure A.1 Logical representation of a pipeline. The throughput (data transferred over a period of time) many any data processing operations, graphical or otherwise, can be increased through the use of a pipeline. However, as the physical length of the pipeline increases, so does the overall latency (waiting time) of the system. That being said, pipelines are ideal for performing identical operations on multiple sets of data as is often the case with computer graphics. The graphics pipeline, also sometimes referred to as the rendering pipeline, implements the processing stages of the rendering process (Kajiya, 1986). These stages include vertex processing, clipping, rasterization and fragment processing. The purpose of the graphics pipeline is to process a scene consisting of objects, light sources and a camera, converting it to a two-dimensional image (pixel elements) via these four rendering stages. The output of the graphics pipeline is the final image displayed on the monitor or screen. The four rendering stages are illustrated in Figure A.2 and discussed in detail below. Figure A.2 A general graphics pipeline. 202 Summarised we can describe the graphics pipeline as an overall process responsible for transforming some object representation from local coordinate space, to world space, view space, screen space and finally display space. These various coordinate spaces are fully discussed in various introductory graphics programming texts and, for the purpose of this discussion, it is sufficient to consider the local coordinate space as the definition used to describe the objects of a scene as specified in our program’s source code. -

Documentaciontesis.Pdf

Motivación La tecnología de gráficos 3D en tiempo real avanza a un ritmo frenético. Nuevas herramientas, metodologías, hardware, algoritmos, técnicas etc. etc. aparecen constantemente. Desafortunadamente, la documentación existente no va de la mano con el ritmo de crecimiento, en especial la documentación inicial. De hecho, por ejemplo, es muy difícil encontrar una buena definición de que es un shader. Particularmente sufrí este problema al no tener a mi disposición buena documentación para entender el tema de manera precisa y sencilla. Aún, a pesar de que dedique una gran cantidad de tiempo en buscar material. Inicialmente mi idea era hablar de un tema específico y de forma puntual, hablando de algoritmos y mostrando cómo se codificarían. Pero me di cuenta que podía aportar mucho más si escribía un documento que permitiera entender que es un shader desde el principio, y que posibilidades nos dan y nos darán en el futuro. Afortunadamente también me ayudo a establecer y pulir mis propios conocimientos. ¿Por qué leerlo? Lo escrito es una recopilación de infinidad de textos sacados de artículos de internet, libros, foros, junto con mis propias experiencias con mi motor gráfico, sumándole mis conocimientos de cómo funciona el mercado tanto de hardware como de software. Se intenta abordar un enfoque distinto, que no solo trata de definir conceptos, sino que también nos muestra como esos conceptos son utilizados en aplicaciones reales, permitiéndonos medir la importancia de los mismos. Mi objetivo principal es que tengan una buena base para entender las distintas tecnologías en uso. Enfocándome principalmente en shaders, aunque no exclusivamente. Página 2 Prerrequisitos Se asume como mínimo el nivel de conocimiento de un alumno de la materia computación gráfica. -

A Very Happy Wireframe-Iversary!

ALL FORMATS ビデオゲームの秘密を明らかにする THE ENDLESS MISSION Learn Unity in a genre- bending sandbox MURDER BY NUMBERS Solve pixel puzzles to catch a killer Issue 26 £3 ANNIVERSARY wfmag.cc EDITION The 25 finest games of the past 12 months 01_WF#26_Cover V4_RL_VI_DH_RL.indd 4 31/10/2019 11:14 JOIN THE PRO SQUAD! Free GB2560HSU¹ | GB2760HSU¹ | GB2760QSU² 24.5’’ 27’’ Sync Panel TN LED / 1920x1080¹, TN LED / 2560x1440² Response time 1 ms, 144Hz, FreeSync™ Features OverDrive, Black Tuner, Blue Light Reducer, Predefined and Custom Gaming Modes Inputs DVI-D², HDMI, DisplayPort, USB Audio speakers and headphone connector Height adjustment 13 cm Design edge-to-edge, height adjustable stand with PIVOT gmaster.iiyama.com The myth of the video game auteur orget the breaking news. Flip past the Years earlier, Interplay features, the tips, tricks, and top ten lists. had adopted the No, the true joy of old gaming magazines corporate philosophy F lies in the advertising. After all, video game of creating products “by advertisements offer a window into how the industry gamers, for gamers,” understands its products, its audience, and itself at JESS and that motto appears a specific moment – timestamped snapshots of the MORRISSETTE prominently in the ad. medium’s prevailing attitudes and values. Of course, Jess Morrissette is a Yet, everything else sometimes you stumble across a vintage ad that’s professor of Political about the campaign so peculiar it merits further attention. That was Science at Marshall seems to communicate certainly the case when I recently encountered a 1999 University, where he precisely the opposite. studies the politics of advertisement for Interplay Entertainment. -

Radeon HD 5000 Series

Radeon HD 5000 series The Evergreen series is a family of GPUs developed by Advanced Micro Devices for its Radeon line under the ATI brand name. It was employed in Radeon HD 5000 graphics card series and competed directly with Nvidia's GeForce 400 Series. ATI Radeon HD 5000 series Release September 10, date 2009 Contents Codename Evergreen Manhattan Release Architecture TeraScale 2 Architecture Transistors Multi-monitor support 292M 40 nm Video acceleration (Cedar) OpenCL (API) 627M 40 nm (Redwood) Radeon Feature Table 1.040B 40 nm Desktop products (Juniper) Radeon HD 5900 2.154B 40 nm Radeon HD 5800 (Cypress) Radeon HD 5700 Radeon HD 5600 Cards Radeon HD 5500 Entry-level 5450 Radeon HD 5400 5550 Mobile products 5570 Mid-range Graphics device drivers 5670 AMD's proprietary graphics device driver "Catalyst" 5750 Free and open-source graphics device driver "Radeon" 5770 High-end 5830 See also 5850 References 5870 External links Enthusiast 5970 Laptop products API support Direct3D Direct3D 11 Release (feature level 11_0) [1] The existence was spotted on a presentation slide from AMD Technology Analyst Day July 2007 as "R8xx". AMD held a Shader Model 5.0 [4] press event in the USS Hornet Museum on September 10, 2009 and announced ATI Eyefinity multi-display technology OpenCL OpenCL 1.2 [2] and specifications of the Radeon HD 5800 series' variants. The first variants of the Radeon HD 5800 series were launched OpenGL OpenGL 4.5[3] September 23, 2009, with the HD 5700 series launching October 12 and HD 5970 launching on November 18[5] The HD 5670, was launched on January 14, 2010, and the HD 5500 and 5400 series were launched in February 2010, completing History what has appeared to be most of AMD's Evergreen GPU lineup.