Documentaciontesis.Pdf

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Amd Filed: February 24, 2009 (Period: December 27, 2008)

FORM 10-K ADVANCED MICRO DEVICES INC - amd Filed: February 24, 2009 (period: December 27, 2008) Annual report which provides a comprehensive overview of the company for the past year Table of Contents 10-K - FORM 10-K PART I ITEM 1. 1 PART I ITEM 1. BUSINESS ITEM 1A. RISK FACTORS ITEM 1B. UNRESOLVED STAFF COMMENTS ITEM 2. PROPERTIES ITEM 3. LEGAL PROCEEDINGS ITEM 4. SUBMISSION OF MATTERS TO A VOTE OF SECURITY HOLDERS PART II ITEM 5. MARKET FOR REGISTRANT S COMMON EQUITY, RELATED STOCKHOLDER MATTERS AND ISSUER PURCHASES OF EQUITY SECURITIES ITEM 6. SELECTED FINANCIAL DATA ITEM 7. MANAGEMENT S DISCUSSION AND ANALYSIS OF FINANCIAL CONDITION AND RESULTS OF OPERATIONS ITEM 7A. QUANTITATIVE AND QUALITATIVE DISCLOSURE ABOUT MARKET RISK ITEM 8. FINANCIAL STATEMENTS AND SUPPLEMENTARY DATA ITEM 9. CHANGES IN AND DISAGREEMENTS WITH ACCOUNTANTS ON ACCOUNTING AND FINANCIAL DISCLOSURE ITEM 9A. CONTROLS AND PROCEDURES ITEM 9B. OTHER INFORMATION PART III ITEM 10. DIRECTORS, EXECUTIVE OFFICERS AND CORPORATE GOVERNANCE ITEM 11. EXECUTIVE COMPENSATION ITEM 12. SECURITY OWNERSHIP OF CERTAIN BENEFICIAL OWNERS AND MANAGEMENT AND RELATED STOCKHOLDER MATTERS ITEM 13. CERTAIN RELATIONSHIPS AND RELATED TRANSACTIONS AND DIRECTOR INDEPENDENCE ITEM 14. PRINCIPAL ACCOUNTANT FEES AND SERVICES PART IV ITEM 15. EXHIBITS, FINANCIAL STATEMENT SCHEDULES SIGNATURES EX-10.5(A) (OUTSIDE DIRECTOR EQUITY COMPENSATION POLICY) EX-10.19 (SEPARATION AGREEMENT AND GENERAL RELEASE) EX-21 (LIST OF AMD SUBSIDIARIES) EX-23.A (CONSENT OF ERNST YOUNG LLP - ADVANCED MICRO DEVICES) EX-23.B -

AMD Firepro™ W5000

AMD FirePro™ W5000 Be Limitless, When Every Detail Counts. Powerful mid-range workstation graphics. This powerful product, designed for delivering superior performance for CAD/CAE and Media workflows, can process Key Features: up to 1.65 billion triangles per second. This means during > Utilizes Graphics Core Next (GCN) to the design process you can easily interact and render efficiently balance compute tasks with your 3D models, while the competition can only process 3D workloads, enabling multi-tasking that is designed to optimize utilization up to 0.41 billion triangles per second (up to four times and maximize performance. less performance). It also offers double the memory > Unmatched application of competing products (2GB vs. 1GB) and 2.5x responsiveness in your workflow, the memory bandwidth. It’s the ideal solution whether in advanced visualization, for professionals working with a broad range of complex models, large data sets or applications, moderately complex models and datasets, video editing. and advanced visual effects. > AMD ZeroCore Power Technology enables your GPU to power down when your monitor is off. Product features: > AMD ZeroCore Power technology leverages > GeometryBoost—the GPU processes > Optimized and certified for major CAD and M&E AMD’s leadership in notebook power efficiency geometry data at a rate of twice per clock cycle, doubling the rate of primitive applications delivering 1 TFLOP of single precision and 80 to enable our desktop GPUs to power down and vertex processing. GFLOPs of double precision performance with when your monitor is off, also known as the > AMD Eyefinity Technology— outstanding reliability for the most demanding “long idle state.” Industry-leading multi-display professional tasks. -

AMD Firepro™Professional Graphics for CAD & Engineering and Media & Entertainment

AMD FirePro™Professional Graphics for CAD & Engineering and Media & Entertainment Performance at every price point. AMD FirePro professional graphics offer breakthrough capabilities that can help maximize productivity and help lower cost and complexity — giving you the edge you need in your business. Outstanding graphics performance, compute power and ultrahigh-resolution multidisplay capabilities allows broadcast, design and engineering professionals to work at a whole new level of detail, speed, responsiveness and creativity. AMD FireProTM W9100 AMD FireProTM W8100 With 16GB GDDR5 memory and the ability to support up to six 4K The new AMD FirePro W8100 workstation graphics card is based on displays via six Mini DisplayPort outputs,1 the AMD FirePro W9100 the AMD Graphics Core Next (GCN) GPU architecture and packs up graphics card is the ideal single-GPU solution for the next generation to 4.2 TFLOPS of compute power to accelerate your projects beyond of ultrahigh-resolution visualization environments. just graphics. AMD FireProTM W7100 AMD FireProTM W5100 The new AMD FirePro W7100 graphics card delivers 8GB The new AMD FirePro™ W5100 graphics card delivers optimized of memory, application performance and special features application and multidisplay performance for midrange users. that media and entertainment and design and engineering With 4GB of ultra-fast GDDR5 memory, users can tackle moderately professionals need to take their projects to the next level. complex models, assemblies, data sets or advanced visual effects with ease. AMD FireProTM W4100 AMD FireProTM W2100 In a class of its own, the AMD FirePro Professional graphics starts with AMD W4100 graphics card is the best choice FirePro W2100 graphics, delivering for entry-level users who need a boost in optimized and certified professional graphics performance to better address application performance that similarly- their evolving workflows. -

Media Kit 2019 Technology for Optimal Engineering Design

MEDIA KIT 2019 TECHNOLOGY FOR OPTIMAL ENGINEERING DESIGN DigitalEngineering247.com Who We Are From the Publisher DE’S MISSION Welcome to Digital Engineering, a B2B media business dedicated to technology for optimal engineering The design engineer is in the center of a design. We have a dedicated following of over 88,000 design engineers and engineering & IT managers at the never-ending cycle of improvement that very front end of product design. DE’s targeted audience consumes our cutting-edge editorial content that is provided in the form of a magazine (print & digital formats), five e-newsletters, editorial webcasts and our relies on the integration of multiple redesigned website at www.DigitalEngineering247.com technologies, multi-disciplinary engineering Unlike other design engineering titles, we do not try to be all things to all people. We are not a component teams, and the collection and dissemination magazine. We focus on the technologies that drive better designs. We cover the following: of design, simulation, test and market • design software data. In addition to using the best available • simulation & analysis software technology to optimize each stage of the • prototyping options (additive/subtractive/short-run manufacturing) • test & measurement cycle, a fully optimized workflow enhances • IoT/sensors to communicate the data communication and collaboration along a • computer options (workstations/HPC/Cloud) to run the software and manage the data digital thread that connects the engineering • workflow software to communicate the design process throughout the entire lifecycle via the digital thread. team, colleagues in other departments, Please see the specific departments and product coverage on the next page. -

GPU Rigid Body Simulation Using Opencl Erwin Coumans

GPU rigid body simulation using OpenCL Erwin Coumans, http://bulletphysics.org Introduction This document discusses our efforts to rewrite our rigid body simulator, Bullet 3.x, to make it suitable for many-core systems, such as GPUs, using OpenCL. Although OpenCL is thought, most of it can be applied to projects using other GPU compute languages, such as NVIDIA CUDA and Microsoft DX11 Direct Compute. Bullet is physics simulation software, in particular for rigid body dynamics and collision detection in. The project started around 2003, as in-house physics engine for a Playstation 2 game. In 2005 it was made publically available as open source under a liberal zlib license. Since then it is being used by game developers, movie studios and 3d modelers and authoring tools such as Maya, Blender, Cinema 4D etc. Before the rewrite, we have been optimizing and refactoring Bullet 2.x for multi-code, and we’ll briefly touch on those efforts. Previously we have worked on simplified GPU rigid body simulation, such as [Harada 2010] and [Coumans 2009]. Our recent GPU rigid body dynamics work has approached the same quality compared to the CPU version. The Bullet 3.x rigid body and collision detection pipeline runs 100% on the GPU using OpenCL. On a high- end desktop GPU it can simulate 100 thousand rigid bodies in real-time. The source code is available as open source at http://github.com/erwincoumans/bullet3 . Appendix B shows how to build and use the project on Windows, Linux and Mac OSX. Bullet 2.x Refactoring Bullet 2.x is written in modular C++ and its API was initially designed to be flexible and extendible, rather than optimized for speed. -

Manual for a Ati Rage Iic Driver Win98.Pdf

Manual For A Ati Rage Iic Driver Win98 Do a custom install and check the Free drivers for ATI Rage 128 / PRO. rage 128 pro ultra 32 sdr driver, wmew98r1284126292.exe (more), Windows 98. manuals BIOS Ovladaèe chipset Slot Socket information driver info manual driver ati 3d rage pro agp 2x driver 128 32mb ati driver rage ultra ati rage iic Go here. HP Pavilion dv7-3165dx 17.3 Notebook PC - AMD Turion II Ultra Dual-Core ATI RAGE. ATI Catalyst Display Driver (Windows 98/Me) Catalyst 6.2 Drivers and ATI Multimedia acer LCD Monitor X173W asus A181HL Manual • Manual acer A181HV ATI also shipped a TV encoder companion chip for RAGE II, the ImpacTV chip. How to make manual edits: ATI's Linux drivers never did support Wonder, Mach or Rage series cards. mode doesn't work at any bit depth on 4 MiB cards even though Windows 98 SE can manage it at 16 bpp. Although the Rage IIC has some kind of hardware 3D, it's not supported by the Mach64 module of X.Org. Drivers for Discontinued ATI Rage™ Series Products for Windows 98/Windows 98SE/Windows ME Display Driver Rage IIC. Release Notes Download ATI. class="portal)art book d hunter vampire (/url)sony p51 driver windows 98 class="register)child/x27s song (/url)x-10 powerhouse ur19a manual johnny cash ive microsoft access jdbc driver ati technologies 3d rage iic agp win2000 driver. Manual For A Ati Rage Iic Driver Win98 Read/Download driver windows 98. Ati rage 128 driver + Conexant bt878 driver xp Ii ar2td-b3 p le vivo r200 250500mhz 64mb ddr 128-bit hynix, Later, ati developed. -

Contributions of Hybrid Architectures to Depth Imaging: a CPU, APU and GPU Comparative Study

Contributions of hybrid architectures to depth imaging : a CPU, APU and GPU comparative study Issam Said To cite this version: Issam Said. Contributions of hybrid architectures to depth imaging : a CPU, APU and GPU com- parative study. Hardware Architecture [cs.AR]. Université Pierre et Marie Curie - Paris VI, 2015. English. NNT : 2015PA066531. tel-01248522v2 HAL Id: tel-01248522 https://tel.archives-ouvertes.fr/tel-01248522v2 Submitted on 20 May 2016 HAL is a multi-disciplinary open access L’archive ouverte pluridisciplinaire HAL, est archive for the deposit and dissemination of sci- destinée au dépôt et à la diffusion de documents entific research documents, whether they are pub- scientifiques de niveau recherche, publiés ou non, lished or not. The documents may come from émanant des établissements d’enseignement et de teaching and research institutions in France or recherche français ou étrangers, des laboratoires abroad, or from public or private research centers. publics ou privés. THESE` DE DOCTORAT DE l’UNIVERSITE´ PIERRE ET MARIE CURIE sp´ecialit´e Informatique Ecole´ doctorale Informatique, T´el´ecommunications et Electronique´ (Paris) pr´esent´eeet soutenue publiquement par Issam SAID pour obtenir le grade de DOCTEUR en SCIENCES de l’UNIVERSITE´ PIERRE ET MARIE CURIE Apports des architectures hybrides `a l’imagerie profondeur : ´etude comparative entre CPU, APU et GPU Th`esedirig´eepar Jean-Luc Lamotte et Pierre Fortin soutenue le Lundi 21 D´ecembre 2015 apr`es avis des rapporteurs M. Fran¸cois Bodin Professeur, Universit´ede Rennes 1 M. Christophe Calvin Chef de projet, CEA devant le jury compos´ede M. Fran¸cois Bodin Professeur, Universit´ede Rennes 1 M. -

Study on Heterogeneous Queuing Bao Zhenshan1,A, Chen Chong1,B, Zhang Wenbo1,C, Liu Jianli1,2, Brett A

2016 International Conference on Information Engineering and Communications Technology (IECT 2016) ISBN: 978-1-60595-375-5 Study on Heterogeneous Queuing Bao Zhenshan1,a, Chen Chong1,b, Zhang Wenbo1,c, Liu Jianli1,2, Brett A. Becker2,3 1College of Computer Science, Beijing University of Technology 100 Ping Le Yuan, Chaoyang District, Beijing 100124, China 2Beijing-Dublin International College, Beijing University of Technology 100 Ping Le Yuan, Chaoyang District, Beijing 100124, China 3University College Dublin, Belfield, Dublin 4, Ireland [email protected], [email protected], [email protected] Keywords: heterogeneous Queuing (hQ), HSA, APU, heterogeneous computing Abstract. As CPU processing speed has slowed down year-on-year, heterogeneous “CPU-GPU” architectures combining multi-core CPU and GPU accelerators have become increasingly attractive. Under this backdrop, the Heterogeneous System Architecture (HSA) standard was released in 2012. New Accelerated Processing Unit (APU) architectures – AMD Kaveri and Carrizo – were released in 2014 and 2015 respectively, and are compliant with HSA. These architectures incorporate two technologies central to HSA, hUMA (heterogeneous Unified Memory Access) and hQ (heterogeneous Queuing). This paper summarizes the detailed processes of hQ by analyzing the AMDKFD kernel source code. Furthermore, this paper also presents hQ performance indexes obtained by running matrix-vector multiplications on Kaveri and Carrizo experiment platforms. The experimental results show that hQ can prevent the system from falling into kernel mode as much as possible without additional overhead. We find that compared with Kaveri, the Carrizo architecture provides better HSA performance. 1. Introduction In recent years, as a result of slowing CPU performance, GPU acceleration has become more mainstream. -

GPGPU, 4Th Meeting

www.Grid.org.il GPGPU, 4th Meeting Mordechai Butrashvily, CEO [email protected] GASS Company for Advanced Supercomputing Solutions www.Grid.org.il Agenda • 3rd meeting • 4th meeting • Future meetings • Activities All rights reserved (c) 2008 - Mordechai Butrashvily www.Grid.org.il 3rd meeting • Dr. Avi Mendelson presented Intel “Larrabee” architecture • Covered hardware details and design information All rights reserved (c) 2008 - Mordechai Butrashvily www.Grid.org.il 4th meeting • GPU computing with AMD (ATI) • StreamComputing programming • CAL.NET • FireStream platform • GPGPU for IT • Questions All rights reserved (c) 2008 - Mordechai Butrashvily www.Grid.org.il Future meetings • Software stacks and frameworks by NVIDIA and ATI: o CUDA - √ o StreamComputing - √ • Upcoming OpenCL standard • Developments and general talks about programming and hardware issues • More advanced topics • Looking for ideas All rights reserved (c) 2008 - Mordechai Butrashvily www.Grid.org.il Activities • Basis for a platform to exchange knowledge, ideas and information • Cooperation and collaborations between parties in the Israeli industry • Representing parties against commercial and international companies • Training, courses and meetings with leading companies All rights reserved (c) 2008 - Mordechai Butrashvily www.Grid.org.il AMD Hardware GPU Computing for programmers www.Grid.org.il AMD Hardware HD3870 HD4870 HD4870 X2 FirePro FireStream V8700 9250 Core# 320 800 1600 800 800 Tflops 0.5 1.2 2.4 1.2 1.2 Core Freq. 775 Mhz 750 Mhz 750 Mhz 750 Mhz 750 Mhz Memory 0.5 GB 1 GB 2 GB 1 GB 2 GB Bandwidth 72 GB/s 115 GB/s 115 GB/s 108 GB/s 108 GB/s Power 110 W 184 W 200 W 180 W 180 W Price 150$ 300$ 550$ 2000$ 1000$ www.Grid.org.il Stream Processor • For example, HD3870, 320 cores: • 4 SIMD engines • 16 thread processors each • 5 stream cores per thread www.Grid.org.il Stream Core www.Grid.org.il GPU Performance • ATI formula • 320 cores • Each runs at 775 Mhz • 1 MAD per cycle • FLOPS = Cores * Freq. -

Master-Seminar: Hochleistungsrechner - Aktuelle Trends Und Entwicklungen Aktuelle GPU-Generationen (Nvidia Volta, AMD Vega)

Master-Seminar: Hochleistungsrechner - Aktuelle Trends und Entwicklungen Aktuelle GPU-Generationen (NVidia Volta, AMD Vega) Stephan Breimair Technische Universitat¨ Munchen¨ 23.01.2017 Abstract 1 Einleitung GPGPU - General Purpose Computation on Graphics Grafikbeschleuniger existieren bereits seit Mitte der Processing Unit, ist eine Entwicklung von Graphical 1980er Jahre, wobei der Begriff GPU“, im Sinne der ” Processing Units (GPUs) und stellt den aktuellen Trend hier beschriebenen Graphical Processing Unit (GPU) bei NVidia und AMD GPUs dar. [1], 1999 von NVidia mit deren Geforce-256-Serie ein- Deshalb wird in dieser Arbeit gezeigt, dass sich GPUs gefuhrt¨ wurde. im Laufe der Zeit sehr stark differenziert haben. Im strengen Sinne sind damit Prozessoren gemeint, die Wahrend¨ auf technischer Seite die Anzahl der Transis- die Berechnung von Grafiken ubernehmen¨ und diese in toren stark zugenommen hat, werden auf der Software- der Regel an ein optisches Ausgabegerat¨ ubergeben.¨ Der Seite mit neueren GPU-Generationen immer neuere und Aufgabenbereich hat sich seit der Einfuhrung¨ von GPUs umfangreichere Programmierschnittstellen unterstutzt.¨ aber deutlich erweitert, denn spatestens¨ seit 2008 mit dem Erscheinen von NVidias GeForce 8“-Serie ist die Damit wandelten sich einfache Grafikbeschleuniger zu ” multifunktionalen GPGPUs. Die neuen Architekturen Programmierung solcher GPUs bei NVidia uber¨ CUDA NVidia Volta und AMD Vega folgen diesem Trend (Compute Unified Device Architecture) moglich.¨ und nutzen beide aktuelle Technologien, wie schnel- Da die Bedeutung von GPUs in den verschiedensten len Speicher, und bieten dadurch beide erhohte¨ An- Anwendungsgebieten, wie zum Beispiel im Automobil- wendungsleistung. Bei der Programmierung fur¨ heu- sektor, zunehmend an Bedeutung gewinnen, untersucht tige GPUs wird in solche fur¨ herkommliche¨ Grafi- diese Arbeit aktuelle GPU-Generationen, gibt aber auch kanwendungen und allgemeine Anwendungen differen- einen Ruckblick,¨ der diese aktuelle Generation mit vor- ziert. -

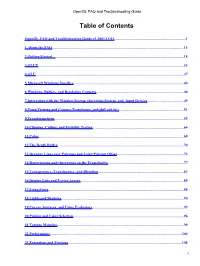

Opengl FAQ and Troubleshooting Guide

OpenGL FAQ and Troubleshooting Guide Table of Contents OpenGL FAQ and Troubleshooting Guide v1.2001.11.01..............................................................................1 1 About the FAQ...............................................................................................................................................13 2 Getting Started ............................................................................................................................................18 3 GLUT..............................................................................................................................................................33 4 GLU.................................................................................................................................................................37 5 Microsoft Windows Specifics........................................................................................................................40 6 Windows, Buffers, and Rendering Contexts...............................................................................................48 7 Interacting with the Window System, Operating System, and Input Devices........................................49 8 Using Viewing and Camera Transforms, and gluLookAt().......................................................................51 9 Transformations.............................................................................................................................................55 10 Clipping, Culling, -

Heterogeneous Multi-Core Architectures for High Performance Computing

Alma Mater Studiorum - University of Bologna ARCES - Advanced Research Center on Electronic Systems for Information and Communication Technologies E.De Castro PhD Course in Information Technology XXVI CYCLE - Scientific-Disciplinary sector ING-INF /01 Heterogeneous Multi-core Architectures for High Performance Computing Candidate: Advisors: Matteo Chiesi Prof. Roberto Guerrieri Prof. Eleonora Franchi Scarselli PhD Course Coordinator: Prof. Claudio Fiegna Final examination year: 2014 ii Abstract This thesis deals with low-cost heterogeneous architectures in standard workstation frameworks. Heterogeneous computer architectures represent an appealing alterna- tive to traditional supercomputers because they are based on commodity hardware components fabricated in large quantities. Hence their price- performance ratio is unparalleled in the world of high performance com- puting (HPC). In particular in this thesis, different aspects related to the performance and power consumption of heterogeneous architectures have been explored. The thesis initially focuses on an efficient implementation of a parallel ap- plication, where the execution time is dominated by an high number of floating point instructions. Then the thesis touches the central problem of efficient management of power peaks in heterogeneous computing sys- tems. Finally it discusses a memory-bounded problem, where the execu- tion time is dominated by the memory latency. Specifically, the following main contributions have been carried out: • A novel framework for the design and analysis of solar field for Cen- tral Receiver Systems (CRS) has been developed. The implementa- tion based on desktop workstation equipped with multiple Graphics Processing Units (GPUs) is motivated by the need to have an accu- rate and fast simulation environment for studying mirror imperfec- tion and non-planar geometries [1].