Carlos Enrique Hernández Simões

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

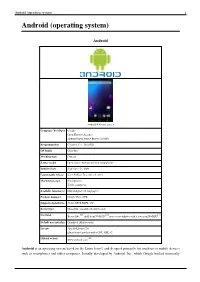

Android (Operating System) 1 Android (Operating System)

Android (operating system) 1 Android (operating system) Android Android 4.4 home screen Company / developer Google Open Handset Alliance Android Open Source Project (AOSP) Programmed in C (core), C++, Java (UI) OS family Unix-like Working state Current Source model Open source with proprietary components Initial release September 23, 2008 Latest stable release 4.4.2 KitKat / December 9, 2013 Marketing target Smartphones Tablet computers Available language(s) Multi-lingual (46 languages) Package manager Google Play, APK Supported platforms 32-bit ARM, MIPS, x86 Kernel type Monolithic (modified Linux kernel) [1] [2] [3] Userland Bionic libc, shell from NetBSD, native core utilities with a few from NetBSD Default user interface Graphical (Multi-touch) License Apache License 2.0 Linux kernel patches under GNU GPL v2 [4] Official website www.android.com Android is an operating system based on the Linux kernel, and designed primarily for touchscreen mobile devices such as smartphones and tablet computers. Initially developed by Android, Inc., which Google backed financially Android (operating system) 2 and later bought in 2005, Android was unveiled in 2007 along with the founding of the Open Handset Alliance: a consortium of hardware, software, and telecommunication companies devoted to advancing open standards for mobile devices. The first publicly available smartphone running Android, the HTC Dream, was released on October 22, 2008. The user interface of Android is based on direct manipulation, using touch inputs that loosely correspond to real-world actions, like swiping, tapping, pinching and reverse pinching to manipulate on-screen objects. Internal hardware such as accelerometers, gyroscopes and proximity sensors are used by some applications to respond to additional user actions, for example adjusting the screen from portrait to landscape depending on how the device is oriented. -

Review Scan This Code for More Info

Review Scan this code for more info. To download a barcode app, SMS <f2k> to 56677 from a mobile phone with Internet access and camera. Mobile Office suites Kingston office A free android app to view and edit Word, Excel and PowerPoint files. You can save files over cloud, send files or text as an email attachment besides exporting to PDF. You can also create .txt file, do word count, sort content and view files on full screen mode. It also allows you save files in all possible document type such as .doc, .docx, .txt, .xls, .xlsx, ppt and .pptx. It works well in both portrait and landscape modes. It has auto-spell correct but lacks cut-paste option. Bottom-line: The freely available Office suite is worth Price: Free using as a word processor and for spread sheets, but Specifications: Create and edit any type of document, freely available, word count, cloud accessibility. not recommended for making presentations. Pros: auto-spell correct, free, supports multiple formats, Cons: none Write to: [email protected] for more info. iWork A complete office suite for creating and editing documents on your iPad. It is a combination of three separate apps: Pages, Numbers and Keynote, each of them including every possible advanced feature. It is the only application that automatically saves your changes. Also, you can export files as PDF, send as email, access files from iDesk, WebDAV etc and print your documents through wireless printers. The iWork works best in portrait mode but shrinks in landscape mode and also it does not offers you access from cloud storage such as Google Docs, Box.net etc. -

0X0a I Don't Know Gregor Weichbrodt FROHMANN

0x0a I Don’t Know Gregor Weichbrodt FROHMANN I Don’t Know Gregor Weichbrodt 0x0a Contents I Don’t Know .................................................................4 About This Book .......................................................353 Imprint ........................................................................354 I Don’t Know I’m not well-versed in Literature. Sensibility – what is that? What in God’s name is An Afterword? I haven’t the faintest idea. And concerning Book design, I am fully ignorant. What is ‘A Slipcase’ supposed to mean again, and what the heck is Boriswood? The Canons of page construction – I don’t know what that is. I haven’t got a clue. How am I supposed to make sense of Traditional Chinese bookbinding, and what the hell is an Initial? Containers are a mystery to me. And what about A Post box, and what on earth is The Hollow Nickel Case? An Ammunition box – dunno. Couldn’t tell you. I’m not well-versed in Postal systems. And I don’t know what Bulk mail is or what is supposed to be special about A Catcher pouch. I don’t know what people mean by ‘Bags’. What’s the deal with The Arhuaca mochila, and what is the mystery about A Bin bag? Am I supposed to be familiar with A Carpet bag? How should I know? Cradleboard? Come again? Never heard of it. I have no idea. A Changing bag – never heard of it. I’ve never heard of Carriages. A Dogcart – what does that mean? A Ralli car? Doesn’t ring a bell. I have absolutely no idea. And what the hell is Tandem, and what is the deal with the Mail coach? 4 I don’t know the first thing about Postal system of the United Kingdom. -

Manuel De Référence

APPAREIL PHOTO NUMÉRIQUE Manuel de référence Fr Prolongation de l'autonomie de l'accumulateur Mode veille • Ce mode d'économie d'énergie réduit considérablement la consommation de l'accumulateur et permet de réactiver rapidement l'appareil photo. Appuyez sur le commutateur marche-arrêt pour passer en mode veille. Appuyez à nouveau sur le commutateur marche-arrêt pour quitter immédiatement le mode veille et reprendre la prise de vue ou la visualisation. Quand l'appareil photo est en veille, il se met hors tension au terme de la durée de la minuterie d'arrêt. La mise hors tension entraîne la perte des données non enregistrées. Enregistrez avant de continuer. Veille Ne plus afficher ce message. Annuler Mode veille • Après un certain temps en mode veille (le réglage par défaut est 1 heure), l'appareil photo se met hors tension (A75 ; Minuterie d'arrêt). Toutes les données non enregistrées sont perdues en cas de mise hors tension de l'appareil photo après le délai défini. Enregistrez les données que vous souhaitez conserver avant que l'appareil photo passe en mode veille. Mise hors tension Maintenez le commutateur marche-arrêt enfoncé pour mettre l'appareil photo hors tension (extinction forcée). La consommation d'énergie est pratiquement nulle. Lorsque vous mettez l'appareil photo sous tension, vous ne pouvez prendre que quelques photos et ne pouvez pas modifier les réglages aussi longtemps qu'Android™ OS n'a pas complètement démarré. Avant de mettre l'appareil photo hors tension, enregistrez les données que vous souhaitez conserver, de la même manière que lors du passage en mode veille. -

FOR IMMEDIATE RELEASE Press Contacts: MWW Group Geoff Coalter E: [email protected] Matt Kopacz E: [email protected] P: 201.507.9500 Press.Nikonusa.Com

FOR IMMEDIATE RELEASE Press Contacts: MWW Group Geoff Coalter E: [email protected] Matt Kopacz E: [email protected] P: 201.507.9500 press.nikonusa.com GREAT IMAGES ARE NOW TRENDING: WITH WI-FI® CONNECTIVITY AND A POWERFUL ANDROID™ PLATFORM, THE NEW NIKON COOLPIX S800c IS THE EASY WAY TO INSTANTLY CAPTURE, CREATE AND SHARE The New COOLPIX S800c Enhances the User’s Connected Life, Letting Them Instantly Share Great Images From a Device That Includes Features Only a Camera Can Provide with the Ease and Versatility of a Smartphone or Tablet MELVILLE, N.Y. (August 22, 2012) – Today, Nikon Inc. announced the innovative COOLPIX S800c, Nikon’s first Wi-Fi compact digital camera to incorporate Nikon’s powerful camera imaging technologies and the boundless capabilities of an Android Operating System (OS). Designed for the always connected individual, the S800c delivers the high picture quality and superior performance expected from a Nikon camera coupled with communication functions and app-based versatility of a smartphone or tablet. The new S800c answers the call for users who need the ability to capture photos and HD video with amazing clarity and color, yet offers a familiar portal to connect to social networks and popular imaging applications through an Android Operating System. With the introduction of the S800c, beautiful images can now be confidently and quickly shared with friends and family. “With the new COOLPIX S800c, Nikon designed a camera for users looking to capture stunning images and videos with a compact digital camera but also want to share their content with their friends and family in a familiar way,” said Bo Kajiwara, Vice President of Marketing, Planning and Customer Experience, Nikon Inc. -

Dateline Volume 49-5

November 26, 2012 Volume 49 Issue 5 ateline owntown Student Run Since Volume One D Our Campus and the Plastic Consumption Obsession Bayan Rabbini Discounting plastic’s other uses, in 2006 alone Assistant Business Manager almost 1.3 million tons of plastic water bottles were produced; that’s the equivalent of 50 million barrels We live in a world obsessed with consumption. The of oil. use of plastic to feed this consumption-obsession is To make matters worse, over 75% of those bottles something we cannot escape. ended up in landfills. Being an organic, synthetic (and often semi- Conservatively speaking, the average American synthetic) moldable material, plastic is valuable and purchases at minimum, 200 bottles of water a year. useful to us. The Ian Somerhalder Foundation is looking to do Everything from components of vehicles, cell something about this. phones and computers, clothes, to kitchenware has some element of plastic in it. But how much plastic is (continued on page 2) too much? Spotlight on Sustainability George Washington Universi- ty Stripped of Ranking Tianna Thomas Ed’s Bayou Cleanup News Editor In the wake of a scandal regarding allegedly falsified incoming stu- dent rates, US News has decided to strip George Washington University of its ranking as one of the best colleges in the nation, a category in which the university held the 51st position. Last Wednesday, US News made the decision to strip George Wash- ington University of its best colleges ranking after news of discrepan- cies in the incoming student statistics reported by the school. The mag- azine intends to keep the university as “unranked” until the university produces updated information about incoming student statistics, such as high school class ranks. -

43 Sidor Nyheter Från IFA-Mässan EEL Tittar Över Gränserna AHLSTRAND & WÅLLGREN

2012 7 Expert i konkurs 43 sidor nyheter från IFA-mässan EEL tittar över gränserna AHLSTRAND & WÅLLGREN Best Product 2012-2013 LCD TV Philips 46PFL9707 PHILIPS 9000 – ÅRETS BÄSTA LCD-TV. ”År efter år kommer det nya TV-modeller från Philips med egenskaper på toppnivå, och år efter år överraskar företaget med ännu bättre prestanda. Philips 9000 serien (46PFL9707) har ett förbättrat ”Moth Eye”-filter som drastiskt reducerar reflektioner från skärmen och det direktstrålande bakljuset med lokal nertoning ger djup svärta och hög ljusstryka. Rörelsekompensationen är utmärkt och de nya flimmerfria glasögonen gör att man kan njuta av 3D-filmer utan det obehag som kan uppstå i kombination med rummets ljus. Den nya fjärrkontrollen har dessutom ett inbyggt tangentbord som förenklar navigationen i TV:ns Smart-funktioner” – EISA juryns motivering till årets bästa Europeiska LCD-TV. UPPLEV GRÄNSLÖS UNDERHÅLLNING PÅ WWW.FEELMORETV.COM KRÖNIKA Förlåt! issa ber om förlåtelse i nationell television - jag får göra det i branschens tidning. Säga förlåt för att jag är Vför pratsam, för yvig och att jag inte ser mig för. Förlåt Fredrik för den heta kaffekopp jag lyckades hälla ut över dig i Berlin. Det var verkligen inte meningen och jag borde verkligen sluta prata flaxandes som en kråka! Valueline Så glad och tacksam att brännskadorna inte blev för allvar- Nätverkskabelkoncept liga. Nedis introducerar detta attraktiva koncept som innehåller de mest använda nätverkskablarna nnan det olycksaliga hände att vi det riktigt trevligt ivrigt i olika längder och olika färger och låter alla diskuterande allt som var nytt på IFA. Alla leverantörer enkelt skapa, förlänga eller färgkoda sitt nätverk. -

Manual De Referência

CÂMERA DIGITAL Manual de referência Pb Garantia de uma vida útil mais longa da bateria Modo stand-by • Este modo de economia de energia reduz significativamente o consumo de energia da bateria e permite que você ligue rapidamente a câmera novamente. Pressione a chave liga/desliga para entrar no modo de espera. Pressione a chave liga/desliga novamente para sair imediatamente do modo de stand-by e retorna ao disparo ou à reprodução. Ao entrar em standby, a câmera é desligada quando o temporizador de desligamento expirar. Os dados não salvos serão perdidos quando a alimentação for desligada. Salve antes de continuar. Standby Não mostrar essa mensagem novamente. Cancelar Modo de espera • Depois de um determinado tempo no modo de stand-by (a configuração padrão é 1 hora), a câmera desliga (A75; Temporizador de desligamento). Todos os dados que não foram salvos serão perdidos quando a câmera desligar depois de um determinado tempo. Salve os dados que deseja manter antes que a câmera entre no modo de espera. Desligar Pressione e segure a chave liga/desliga para desligar a câmera (forçar a saída). A energia consumida da bateria é mínima. Quando você liga a câmera, você está limitado a tirar somente algumas poucas fotografias e não pode alterar as configurações até que o Android™ OS tenha iniciado por completo. Salve os dados que deseja manter antes de desligar a câmera, assim como faria no modo de stand-by. Desligar Redução do consumo de energia da bateria enquanto usa a câmera Desative as funções que não estão mais sendo usadas para reduzir o consumo de energia da bateria. -

Reference Manual

DIGITAL CAMERA Reference Manual En Ensuring Longer Battery Life Stand by Mode • This power saving mode greatly reduces battery power consumption and allows you to quickly turn back on the camera. Press the power switch to enter stand by mode. Press the power switch again to immediately exit stand by mode and resume shooting or playback. Once the camera enters standby, the power will turn off after the shut-down timer expires. Unsaved data will be lost when the power turns off. Save before proceeding. Stand by Do not show this message again. Cancel Stand by mode • After a certain amount of time elapses in stand by mode (the default setting is 1 hour), the camera turns off (A75; Shut-down timer). All unsaved data is lost when the camera turns off after the set amount of time. Save the data you want to keep before the camera enters stand by mode. Power Off Press and hold the power switch to turn off the camera (force-quit). Almost no battery power is consumed. When you turn on the camera, you are limited to taking only a few pictures and cannot change the settings until Android™ OS starts up completely. Save the data you want to keep before you turn off the camera, just as you would in stand by mode. Power off Reducing Battery Power Consumption While Using the Camera Turn off the functions that are not in use to reduce battery power consumption. We recommend placing the Power control widget on the Android™ platform home screen and turning off these functions as often as possible. -

GDT, Die Gesellschaft Deutscher Tierfotografen

FotoEspresso G. Rossbach, J. Gulbins, S. Petrowitz, U. Steinmüller Etwas schlanker… WiFi-Modul (ca. 60 Euro), das die Kommunikation mit Was sich Jürgen Gulbins schon längere Zeit vorge- …fällt diese Ausgabe von Fotoespresso aus – obwohl Tablets und Handys erlaubt (auf ca. 10 m). Canon setzt nommen hatte, resultierte nun wirklich in einem Arti- sich am Fotomarkt aktuell recht viel tut und die Photo- seine neue 6D-Vollformatkamera dagegen. kel, in dem er über die drei kreativen Phasen der digita- kina stattfand. Der Grund ist einfach: Jürgen Gulbins, Auch Sony ließ sich nicht lumpen und stellte die len Fotografie nachdenkt – um eigene Überlegungen der einen Großteil dieses Magazins stemmt, arbeitet Alpha 99 vor – die erste Vollformatkamera mit semi- des Lesers anzustoßen. gerade intensiv an einem neuen Buch über Photoshop- transparentem, feststehendem Spiegel und einem Dieses Mal erfahren die Leser außerdem mehr über Ebenentechniken (für Fotografen), das eigentlich schon 24-Megapixel-Sensor. Die Serienbildrate liegt bei 6 fps die GDT, die Gesellschaft Deutscher Tierfotografen. Die lange fertig sein sollte, aber eben noch nicht ist. Wie (��������������������frames per second���). ���������������������������������b es damit den klassischen Spie- GDT hat einen hohen ethischen Standard, was die Tier- dem auch sei: Die 80 Seiten der letzten FE-Ausgabe gelreflexkameras wirklich an den Kragen geht, wird und Naturfotografie betrifft. Das vom 26. bis 28. �kto- waren ohnehin ganz schön umfangreich. Unser Spek- man sehen. Als Zubehör gibt es – es war -

A1holiday Gift Guide

A1Holiday Gift Guide A2 Page A2 – The Daily Post-Athenian, " Holiday Gift Guide 2012", Wednesday, November 21, 2012 http://www.dailypostathenian.com Use your imagination and make your own holiday ornaments Holiday decorating is a big part of the a photo to a ceramic orna- pieces after they are painted painted and ribbon-adorned gift boxes. holiday season. Bins are taken out of the ment and cover it with so that they are shiny and Stain a treasure chest that can be used attic or garage, and decorations are once decoupage glaze to set it hardened for display. to store reindeer snacks for Santa’s crew. again given their opportunity to shine for permanently. Try pur- Those who want Turn small decorative pieces into orna- several weeks before being packed away chasing clear, glass to do their painting ments for the tree. Paint and affix wood again. ornaments, then at home can visit initials onto stocking holders to identify Among the many decorations families remove the top their local craft or to whom each stocking belongs. Crafty use to deck the halls are ornaments that of the ornament, hobby shop, where individuals also can turn plain wood were made by hand. This year creating which is usu- typically there are plaques into signs with clever sayings, homemade ornaments can be a crafty ally spring-loaded, unfinished ceram- such as “Park your sleigh here.” project that helps families make new before slipping a ic ornaments that holiday memories. photo inside and can be painted with Scavenge around the house Christmas tree ornaments come in all replacing the top. -

Pos-MAIL November 2012

November 2012 ISSN 1615 - 0635 • 5,– € 13. Jahrgang • 51612 http://www.pos-mail.de Einmalig. 2160 Mal. 1 Fernseher. 12 Farben. 2160 Varianten. Der neue Loewe Connect ID. Was haben Kopfhörer und Latte Macchiato gemeinsam? Im Hin- verlief, laut Angaben der GfK, deshalb im zweiten Quartal 2012 blick auf die vergangene IFA gibt es diesbezüglich wohl nur eine äußerst zufriedenstellend. Die wertmäßigen Verkäufe liegen mit Antwort: Beides sind Lifestyle-Produkte. Das Thema Lifestyle 7,7 Prozent über dem Niveau des Vorjahreszeitraums und errei- zieht sich wie ein roter Faden durch fast alle Produktbereiche chen in Summe 653 Millionen Euro. Deutliche Zuwächse ver- der Consumer Electronics und hat schon längst die Sparte Home zeichnet der Bereich Körperpflege. Insbesondere Mundpflege- Appliances erobert. Toaster, Kaffeemaschinen und Bügeleisen geräte wie Mundduschen und elektrische Zahnbürsten, aber dümpeln somit nicht mehr langweilig in der Abteilung Elektro- auch Haartrockner und Haarstyling-Geräte, werden häufiger kleingeräte Haushalt herum, sondern entwickeln mit ihren zahl- gekauft. Mit Ausnahme der traditionellen Filterkaffeemaschinen reichen Funktionen und attraktiven Designs Erlebnisqualität. liegen auch die mit Kaffee- und Espressomaschinen zwischen Strahlend weiße Zähne sind nicht nur ein Gesundheitsmerkmal, April und Juni 2012 erzielten Umsätze im Plus. Dabei greifen Jetzt exklusiv im sondern auch Schönheitsideal, und Baristas rücken mit ihren deutsche Konsumenten besonders gerne zu Kaffee- und Espres- Fachhandel und auf Kaffee-Kreationen genauso stark in den Vordergrund des Kon- sovollautomaten. Die stillen Stars der Küche rücken immer mehr www.loewe.tv sumenten-Interesses wie die Tricks der Star-Köche und ihre in das Interesse lifestyle-orientierter Endanwender, bieten dem persönlichen Empfehlungen in der Auswahl der elektronischen Handel aber auch in diesem Bereich gute Chancen, den Umsatz Küchenhelfer.