Biblioteca Digital

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

2004 PROGRAM REPORT T 2004 PROGRAM HIGHLIGHTS R E Are Pleased to Present a Summary Overview of the Inter-American Dialogue’S Work in 2004

2INTER - AMERICAN0 DIALOGUE04 2004 PROGRAM REPORT t 2004 PROGRAM HIGHLIGHTS r e are pleased to present a summary overview of the Inter-American Dialogue’s work in 2004. The Dialogue has become an increasingly visible and influential presence in Washington and W in Latin America. No other non-governmental institution has more effectively engaged the U.S. Congress on hemispheric affairs, or is more regularly quoted in the U.S. and Latin American media about inter-American issues. This year, former president of Brazil Fernando Henrique Cardoso and former U.S. trade representative Carla Hills chaired a Dialogue task force that produced “Agenda for the po Americas 2005,” a widely cited report offering recommendations to revitalize U.S. policy toward Latin America and the Caribbean. e The Dialogue’s extensive work on Colombia and Venezuela provides authoritative and balanced policy assessments of the challenges confronting those countries. Our forums and publications on remittances have broken new ground. We are an active voice in debates about Haiti and Cuba—and have helped R keep Washington consistently well-informed about developments in Brazil, Argentina, and Mexico. We have worked for several years to keep issues of press freedom, media responsibility, and access to informa- tion on the agenda—both in Washington and throughout the region. The Dialogue is shaping policy and action on educational reform in many countries. We are also working hard to focus attention on the hemispheric trade agenda—and to seek bipartisan support for U.S. economic cooperation with Latin America and the Caribbean. We are grateful for the support of a wide circle of friends, associates, corporate partners, and public and private donors, which is vital to sustain the Inter-American Dialogue’s work and its efforts to improve the quality of debate and decision making in hemispheric affairs and to build stronger cooperation in the Americas. -

Mutual Watching and Resistance to Mass Surveillance After Snowden

Media and Communication (ISSN: 2183-2439) 2015, Volume 3, Issue 3, Pages 12-25 Doi: 10.17645/mac.v3i3.277 Article “Veillant Panoptic Assemblage”: Mutual Watching and Resistance to Mass Surveillance after Snowden Vian Bakir School of Creative Studies and Media, Bangor University, Bangor, LL57 2DG, UK; E-Mail: [email protected] Submitted: 9 April 2015 | In Revised Form: 16 July 2015 | Accepted: 4 August 2015 | Published: 20 October 2015 Abstract The Snowden leaks indicate the extent, nature, and means of contemporary mass digital surveillance of citizens by their intelligence agencies and the role of public oversight mechanisms in holding intelligence agencies to account. As such, they form a rich case study on the interactions of “veillance” (mutual watching) involving citizens, journalists, intelli- gence agencies and corporations. While Surveillance Studies, Intelligence Studies and Journalism Studies have little to say on surveillance of citizens’ data by intelligence agencies (and complicit surveillant corporations), they offer insights into the role of citizens and the press in holding power, and specifically the political-intelligence elite, to account. Atten- tion to such public oversight mechanisms facilitates critical interrogation of issues of surveillant power, resistance and intelligence accountability. It directs attention to the veillant panoptic assemblage (an arrangement of profoundly une- qual mutual watching, where citizens’ watching of self and others is, through corporate channels of data flow, fed back into state surveillance of citizens). Finally, it enables evaluation of post-Snowden steps taken towards achieving an equiveillant panoptic assemblage (where, alongside state and corporate surveillance of citizens, the intelligence-power elite, to ensure its accountability, faces robust scrutiny and action from wider civil society). -

Exhibit a Case 3:16-Cr-00051-BR Document 545-2 Filed 05/11/16 Page 2 of 86

Case 3:16-cr-00051-BR Document 545-2 Filed 05/11/16 Page 1 of 86 Exhibit A Case 3:16-cr-00051-BR Document 545-2 Filed 05/11/16 Page 2 of 86 Executive Order 12333 United States Intelligence Activities (As amended by Executive Orders 13284 (2003), 13355 (2004) and 134 70 (2008)) PREAMBLE Timely, accurate, and insightful information about the activities, capabilities, plans, and intentions of foreign powers , organizations, and persons, and their agents, is essential to the national security of the United States. All reasonable and lawful means must be used to ensure that the United States will receive the best intelligence possible. For that purpose, by virtue of the authority vested in me by the Constitution and the laws of the United States of America, including the National Security Act of 1947, as amended, (Act) and as President of the United States of America, in order to provide for the effective conduct of United States intelligence activities and the protection of constitutional rights, it is hereby ordered as follows: PART 1 Goals, Directions, Duties, and Responsibilities with Respect to United States Intelligence Efforts 1.1 Goals. The United States intelligence effort shall provide the President, the National Security Council, and the Homeland Security Council with the necessary information on which to base decisions concerning the development and conduct of foreign, defense, and economic policies, and the protection of United States national interests from foreign security threats. All departments and agencies shall cooperate fully to fulfill this goal. (a} All means, consistent with applicable Federal law and this order, and with full consideration of the rights of United States persons, shall be used to obtain reliable intelligence information to protect the United States and its interests. -

The Right to Privacy and the Future of Mass Surveillance’

‘The Right to Privacy and the Future of Mass Surveillance’ ABSTRACT This article considers the feasibility of the adoption by the Council of Europe Member States of a multilateral binding treaty, called the Intelligence Codex (the Codex), aimed at regulating the working methods of state intelligence agencies. The Codex is the result of deep concerns about mass surveillance practices conducted by the United States’ National Security Agency (NSA) and the United Kingdom Government Communications Headquarters (GCHQ). The article explores the reasons for such a treaty. To that end, it identifies the discriminatory nature of the United States’ and the United Kingdom’s domestic legislation, pursuant to which foreign cyber surveillance programmes are operated, which reinforces the need to broaden the scope of extraterritorial application of the human rights treaties. Furthermore, it demonstrates that the US and UK foreign mass surveillance se practices interferes with the right to privacy of communications and cannot be justified under Article 17 ICCPR and Article 8 ECHR. As mass surveillance seems set to continue unabated, the article supports the calls from the Council of Europe to ban cyber espionage and mass untargeted cyber surveillance. The response to the proposal of a legally binding Intelligence Codexhard law solution to mass surveillance problem from the 47 Council of Europe governments has been so far muted, however a soft law option may be a viable way forward. Key Words: privacy, cyber surveillance, non-discrimination, Intelligence Codex, soft law. Introduction Peacetime espionage is by no means a new phenomenon in international relations.1 It has always been a prevalent method of gathering intelligence from afar, including through electronic means.2 However, foreign cyber surveillance on the scale revealed by Edward Snowden performed by the United States National Security Agency (NSA), the United Kingdom Government Communications Headquarters (GCHQ) and their Five Eyes partners3 1 Geoffrey B. -

Case3:08-Cv-04373-JSW Document174-2 Filed01/10/14 Page1 of 7 Exhibit 2

Case3:08-cv-04373-JSW Document174-2 Filed01/10/14 Page1 of 7 Exhibit 2 Exhibit 2 1/9/14 Case3:08-cv-04373-JSWNew Details S Document174-2how Broader NSA Surveil la n Filed01/10/14ce Reach - WSJ.com Page2 of 7 Dow Jones Reprints: This copy is for your personal, non-commercial use only. To order presentation-ready copies for distribution to your colleagues, clients or customers, use the Order Reprints tool at the bottom of any article or visit www.djreprints.com See a sample reprint in PDF Order a reprint of this article now format. U.S. NEWS New Details Show Broader NSA Surveillance Reach Programs Cover 75% of Nation's Traffic, Can Snare Emails By SIOBHAN GORMAN and JENNIFER VALENTINO-DEVRIES Updated Aug. 20, 2013 11:31 p.m. ET WASHINGTON—The National Security Agency—which possesses only limited legal authority to spy on U.S. citizens—has built a surveillance network that covers more Americans' Internet communications than officials have publicly disclosed, current and former officials say. The system has the capacity to reach roughly 75% of all U.S. Internet traffic in the hunt for foreign intelligence, including a wide array of communications by foreigners and Americans. In some cases, it retains the written content of emails sent between citizens within the U.S. and also filters domestic phone calls made with Internet technology, these people say. The NSA's filtering, carried out with telecom companies, is designed to look for communications that either originate or end abroad, or are entirely foreign but happen to be passing through the U.S. -

Citizen Snowden

International Journal of Communication 11(2017), 843–857 1932–8036/20170005 Citizen Snowden ENGIN ISIN1 Queen Mary University of London, UK EVELYN RUPPERT Goldsmiths University of London, UK What kind of citizenship has Snowden performed? Apparently, it is not American citizenship because American authorities attempted to try him for treason and he became a stateless fugitive. After requesting political asylum in 21 countries, he was eventually granted temporary asylum in Russia. Neither states nor international organizations recognized his act as an act of citizenship. Did Snowden perform a citizenship that is yet to come? Did he perform an international citizenship? The issue of rights usually recognized in the literature on the debate about Snowden’s act concerns its content such as the practices of states spying on their citizens. This article focuses on the act itself as making digital rights claims that do not yet exist in law. We argue that just as Snowden’s act disrupted surveillance practices that evermore traverse national borders, it also called for digital rights and responsibilities that traverse national legal orders. Keywords: citizenship, performativity, international politics, digital rights I believe in the principle declared at Nüremberg in 1945: “Individuals have international duties which transcend the national obligations of obedience. Therefore individual citizens have the duty to violate domestic laws to prevent crimes against peace and humanity from occurring.” —Edward Snowden, Moscow Declaration2 Engin Isin: [email protected] Evelyn Ruppert: [email protected] Date submitted: 2016–03–29 1 We would like to thank two anonymous reviewers for their two rounds of comments that were incredibly helpful for strengthening our argument. -

Meeting the Privacy Movement

-----BEGIN PGP MESSAGE----- Charset: utf-8 Version: GnuPG v2 hQIMA5xNM/DISSENT7ieVABAQ//YbpD8i8BFVKQfbMy I3z8R8k/ez3oexH+sGE+tPRIVACYMOVEMENTRvU+lSB MY5dvAkknydTOF7xIEnODLSq42eKbrCToDMboT7puJSlWr W Meeting the Privacy Movement d 76hzgkusgTrdDSXure5U9841B64SwBRzzkkpLra4FjR / D z e F Dissent in the Digital Age 0 M 0 0 m BIPhO84h4cCOUNTERREVOLUTION0xm17idq3cF5zS2 GXACTIVISTSXvV3GEsyU6sFmeFXNcZLP7My40pNc SOCIALMOVEMENTgQbplhvjN8i7cEpAI4tFQUPN0dtFmCu h8ZOhP9B4h5Y681c5jr8fHzGNYRDC5IZCDH5uEZtoEBD8 FHUMANRIGHTSwxZvWEJ16pgOghWYoclPDimFCuIC 7K0dxiQrN93RgXi/OEnfPpR5nRU/Qv7PROTESTaV0scT nwuDpMiAGdO/byfCx6SYiSURVEILLANCEFnE+wGGpKA0rh C9Qtag+2qEpzFKU7vGt4TtJAsRc+5VhNSAq8OMmi8 n+i4W54wyKEPtkGREENWALDk41TM9DN6ES7sHtA OfzszqKTgB9y10Bu+yUYNO2d4XY66/ETgjGX3a7OY/vbIh Ynl+MIZd3ak5PRIVACYbNQICGtZAjPOITRAS6E ID4HpDIGITALAGEBhcsAd2PWKKgHARRISON4hN4mo7 LIlcr0t/U27W7ITTIEpVKrt4ieeesji0KOxWFneFpHpnVcK t4wVxfenshwUpTlP4jWE9vaa/52y0xibz6az8M62rD9F/ XLigGR1jBBJdgKSba38zNLUq9GcP6YInk5YSfgBVsvTzb VhZQ7kUU0IRyHdEDgII4hUyD8BERLINmdo/9bO/4s El249ZOAyOWrWHISTLEBLOWINGrQDriYnDcvfIGBL 0q1hORVro0EBDqlPA6MOHchfN+ck74AY8HACKTIVISMy 8PZJLCBIjAJEdJv88UCZoljx/6BrG+nelwt3gCBx4dTg XqYzvOSNOWDENTEahLZtbpAnrot5APPELBAUMzAW Qn6tpHj1NSrAseJ/+qNC74QuXYXrPh9ClrNYN6DNJGQ +u8ma3xfeE+psaiZvYsCRYPTOGRAPHYwkZFimy R9bjwhRq35Fe1wXEU4PNhzO5muDUsiDwDIGITAL A Loes Derks van de Ven X o J 9 1 H 0 w J e E n 2 3 S i k k 3 W Z 5 s XEGHpGBXz3njK/Gq+JYRPB+8D5xV8wI7lXQoBKDGAs -----END PGP MESSAGE----- Meeting the Privacy Movement Dissent in the Digital Age by Loes Derks van de Ven A thesis presented to the -

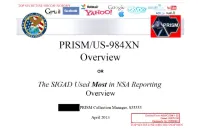

PRISM/US-984XN Overview

TOP SFCRF.T//SI//ORCON//NOFORX a msn Hotmail Go« „ paltalk™n- Youffl facebook Gr-iai! AOL b mail & PRISM/US-984XN Overview OR The SIGAD Used Most in NSA Reporting Overview PRISM Collection Manager, S35333 Derived From: NSA/CSSM 1-52 April 20L-3 Dated: 20070108 Declassify On: 20360901 TOP SECRET//SI// ORCON//NOFORN TOP SECRET//SI//ORCON//NOEÛEK ® msnV Hotmail ^ paltalk.com Youi Google Ccnmj<K8t« Be>cnö Wxd6 facebook / ^ AU • GM i! AOL mail ty GOOglC ( TS//SI//NF) Introduction ILS. as World's Telecommunications Backbone Much of the world's communications flow through the U.S. • A target's phone call, e-mail or chat will take the cheapest path, not the physically most direct path - you can't always predict the path. • Your target's communications could easily be flowing into and through the U.S. International Internet Regional Bandwidth Capacity in 2011 Source: Telegeographv Research TOP SECRET//SI// ORCON//NOFORN TOP SECRET//SI//ORCON//NOEQBN Hotmail msn Google ^iïftvgm paltalk™m YouSM) facebook Gm i ¡1 ^ ^ M V^fc i v w*jr ComnuMcatiw Bemm ^mmtmm fcyGooglc AOL & mail  xr^ (TS//SI//NF) FAA702 Operations U « '«PRISM/ -A Two Types of Collection 7 T vv Upstream •Collection of ;ommujai£ations on fiber You Should Use Both PRISM • Collection directly from the servers of these U.S. Service Providers: Microsoft, Yahoo, Google Facebook, PalTalk, AOL, Skype, YouTube Apple. TOP SECRET//SI//ORCON//NOFORN TOP SECRET//SI//ORCON//NOEÛEK Hotmail ® MM msn Google paltalk.com YOUE f^AVi r/irmiVAlfCcmmjotal«f Rhnnl'MirBe>coo WxdS6 GM i! facebook • ty Google AOL & mail Jk (TS//SI//NF) FAA702 Operations V Lfte 5o/7?: PRISM vs. -

SURVEILLE NSA Paper Based on D2.8 Clean JA V5

FP7 – SEC- 2011-284725 SURVEILLE Surveillance: Ethical issues, legal limitations, and efficiency Collaborative Project This project has received funding from the European Union’s Seventh Framework Programme for research, technological development and demonstration under grant agreement no. 284725 SURVEILLE Paper on Mass Surveillance by the National Security Agency (NSA) of the United States of America Extract from SURVEILLE Deliverable D2.8: Update of D2.7 on the basis of input of other partners. Assessment of surveillance technologies and techniques applied in a terrorism prevention scenario. Due date of deliverable: 31.07.2014 Actual submission date: 29.05.2014 Start date of project: 1.2.2012 Duration: 39 months SURVEILLE WorK PacKage number and lead: WP02 Prof. Tom Sorell Author: Michelle Cayford (TU Delft) SURVEILLE: Project co-funded by the European Commission within the Seventh Framework Programme Dissemination Level PU Public X PP Restricted to other programme participants (including the Commission Services) RE Restricted to a group specified by the consortium (including the Commission Services) CO Confidential, only for members of the consortium (including the Commission Services) Commission Services) Executive summary • SURVEILLE deliverable D2.8 continues the approach pioneered in SURVEILLE deliverable D2.6 for combining technical, legal and ethical assessments for the use of surveillance technology in realistic serious crime scenarios. The new scenario considered is terrorism prevention by means of Internet monitoring, emulating what is known about signals intelligence agencies’ methods of electronic mass surveillance. The technologies featured and assessed are: the use of a cable splitter off a fiber optic backbone; the use of ‘Phantom Viewer’ software; the use of social networking analysis and the use of ‘Finspy’ equipment installed on targeted computers. -

A Level Film Studies Candidate Style Answers

Qualification Accredited A LEVEL Candidate Style Answers FILM STUDIES H410 For first teaching in 2017 H410/02 Critical approaches to film Version 1 www.ocr.org.uk/filmstudies A Level Film Studies Candidate Style Answers Contents Introduction 3 Section A Question 2: Level 5 answer 4 Commentary 6 Section A Question 2: Level 3 answer 7 Commentary 7 Section B Question 4: Level 5 answer 8 Commentary 10 Section B Question 4: Level 3 answer 11 Commentary 11 Section C Question 5: Level 5 answer 12 Commentary 14 Section C Question 5: Level 3 answer 15 Commentary 16 Section C Question 7: Level 5 answer 17 Commentary 19 Section C Question 7: Level 3 answer 20 Commentary 21 Section C Question 10: Level 5 answer 22 Commentary 24 Section C Question 10: Level 3 answer 25 Commentary 25 2 © OCR 2018 A Level Film Studies Candidate Style Answers Introduction Please note that this resource is provided for advice and guidance only and does not in any way constitute an indication of grade boundaries or endorsed answers. Whilst a senior examiner has provided a possible level for each Assessment Objective when marking these answers, in a live series the mark a response would get depends on the whole process of standardisation, which considers the big picture of the year’s scripts. Therefore the level awarded here should be considered to be only an estimation of what would be awarded. How levels and marks correspond to grade boundaries depends on the Awarding process that happens after all/most of the scripts are marked and depends on a number of factors, including candidate performance across the board. -

Journey to the Academy Awards: an Investigation of Oscar-Shortlisted and Nominated Documentaries (2014-2016) PRELIMINARY KEY

Journey to the Academy Awards: An Investigation of Oscar-Shortlisted and Nominated Documentaries (2014-2016) PRELIMINARY KEY FINDINGS By Caty Borum Chattoo, Co-Director, Center for Media & Social Impact American University School of Communication | Washington, D.C. February 2016 OVERVIEW For a documentary filmmaker, being recognized by the Academy of Motion Picture Arts & Sciences for an Oscar nomination in the Best Documentary Feature category is often the pinnacle moment in a career. Beyond the celebratory achievement, the acknowledgment can open up doors for funding and opportunities for next films and career opportunities. The formal recognition happens in three phases: It begins in December with the Academy’s announcement of a shortlist—15 films that advance to a formal nomination for the Academy’s Best Documentary Feature Award. Then, in mid-January, the final list of five official nominations is announced. Finally, at the end of February each year, the one winner is announced at the Academy Awards ceremony. Beyond a film’s narrative and technical prowess, the marketing campaigns that help a documentary make it to the shortlist and then the final nomination list are increasingly expensive and insular, from advertisements in entertainment trade outlets to lavish events to build buzz among Academy members and industry influencers. What does it take for a documentary film and its director and producer to make it to the top—the Oscars shortlist, the nomination and the win? Which film directors are recognized—in terms of race and gender? -

Documentary Movies

Libraries DOCUMENTARY MOVIES The Media and Reserve Library, located in the lower level of the west wing, has over 9,000 videotapes, DVDs and audiobooks covering a multitude of subjects. For more information on these titles, consult the Libraries' online catalog. 10 Days that Unexpectedly Changed America DVD-2043 56 Up DVD-8322 180 DVD-3999 60's DVD-0410 1-800-India: Importing a White-Collar Economy DVD-3263 7 Up/7 Plus Seven DVD-1056 1930s (Discs 1-3) DVD-5348 Discs 1 70 Acres in Chicago: Cabrini Green DVD-8778 1930s (Discs 4-5) DVD-5348 Discs 4 70 Acres in Chicago: Cabrini Green c.2 DVD-8778 c.2 1964 DVD-7724 9/11 c.2 DVD-0056 c.2 1968 with Tom Brokaw DVD-5235 9500 Liberty DVD-8572 1983 Riegelman's Closing/2008 Update DVD-7715 Abandoned: The Betrayal of America's Immigrants DVD-5835 20 Years Old in the Middle East DVD-6111 Abolitionists DVD-7362 DVD-4941 Aboriginal Architecture: Living Architecture DVD-3261 21 Up DVD-1061 Abraham and Mary Lincoln: A House Divided DVD-0001 21 Up South Africa DVD-3691 Absent from the Academy DVD-8351 24 City DVD-9072 Absolutely Positive DVD-8796 24 Hours 24 Million Meals: Feeding New York DVD-8157 Absolutely Positive c.2 DVD-8796 c.2 28 Up DVD-1066 Accidental Hero: Room 408 DVD-5980 3 Times Divorced DVD-5100 Act of Killing DVD-4434 30 Days Season 3 DVD-3708 Addicted to Plastic DVD-8168 35 Up DVD-1072 Addiction DVD-2884 4 Little Girls DVD-0051 Address DVD-8002 42 Up DVD-1079 Adonis Factor DVD-2607 49 Up DVD-1913 Adventure of English DVD-5957 500 Nations DVD-0778 Advertising and the End of the World DVD-1460