Codifica Audio Lossless

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

An Introduction to Mpeg-4 Audio Lossless Coding

« ¬ AN INTRODUCTION TO MPEG-4 AUDIO LOSSLESS CODING Tilman Liebchen Technical University of Berlin ABSTRACT encoding process has to be perfectly reversible without loss of in- formation, several parts of both encoder and decoder have to be Lossless coding will become the latest extension of the MPEG-4 implemented in a deterministic way. audio standard. In response to a call for proposals, many com- The MPEG-4 ALS codec uses forward-adaptive Linear Pre- panies have submitted lossless audio codecs for evaluation. The dictive Coding (LPC) to reduce bit rates compared to PCM, leav- codec of the Technical University of Berlin was chosen as refer- ing the optimization entirely to the encoder. Thus, various encoder ence model for MPEG-4 Audio Lossless Coding (ALS), attaining implementations are possible, offering a certain range in terms of working draft status in July 2003. The encoder is based on linear efficiency and complexity. This section gives an overview of the prediction, which enables high compression even with moderate basic encoder and decoder functionality. complexity, while the corresponding decoder is straightforward. The paper describes the basic elements of the codec, points out 2.1. Encoder Overview envisaged applications, and gives an outline of the standardization process. The MPEG-4 ALS encoder (Figure 1) typically consists of these main building blocks: • 1. INTRODUCTION Buffer: Stores one audio frame. A frame is divided into blocks of samples, typically one for each channel. Lossless audio coding enables the compression of digital audio • Coefficients Estimation and Quantization: Estimates (and data without any loss in quality due to a perfect reconstruction quantizes) the optimum predictor coefficients for each of the original signal. -

Implementing Object-Based Audio in Radio Broadcasting

Object-based Audio in Radio Broadcast Implementing Object-based audio in radio broadcasting Diplomarbeit Ausgeführt zum Zweck der Erlangung des akademischen Grades Dipl.-Ing. für technisch-wissenschaftliche Berufe am Masterstudiengang Digitale Medientechnologien and der Fachhochschule St. Pölten, Masterkalsse Audio Design von: Baran Vlad DM161567 Betreuer/in und Erstbegutachter/in: FH-Prof. Dipl.-Ing Franz Zotlöterer Zweitbegutacher/in:FH Lektor. Dipl.-Ing Stefan Lainer [Wien, 09.09.2019] I Ehrenwörtliche Erklärung Ich versichere, dass - ich diese Arbeit selbständig verfasst, andere als die angegebenen Quellen und Hilfsmittel nicht benutzt und mich auch sonst keiner unerlaubten Hilfe bedient habe. - ich dieses Thema bisher weder im Inland noch im Ausland einem Begutachter/einer Begutachterin zur Beurteilung oder in irgendeiner Form als Prüfungsarbeit vorgelegt habe. Diese Arbeit stimmt mit der vom Begutachter bzw. der Begutachterin beurteilten Arbeit überein. .................................................. ................................................ Ort, Datum Unterschrift II Kurzfassung Die Wissenschaft der objektbasierten Tonherstellung befasst sich mit einer neuen Art der Übermittlung von räumlichen Informationen, die sich von kanalbasierten Systemen wegbewegen, hin zu einem Ansatz, der Ton unabhängig von dem Gerät verarbeitet, auf dem es gerendert wird. Diese objektbasierten Systeme behandeln Tonelemente als Objekte, die mit Metadaten verknüpft sind, welche ihr Verhalten beschreiben. Bisher wurde diese Forschungen vorwiegend -

Lossless Audio Coding Using Adaptive Linear Prediction

View metadata, citation and similar papers at core.ac.uk brought to you by CORE provided by ScholarBank@NUS LOSSLESS AUDIO CODING USING ADAPTIVE LINEAR PREDICTION SU XIN RONG (B.Eng., SJTU, PRC) A THESIS SUBMITTED FOR THE DEGREE OF MASTER OF ENGINEERING DEPARTMENT OF ELECTRICAL AND COMPUTER ENGINEERING NATIONAL UNIVERSITY OF SINGAPORE 2005 ACKNOWLEDGEMENTS First of all, I would like to take this opportunity to express my deepest gratitude to my supervisor Dr. Huang Dong Yan from Institute for Infocomm Research for her continuous guidance and help, without which this thesis would not have been possible. I would also like to specially thank my supervisor Assistant Professor Nallanathan Arumugam from NUS for his continuous support and help. Finally, I would like to thank all the people who might help me during the project. ii TABLE OF CONTENTS ACKNOWLEDGEMENTS .............................................................................................. ii TABLE OF CONTENTS ................................................................................................. iii SUMMARY ........................................................................................................................vi LIST OF TABLES .......................................................................................................... viii LIST OF FIGURES ...........................................................................................................ix CHAPTER 1 INTRODUCTION......................................................................................................... -

Preview - Click Here to Buy the Full Publication

This is a preview - click here to buy the full publication IEC 62481-2 ® Edition 2.0 2013-09 INTERNATIONAL STANDARD colour inside Digital living network alliance (DLNA) home networked device interoperability guidelines – Part 2: DLNA media formats INTERNATIONAL ELECTROTECHNICAL COMMISSION PRICE CODE XH ICS 35.100.05; 35.110; 33.160 ISBN 978-2-8322-0937-0 Warning! Make sure that you obtained this publication from an authorized distributor. ® Registered trademark of the International Electrotechnical Commission This is a preview - click here to buy the full publication – 2 – 62481-2 © IEC:2013(E) CONTENTS FOREWORD ......................................................................................................................... 20 INTRODUCTION ................................................................................................................... 22 1 Scope ............................................................................................................................. 23 2 Normative references ..................................................................................................... 23 3 Terms, definitions and abbreviated terms ....................................................................... 30 3.1 Terms and definitions ............................................................................................ 30 3.2 Abbreviated terms ................................................................................................. 34 3.4 Conventions ......................................................................................................... -

The Standard for Lossless Audio Coding

한국음향학 회지 제 28권 제 7호 pp. 618-629 (2009) MPEG-4 ALS - The Standard for Lossless Audio Coding Tilman Liebchen* *LG Electronics, Berlin, Germany (접수일자 : 2009년 9월 2일 ; 채택일자 : 2009년 9월 15일 ) The MPEG-4 Audio Lossless Coding (ALS) standard belongs to the family MPEG-4 audio coding standards. In contrast to lossy codecs such as AAC, which merely strive to preserve the subjective audio quality, lossless coding preserves every sin이 e bit of the original audio data. The ALS core codec is based on forward-adaptive linear prediction, which combines remarkable compression with low complexity. Additional features include long-term prediction, multichannel coding, and compression of floating-point audio material. This paper describes the basic elements of the ALS codec with a focus on prediction, entropy coding, and related tools, and points out the most important applications of this standardized lossless audio format. Keywords: Audio Coding, Lossless, Compression, Linear Prediction, MPEG, Standard, ALS ASK subject classification* New Media (13) I. Introduction The first version of the MPEG4 ALS standard was published in 2006 [2], Since then, some corrigenda have Lossless audio coding enables the compression of been issued, and additional tools such as reference digital audio data without any loss in quality due to software [3] and conformance bitstreams [4] have a perfect (i.e. bit-identical) reconstruction of the been standardized and released. The latest description of MPEG4 ALS has been fully integrated into the 4th original signal. On the other hand, modem perceptual audio coding standards such as MP3 or AAC are always Edition of the MPEG4 audio standard [5], which was lossy, since they never fully preserve the original ultimately published in 2009. -

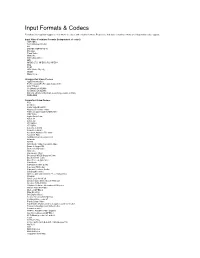

Input Formats & Codecs

Input Formats & Codecs Pivotshare offers upload support to over 99.9% of codecs and container formats. Please note that video container formats are independent codec support. Input Video Container Formats (Independent of codec) 3GP/3GP2 ASF (Windows Media) AVI DNxHD (SMPTE VC-3) DV video Flash Video Matroska MOV (Quicktime) MP4 MPEG-2 TS, MPEG-2 PS, MPEG-1 Ogg PCM VOB (Video Object) WebM Many more... Unsupported Video Codecs Apple Intermediate ProRes 4444 (ProRes 422 Supported) HDV 720p60 Go2Meeting3 (G2M3) Go2Meeting4 (G2M4) ER AAC LD (Error Resiliant, Low-Delay variant of AAC) REDCODE Supported Video Codecs 3ivx 4X Movie Alaris VideoGramPiX Alparysoft lossless codec American Laser Games MM Video AMV Video Apple QuickDraw ASUS V1 ASUS V2 ATI VCR-2 ATI VCR1 Auravision AURA Auravision Aura 2 Autodesk Animator Flic video Autodesk RLE Avid Meridien Uncompressed AVImszh AVIzlib AVS (Audio Video Standard) video Beam Software VB Bethesda VID video Bink video Blackmagic 10-bit Broadway MPEG Capture Codec Brooktree 411 codec Brute Force & Ignorance CamStudio Camtasia Screen Codec Canopus HQ Codec Canopus Lossless Codec CD Graphics video Chinese AVS video (AVS1-P2, JiZhun profile) Cinepak Cirrus Logic AccuPak Creative Labs Video Blaster Webcam Creative YUV (CYUV) Delphine Software International CIN video Deluxe Paint Animation DivX ;-) (MPEG-4) DNxHD (VC3) DV (Digital Video) Feeble Files/ScummVM DXA FFmpeg video codec #1 Flash Screen Video Flash Video (FLV) / Sorenson Spark / Sorenson H.263 Forward Uncompressed Video Codec fox motion video FRAPS: -

Critical Assessment of Advanced Coding Standards for Lossless Audio Compression

TONNY HIDAYAT et al: A CRITICAL ASSESSMENT OF ADVANCED CODING STANDARDS FOR LOSSLESS .. A Critical Assessment of Advanced Coding Standards for Lossless Audio Compression Tonny Hidayat Mohd Hafiz Zakaria, Ahmad Naim Che Pee Department of Information Technology Faculty of Information and Communication Technology Universitas Amikom Yogyakarta Universiti Teknikal Malaysia Melaka Yogyakarta, Indonesia Melaka, Malaysia [email protected] [email protected], [email protected] Abstract - Image data, text, video, and audio data all require compression for storage issues and real-time access via computer networks. Audio data cannot use compression technique for generic data. The use of algorithms leads to poor sound quality, small compression ratios and algorithms are not designed for real-time access. Lossless audio compression has achieved observation as a research topic and business field of the importance of the need to store data with excellent condition and larger storage charges. This article will discuss and analyze the various lossless and standardized audio coding algorithms that concern about LPC definitely due to its reputation and resistance to compression that is audio. However, another expectation plans are likewise broke down for relative materials. Comprehension of LPC improvements, for example, LSP deterioration procedures is additionally examined in this paper. Keywords - component; Audio; Lossless; Compression; coding. I. INTRODUCTION Compression is to shrink / compress the size. Data compression is a technique to minimize the data so that files can be obtained with a size smaller than the original file size. Compression is needed to minimize the data storage (because the data size is smaller than the original), accelerate information transmission, and limit bandwidth prerequisites. -

Supported Codecs and Formats Codecs

Supported Codecs and Formats Codecs: D..... = Decoding supported .E.... = Encoding supported ..V... = Video codec ..A... = Audio codec ..S... = Subtitle codec ...I.. = Intra frame-only codec ....L. = Lossy compression .....S = Lossless compression ------- D.VI.. 012v Uncompressed 4:2:2 10-bit D.V.L. 4xm 4X Movie D.VI.S 8bps QuickTime 8BPS video .EVIL. a64_multi Multicolor charset for Commodore 64 (encoders: a64multi ) .EVIL. a64_multi5 Multicolor charset for Commodore 64, extended with 5th color (colram) (encoders: a64multi5 ) D.V..S aasc Autodesk RLE D.VIL. aic Apple Intermediate Codec DEVIL. amv AMV Video D.V.L. anm Deluxe Paint Animation D.V.L. ansi ASCII/ANSI art DEVIL. asv1 ASUS V1 DEVIL. asv2 ASUS V2 D.VIL. aura Auravision AURA D.VIL. aura2 Auravision Aura 2 D.V... avrn Avid AVI Codec DEVI.. avrp Avid 1:1 10-bit RGB Packer D.V.L. avs AVS (Audio Video Standard) video DEVI.. avui Avid Meridien Uncompressed DEVI.. ayuv Uncompressed packed MS 4:4:4:4 D.V.L. bethsoftvid Bethesda VID video D.V.L. bfi Brute Force & Ignorance D.V.L. binkvideo Bink video D.VI.. bintext Binary text DEVI.S bmp BMP (Windows and OS/2 bitmap) D.V..S bmv_video Discworld II BMV video D.VI.S brender_pix BRender PIX image D.V.L. c93 Interplay C93 D.V.L. cavs Chinese AVS (Audio Video Standard) (AVS1-P2, JiZhun profile) D.V.L. cdgraphics CD Graphics video D.VIL. cdxl Commodore CDXL video D.V.L. cinepak Cinepak DEVIL. cljr Cirrus Logic AccuPak D.VI.S cllc Canopus Lossless Codec D.V.L. -

Review of AVS Audio Coding Standard ZHANG Tao, ZHANG Caixia, and ZHAO Xin

Research Papers DOI: 10.3969/j. issn. 1673Ƽ5188. 2016. 02. 007 http://www.cnki.net/kcms/detail/34.1294.TN.20160205.1056.002.html, published online February 5, 2016 tions and enterprises that focus on the research of digital audio and video coding technology and the development of related products. Review of AVS Audio Since 2002, the AVS audio subgroup has drafted a series of audio coding standards, including AVS1 ⁃P3, AVS1 ⁃P10 and Coding Standard AVS ⁃ Lossless. Since 2009, the AVS audio subgroup started drafting the next generation audio coding standards. To identi⁃ fy the difference between these two series, the former serial is called AVS1 audio coding standards and the later one is called ZHANG Tao, ZHANG Caixia, and ZHAO Xin (School of Electronic Information Engineering, Tianjin University, Tianjin AVS2 audio coding standards. The AVS1 audio coding stan⁃ 300072, China) dards has been finished and widely used in various applica⁃ tions so far. The AVS2 audio coding standards is still under de⁃ velopment and will be released soon. Abstract This paper reviews AVS audio coding standards. It is orga⁃ nized as follows. In section 2, the series standards of AVS1 au⁃ Audio Video Coding Standard (AVS) is a second ⁃ generation dio including AVS1⁃P3, AVS1⁃P10 and AVS⁃Lossless will be source coding standard and the first standard for audio and introduced. AVS2 audio coding scheme are presented in sec⁃ video coding in China with independent intellectual property rights. Its performance has reached the international standard. tion 3. At last, the conclusion is given in section 4. Its coding efficiency is 2 to 3 times greater than that of MPEG ⁃2. -

Embedded Lossless Audio Coding Using Linear Prediction and Cascade Coding

University of Wollongong Thesis Collections University of Wollongong Thesis Collection University of Wollongong Year Embedded lossless audio coding using linear prediction and cascade coding Kevin Adistambha University of Wollongong Adistambha, Kevin, Embedded lossless audio coding using linear prediction and cascade coding, M.Eng. thesis, School of Electrical, Computer and Telecommunications Engineering , University of Wollongong, 2005. http://ro.uow.edu.au/theses/498 This paper is posted at Research Online. http://ro.uow.edu.au/theses/498 Embedded Lossless Audio Coding using Linear Prediction and Cascade coding A thesis submitted in fulfillment of the requirements for the award of the degree Master of Engineering Research From The University of Wollongong By Kevin Adistambha Bachelor of Science, Master of Internet Technology School of Electrical, Computer and Telecommunications Engineering 2005 Abstract This thesis studies the techniques and feasibility of embedding a perceptual audio coder within a lossless compression scheme. The goal is to provide for two step scalability in the resulting bitstream, where both a perceptual version of the audio signal and a lossless version of the same signal are provided in the one bitstream. The focus of this thesis is the selection of the perceptual coder to be used as the perceptual base layer and the techniques to be used to compress the lossless layer by using backward linear prediction followed by entropy coding. The perceptual base layer used is MPEG-4 AAC, chosen based on entropy measurements of the residual signal. Results of the work in this thesis show that the embedded lossless coding scheme could achieve an average compression ratio of only 6% larger compared to lossless only coding. -

Codec for Mpeg-4 Movie

Codec for mpeg-4 movie One of the best "codec packs" on the market, FFDShow MPEG-4 Video Decoder It improves the visual quality of low bitrate movies due to its. For playback of videos produced with certain Samsung digital camcorders. Notes: The decoder is DirectShow-only. This means that VfW (Video. Media Player Codec Pack for Microsoft Windows, 10, , 8, 7, Vista, XP, , , x MP4 | MPEG4 | MPEG2 and many more. File types you will be able. MPEG4 codec free download. Download and install free MPEG4 codec. MPEG-4 is a method of defining compression of audio and visual (AV) digital data. The key parts to be aware of are MPEG-4 Part 2 (including Advanced Simple Profile, used by codecs such as DivX, Xvid, Nero Digital and 3ivx and by Background · Overview · MPEG-4 Parts · MPEG-4 Levels. This package can be used as an alternative to automatically downloading Windows Media Codecs, or to correct problems experienced with. This page answers all questions related to 'mp4 vs mpeg4' file formats. I've been looking for info about "MPEG vs MP4" and I've heard of movie files Media Container = video format (video codec) + audio format (audio codec) + subtitle. Free Download DivX MPEG-4 Audio Codec - A codec that makes it possible for users to watch movies created with WMA sound format. I have some MP4 files I am unable to import into Final Cut Pro X from a Hard Drive. x, Codecs: MPEG-4 Video, Linear PCM, Audio. 3ivx is a natural video compression system that is compliant with MPEG size of a DVD or MPEG-2 movie while maintaining approximately the same quality. -

Embedded Lossless Audio Coding Using Linear Prediction and Cascade

University of Wollongong Research Online Faculty of Engineering and Information Faculty of Informatics - Papers (Archive) Sciences 2005 Embedded lossless audio coding using linear prediction and cascade Kevin Adistambha University of Wollongong, [email protected] Christian Ritz University of Wollongong, [email protected] Jason Lukasiak [email protected] Follow this and additional works at: https://ro.uow.edu.au/infopapers Part of the Physical Sciences and Mathematics Commons Recommended Citation Adistambha, Kevin; Ritz, Christian; and Lukasiak, Jason: Embedded lossless audio coding using linear prediction and cascade 2005. https://ro.uow.edu.au/infopapers/2793 Research Online is the open access institutional repository for the University of Wollongong. For further information contact the UOW Library: [email protected] Embedded lossless audio coding using linear prediction and cascade Abstract Embedded lossless audio coding is a technique for embedding a perceptual audio coding bitstream within a lossless audio coding bitstream. This paper provides an investigation into a lossless embedded audio coder based on the AAC coder and utilising both backward Linear Predictive Coding (LPC) and cascade coding. Cascade coding is a technique for entropy coding of large dynamic range integer sequences that has the advantage of simple implementation and low complexity. Results show that employing LPC in an embedded architecture achieves approximately an 8% decrease in the coding rate. The overall compression performance of cascade coding closely follows Rice coding, a popular entropy coding method for lossless audio. It is also shown that performance can be further improved by incorporating a start of the art lossless coder into the proposed embedded coder.