Procesamiento De Búsquedas Por Similitud

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Ninagawa Company Kafka on the Shore Based on the Book by Haruki Murakami Adapted for the Stage by Frank Galati

Lincoln Center Festival lead support is provided by American Express July 23 –26 David H. Koch Theater Ninagawa Company Kafka on the Shore Based on the book by Haruki Murakami Adapted for the stage by Frank Galati Directed by Yukio Ninagawa Translated by Shunsuke Hiratsuka Set Designer Tsukasa Nakagoshi Costume Designer Ayako Maeda Lighting Designer Motoi Hattori Sound Designer Katsuji Takahashi Hair and Make-up Designers Yoko Kawamura , Yuko Chiba Original Music Umitaro Abe Chief Assistant Director Sonsho Inoue Assistant Director Naoko Okouchi Stage Manager Shinichi Akashi Technical Manager Kiyotaka Kobayashi Production Manager Yuichiro Kanai Approximate performance time: 3 hours, including one intermission Major support for Lincoln Center Festival 2015 is provided by The Andrew W. Mellon Foundation. This performance is made possible in part by the Josie Robertson Fund for Lincoln Center. Lincoln Center Festival 2015 is made possible in part with public funds from the New York City Department of Cultural Affairs, New York State Council on the Arts, and the National Endowment for the Arts. The Lincoln Center Festival 2015 presentation of Kafka on the Shore is made possible in part by generous support from the LuEsther T. Mertz Charitable Trust. Additional support provided by Mitsui & Co. (U.S.A.), Inc., Marubeni America Corporation, Mitsubishi Corporation (Americas), Sumitomo Corporation of Americas, ITOCHU International Inc., Mitsubishi Heavy Industries America, Inc., and Nippon Steel & Sumitomo Metal U.S.A., Inc. Co-produced by Saitama Arts Foundation, Tokyo Broadcasting System Television, Inc., and HoriPro, Inc. LINCOLN CENTER FESTIVAL 2015 KAFKA ON THE SHORE Greeting from HoriPro Inc. HoriPro Inc., along with our partners Saitama Arts Foundation and Tokyo Broadcasting System Television Inc., is delighted that we have once again been invited to the Lincoln Center Festival , this time to celebrate the 80th birthday of director, Yukio Ninagawa, who we consider to be one of the most prolific directors in Japanese theater history. -

The-Vandal.Pdf

THE FLEA THEATER JIM SIMPSON artistic director CAROL OSTROW producing director BETH DEMBROW managing director presents the world premiere of THE VANDAL written by HAMISH LINKLATER directed by JIM SIMPSON DAVID M. BARBER set design BRIAN ALDOUS lighting design CLAUDIA BROWN costume design BRANDON WOLCOTT sound design and original music MICHELLE KELLEHER stage manager EDWARD HERMAN assistant stage manager CAST (IN ALPHABETICAL ORDER) Man...........................................................................................................................Zach Grenier Woman...............................................................................................................Deirdre O’Connell Boy...........................................................................................................................Noah Robbins CREATIVE TEAM Playwright...........................................................................................................Hamish Linklater Director.......................................................................................................................Jim Simpson Set Design..............................................................................................................David M. Barber Lighting Design.........................................................................................................Brian Aldous Costume Design......................................................................................................Claudia Brown Sound Design and Original -

Appetite for Autumn 34Th Street Style Knicks & Nets

NOV 2014 NOV ® MUSEUMS | Knicks & Nets Knicks 34th Street Style Street 34th Restaurants offering the flavors of Fall NBA basketball tips-off in New York City York New in tips-off basketball NBA Appetite For Autumn For Appetite Styles from the world's brands beloved most BROADWAY | DINING | ULTIMATE MAGAZINE FOR NEW YORK CITY FOR NEW YORK MAGAZINE ULTIMATE SHOPPING NYC Monthly NOV2014 NYCMONTHLY.COM VOL. 4 NO.11 44159RL_NYC_MONTHLY_NOV.indd All Pages 10/7/14 5:18 PM SAMPLE SALE NOV 8 - NOV 16 FOR INFO VISIT: ANDREWMARC.COM/SAMPLESALE 1OOO EXCLUSIVES • 1OO DESIGNERS • 1 STORE Contents Cover Photo: Woolworth Building Lobby © Valerie DeBiase. Completed in 1913 and located at 233 Broadway in Manhattan’s financial district, The Woolworth building is an NYC landmark and was at the time the world’s tallest building. Its historic, ornate lobby is known for its majestic, vaulted ceiling, detailed sculptures, paintings, bronze fixtures and grand marble staircase. While generally not open to the public, this neo-Gothic architectural gem is now open for tours with limited availability. (woolworthtours.com) FEATURES Top 10 things to do in November Encore! Encore! 16 26 Feel the energy that only a live performance in the Big Apple can produce 34th Street Style 18 Make your way through this stretch of Midtown, where some of the biggest outposts from global NYC Concert Spotlight brands set up shop 28 Fitz and the Tantrums Appetite For Autumn 30 The Crowd Goes Wild 20 As the seasons change, so do these restaurant's NBA basketball tips off in NYC menus, -

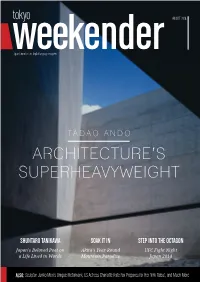

Tadao Ando Architecture’S Superheavyweight

AUGUST 2014 Japan’s number one English language magazine TADAO ANDO ARCHITECTURE’S SUPERHEAVYWEIGHT SHUNTARO TANIKAWA SOAK IT IN STEP INTO THE OCTAGON Japan’s Beloved Poet on Akita’s Year-Round UFC Fight Night a Life Lived in Words Mountain Paradise Japan 2014 ALSO: Sculptor Junko Mori’s Unique Metalwork, US Actress Charlotte Kate Fox Prepares for Her NHK Debut, and Much More AUGUST 2014 www.tokyoweekender.com AUGUST 2014 CONTENTS 8 AKITA ONSENS Dipping into the hospitality of Nyuto Mountain’s hot spring ryokan 16 18 22 TADAO ANDO JUNKO MORI CHARLOTTE KATE FOX One of the world’s most celebrated Transmuting metal into organic forms of Say hello to the face of NHK’s upcoming architects reveals his passion for the craft subtle grace and beauty morning drama, Massan 6 UFC Preview 20 Is Japan Expensive? 31 Weekender Insiders Club We take a look ahead at three of the top Ken Seeroi dispels one of the country’s Join in, sign on, and find out about matchups at Fight Night Japan 2014 biggest myths product launches and special offers 7 Takanori Gomi 24 People, Parties, Places 32 Agenda The Fireball Kid prepares for his battle The latest updates from Tokyo’s nonstop Celebrate the closing of summer any way with Myles “Fury“ Jury social scene you like it, from udon to samba 13 Shuntaro Tanikawa 30 Movies 34 Back in the Day Looking back at more than six decades of Scarlett Johansson updates her grey In which a shady character from the life as a public poet matter and Lupin goes live action Weekender’s past ‘fesses up www.tokyoweekender.com AUGUST 2014 THIS MONTH IN THE WEEKENDER clean, minimal lines of his monumental AUGUST 2014 designs, the Osaka-born architect has a AUGUST 2014 fascinating background that includes a Japan’s number one English language magazine stint in the boxing ring and no formal schooling whatsoever. -

En Garde Arts Presents Wilderness

EN GARDE ARTS PRESENTS WILDERNESS Tuesday, March 28, 2017, at 7:30pm Colwell Playhouse PROGRAM EN GARDE ARTS PRESENTS WILDERNESS Seth Bockley and Anne Hamburger, writers Seth Bockley, director THE KIDS/FIELD STAFF Chloe/Rebecca Michael/Taco Holly DeMorro Jake Williams Elizabeth Dylan/Billy Caitlin Goldie Luke Zimmerman Sophia/Merritt The Mom Taylor Noble Welker White* Cole/Corey The Parents Scott Freeman as themselves This performance will be presented with no intermission. En Garde Arts appears by arrangement with: Opus 3 Artists 470 Park Avenue South, 9th Floor North New York, NY 10016 www.opus3artists.com 2 Devon de Mayo and Patrick McCollum, co-movement directors Carolyn Mraz, set design Scott Bolman, lighting design Claudia Brown, costume design Mikhail Fiksel, sound design Michael Tutaj, video and projection design Morgan Jenness, dramaturgy Lauren Parrish, production stage manager and lighting supervisor Lionel A. Christian*, stage manager Jake Cheriff, audio/video engineer Lory Henning, production manager Amanda Cooper, general manager Kyle Henderson, Desert Noises, Gregory Alan Isakov and Kyle Miller, Tow’rs, songwriters Stephanie Klapper, CSA, casting Anne Hamburger, executive producer Nicole Borelli Hearn, Opus 3 Artists, tour representation Solomon Weisbard, associate lighting designer Michael Hunter, music direction Paul Howells, audio/video consultant Maria Baranova-Suzuki, production photography *Courtesy of Actors Equity Association WILDERNESS is made possible in part thanks to the generosity of the Phoebe Snow Foundation, Howard Gilman Foundation, Allergan Foundation, Evoke Therapy Programs, Open Sky Wilderness, Jus- tyn and Scott Shwayder, Patrick Duffy, Joan D. Firestone, Betsy Kalish, Kate Paletta, and Regina Scully. Development support provided by the National Endowment for the Arts (NEA), Pace University, the University of Florida, Gainesville, and Ideal Glass. -

Living Through the Chilean Coup D'etat

Living Through the Chilean Coup d’Etat: The Second-Generation’s Reflection on Their Sense of Agency, Civic Engagement and Democracy Denise Tala Diaz ORCID Scholar ID# 0000-0003-1458-6287 A Dissertation Submitted to the PhD in Leadership and Change Program of Antioch University in partial fulfillment for the degree of Doctor of Philosophy June 2020 This dissertation has been approved in partial fulfillment of the requirements for the degree of PhD in Leadership and Change, Graduate School of Leadership and Change, Antioch University Dissertation Committee • Laurien Alexandre, PhD, Committee Chair • Elizabeth Holloway, PhD, Committee Member • Jean-Luc Brackelaire, PhD, Committee Member Copyright 2020 Denise Tala Diaz All rights reserved Dedication I would like to dedicate this dissertation to my children, Alejandro, Josefina and Elisa who are part of the generation without fear, who were lucky enough to be born in a democracy. My message to you is simple and from all of my heart; it is important to be resilient, to never give up because despite all the difficulties you will confront during your lives you will always need to think that you are capable to keep going because the sun will come out again. To Patricio my husband, thank you for our interesting and long conversations which many times brought back nostalgic memories from our youth when Chile was going through difficult times. Thank you for the shared coffees, cookies, glasses of wine, and for encouraging me all the time to finish my research. To Margarita, my second mom, who has always taken care of me. Thank you for your lovely lunches and dinners made with all your love while I was working on my dissertation until late every day. -

Live at the Miami Jackie Gleason Theater

Lexus Presents a VIP Performance by the International Sensation Fuerza Bruta - Live at the Miami Jackie Gleason Theater October 29, 2009 Theatrical Performance Caps Off Lexus’ Hispanic-Focused Initiatives (Miami, FL) October 28, 2009 – As the leading luxury automotive brand in the United States, Lexus believes it is important to support and encourage all forms of artistic expression in the Hispanic Community. The next event in Lexus’ innovative experiential campaign is a VIP evening with Fuerza Bruta at the Filmore Jackie Gleason Theater in Miami on Monday, Nov. 2, 2009. This electric theatrical experience begins the moment audiences arrive as they pass the Walk of Stars located right outside the Miami Jackie Gleason Theater box office entrance where celebrities cement their handprints and signatures. The night will kick off with a cocktail reception leading up to the show. At show time, audiences will be ushered onto the main stage where they will be engulfed in spectacle – performers suspended in mid-air surrounded by a vast sea of mylar; and gorgeous women twisting ethereally in a lucite pool above the audience. Fuerza Bruta is a vivid of example of VIP events that will continue into 2010, before, during and after Hispanic Heritage month. In celebration of Hispanic Heritage Month, Lexus partnered with Ocean Drive Magazine and the Miami Dolphins to host a star-studded reception during the Dolphins vs. Jets game on October 12, 2009 at the ultra-modern Ocean Drive Club at Landshark Stadium. In line with Lexus’ dedication to the Hispanic Community, the Lexus Listening Lounge at the Miami Auto Show featured an impressive line-up of acclaimed Latino artists from Miami. -

Socialist Biopolitics: Flesh and Animality in Cuba and Venezuela

López, Magdalena. 2021. Socialist Biopolitics: Flesh and Animality in Cuba and Venezuela. Latin American Research Review 56(2), pp. 417–436. DOI: https://doi.org/10.25222/larr.944 LITERATURE AND CULTURAL STUDIES Socialist Biopolitics: Flesh and Animality in Cuba and Venezuela Magdalena López1,2 1 Centro de Estudos Internacionais, Instituto Universitário de Lisboa (ISCTE-IUL), PT 2 Kellogg Institute for International Studies, University of Notre Dame, US [email protected] Taking as a starting point the ontological differentiation between animal and human as a fundamental mechanism of biopolitical violence, I analyze the ambiguity of the imaginaries of flesh and animality in the contexts of revolutionary Cuba and Venezuela. I demonstrate how the dynamics of power marked by an ontological division between human and not human, often ascribed to neoliberalism, paradoxically operate in socialist regimes. I examine several instances of visual arts, performance, literature, and public demonstrations, to reveal, on the one hand, sacrificial state power over the population’s bodies and, on the other, examples of disobedience against the state. Partiendo de la diferenciación ontológica entre lo humano y lo animal como mecanismo fundamental de la violencia biopolítica, analizaré la ambigüedad de los imaginarios sobre la carne y lo animal en Cuba y Venezuela. Demostraré cómo las dinámicas de poder marcadas por esta división ontológica que generalmente se relacionan a contextos neoliberales, operan también de manera paradójica en regímenes socialistas. Para ello examinaré un corpus diverso de artes visuales, performance, literatura y demostraciones políticas a fin de revelar por un lado, el poder sacrificial del Estado sobre los cuerpos ciudadanos y, por el otro, la insumisión de los cuerpos frente a ese poder. -

Leeuwarden-Friesland 2018 ISPA Congress: June 11 – 15, 2018 Off

Leeuwarden-Friesland 2018 ISPA Congress: June 11 – 15, 2018 Delegates by Last Name Off the Beaten Track Updated on 6/20/2018 Name/ Position Organization/ Location Website Rasmus Adrian Hotel Pro Forma http://www.hotelproforma.dk Managing Director Copenhagen, Denmark Nadia Aguir IN SITU Head of European and International Relations Marseille, France Hosang Ahn Hongik University Professor Seoul, South Korea Mary Lou Aleskie Hopkins Center for the Arts at Dartmouth College Director Hanover, NH, USA Bradley Allen Tivoli - Theatres http://www.tivoli.dk/salene Admin Manager Copenhagen, Denmark Ane Alsløv Danish Agency for Culture http://slks.dk Head of Projects, Senior Advisor Copenhagen, Denmark Yamam Al-Zubaidi Riksteatern Equality and Diversity Manager Norsborg, Sweden Maria Rita Arnaut 1340 Entertainment Managing Director - Europe Lisboa, Portugal Britt Arp Stichting Plan d- http://www.plan-d.nl Business Director Amsterdam, Netherlands Laura Artoni pro scena http://www.proscena.org Producer Milan, Italy Randa Asmar Beirut Spring Festival/Samir Kassir Foundation Director Beirut, Lebanon Magnus Aspegren Riksteatern CEO Norsborg, Sweden Nika Babayan Cadence Music Centre General Manager Yerevan, Armenia Tomy Lorenzo Badiane DECLIC (Integrated Civic Leadership & Community Arts & Culture Program Manager Development) Ziguinchor, Senegal David Baile International Society for the Performing Arts https://www.ispa.org Chief Executive Officer New York, NY, USA Dan Baker Barbican Theatre, Plymouth http://www.barbicantheatre.co.uk Creative Producer Plymouth, -

A Day in the Life of a Rickshaw Driver, Summer Cruises in Tokyo, and Who Is the Greatest Japanese Person Ever?

AUGUST 2017 Japan’s number one English language magazine CRAVING AN ISLAND GETAWAY? IT'S CLOSER THAN YOU THINK... PLUS: A Day in the Life of a Rickshaw Driver, Summer Cruises in Tokyo, and Who is the Greatest Japanese Person Ever? 20 14 23 28 AUGUST 2017 radar in-depth 30 HOW "ASIAN BOSS" IS EXPLODING CULTURAL STEREOTYPES THIS MONTH’S HEAD TURNERS COFFEE-BREAK READS And getting Tokyoites to open up. 8 AREA GUIDE: KURAMAE 20 SEEKING WHITE SAND How this Edo period neighborhood has sus- Craving an island getaway? Here are three 32 WHO IS THE GREATEST JAPANESE tained its relevance through craftsmanship. destinations in Japan that should be on the PERSON EVER? list of “Asia’s best beaches.” The results are in: we count down the top 15. 10 STYLE Get the vacation look with chic items for 23 THAT OUTDOOR IZAKAYA FEELING beach getaways and summer sundowners. Street-pub dining is the best way to enjoy Tokyo’s balmy summer nights. Create your guide 12 TRENDS own balcony izakaya dinner with these four CULTURE ROUNDUP Rooftops, pools, cocktails and beers: find simple traditional recipes. 37 ART & EVENTS your perfect outdoor drinks spot. Yokohama Triennale, Arcimboldo, and 26 FIVE UNIQUE SUMMER CRUISES stretching the bounds of possibility. 14 TRAVEL Free your mind from the hectic city by Meet some of Japan's top artisans in one of setting sail on Tokyo’s waterways. 40 AGENDA the world's most famous industrial regions. Awaodori, samba, ghosts, and the all-night 28 A DAY IN THE LIFE OF A concert of Sonic Mania. -

Casting Directors

CASTING DIRECTORS CASTING DIRECTOR: NEW YORK AAAVoice Casting c/o City Vox 630 Ninth Ave., Ste. 415 New York, NY 10036 917-363-9877 917-363-3130 email: [email protected] website: www.voiceoversunlimited.com Staff: Carole Murray Duckworth(Casting Director), Dan Duckworth (Casting Director), Jen Duckworth (Casting Director) Casts: Voiceovers Policy: Union and nonunion. Demo reel/resume by mail or email. Address ESLandpreteenvoice talent information to the attention of Jen Duckworth. To be entered in active casting files, call to arrange an appointment for interview. No drop-offs. Comments: Casts for voice talent only. Particularly interested in foreign-language voiceover/narrator talent. AAAVoiceCasting is a division of VoiceOvers Unlimited, which provides training and other voiceover services. Florida office: 3105 12th St. North, St. Petersburg, FL 33704. ABC Entertainment Casting (CSA) 147 Columbus Ave. New York, NY 10023 Staff: Marci Phillips (Executive Director, Primetime Casting, East Coast) Casts: Television Policy: Accepts headshot/resume by mail only. No drop-offs. ABEL Intermedia/Barbara Barna Casting 249 Smith St., Ste. 122 Brooklyn, NY 11231 718-403-0200 email: [email protected] website: www.abelintermedia.com Credits: Unscripted/alternative projects, Adam Richman, Bert Kreischer, Carson Kressley, Clinton Kelly, Ted Allen, Thom Felicia, and manyothers. Clients include television networks, PRfirms, celebrity chefs, models, athletes, business executives, and young creatives. Staff: Barbara Barna Abel (Casting Director) Casts: Commercials- Interactive & Digital Media- Documentaries & Reality TV - Television Policy: Unionandnonunion. Headshot/resume/demoreelbymail or email. Accepts postcards and invitations. No calls. No drop-offs. Comments: Specializes in nonfiction, alternative, reality, branded entertainment, and new media. For information on small group classes and private coaching visit www.abelintermedia.com orcall (718) 403- 2000.