Algorithmes De Recommandation Musicale

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

The Lumberjack, November 5, 2014

THEServing LUMBERJACK the Humboldt State campus and community since 1929 Vol. 105 No. 10 www.thelumberjack.org Wednesday, November 5, 2014 Love, nature and rasta soul Eye candy HSU icon vandalized Exclusive interview with reggae star Ziggy Marley on Halloween night by Israel LeFrak Humboldt State University’s iconic entryway sign was tagged with spray paint by vandals late Halloween night. The two mes- sages said, “Bring back bolman [sic]” and “Fire P I TOMP- KINS [sic].” According to university po- lice chief Lynne Soderberg, the event took place between 12:30-12:35 a.m. early Saturday morning. There are currently no suspects, but police received an eyewitness account. “We don’t want to release any descriptions until we can confirm the information given to us,” Soderberg said. “We Continued on page three News ........... 3 Ziggy Marley will play at the Van Duzer Theatre Nov. 8 | Photo courtesy of Malia James Life and Arts ..... 5 by Miranda Hutchison and Rebekah Staub State University this Saturday to et, with actual dirt, with earth. and expand traditional reg- Sports .......... 9 perform the last leg of his tour. Hopefully that will reignite that gae sounds with new musical Ziggy Marley scatters dirt from The six-time Grammy Award thing that I think is deep inside sounds. It represents what his hands. The earth crumbles winner’s latest album, “Fly Ras- of us, the love of this planet, the Marley described as a galactic Opinion ......... 11 over young seeds in the ground. ta,” comes with a package of love that means we will treat sonic journey. -

AXS TV Schedule for Mon. April 17, 2017 to Sun. April 23, 2017 Monday

AXS TV Schedule for Mon. April 17, 2017 to Sun. April 23, 2017 Monday April 17, 2017 6:30 PM ET / 3:30 PM PT 8:00 AM ET / 5:00 AM PT Rock Legends Rock Legends Foo Fighters - With a career of over two decades and album sales over 11 million, Foo Fighters KISS - Well known for its members’ face paint and stage outfits, KISS rose to prominence in are giants in the world of contemporary rock. Featuring archive material, music videos “Best Of the mid-to-late 1970s with their elaborate live performances. Interviews, news archives and You” and “Monkey Wrench” including exclusive insights from media critics. performances reveal the story of this iconic band. 7:00 PM ET / 4:00 PM PT 8:50 AM ET / 5:50 AM PT Nothing But Trailers Rock Legends Sometimes the best part of the movie is the preview! So AXS TV presents Nothing But Trailers. Santana - Leading music critics tell the story of Santana, the San Francisco-based Latin rock See the best trailers, old and new, in AXS TV’s collection. band that exploded onto the music scene with their breakthrough performance at 1969’s Woodstock music festival. Premiere 9:00 PM ET / 6:00 PM PT 9:20 AM ET / 6:20 AM PT 9 to 5 Nothing But Trailers Three female employees live out their fantasies of getting even with their chauvinistic, egotisti- Sometimes the best part of the movie is the preview! So AXS TV presents Nothing But Trailers. cal male boss. Starring Jane Fonda, Lily Tomlin, and Dolly Parton. -

AXS TV Canada Schedule for Mon. March 20, 2017 to Sun. March 26, 2017

AXS TV Canada Schedule for Mon. March 20, 2017 to Sun. March 26, 2017 Monday March 20, 2017 6:10 PM ET / 3:10 PM PT 8:00 AM ET / 5:00 AM PT Rock Legends Nothing But Videos Billy Idol - English rock musician, Billy Idol first achieved fame in the punk rock era as a member Nothing But Videos is a collection of some of the biggest artists today. Catch some of the best of the band Generation X as well as creating a successful name for himself as a solo artist. Using music videos during this special presentation. interviews, news archive and performance this episode reveals the unique aspect of this iconic artist. 8:30 AM ET / 5:30 AM PT The Big Interview 7:00 PM ET / 4:00 PM PT Oliver Stone - Dan Rather sits down with Academy Award winning director Oliver Stone. From his Nothing But Trailers service in Vietnam, to his brief time behind bars in an American prison, Stone talks about how Sometimes the best part of the movie is the preview! So AXS TV presents Nothing But Trailers. his personal experiences shaped his legendary film making career. See the best trailers, old and new, in AXS TV’s collection. 9:30 AM ET / 6:30 AM PT 9:00 PM ET / 6:00 PM PT The Big Interview The Musical Mojo Of Dr. John - Celebrating Mac & His Music Gregg Allman - A conversation with the music legend known as one of the architects of southern Equal parts musician, singer, songwriter, hustler, and shaman, Dr. -

Right Arm Resource Update

RIGHT ARM RESOURCE UPDATE JESSE BARNETT [email protected] (508) 238-5654 www.rightarmresource.com www.facebook.com/rightarmresource 10/15/2014 The Lone Bellow “Then Came The Morning” The first single from their anticipated sophomore album, due in January, going for adds now Most Added early with support already from almost 20 stations including WXRV, KINK, WNCS, WRLT, WFUV, KCSN, WYEP, WTMD, WWCT, WJCU, WEXT, WCBE, WMVY, WNKU, WFIV, WDST, KROK and more “Charismatic, photogenic, endlessly hooky — The Lone Bellow has been the complete package since day one.”- NPR On tour now - see the complete list of dates on page 3 Single available on iTunes now, great sales already The New Pornographers Anthony D’Amato Young Rebel Set “Dancehall Domine” “Good and Ready” “Tuned Transmission” The second single from Brill Bruisers The first single from his New West debut The first single from Crocodile, in stores now Most Added early! Already on board: album The Shipwreck From The Shore New: WCBE ON: WZEW, KTAO, WOCM, WVMP KCMP, WFUV, WFPK, KTBG, KBAC, WDST, WFIV, Already added: KRSH, WZEW, KNBA, KTAO, WBJB, Single on PlayMPE, full cd mailing to radio this week KCLC, KSUT, WBJB, WNKU, WYCE, WYEP and more WCBE, WFHB, WFIT, WERU, Maine Public Radio... “All we can say is that Young Rebel Watch the fantastic video on our site now Great set in Boulder In stores & on your desk now Set have created a flawless coupling Over 30K albums sold so far, #13 debut Fun video on our website now, premiered via NPR of psychedelic indie with blues rock Catch them on tour before the end of the “Anthony D’Amato strikes every right note” - USA Today and we love it.” - InvasionMag (UK) year: 11/9 Washington DC, 11/11 Raleigh “Anthony D’Amato has a way with words” - Billboard Check out the official video on our website NC, 11/12 Asheville NC, 11/13 Atlanta “Needs to be played on repeat” - Refinery 29 First US tour dates going on now 10/15 San GA, 11/14 Jacksonville FL, 11/15 Panama “Turns heartbreak into cheery folk” - SPIN Francsisco, 10/17 Portland OR, 10/18 Seattle City Beach FL, 11/16 Ft. -

Right Arm Resource Update

RIGHT ARM RESOURCE UPDATE JESSE BARNETT [email protected] (508) 238-5654 www.rightarmresource.com www.facebook.com/rightarmresource 10/8/2014 Damien Rice “I Don’t Want To Change You” The first single from My Favourite Faded Fantasy, produced by Rick Rubin, in stores November 11 Over 30 stations early including WXRV, WRNR, WEZZ, KCSN, WXPN, WFUV, KCMP, WYEP, WFPK, WTMD, WDST, WEXT, WEHM, XM Loft, WUIN, WFIV, WBJB, WNRN, WMVY, KTBG, WJCU, KSUT and more Fall tour in select worldwide cities - every show sold out in minutes! US shows: 10/9 Los Angeles, 10/13 Chicago, 10/16-18 New York City, 11/15 New York City This is Damien’s first album in eight years Ray LaMontagne “She’s The One” The third single from Supernova, produced by Dan Auerbach, following up two back to back top 10 tracks Early adds at WRLT, WEHM, KUTX, WEXT, WDST, KCLC, WFIV, WTYD, KFMU, KSPN and more On tour: 10/10 Paso Robles CA, 10/11 Los Angeles, 10/12 Davis CA, 10/14-15 Oakland, 10/17 San Diego, 10/18 Santa Barbara, 10/21 Palm Desert CA, 10/22 Phoenix, 10/23 Tucson, 10/26 Shreveport, 10/27 New Orleans, 10/28 Mobile, 10/30 Macon, 10/31 Chattanooga, 11/1 Charlotte and more shows through 11/14 Ziggy Marley “Lighthouse” The second single from Fly Rasta Added early at WFIV, KSPN, KFMU, WMVY, KBAC and WOCM Special iTunes exclusive Lighthouse EP available now featuring the single along with a full band concert version and live acoustic versions of “I Get Up” and “I Don’t Want To Live On Mars” On tour now: 10/11 Hampton Beach NH, 10/12 Bridgeport CT, 10/13 Baltimore, 10/14 Newport News VA, 10/16 Myrtle Beach SC, 10/17 Atlanta, 10/18 Orlando, 10/19 Ponte Vedra Beach FL, 10/21 New Orleans.. -

AXS TV Schedule for Mon. April 4, 2016 to Sun. April 10, 2016 Monday April 4, 2016

AXS TV Schedule for Mon. April 4, 2016 to Sun. April 10, 2016 Monday April 4, 2016 4:50 PM ET / 1:50 PM PT 8:00 AM ET / 5:00 AM PT Nothing But Trailers Smart Travels Europe Sometimes the best part of the movie is the preview! So AXS TV presents Nothing But Trailers. Edinburgh & Scotland - Friendly and feisty, Scotland makes us feel right at home. In Edinburgh, See the best trailers, old and new, in AXS TV’s collection. we climb the ramparts of this city’s famous castle, shop for kilts, visit mysterious Rosslyn chapel and thrill to a spooky ghost tour. Then we head to historic St. Andrew’s to practice our swing on 5:00 PM ET / 2:00 PM PT the world’s most famous golf course. In the Scottish highlands, we try our hand at skeet shoot- Nashville ing and falconry, and tour the Dewar’s whisky distillery. Then it’s off to historic Stirling to stroll I’m Tired of Pretending - When Maddie wants to spend time with Deacon, Teddy starts to feel he’s the battlefields of Braveheart before setting sail on legendary Loch Lomond. being replaced; Lamar asks Rayna to get Tandy to commit to being a character witness; Juliette worries about Layla’s career stealing her spotlight. 8:30 AM ET / 5:30 AM PT Rick Steves’ Europe 6:00 PM ET / 3:00 PM PT Switzerland’s Great Cities - In this episode, we’ll focus on an often-overlooked side of Switzer- Only In America land: Luzern, Bern, Zurich, and Lausanne. -

AXS TV Schedule for Mon. October 23, 2017 to Sun. October 29, 2017

AXS TV Schedule for Mon. October 23, 2017 to Sun. October 29, 2017 Monday October 23, 2017 6:50 PM ET / 3:50 PM PT 8:00 AM ET / 5:00 AM PT The Big Interview Pop Profiles Sneak Peek - Rush’s Geddy Lee - A special clip previewing the upcoming premiere next week. Black Eyed Peas - Black Eyed Peas’ story is told chronologically through their major hit singles. 7:00 PM ET / 4:00 PM PT 8:30 AM ET / 5:30 AM PT The X Factor UK Rock Legends Judges Houses 1 - The competition reaches its next stage as the remaining acts jet off to the Beastie Boys - Archive material, music videos and exclusive insights from music critics tell the Judges’ Houses, where they have a final chance to make a good impression. story of the Beastie Boys, the first rap rock punk band and one of the most important alternative acts of the last 30 years. Premiere 9:00 PM ET / 6:00 PM PT 9:00 AM ET / 6:00 AM PT The X Factor UK The Big Interview The competition reaches its next stage as the remaining acts jet off to the Judges’ Houses, where Russell Simmons - He was one of the driving forces behind a big change in American culture they have a final chance to make a good impression. when he began producing hip hop music. 11:00 PM ET / 8:00 PM PT 10:00 AM ET / 7:00 AM PT Rock Legends The Big Interview Bee Gees - The Bee Gees their first record deal in 1963 with Festival Records, March 1978 saw the Weird Al Yankovic - A conversation with a comedy and music genius. -

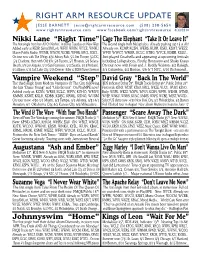

Right Arm Resource Update

RIGHT ARM RESOURCE UPDATE JESSE BARNETT [email protected] (508) 238-5654 www.rightarmresource.com www.facebook.com/rightarmresource 4/30/2014 Nikki Lane “Right Time” Cage The Elephant “Take It Or Leave It” The first single from her All Or Nothin’, in stores Tuesday on New West The second single from Melophobia Already pushing top 15 at Alt! Added early at KEXP, SiriusXM Loft, WFIV, WUIN, WYCE, WNKU, Already on: KCMP, KCSN, WERS, KLRR, KSKI, KSMT, WEZZ, Maine Public Radio, WUMB, WNCW, WCBE, WFHB, KRCL, KXCI... WFIV, WWCT, WMSR, KCLC, KTBG, WYCE, KDBB, KSLU... On tour now with The Whigs: 4/30 Asbury Park, 5/1 Jim Thorpe, 5/2 DC, Just played Coachella and appearing at upcoming festivals 5/3 Charlotte, then with Old 97s: 5/6 Tucson, 5/7 Phoenix, 5/8 Solana including Lollapalooza, Firefly, Bonnaroo and Shaky Knees Beach, 5/9 Los Angeles, 5/10 San Francisco, 5/12 Seattle, 5/13 Portland, On tour now with Foals and J. Roddy Walston: 5/2 Raleigh, 5/14 Boise, 5/15 Salt Lake City, 5/16 Denver Killer at SXSW/Sunset Sessions 5/3 Columbia, 5/4 Boston, 5/6 & 7 NYC, 5/10 Richmond... Vampire Weekend “Step” David Gray “Back In The World” The third single from Modern Vampires Of The City, following BDS Indicator Debut 29*, FMQB Tracks Debut 36*, Public Debut 26*! the hits “Diane Young” and “Unbelievers” On PlayMPE now! First week: KTHX, WDST, KTAO, KRCL, WKZE, WJCU, WUKY, KSNO... Added early at: KCSN, WRSI, KCLC, WFIV, KOHO, WMVY, Early: WXPK, WEZZ, WXPN, WFUV, KCSN, WFPK, WEHM, WTMD, KMMS, KSMT, KSLU, KDBB, KDEC, KRML, KSNO, WUSM WYEP, WNKU, WNRN, KUNC, KMMS, WAPS, WCBE, WEXT, WVOD.. -

Right Arm Resource Update

RIGHT ARM RESOURCE UPDATE JESSE BARNETT [email protected] (508) 238-5654 www.rightarmresource.com www.facebook.com/rightarmresource 10/29/2014 Tune-Yards “Real Thing” The second single from Nikki Nack, in stores now Single available in my Dropbox and hitting PlayMPE today US dates: 12/4-7 Brooklyn (12/6 Sold Out), 12/10 Los Angeles, 12/11 Oakland, 12/12 Portland, 12/13 Seattle “Nikki Nack, Garbus’ third effort, is polished, meticulously produced, and very much a studio effort.” - AV Club (rating A-) “Sonically, Nikki Nack is a joyous record which sees Gabril bursting at the seams with restless energy and tremendous creativity.” - Sputnik Music More great reviews from Pitchfork, Clash Music, Exclaim, NME and many others You+Me “You and Me” The first single from the new project from Dallas Green (City and Colour) and Alecia Moore (P!nk) #1 Most Added! First week: KCSN, WFPK, WNKU, WCBE, KROK, WZLO, KRML, WMVY, KRVM, WHRV, KSLU... Early: WEZZ, XM Loft, WJCU, WBJB, KCLC, WMWV, KNBA, WUIN, WFIV, KFMU, KSPN, KUNC, Music Choice... Full cd rose ave. in stores, 63K sold in two weeks Great press: Ellen, Kimmel, NPR Weekend Edition already “While such prominent voices rarely mix too seamlessly, Green and Moore were destined to harmonize together.” - Huffington Post The Lone Bellow The New Pornographers Anthony D’Amato “Then Came The Morning” “Dancehall Domine” “Good and Ready” The title track single from their upcoming album The second single from Brill Bruisers The first single from his New West debut Mediabase 42*, BDS Monitored New & Active New: KSMT, WNRN, KFMU, KSPN, WOCM, KDBB.. -

Final Nominations List

NATIONAL ACADEMY OF RECORDING ARTS & SCIENCES, INC. FINAL NOMINATIONS LIST THE NATIONAL ACADEMY OF RECORDING ARTS & SCIENCES, INC. Final Nominations List 57th Annual GRAMMY® Awards For recordings released during the Eligibility Year October 1, 2013 through September 30, 2014 Note: More or less than 5 nominations in a category is the result of ties. General Field Category 1 Record Of The Year Award to the Artist and to the Producer(s), Recording Engineer(s) and/or Mixer(s) and mastering engineer(s), if other than the artist. 1. FANCY Iggy Azalea Featuring Charli XCX The Arcade & The Invisible Men, producers; Anthony Kilhofler & Eric Weaver, engineers/mixers; Miles Showell, mastering engineer Track from: The New Classic [Def Jam Recordings] 2. CHANDELIER Sia Greg Kurstin & Jesse Shatkin, producers; Greg Kurstin, Manny Marroquin & Jesse Shatkin, engineers/mixers; Emily Lazar, mastering engineer Track from: 1000 Forms Of Fear [RCA Records / Monkey Puzzle Records] 3. STAY WITH ME (DARKCHILD VERSION) Sam Smith Steve Fitzmaurice, Rodney Jerkins & Jimmy Napes, producers; Steve Fitzmaurice, Jimmy Napes & Steve Price, engineers/mixers; Tom Coyne, mastering engineer [Capitol Records] 4. SHAKE IT OFF Taylor Swift Max Martin & Shellback, producers; Serban Ghenea, John Hanes, Sam Holland & Michael Ilbert, engineers/mixers; Tom Coyne, mastering engineer [Big Machine Records] 5. ALL ABOUT THAT BASS Meghan Trainor Kevin Kadish, producer; Kevin Kadish, engineer/mixer; Dave Kutch, mastering engineer [Epic Records] © The Recording Academy 2014 - all rights reserved 1 Not for copy or distribution 57th Finals - Press List General Field Category 3 Category 4 Song Of The Year Best New Artist A Songwriter(s) Award. A song is eligible if it was first released or For a new artist who releases, during the eligibility year, the first if it first achieved prominence during the Eligibility Year. -

2018 Sspa Officers, Directors, Trustees & Members

SOUTH SHORE MUSIC CIRCUS 2 CAPE COD MELODY TENT 2018 SSPA OFFICERS, DIRECTORS, TRUSTEES & MEMBERS PRESIDENT DIRECTORS TRUSTEES Bruce T. Cameron Jason R. Cameron & MEMBERS Kurt DeVries * Roger Good VICE PRESIDENT John J. Hayes, III Kevin Leddy & CLERK N. Frank Neer Joy P. Schiffmann Richard L. Evans Meg Nelson Thomas D. Shipp Tina Watson TREASURER Brian S. Noble Susan Weisenfluh Robert C. Jordan, Jr. Jeffrey C. Pratt * Elizabeth A. Sullivan Rebecca J. Synnestvedt *Chairmen of Community Trust SOUTH SHORE MUSIC CIRCUS 3 CAPE COD MELODY TENT SOUTH SHORE MUSIC CIRCUS 4 CAPE COD MELODY TENT From The EXECUTIVE PRODUCER… Welcome In our 70 year history, we’ve seen quite an evolution in the live music and recording industries. Cassettes and CDs have come and gone, digital downloads had their heyday, concerts have become multi-media events, and conglomerates have formed. In the midst of industry upheaval, we’ve continued to be the heart of our communities, offering not only world-class live entertainment but a constant gathering place for friends and families. Home is where your heart is. We’re pleased to welcome back many performers who consider our venues not just a stop on tour but a home away from home. Lee Brice, Melissa Etheridge, Jake Owen, Boz Scaggs are just a few of the many returning performers under the tents this summer. We hope to become a summer home to some of the new faces of the 2018 season including Chris Janson, Little River Band and Peter Cetera. We’d like to thank our patrons for keeping their money where their heart is. -

Smirnoff Dream Weekend Rocks Negril Smirnoff

HospitalityThe Gleaner Jamaica KEEPING YOU CONNECTED TO THE BUSINESS OF TOURISM WEDNESDAY, AUGUST 6, 2014 Smirnoff Dream Weekend rocksSmirnoffSmirnoffSmirnoffSmirnoffSmirnoff Negril Smirnoff Dream Weekend rocksDreamDreamDreamDreamDream Negril Smirnoff Dream Weekend rocksWeekendWeekendWeekendWeekendWeekend Negril Smirnoff Dream Weekend rocks Negril Smirnoff Dream Weekend rocksROCKSROCKSROCKSROCKSROCKS Negril Smirnoff Dream Weekend rocksNEGRILNEGRIL Negril ERA NEGRILNEGRILNEGRIL ANET SILV NEGRIL Smirnoff Dream WeekendPHOTO BY J rocks Negril SmirnoffThe crowd at the Xtreme Wet andDream Wild at the Kool Runnings Weekend Waterpark in Negril on Sunday, August rocks 3. Negril Shinton Dixon Caribbean SmirnoffSandals Montego Dream WeekendAirlines – the rocks Negril Bay’s shining star official carrier Page 6 of CPL T20 Smirnoff Dream WeekendPage 9 rocks Negril SmirnoffINSIDE Dream Weekend rocks Negril THE BUSINESS OF TOURISM Tourism-related casino gambling ... Is this the light at the end of the tunnel? Something seems to be highly amusing as CNN anchor in New David Jessop report and others is that the York, Michaela Pereira, and Minister of Tourism and Entertainment Contributor demographic for casino Dr Wykeham McNeill flip through a copy of ‘Jamaica Heritage in gambling is gradually changing ASINOS ARE fast Pictures’, produced by the Jamaica National Heritage Trust. McNeill and the trend appears to bear becoming a major part of some relation to the new presented the book to Pereira as a gift when she paid him a Cthe new tourism offering courtesy call at Half Moon, A Rock Resort, on Saturday, July 19. younger or retired higher- across the Caribbean, despite spending category of visitors She was in the island to trace her genealogical roots in Cambridge, local objections from religious that tourist boards and hoteliers St James, Jamaica.