L'enjeu De La Connaissance

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Bibliography of Erik Wilde

dretbiblio dretbiblio Erik Wilde's Bibliography References [1] AFIPS Fall Joint Computer Conference, San Francisco, California, December 1968. [2] Seventeenth IEEE Conference on Computer Communication Networks, Washington, D.C., 1978. [3] ACM SIGACT-SIGMOD Symposium on Principles of Database Systems, Los Angeles, Cal- ifornia, March 1982. ACM Press. [4] First Conference on Computer-Supported Cooperative Work, 1986. [5] 1987 ACM Conference on Hypertext, Chapel Hill, North Carolina, November 1987. ACM Press. [6] 18th IEEE International Symposium on Fault-Tolerant Computing, Tokyo, Japan, 1988. IEEE Computer Society Press. [7] Conference on Computer-Supported Cooperative Work, Portland, Oregon, 1988. ACM Press. [8] Conference on Office Information Systems, Palo Alto, California, March 1988. [9] 1989 ACM Conference on Hypertext, Pittsburgh, Pennsylvania, November 1989. ACM Press. [10] UNIX | The Legend Evolves. Summer 1990 UKUUG Conference, Buntingford, UK, 1990. UKUUG. [11] Fourth ACM Symposium on User Interface Software and Technology, Hilton Head, South Carolina, November 1991. [12] GLOBECOM'91 Conference, Phoenix, Arizona, 1991. IEEE Computer Society Press. [13] IEEE INFOCOM '91 Conference on Computer Communications, Bal Harbour, Florida, 1991. IEEE Computer Society Press. [14] IEEE International Conference on Communications, Denver, Colorado, June 1991. [15] International Workshop on CSCW, Berlin, Germany, April 1991. [16] Third ACM Conference on Hypertext, San Antonio, Texas, December 1991. ACM Press. [17] 11th Symposium on Reliable Distributed Systems, Houston, Texas, 1992. IEEE Computer Society Press. [18] 3rd Joint European Networking Conference, Innsbruck, Austria, May 1992. [19] Fourth ACM Conference on Hypertext, Milano, Italy, November 1992. ACM Press. [20] GLOBECOM'92 Conference, Orlando, Florida, December 1992. IEEE Computer Society Press. http://github.com/dret/biblio (August 29, 2018) 1 dretbiblio [21] IEEE INFOCOM '92 Conference on Computer Communications, Florence, Italy, 1992. -

Internet Hall of Fame Announces 2013 Inductees

Internet Hall of Fame Announces 2013 Inductees Influential engineers, activists, and entrepreneurs changed history through their vision and determination Ceremony to be held 3 August in Berlin, Germany [Washington, D.C. and Geneva, Switzerland -- 26 June 2013] The Internet Society today announced the names of the 32 individuals who have been selected for induction into the Internet Hall of Fame. Honored for their groundbreaking contributions to the global Internet, this year’s inductees comprise some of the world’s most influential engineers, activists, innovators, and entrepreneurs. The Internet Hall of Fame celebrates Internet visionaries, innovators, and leaders from around the world who believed in the design and potential of an open Internet and, through their work, helped change the way we live and work today. The 2013 Internet Hall of Fame inductees are: Pioneers Circle – Recognizing individuals who were instrumental in the early design and development of the Internet: David Clark, David Farber, Howard Frank, Kanchana Kanchanasut, J.C.R. Licklider (posthumous), Bob Metcalfe, Jun Murai, Kees Neggers, Nii Narku Quaynor, Glenn Ricart, Robert Taylor, Stephen Wolff, Werner Zorn Innovators – Recognizing individuals who made outstanding technological, commercial, or policy advances and helped to expand the Internet’s reach: Marc Andreessen, John Perry Barlow, Anne-Marie Eklund Löwinder, François Flückiger, Stephen Kent, Henning Schulzrinne, Richard Stallman, Aaron Swartz (posthumous), Jimmy Wales Global Connectors – Recognizing individuals from around the world who have made significant contributions to the global growth and use of the Internet: Karen Banks, Gihan Dias, Anriette Esterhuysen, Steven Goldstein, Teus Hagen, Ida Holz, Qiheng Hu, Haruhisa Ishida (posthumous), Barry Leiner (posthumous), George Sadowsky “This year’s inductees represent a group of people as diverse and dynamic as the Internet itself,” noted Internet Society President and CEO Lynn St. -

Histories-Of-The-Internet-And-The-Web LIVING BOOKS ABOUT HISTORY

Histoires de l’Internet et du Web : Introduction Valérie Schafer, Alexandre Serres To cite this version: Valérie Schafer, Alexandre Serres. Histoires de l’Internet et du Web : Introduction. His- toires de l’Internet et du Web, Infoclio.ch, 2016, Living Books about History, 978-3-906817-10-1. 10.13098/infoclio.ch-lb-0006. hal-02529993 HAL Id: hal-02529993 https://hal.archives-ouvertes.fr/hal-02529993 Submitted on 8 Apr 2020 HAL is a multi-disciplinary open access L’archive ouverte pluridisciplinaire HAL, est archive for the deposit and dissemination of sci- destinée au dépôt et à la diffusion de documents entific research documents, whether they are pub- scientifiques de niveau recherche, publiés ou non, lished or not. The documents may come from émanant des établissements d’enseignement et de teaching and research institutions in France or recherche français ou étrangers, des laboratoires abroad, or from public or private research centers. publics ou privés. LIVING BOOKS ABOUT HISTORY VALÉRIE SCHAFER & ALEXANDRE SERRES HISTOIRES DE L’INTERNET ET DU WEB « Il existe une demi-douzaine de livres sur Internet, écrits par des gens qui n’étaient pas là quand il a été développé. On est tenté de commencer un ouvrage sur le sujet par la vieille remarque : “Tout ce que vous savez est faux !” » (Jacques Vallée, Au cœur d’Internet, Balland, 2004, p. 20). Il y a tout juste cinquante ans, en 1966, Charles Herzfeld débloquait à l’Advanced Research Projects Agency les financements qui permettront au département de l’IPTO (Information Processing Techniques -

Final List of Participants (Prepcom 3)

Final list of participants (PrepCom 3) 1) STATES AND EUROPEAN COMMUNITY Algeria Representatives: H.E. Mr Idriss JAZAIRY, Ambassadeur/Représentant Permanent, Delegation Of Algeria, [email protected] Mr Said CHABANI, Representative, Delegation of Algeria, - Ms Amina MESDOUA, Representative, Delegation of Algeria, - Mr Mahieddine OUHADJ, Directeur, Ministère de la poste et des technologies de l'information et de la communication, mission.algerie@mission- algerie.ch Mr Boualem SEDKI, Ministre Plénipotentiaire, Delegation Of Algeria, [email protected] Andorra Representatives: Ms Cristina RICO, Desk Officer, Delegation Of Andorra, [email protected] Angola Representatives: H.E. Mr Arcanjo DO NASCIEMENTO, Ambassador, Delegation of Angola, - H.E. Mr Licino RIBEIRO, Representative, Delegation of Angola, - H.E. Mr Pedro Sebastião TETA, Vice-ministre de la Science et Technologie, Ministère de la Science et Technologie Mr Viera BEMBO, Representative, Delegation of Angola, - Mr Joaquim PEDRO, Chef de la Section de Relations Publiques du MCT, Ministère des Postes et Télécommunications, E-mail not provided Mr Aristide SAFECA, Directeur National des Télécommunications, Ministère des Postes et Télécommunications, E-mail not provided Mr Pedro SALES, Representative, Delegation of Angola, - Mr José Manuel BEIRÃO, Directeur Général de l'Institut National de Communications, INACOM-MCT, Institut National de Communications, INACOM-MCT, - Dr António Pedro BENGE, Director do Gabinete de Intercambio Internacional, Delegation -

The Amateur Computerist Gathers an Article Was Written and Published in the Some Documents from That Celebration

The Amateur Comp u terist http://www.ais.org/~jrh/acn/ Summer 2008 ‘Across the Great Wall’ Volume 16 No. 2 2007. Participating were international Internet pio- Celebration neers, representatives of the Internet in China and The First Email Message from China to CSNET historians and journalists. From 1983 to 1987, two teams of scientists and engineers worked to overcome the technical, financial, and geographic obstacles to set up an email connection between China and the interna- tional CSNET. One team was centered around Werner Zorn at Karlsruhe University in the Federal Republic of Germany. The other team was under the general guidance of Wang Yuenfung at the In- stitute for Computer Applications (ICA) in the Peo- ple’s Republic of China. The project succeeded based on the scientific and technical skill and friendship, resourcefulness and dedication of the members of both teams. The first successful email message was sent on Sept 20, 1987 from Beijing to computer scien- tists in Germany, the U.S. and Ireland. The China- CSNET connection was granted official recogni- tion and approval on Nov 8 1987 when a letter (Composed 14 Sept 1987, sent 20 Sept 1987) signed by the Director of the U.S. National Science Foundation Division of Networking and Commu- A celebration of the 20th anniversary of the nications Research and Infrastructure Stephen first email message that was sent from China to the Wolff was forwarded to the head of the Chinese world via the international Computer Science Net- delegation, Yang Chuquan at an International work (CSNET) was held at the Hasso Plattner In- Networkshop in the U.S. -

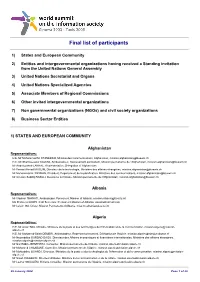

Final List of Participants

Final list of participants 1) States and European Community 2) Entities and intergovernmental organizations having received a Standing invitation from the United Nations General Assembly 3) United Nations Secretariat and Organs 4) United Nations Specialized Agencies 5) Associate Members of Regional Commissions 6) Other invited intergovernmental organizations 7) Non governmental organizations (NGOs) and civil society organizations 8) Business Sector Entities 1) STATES AND EUROPEAN COMMUNITY Afghanistan Representatives: H.E. Mr Mohammad M. STANEKZAI, Ministre des Communications, Afghanistan, [email protected] H.E. Mr Shamsuzzakir KAZEMI, Ambassadeur, Representant permanent, Mission permanente de l'Afghanistan, [email protected] Mr Abdelouaheb LAKHAL, Representative, Delegation of Afghanistan Mr Fawad Ahmad MUSLIM, Directeur de la technologie, Ministère des affaires étrangères, [email protected] Mr Mohammad H. PAYMAN, Président, Département de la planification, Ministère des communications, [email protected] Mr Ghulam Seddiq RASULI, Deuxième secrétaire, Mission permanente de l'Afghanistan, [email protected] Albania Representatives: Mr Vladimir THANATI, Ambassador, Permanent Mission of Albania, [email protected] Ms Pranvera GOXHI, First Secretary, Permanent Mission of Albania, [email protected] Mr Lulzim ISA, Driver, Mission Permanente d'Albanie, [email protected] Algeria Representatives: H.E. Mr Amar TOU, Ministre, Ministère de la poste et des technologies -

Histories of the Internet and the Web

LIVING BOOKS ABOUT HISTORY VALÉRIE SCHAFER & ALEXANDRE SERRES HISTORIES OF THE INTERNET AND THE WEB “There are half a dozen books on the Internet in existence, written by people who were not there when it was developed. It is tempting to begin a piece of work on the subject by quoting the old adage: ‘ Everything you know is wrong!’” (Jacques Vallée, Au Coeur d’Internet, Balland, 2004, p. 20). Just fifty years ago, in 1966, Charles Herzfeld released to the Advanced Research Projects Agency the funds which would allow the IPTO department (Information Processing Techniques Office) to launch the Arpanet project; twenty-five years ago, in 1991, the British computer scientist Tim Berners-Lee announced the invention of the Web on line in Newsgroups - the discussion 1 forums of the Usenet community ; twenty years ago, in 1996, Brewster Kahle founded Internet Archive, an organisation whose stated aim was to archive the World Wide Web... The history of the Internet is a recent one, focused on a permanently-moving object that is neither 2 finished nor fixed . This history must also confront the living memories of those involved, and the way this innovation is viewed by contemporary society – for many people it is the embodiment of the “digital revolution” – as well as the more or less wide definitions of its limits. So as not to discriminate between the different meanings and approaches to the Internet and its history, this anthology reports on a variety of historiographical trends and research work. Some of them limit their frame of reference to the network of networks and its protocol aspects. -

Lehigh Preserve Institutional Repository

Lehigh Preserve Institutional Repository Binary Freedom: Free Software, the Internet, and Activism in the Digital Age Campbell, Christopher Bryan 2016 Find more at https://preserve.lib.lehigh.edu/ This document is brought to you for free and open access by Lehigh Preserve. It has been accepted for inclusion by an authorized administrator of Lehigh Preserve. For more information, please contact [email protected]. Binary Freedom: Free Software, the Internet, and Activism in the Digital Age By Christopher Bryan Campbell A Thesis Presented to the Graduate and Research Committee of Lehigh University in Candidacy for the Degree of Master of Arts in History Lehigh University May 23, 2016 © 2016 Copyright Christopher Bryan Campbell ii Thesis is accepted and approved in partial fulfillment of the requirements for the Master of Arts in History. Binary Freedom: Free Software, the Internet, and Activism in the Digital Age Christopher Bryan Campbell ______________________________ Date Approved ______________________________ Dr. John K. Smith Thesis Director ______________________________ Dr. Stephen Cutcliffe Co-Director ______________________________ Dr. John K. Smith Department Chair iii TABLE OF CONTENTS Abstract 1 Introduction 2 The Closing of the Source Code 7 GNU, the Free Software Movement and the Hacker Ethic 13 Free Software and the Internet 22 Open Source & the Commercialization of the Free Software Movement 28 The Fracturing of the Movement 35 Free Software Consumers 40 The Digital Millennium Copyright Act and the Rise of Internet Activism 45 Conclusion 53 Bibliography: 55 Vita 62 iv TABLE OF FIGURES Figure 1. Web Server Market Share by Year 26 v ABSTRACT In the 1970s, software emerged as a distinct industry as it became unbundled from computer hardware. -

List of Participants

List of participants 1) States and European Community 2) Entities and intergovernmental organizations having received a Standing invitation from the United Nations General Assembly 3) United Nations Secretariat and Organs 4) United Nations Specialized Agencies 6) Other invited intergovernmental organizations 7) Non governmental organizations (NGOs) and civil society organizations 8) Business Sector Entities 1) STATES AND EUROPEAN COMMUNITY Afghanistan Representatives: Mr Omar Mansoor ANSARI, Representative, Delegation of Afghanistan, - Albania Representatives: Mr Vladimir THANATI, Ambassador, Delegation Of Albania, [email protected] Ms Pranvera GOXHI, First Secretary, Delegation Of Albania, [email protected] Algeria Representatives: H.E. Mr Idriss JAZAIRY, Ambassadeur/représentant permanent, Delegation of Algeria, [email protected] Mr Boualem SEDKI, Ministre plénipotentiaire, Delegation of Algeria, [email protected] Mr Said CHABANI, Representative, Delegation of Algeira, - Andorra Representatives: H.E. Mr Francesc BONET CASAS, Ambassador, Permanent Mission of Andorra, [email protected] Mr Iolanda NADAL, Attaché, Permanent Mission of Andorra, [email protected] Ms Cristina RICO, Desk Officer, Delegation of Andorra, [email protected] Mr Xavier TROTA-BOLLO, Third Secretary, Permanent Mission of Andorra, [email protected] Angola Representatives: Mr Amadeu Leitao NUNES, Representative, Delegation of Angola, - Mr Camilo BUANGA, Representative, Delegation of Angola, - Mr Manuel NETO, Representative, Delegation of Angola, - 07 March 2005 Page 1 of 60 Argentina Representatives: H.E. Ms Ileana DI GIOVAN BATTISTA, Ambassador, Delegation of Argentina, [email protected] Mr Marcelo VALLE FONROUGE, Minister, Delegation of Argentina, [email protected] Mr Enrique VACA NARVAJA, Secretary Of Embassy, Delegation Of Argentina, [email protected] Dr Andrea REPETTI, Secretary of Embassy, Delegation of Argentina, [email protected] Armenia Representatives: H.E. -

The European Researchers' Network

The European Researchers’ Network Francois Fluckiger CERN, Geneva Published in La Recherche, Issue number 328, February 2000 “Special Internet, l’Avenir du Web” In the middle of the 1980s, most European countries did not dispose of any operational network. Whilst Governments (States) and the major computer manufacturers negotiate, public research computer scientists adopt the Internet technology. Without explicit mandates from their organisations, they deploy it, spreading it out all over, and ten years later, the door is opened to the private sector. François In spite of what has often science resources? In the United States, Fluckiger been said, the Internet is not the Arpanet network, set up in 1969, is, at the time of this a positive product of links universities and laboratories that article is published, in unconstrained liberalism, collaborate in research projects of the charge of the CERN nor a product of the Department of Defense. (See article by Web Services in imagination of private Jean-Claude Guédon p. 16.) But the Geneva. He is also enterprise which is free of technology used at that time to transport adjunct professor at the the straightjacket of data is not the one we know today – University of Geneva, member of the Advisory autocratic policy; neither “TCP/IP” technology will be introduced Council of the Internet could have accomplished into Arpanet only in 1983. What can Society (ISOC) and something that both researchers do with this network? expert for the European Governments and major Exchange electronic messages, transfer Commission. institutions had failed to files from one computer to another and achieve. -

Source Book on Digital Libraries

Source Book on Digital Libraries Version 1.0 December 6, 1993 Prepared for and Sponsored by the National Science Foundation Directorate for Computer and Information Science and Engineering (CISE) Division of Information, Robotics and Intelligent Systems (IRIS) Covering a series of NSF Invitational Workshops and Related Information Edward A. Fox, Editor ([email protected]) (C) Copyright 1993 Edward A. Fox and Virginia Tech Preface This report has its origins in discussions Mike Lesk and I had in October 1991, in connection with an NSF-sponsored workshop. With Mike McGill we drafted a White Paper, calling for a National Electronic Science, Engineering, and Technology Library. Since then, many things have changed. Now, the term “Digital Library” is more in vogue than “Electronic Library,” though one might also call it a hypermedia archive or a data/information/knowledge base. Regardless of the name, the intent is clear. Step one is for NSF to play a lead role in launching a concerted R&D program in the area. This is essential, so that any large scale development efforts by the Federal Government, along with state and private agencies, will be sensibly coordinated and undertaken in the most cost-effective and timely manner possible. We hope this initiative will begin in 1993, and proceed into the 21st Century. We feel that it must focus on large scale proto- types, and on setting the stage for a new, open, task-oriented, computer-assisted, type of access to information. Step two involves partnerships, cooperative ventures, and production conversion of back- archives. ARPA, NASA, NIST, Library of Congress, NLM, NAL, and many other groups must become involved if we are to serve the broad base of users, from kindergarten to Nobel laureate researchers. -

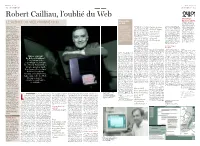

Suite Et Fin Dans Le Soir

Le Soir Lundi 30 juillet 2018 Le Soir Lundi 30 juillet 2018 12 SÉRIED’ÉTÉ SÉRIED’ÉTÉ 13 Robert Cailliau, l’oublié du WebW L’hommage L’évangéliste du Soir à 24h01 L’aventure a duré cinq ans. LE SILENCE DU VIEIL HOMME (1/3) du Web D’octobre 2013 à juin 2018, Né à Tongres en 1947, la revue 24h01 a marqué le Depuis plusieurs mois, Robert Cailliau est un ingé- perposition 2D de trois « W » (l’ancêtre d’Internet Explorer, Sa- paysage médiatique belge en Quentin Jardon (journaliste nieur belge spécialisé en verts. Pourquoi verts ? Depuis Enfin, le jour fari ou Google Chrome). Il déve- publiant, chaque trimestre, de 24h01) cherche un informatique. Le Cern l’en- toujours, Robert souffre d’une loppe le langage HTML pour 130 pages de récit journalis- homme qui fuit les journa- gage en 1974 pour améliorer forme modérée de synesthésie, de Noël 1990, écrire des pages contenant des tique et de photojourna- listes, refuse toute sollicita- le système de contrôle d’un phénomène neurologique par le- hyperliens et fait appel au proto- lisme. Faute de moyens tion. Les quelques articles de accélérateur de particules. quel, dans son esprit, chaque Tim donne cole de communication HTTP financiers, 24h01 cesse ses presse à son sujet divergent. À partir de 1990, il y déve- lettre est associée à une couleur pour que navigateurs et serveurs activités. Par solidarité, Le On le présente tantôt loppe avec Tim Berners-Lee différente. Dans son alphabet bi- naissance Web puissent communiquer. Il Soir ouvre cette semaine ses comme l’inventeur du Web, une invention qui va propul- garré, le « W » a hérité du vert.