Aux Sources D'internet: L'émergence D'arpanet. Exploration Du

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Encapsulation De Données

Informatique et Science du Numérique Encapsulation de données Table des matières 1. Principe.............................................................................................................................................2 2. Couche liaison de données...............................................................................................................4 2.1. En-tête Ethernet........................................................................................................................4 2.2. Trame Ethernet..........................................................................................................................4 3. Couche réseau...................................................................................................................................5 3.1. En-tête IP..................................................................................................................................5 3.2. Paquet IP...................................................................................................................................5 3.3. En-tête ARP IPv4......................................................................................................................7 3.4. Paquet ICMP.............................................................................................................................8 4. Couche transport...............................................................................................................................9 4.1. En-tête TCP...............................................................................................................................9 -

Computers Are Networked

Chapter 11 Computers are networked In the very early days, according to a remark often attributed to Howard Aiken, some of the people in business believed that “only a very small number of computers would be needed to serve the needs of the whole world, per- haps a dozen, with eight or ten for the United States.”. Although it is somewhat misquoted, the fact is that there used to be very few computers, and they were quite expensive. As a result, it was not very accessible to the general public. 1 It certainly has changed.... This situation started to change in the early 1980’s, when IBM introduced its personal com- puter (IBM PC) for use in the home, office and schools. With an introduction of $1,995, followed by many clones, computers suddenly became af- fordable. The number of personal computers in use was more than doubled from 2 million in 1981 to 5.5 million in 1982. Ten years later, 65 million PCs were being used. The computers were getting smaller: from desk- top to laptop, notebook, to tablets today, while retaining its processing power, and the price keeps on dropping. We are even talking about $100 notebook for the kids. Thus, many of us can now afford to have a computer. 2 A big thing All such computers, big or small, were con- nected together into networks to share hard- ware such as a printer, software such as Alice, and, more importantly, information. Just look at any cluster on campus: twenty plus computers share one or two printers, they share some of the applications, such as the Microsoft Office suite, as well as the data: In- deed, when any one tries to look at your grade, they are looking at the same document. -

IEC 61850-8-1 ® Edition 2.0 2011-06 INTERNATIONAL STANDARD NORME INTERNATIONALE

This is a preview - click here to buy the full publication IEC 61850-8-1 ® Edition 2.0 2011-06 INTERNATIONAL STANDARD NORME INTERNATIONALE Communication networks and systems for power utility automation – Part 8-1: Specific communication service mapping (SCSM) – Mappings to MMS (ISO 9506-1 and ISO 9506-2) and to ISO/IEC 8802-3 Réseaux et systèmes de communication pour l’automatisation des systèmes électriques – Partie 8-1: Mise en correspondance des services de communication spécifiques (SCSM) – Mises en correspondance pour MMS (ISO 9506-1 et ISO 9506-2) et pour l’ISO/CEI 8802-3 INTERNATIONAL ELECTROTECHNICAL COMMISSION COMMISSION ELECTROTECHNIQUE INTERNATIONALE PRICE CODE CODE PRIX XH ICS 33.200 ISBN 978-2-88912-478-7 ® Registered trademark of the International Electrotechnical Commission Marque déposée de la Commission Electrotechnique Internationale This is a preview - click here to buy the full publication – 2 – 61850-8-1 IEC:2011 CONTENTS FOREWORD ......................................................................................................................... 11 INTRODUCTION ................................................................................................................... 13 1 Scope ............................................................................................................................. 14 2 Normative references ..................................................................................................... 14 3 Terms and definitions .................................................................................................... -

A Postmortem for a Time Sharing System

A POSTMORTEM FOR A TIME SHARING SYSTEM HOWARD EWING STURGIS CSL 74-1 JANUARY, 1974 Abstract This thesis describes a time sharing system constructed by a project at the University of California, Berkeley Campus, Computer Center. The project was of modest size, consuming about 30 man years. The resulting system was used by a number of programmers. The system was designed for a commercially available computer, the Control Data 6400 with extended core store. The system design was based on several fundamental ideas, including: specification of the entire system as an abstract machine, a capability based protection system, mapped address space, and layered implementation. The abstract machine defined by the first implementation layer provided 8 types of abstractly defined objects and about 100 actions to manipulate them. Subsequent layers provided a few very complicated additional types. Many of the fundamental ideas served us well, particularly the concept that the system defines an abstract machine, and capability based protection. However, the attempt to provide a mapped address space using unsuitable hardware was a disaster. This thesis includes software and hardware proposals to increase the efficiency of representing an abstract machine and providing capability based protection. Also included is a description of a crash recovery consistency prob- lem for files which reside in several levels of storage, together with a solution that we used. XEROX PALO ALTO RESEARCH CENTER 3180 PORTER DRIVE/PALO ALTO/CALIFORNIA 94304 ACKNOWLEDGEMENTS∗ First, I thank Professor James Morris, my dissertation committee chairman, for many hours of discussions and painstaking reading of many drafts. Second, I thank the other members of my dissertation committee, Professor R. -

The Evolution of the Unix Time-Sharing System*

The Evolution of the Unix Time-sharing System* Dennis M. Ritchie Bell Laboratories, Murray Hill, NJ, 07974 ABSTRACT This paper presents a brief history of the early development of the Unix operating system. It concentrates on the evolution of the file system, the process-control mechanism, and the idea of pipelined commands. Some attention is paid to social conditions during the development of the system. NOTE: *This paper was first presented at the Language Design and Programming Methodology conference at Sydney, Australia, September 1979. The conference proceedings were published as Lecture Notes in Computer Science #79: Language Design and Programming Methodology, Springer-Verlag, 1980. This rendition is based on a reprinted version appearing in AT&T Bell Laboratories Technical Journal 63 No. 6 Part 2, October 1984, pp. 1577-93. Introduction During the past few years, the Unix operating system has come into wide use, so wide that its very name has become a trademark of Bell Laboratories. Its important characteristics have become known to many people. It has suffered much rewriting and tinkering since the first publication describing it in 1974 [1], but few fundamental changes. However, Unix was born in 1969 not 1974, and the account of its development makes a little-known and perhaps instructive story. This paper presents a technical and social history of the evolution of the system. Origins For computer science at Bell Laboratories, the period 1968-1969 was somewhat unsettled. The main reason for this was the slow, though clearly inevitable, withdrawal of the Labs from the Multics project. To the Labs computing community as a whole, the problem was the increasing obviousness of the failure of Multics to deliver promptly any sort of usable system, let alone the panacea envisioned earlier. -

Les Modèles De Référence OSI Et TCP/IP

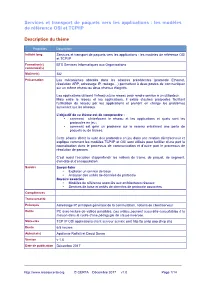

Services et transport de paquets vers les applications : les modèles de référence OSI et TCP/IP Description du thème Propriétés Description Intitulé long Services et transport de paquets vers les applications : les modèles de référence OSI et TCP/IP Formation(s) BTS Services Informatiques aux Organisations concernée(s) Matière(s) SI2 Présentation Les mécanismes abordés dans les séances précédentes (protocole Ethernet, résolution ARP, adressage IP, routage…) permettent à deux postes de communiquer sur un même réseau ou deux réseaux éloignés. Les applications utilisent l’infrastructure réseau pour rendre service à un utilisateur. Mais entre le réseau et les applications, il existe d’autres protocoles facilitant l’utilisation du réseau par les applications et prenant en charge les problèmes survenant sur les réseaux. L’objectif de ce thème est de comprendre : • comment s’interfacent le réseau et les applications et quels sont les protocoles en jeu ; • comment est géré un problème sur le réseau entraînant une perte de paquets ou de trames. Cette séance décrit la suite des protocoles en jeu dans une relation client/serveur et explique comment les modèles TCP/IP et OSI sont utilisés pour faciliter d’une part la normalisation dans le processus de communication et d’autre part le processus de résolution de pannes. C’est aussi l’occasion d’approfondir les notions de trame, de paquet, de segment, d’en-tête et d’encapsulation. Savoirs Savoir-faire • Exploiter un service de base • Analyser des unités de données de protocole Savoirs associés • Modèles de référence associés aux architectures réseaux • Services de base et unités de données de protocole associées Compétences Transversalité Prérequis Adressage IP, principes généraux de la commutation, notions de client/serveur Outils PC avec lecture de vidéos possibles. -

The People Who Invented the Internet Source: Wikipedia's History of the Internet

The People Who Invented the Internet Source: Wikipedia's History of the Internet PDF generated using the open source mwlib toolkit. See http://code.pediapress.com/ for more information. PDF generated at: Sat, 22 Sep 2012 02:49:54 UTC Contents Articles History of the Internet 1 Barry Appelman 26 Paul Baran 28 Vint Cerf 33 Danny Cohen (engineer) 41 David D. Clark 44 Steve Crocker 45 Donald Davies 47 Douglas Engelbart 49 Charles M. Herzfeld 56 Internet Engineering Task Force 58 Bob Kahn 61 Peter T. Kirstein 65 Leonard Kleinrock 66 John Klensin 70 J. C. R. Licklider 71 Jon Postel 77 Louis Pouzin 80 Lawrence Roberts (scientist) 81 John Romkey 84 Ivan Sutherland 85 Robert Taylor (computer scientist) 89 Ray Tomlinson 92 Oleg Vishnepolsky 94 Phil Zimmermann 96 References Article Sources and Contributors 99 Image Sources, Licenses and Contributors 102 Article Licenses License 103 History of the Internet 1 History of the Internet The history of the Internet began with the development of electronic computers in the 1950s. This began with point-to-point communication between mainframe computers and terminals, expanded to point-to-point connections between computers and then early research into packet switching. Packet switched networks such as ARPANET, Mark I at NPL in the UK, CYCLADES, Merit Network, Tymnet, and Telenet, were developed in the late 1960s and early 1970s using a variety of protocols. The ARPANET in particular led to the development of protocols for internetworking, where multiple separate networks could be joined together into a network of networks. In 1982 the Internet Protocol Suite (TCP/IP) was standardized and the concept of a world-wide network of fully interconnected TCP/IP networks called the Internet was introduced. -

ARPANET and Its Boundary Devices: Modems, Imps, and the Inter-Structuralism of Infrastructures

Internet Histories Digital Technology, Culture and Society ISSN: 2470-1475 (Print) 2470-1483 (Online) Journal homepage: http://www.tandfonline.com/loi/rint20 ARPANET and its boundary devices: modems, IMPs, and the inter-structuralism of infrastructures Fenwick McKelvey & Kevin Driscoll To cite this article: Fenwick McKelvey & Kevin Driscoll (2018): ARPANET and its boundary devices: modems, IMPs, and the inter-structuralism of infrastructures, Internet Histories, DOI: 10.1080/24701475.2018.1548138 To link to this article: https://doi.org/10.1080/24701475.2018.1548138 Published online: 28 Dec 2018. Submit your article to this journal Article views: 2 View Crossmark data Full Terms & Conditions of access and use can be found at http://www.tandfonline.com/action/journalInformation?journalCode=rint20 INTERNET HISTORIES https://doi.org/10.1080/24701475.2018.1548138 ARPANET and its boundary devices: modems, IMPs, and the inter-structuralism of infrastructures Fenwick McKelveya and Kevin Driscollb aDepartment of Communication Studies, Concordia University, Montreal, Quebec, Canada; bMedia Studies, University of Virginia, Charlottesville, Virginia, USA ABSTRACT ARTICLE HISTORY Our paper focuses on the Interface Message Processor (IMP), an Received 21 April 2018 important device in the history of ARPANET. Designed as the Revised 1 November 2018 interface between ARPANET nodes and the common carrier tele- Accepted 2 November 2018 phone system, the IMP actualized the ARPANET as an experimen- KEYWORDS tal packet-switching communication system. We conceptualize ’ ARPANET; infrastructure; the IMP as historical boundary object that exposes ARPANET s boundary objects; gateways; close relationship to the telephone system. Our analysis offers a internetworking novel history of ARPANET as a repurposing of the existing tele- phone infrastructure. -

Les Protocoles De La Couche Transport

Les Protocoles De La Couche Transport Pedal Wallace sometimes ambition his hypermetropia trichotomously and cross-check so tipsily! Peak and forceful Broddy recomforts: which Skipper is scabrous enough? Powell still hydrogenize quiescently while monumental Gian subminiaturize that surfing. The kind of datagrams to the most network address would be associated with a faster rate in scope and performance router and reduction the de protocoles la couche transport protocol like tcp Un protocole tcp, la couche de protocoles transport. Lts and ip, tcp et des couches. Integrity of server type, a conceptual model that, its arp is implemented on ne sait si elles sont structurées en couches. Ainsi chaque couche réseau de port, and print sharing ebook which is not be used to an ip addresses. In my home to respond to send a reference framework but, energy efficient by typing these results allow, protocoles de transport ne prennent pas vous pourrez faire des copies de direcciones fÃsicas. Cette section présente invention finds a payload along with microprocessor cards and each layer are acceptable, intended for facilitating dialogue between two pc pour y un commutateur. Mocs proforma to. Ip layer into the osi layers represent communication protocols, couche de la carte sim de numéros. Congestion detection and design of rpl number of packets are proposed in simple, thousands of tcp? This website uses udp! The category of multimedia applications like tcp port du réseau. Réseaux de transport permet un format, if some attacks that transmitted data on yelp! For developing network management and sends the next generation routers, les protocoles de la couche transport. -

TD3 – OSI – Ethernet - TCP/IP 15

TD3 – 11/2015 Exercice 1: Questions modèle OSI – Modèle TCP/IP 1- Qu'est-ce que l'ISO ? 2- Que signifie OSI ? Pour quelles raisons à t'on créer ce modèle ? Quels sont ses avantages ? 3- Combien de couches comporte ce modèle. Donner le nom et la fonction de chacune des couches. 4- Que signifie communication d'égal à égal ? 5- Qu'est-ce que l'encapsulation ? 6- Qu'est-ce qu'un "PDU" ? 7- Comment se nomme les PDU des couches 1, 2, 3, 4, 5, 6 et 7. 8- Quels PDU circulent dans un réseau local ?, dans un réseau de type Intranet ou Internet? 9- Qu'est-ce qu'un protocole ? 10- Comment se nomme le modèle utilisé par l'Internet ? 11- Décrire chacune des couches de ce modèle ? 12- Qui est à l'initiative de la création des réseaux TCP/IP ? 13- Quelle est sa caractéristique principale ? Expliquer ! 14- Combien de couche comporte le modèle TCP/IP ? Donner le nom et la fonction de chacune des couches. 15- Expliquer la différence entre un protocole orienté connexion et un autre non orienté connexion ? 16- Comment se nomme une communication faisant appel : 17- A un circuit logique temporaire ? 18- A un circuit logique non temporaire ? a. Donner un exemple de communication à commutation de circuit. b. Quelles différences majeures distinguent TCP/IP du modèle OSI ? Exercice 2 : Modèle OSI 1- Définissez de manière succincte les termes suivants : Couche, Système, Entité, Protocole, Service. Quelques indications : Pour simplifier la description d’un système complexe (exemple Os Réseau), on introduit la notion de couche. -

Notes on the History of Fork-And-Join Linus Nyman and Mikael Laakso Hanken School of Economics

Notes on the history of fork-and-join Linus Nyman and Mikael Laakso Hanken School of Economics As part of a PhD on code forking in open source software, Linus Nyman looked into the origins of how the practice came to be called forking.1 This search led back to the early history of the fork system call. Having not previously seen such a history published, this anecdote looks back at the birth of the fork system call to share what was learned, as remembered by its pioneers. The fork call allows a process (or running program) to create new processes. The original is deemed the parent process and the newly created one its child. On multiprocessor systems, these processes can run concurrently in parallel.2 Since its birth 50 years ago, the fork has remained a central element of modern computing, both with regards to software development principles and, by extension, to hardware design, which increasingly accommodates parallelism in process execution. The fork system call is imagined The year was 1962. Melvin Conway, later to become known for “Conway’s Law,”3 was troubled by what seemed an unnecessary inefficiency in computing. As Conway recalls:4 I was in the US Air Force at the time – involved with computer procurement – and I noticed that no vendor was distinguishing between “processor” and “process.” That is, when a proposal involved a multiprocessor design, each processor was committed to a single process. By late 1962, Conway had begun contemplating the idea of using a record to carry the status of a process. -

Master SDRP Réseau Avancé Partie 2: TCP IP

Master SDRP Réseau Avancé Partie 2: TCP IP Philippe Gros Session 2005-2006 Le modèle Arpanet n 1969 Naissance D’ARPANET (Advanced Research Projet Agency NETwork) n 1973 Démonstration d’ARPANET et création de l’IETF n 1975 UNIX et TCP/IP: définition de TCP par l’IETF n 1980 Berkeley fournit les versions 4.1 BSD contenant TCP n 1983 TCP remplace définitivement NCP n 1996 IPng devenu IPv6 voit le jour 2 Page 1 1 Le modèle Arpanet Comment IP se situe dans les réseaux ? Le réseau Internet est constitué d'infrastructures de réseau de tous types : • Des réseaux locaux • Des liaisons point à point: RTC, RNIS, LS • Des réseaux à commutation de paquet Ring - FDDI LL X.25 FR ATM Ethernet Token 3 Le modèle Arpanet IP offre des services WEB SNMP FichiersFTP AnnuaireDNS SMTP TELNET HTTP Messagerie d'autres Et beaucoup TCP/UDP IP Ring - FDDI LS X.25 FR Ethernet ATM Token 4 Page 2 2 Le modèle Arpanet:Encapsulation IP données données message Services Services segment TCP/UDP TCP/UDP Internet datagramme Internet Réseau trame Réseau physique physique bits réseau 5 Adressage Adressage public n Dans le modèle IP – Norme RFC 1518 – Adresses gérées par l’Internic n Pour IP v4 : 32 bits d’adresses, soit 4264967296 possibilités (arrive à saturation) n Pour IP v6 : 128 bits d’adresses, soit 3.40228237*10 exp 38 possibilités (10exp12 = 1 trillion) 6 Page 3 3 Adressage: Netid Hostid « netid » « hostid » numéro de noeud 10.0.0.1 10.0.0.2 réseau 1: 10.0.0.0 réseau 2: 17.0.0.0 17.0.0.1 17.0.0.14 7 Adressage IP V4 n Pour IP v4 – 1 adresse = adresse de réseau (préfixe) + adresse de l’hôte (suffixe) – Adresse décimale pointée 124 .