Inhaltsverzeichnis

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

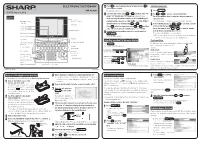

ELECTRONIC DICTIONARY Press Y to Select Alphabet Character Input Or Press N to Selecting a Menu Item 12 Select Japanese Input

ELECTRONIC DICTIONARY Press Y to select alphabet character input or press N to Selecting a menu item 12 select Japanese input. PW-AC890 The date/time settings screen is displayed. Press メニュー . QUICK REFERENCE 1 13 Select the date items using or , and then enter “年” Use or to select a category menu item. (year), “月” (month) and “日” (day) (e.g. June 23th, 2009 → 2 Or, use the numeric keys to enter the category number to Layout 09 06 23) using the number buttons on the handwriting pad. select the item. Utility keys for Display(Main display) dictionaries / functions Confirm that the cursor is on “AM(午前)” or “PM(午後)”, The individual menu for the selected category menu item is displayed. / touch pad and then select one of them using or . In the individual menu, use or to select the content/ Library key 3 Selection keys Press , select the time items using or and then function and then press 検索/決定 . for contents / functions enter “時” (hour) and “分” (minute) (e.g. 9:00 → 09 00). Or, use the numeric keys ( 1 to 9 ) to enter the number Charge lamp Stylus holder(side) Confirm that the information entered is correct and press in front of the content/function ( 1 to 9 ). Global search keys 14 検索/決定 . The selected content/function screen is displayed. Power ON/OFF key The menu display appears. ● The selected content/function screen can also be selected by touching the relevant item on the category menu or the individual menu. Menu key Function key Selecting a content in the menu display Touch operations AC adapter connector (side) Character size (large/small) The PW-AC890 can be operated by touching the main screen with the stylus. -

Conferenceabstracts

TENTH INTERNATIONAL CONFERENCE ON LANGUAGE RESOURCES AND EVALUATION Held under the Honorary Patronage of His Excellency Mr. Borut Pahor, President of the Republic of Slovenia MAY 23 – 28, 2016 GRAND HOTEL BERNARDIN CONFERENCE CENTRE Portorož , SLOVENIA CONFERENCE ABSTRACTS Editors: Nicoletta Calzolari (Conference Chair), Khalid Choukri, Thierry Declerck, Marko Grobelnik , Bente Maegaard, Joseph Mariani, Jan Odijk, Stelios Piperidis. Assistant Editors: Sara Goggi, Hélène Mazo The LREC 2016 Proceedings are licensed under a Creative Commons Attribution- NonCommercial 4.0 International License LREC 2016, TENTH INTERNATIONAL CONFERENCE ON LANGUAGE RESOURCES AND EVALUATION Title: LREC 2016 Conference Abstracts Distributed by: ELRA – European Language Resources Association 9, rue des Cordelières 75013 Paris France Tel.: +33 1 43 13 33 33 Fax: +33 1 43 13 33 30 www.elra.info and www.elda.org Email: [email protected] and [email protected] ISBN 978-2-9517408-9-1 EAN 9782951740891 ii Introduction of the Conference Chair and ELRA President Nicoletta Calzolari Welcome to the 10 th edition of LREC in Portorož, back on the Mediterranean Sea! I wish to express to his Excellency Mr. Borut Pahor, the President of the Republic of Slovenia, the gratitude of the Program Committee, of all LREC participants and my personal for his Distinguished Patronage of LREC 2016. Some figures: previous records broken again! It is only the 10 th LREC (18 years after the first), but it has already become one of the most successful and popular conferences of the field. We continue the tradition of breaking previous records. We received 1250 submissions, 23 more than in 2014. We received 43 workshop and 6 tutorial proposals. -

Dictionary Policy Located on the TEA’S STAAR Resources Webpage

TEA approval is NOT required. ARF Texas Education Agency® Dictionary Description of Accommodation This accommodation, or designated support, facilitates comprehension of unfamiliar words and provides spelling assistance for a student. Assessments For a student who meets the eligibility criterion, this accommodation may be used on • STAAR and STAAR Spanish grades 3–5 reading • STAAR and STAAR Spanish grade 4 writing (all sections of the assessment) Student Eligibility Criteria A student may use this accommodation if he or she rrroutinely, independently, and effectively uses this accommodation during classroom instruction and classroom testing. Authority for Decision and Required Documentation • For a student not receiving special education or Section 504 services, the decision is made by the appropriate team of people at the campus level (e.g., RTI team, student assistance team) based on the eligibility criterion and is documented according to district policies. • For a student who is an ELL, the decision is made by the LPAC based on the eligibility criterion and is documented in the student’s permanent record file. • For a student receiving Section 504 services, the decision is made by the Section 504 committee based on the eligibility criterion and is documented in the student’s IAP. • For a student receiving special education services, the decision is made by the ARD committee based on the eligibility criterion and is documented in the student’s IEP. • In the case of an ELL with a disability, the decision is made by the applicable group above in conjunction with the student’s LPAC. The decision is to be documented by the LPAC in the student’s permanent record file and by the other applicable group, as described above. -

The Modern Electronic Dictionary That Always Provides an Answer

The modern electronic dictionary that always provides an answer Daiga Deksne, Inguna Skadiņa, Andrejs Vasiļjevs Tilde, Vienības gatve 75a, Riga, Latvia E-mail: [email protected], [email protected], [email protected] Abstract This paper presents the Tilde Dictionary Browser (TDB), an innovative dictionary browsing environment for a wide range of users: language learners, language teachers, translators, and casual users. We describe several techniques to maximise the likelihood of providing users with a useful result even when searched items do not have a direct match in the dictionary due to misspellings, inflected words, multi-word items or phrase fragments, or where there is a lack of data in the main dictionary. TDB is targeted for broad use on multiple platforms and is implemented as desktop software, and a Web and mobile application. The desktop version of TDB currently contains dictionaries for more than 20 language pairs, including the languages of the Baltic countries, and is easily extendable to other languages. Besides the data from translation dictionaries, TDB also provides information from different online resources, such as terminology dictionaries, as well as integrates the machine translation facility. Keywords: electronic dictionaries; machine translation; spelling checker; morphological analyser; text-to-speech synthesis. 1. Introduction In the last two decades, electronic dictionaries have been established among the most widely used software applications for non-English speakers, and the majority of users prefer electronic dictionaries to printed ones (Koren 1997). Different models for electronic dictionaries have been of interest to researchers for a long time (for an overview, see de Schryver, 2003). In their work, Oppentocht and Schutz (2003) describe the advantages of electronic dictionaries (e.g., explicit information, consistency, reusability, etc.). -

The Use of Pocket Electronic Dictionaries As Compared With

THE USE OF POCKET ELECTRONIC DICTIONARIES AS COMPARED WITH PRINTED DICTIONARIES BY JAPANESE LEARNERS OF ENGLISH DISSERTATION Presented in Partial Fulfillment of the Requirements for the Degree Doctor of Philosophy in the Graduate School of The Ohio State University By Chiho Kobayashi, M.A. **** The Ohio State University 2006 Dissertation Committee: Approved by Dr. Keiko Samimy, Adviser Dr. Alan Hirvela ___________________________________ Adviser Dr. Terence Odlin College of Education Copyright by Chiho Kobayashi 2006 ABSTRACT As L2 learners increasingly depend on electronic reference materials, it has become crucial to investigate how such materials are used and what impact they have on L2 learning. Pocket electronic dictionaries (EDs) have particularly become popular among Asian learners of English in the past decade. This study compared the use of EDs with PDs among Japanese university students. It also examined the relationships between students’ ED use and their use of lexical processing strategies (LPS; consult, infer, or ignore), their vocabulary learning, and their reading. In order to construct a complete picture, this study investigated these issues both quantitatively and qualitatively, through multiple investigative techniques. This study consisted of two phases. In Phase 1, quantitative data were collected from 279 students, using a written questionnaire on LPS use, the Vocabulary Levels Test assessing vocabulary size, and the Reading Comprehension section of the TOEFL assessing reading proficiency. In Phase 2, both qualitative and quantitative data were collected from the 22 students selected from those who participated in Phase 1, through a follow- up interview about the questionnaire, retrospective think-aloud protocols elicited during a reading session, and two types of vocabulary tests administered a week after the reading session to assess word retention. -

An Electronic Dictionary As a Basis for NLP Tools: the Greek Case

TALN 2004, Session Poster, Fès, 19–21 avril 2004 An electronic dictionary as a basis for NLP tools: The Greek case Ch. Tsalidis (1), A. Vagelatos (2) and G. Orphanos (1) (1) Neurosoft S.A. 24 Kofidou Street GR-14231 Athens, Greece (tsalidis,orphan)@neurosoft.gr (2) R.A. Computer Technology Institute 13 Eptachalkou Street GR-11851 Athens, Greece [email protected] Résumé - Abstract The existence of a Dictionary in electronic form for Modern Greek (MG) is mandatory if one is to process MG at the morphological and syntactic levels since MG is a highly inflectional language with marked stress and a spelling system with many characteristics carried over from Ancient Greek. Moreover, such a tool becomes necessary if one is to create efficient and sophis- ticated NLP applications with substantial linguistic backing and coverage. The present paper will focus on the deployment of such an electronic dictionary for Modern Greek, which was built in two phases: first it was constructed to be the basis for a spelling correction schema and then it was reconstructed in order to become the platform for the deployment of a wider spectrum of NLP tools. Mots-clefs – Keywords Lexique, morphologie Lexicon, morphology Tsalidis, Vagelatos, Orphanos 1 Introduction Electronic dictionaries have become among the most indispensable language resources for those involved in all aspects of natural language processing (NLP). Large–scale language resources (text and speech corpora, lexicons, grammars) are already developed or under development for an increasing number of natural languages. Our computational linguistics (CL) team, over the past ten years has been conducting applied research toward the development of NLP applications and resources for Modern Greek (MG). -

On the Effects of Different Types of Electronic Dictionary Interfaces on L2 Learners' Reference Behaviour in Productive/Receptive Tasks Yukio TONO, Lancaster, UK

ELECTRONIC DICTIONARIES IN SECOND LANGUAGE COMPREHENSION On the Effects of Different Types of Electronic Dictionary Interfaces on L2 Learners' Reference Behaviour in Productive/Receptive Tasks Yukio TONO, Lancaster, UK Abstract This paper1 reports the effects of three different electronic interfaces on EFL learners’ look-up behaviour. Subjects performed language tasks under three conditions: with a paper dictionary, a traditional electronic dictionary, and two non-traditional electronic dictionaries. Statistically significant differences in use were recorded. 1 Background Electronic dictionaries2 have been increasingly accessible to language learners recently and their pedagogical potential is too great to be ignored [NESI 1999]. There seems to be consid- erableadvantage in electronic dictionaries over paper (or hard-copy) dictionaries. A variety of search functions (thus faster look-up), links with multimedia files (e.g. sounds and pictures), virtually no space limitation (thus extra examples and databases), links with other software, and portability (in the case of hand-held dictionaries) are a few examples of those advantages. In relation to vocabulary learning, it is still an empirical question whether fast searching is really advantageous to the learning process (see, however, the positive findings in [Guillot/ Kenning 1994]). In spite of the doubt that language teachers express, however, there is evidence that many students prefer to have electronic format because it is much quicker and easier to look up words [Taylor and Chan 1994]. From lexicographical viewpoints, one of the differences between hard-copy dictionaries and electronic dictionaries is that the former has only a linear, non-hierarchical microstructure while the latter has a hierarchical, layered presentation. The paper dictionary has its own microstruc- ture, but it must inevitably present all the information in a linear order on the same level (unless using different typesets or colours). -

The Advantages and Disadvantages of E-Dictionaries to Enhance Vocabulary Learning of ESL Learners

The Advantages and Disadvantages of E-Dictionaries to Enhance Vocabulary Learning of ESL Learners Maslawati Mohamad, Universiti Kebangsaan Malaysia, Malaysia Nuraidawany Rashid, Universiti Kebangsaan Malaysia, Malaysia Wan Nur’ashiqin Wan Mohamad, Universiti Kebangsaan Malaysia, Malaysia The Asian Conference on Education & International Development 2017 Official Conference Proceedings Abstract Among the common tool used by learners in a language classroom is the dictionary. Nowadays, dictionary has come in various types and among the widely used are the e- dictionaries. This case study aims to explore the advantages of e-dictionaries towards ESL learners together with the difficulties faced when using e-dictionaries. In this study, a total of ten undergraduate TESL students from one of a public research university in Malaysia volunteered to be the participants of this study. Focus group interviews, open-ended questionnaire and email were used as the study instrument. The findings revealed that although e-dictionaries provide some benefits to enhance vocabulary learning, there are also difficulties faced by ESL learners. It was found that the benefits are it enables them to learn about new vocabulary regardless of place and time, helps them to learn proper pronunciation of words, identifies the word origin efficiently, has visual impacts which contain interactive interaction, and gives clearer vocabulary instruction in comparison to printed dictionary. The main difficulties faced are limited internet access, incomplete definitions, lack of credibility on some bilingual e-dictionaries’ developers, and lack of definitions and examples. In addition, the participants acknowledged e-dictionaries as one of the tools for helping them to learn their second language vocabulary in a non-conventional approach as oppose to printed dictionaries. -

An Overview of the EDR Electronic Dictionary and the Current Status Of

An Overview of the EDR Electronic Dictianary and the Current Status of Its Utilization Hideo Miyoshi, Kenji Sugiyama, Masahiro Kobayashi, and Takano Ogino Japan Electronic Dictionary Research Institute, LTD. (EDR) Daini-Abe Bldg., 78-1, Kanda-Sakumagashi, Chiyoda-ku, Tokyo 101, Japan {miyoshi, kenji, kobayasi, ogino}@edr.co,jp Abstract of Japanese and English (the Word Dictionary, the Bilin- In this paper we present the specification and the struc- gual Dictionary, and the Co-occurrence Dictionary), and ture of EDR Electronic Dictionary which was developed has unified thesaurus-like concept classifications (the in a nine-year project. The first version of EDR dictio- Concept Dictionary) with corpus databases (the EDR nary (V1.0) and its revised version (V1.5) are "alreadyre- Corpus). The Concept Classification Dictionary, a sub- leased and are now utilized at many sites for both aca- dictionary of the Concept Dictionary, describes the simi- demic and commercial purposes. We also describe the larity relation among concepts listed in the Word Dictio- current status how the EDR dictionary is utilized. Finally nary. The EDR Corpus is the source for the information we will give the outline of the new R&D project which described in each of the sub-dictionaries. The basic ap- EDR will launch in fiscal 1996. proach taken during the development of the dictionary was to avoid a particular linguistic theory and to allow for adoptability to various applications. 1 Introduction The first version of EDR dictionary (VI.0) and its re- The EDR Electronic Dictionary[ 1,2,31 is the result of a vised version (V1.5) are already released and are now uti- nine-year project (from fiscal 1986 to fiscal 1994), lized at many sites for both academic and commercial funded by the Japan Key Technology Center and eight purposes. -

Visual Representations Is Lexical Learning Environments: Application to the Alexia System Thierry Chanier, Thierry Selva

Visual Representations Is Lexical Learning Environments: Application To The Alexia System Thierry Chanier, Thierry Selva To cite this version: Thierry Chanier, Thierry Selva. Visual Representations Is Lexical Learning Environments: Applica- tion To The Alexia System. Computer Assisted Language Learning, Taylor & Francis (Routledge), 1998, 11 (5), pp.489-521. edutice-00000283 HAL Id: edutice-00000283 https://edutice.archives-ouvertes.fr/edutice-00000283 Submitted on 23 Nov 2003 HAL is a multi-disciplinary open access L’archive ouverte pluridisciplinaire HAL, est archive for the deposit and dissemination of sci- destinée au dépôt et à la diffusion de documents entific research documents, whether they are pub- scientifiques de niveau recherche, publiés ou non, lished or not. The documents may come from émanant des établissements d’enseignement et de teaching and research institutions in France or recherche français ou étrangers, des laboratoires abroad, or from public or private research centers. publics ou privés. VISUAL REPRESENTATIONS IN LEXICAL LEARNING ENVIRONMENTS: APPLICATION TO THE ALEXIA SYSTEM Thierry CHANIER, Thierry SELVA LIB, Université de Franche-Comté 16 route de Gray, 25030 Besançon Cedex, France [email protected], [email protected] Computer Assisted Language Learning, Taylor & Francis (Routledge), 1998, 11 (5), pp.489-521 Abstract: Cognition-based arguments in support of using multimedia aids for the learning of vocabulary have so far offered only an imprecise, general framework. CALL experimentalists have also tried to establish the effectiveness of multimedia for vocabulary learning, but their attempts reveal that the underlying representations have not been clearly defined. After reviewing these points, we propose criteria for evaluating the quality of a visual representation in a lexical environment. -

Thesis the Influence of Using Paper Dictionary And

THESIS THE INFLUENCE OF USING PAPER DICTIONARY AND ELECTRONIC DICTIONARY ON STUDENTS’ IDIOM COMPREHENSION Name: Izky Hanifah NIM: 1503046059 PENDIDIKAN BAHASA INGGRIS FAKULTAS ILMU TARBIYAH DAN KEGURUAN UNIVERSITAS ISLAM NEGERI WALISONGO SEMARANG 2019 i THESIS STATEMENT I am the student with following identity Name : Izky Hanifah Students‟ Number : 1503046059 Department : Education Field of Study : English Language Education Department Certify that the thesis untitled The Influence of Using Paper Dictionary and Electronic Dictionary on Students’ Idiom Comprehension. is definitely my own work. I am completely responsible for the content of the thesis. Other researcher‟s opinions or findings included in the thesis are quoted or cited in accordance with ethical standards. ii iii ADVISOR APPROVAL Semarang, 25 July 2019 To The Dean of Faculty of Education and Teacher Training Walisongo State Islamic University Assalamu‟alaikum Wr. Wb I inform that I have given guidence, briefing, and correction to whatever extent necessary of the following thesis identification: Title : The Influence of Using Paper Dictionary and Electronic Dictionary on Students’ Idiom Comprehension. Name : Izky Hanifah Students‟ Number :1503046059 Department : English Language Education Department I state that the thesis is ready to be submitted to Faculty of Education and Teacher Training of State Islamic University Walisongo to be examined at Munaqosah session. iv ADVISOR APPROVAL Semarang, 25 July 2019 To The Dean of Faculty of Education and Teacher Training Walisongo State Islamic University Assalamu‟alaikum Wr. Wb I inform that I have given guidance, briefing, and correction to whatever extent necessary of the following thesis identification: Title : The Influence of Using Paper Dictionary and Electronic Dictionary on Students’ Idiom Comprehension. -

A Polish-To-English Electronic Dictionary Designed for the Purposes of MT

A Polish-to-English electronic dictionary designed for the purposes of MT. Krzysztof Jassem, [email protected] Maciej Lison, [email protected] Filip Graliński, [email protected] Bogusław Rutkowski, [email protected] Adam Mickiewicz University, Faculty of Mathematics and Computer Science ul. Matejki 48/49, 60-769 Poznań Poland Abstract The aim of the research is to obtain a bilingual dictionary which could be consulted by an MT algorithm translating computer-oriented texts from Polish to English. A single entry of the dictionary consists of a Polish lexeme identifier (a canonical form of the lexeme and a code of its inflection), a list of its inflection forms and a list of "translation units". Each translation unit includes a list of constraints (syntactic, semantic, pragmatic) and a description of an English equivalent. The contents of the dictionary are based on the vocabulary of a text corpus. A corpus consisting of close to 200 000 words has been collected on the basis of Polish texts in computer-oriented magazines and manuals. The corpus has been processed in order to obtain three lists of lexemes occurring in the corpus: proper names, abbreviations and other lexemes. An interactive editor has been designed to assist a lexicographer in describing the entries of the dictionary. The output data of the editor are of the SGML-document type format. An application which converts the dictionary into a binary file has been worked out in order to optimise the access time. The procedures for binary storage of the dictionary are universal enough to be applied to NLP systems other than MT.