Skalierbares Und Flexibles Live-Video Streaming Mit Der Media Internet

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

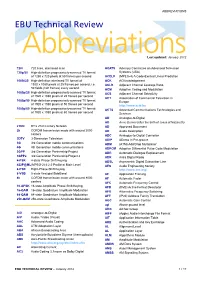

ABBREVIATIONS EBU Technical Review

ABBREVIATIONS EBU Technical Review AbbreviationsLast updated: January 2012 720i 720 lines, interlaced scan ACATS Advisory Committee on Advanced Television 720p/50 High-definition progressively-scanned TV format Systems (USA) of 1280 x 720 pixels at 50 frames per second ACELP (MPEG-4) A Code-Excited Linear Prediction 1080i/25 High-definition interlaced TV format of ACK ACKnowledgement 1920 x 1080 pixels at 25 frames per second, i.e. ACLR Adjacent Channel Leakage Ratio 50 fields (half frames) every second ACM Adaptive Coding and Modulation 1080p/25 High-definition progressively-scanned TV format ACS Adjacent Channel Selectivity of 1920 x 1080 pixels at 25 frames per second ACT Association of Commercial Television in 1080p/50 High-definition progressively-scanned TV format Europe of 1920 x 1080 pixels at 50 frames per second http://www.acte.be 1080p/60 High-definition progressively-scanned TV format ACTS Advanced Communications Technologies and of 1920 x 1080 pixels at 60 frames per second Services AD Analogue-to-Digital AD Anno Domini (after the birth of Jesus of Nazareth) 21CN BT’s 21st Century Network AD Approved Document 2k COFDM transmission mode with around 2000 AD Audio Description carriers ADC Analogue-to-Digital Converter 3DTV 3-Dimension Television ADIP ADress In Pre-groove 3G 3rd Generation mobile communications ADM (ATM) Add/Drop Multiplexer 4G 4th Generation mobile communications ADPCM Adaptive Differential Pulse Code Modulation 3GPP 3rd Generation Partnership Project ADR Automatic Dialogue Replacement 3GPP2 3rd Generation Partnership -

Final-Thesis.Pdf (2.424Mb)

1 2 3 ABSTRAKT Práce pojednává o přenosu multimediálních dat v síti Internet se zaměřením na tvorbu webových stránek s využitím aplikačních rozhraní API, která jsou dostupná na stránkách společnosti Google, a tvorbu nezávislého video portálu s použitím open-source skriptů ClipBucket a PHPmotion. Rozebírána je problematika přenosu video a audio dat s využitím webových prohlížečů. Jsou zde popsány protokoly a kodeky pro streamování videa ve webových prohlížečích. Podrobně je popsána především vlastní tvorba webových stránek se začleněním aplikací API přímo do zdrojového kódu HTML, a vytvoření nezávislého video portálu s kompletní konfigurací serveru pro hosting. Jako přílohy jsou uvedeny vytvořené webové stránky s video obsahem, nezávislý video portál, laboratorní cvičení na praktické vyzkoušení a začlenění multimediálního obsahu a praktická ukázka administrace video portálu. Klíčová slova: Multimediální data, Internet, YouTube, API, ClipBucket, PHPmotion, video portal. ABSTRACT The text of this work deals with multimedia data distribution over Internet with a focus on creating web pages using application APIs that are available on Google and creating an independent video portal using open-source scripts ClipBucket and PHPmotion. There are analyzed problems of transmission of video and audio data using Web browsers. There are described protocols and codecs for video streaming in web browsers. In details it is described creating of Web sites with the inclusion of application API directly into the HTML source code and creating an independent video portal with a complete configuration of the server for hosting. As an annex the created Web pages are listed with video content and laboratory exercises on the practical test and integration of multimedia content and the practical administraton of the video portal. -

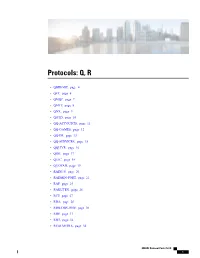

Protocols: Q, R

Protocols: Q, R • QBIKGDP, page 4 • QFT, page 6 • QMQP, page 7 • QMTP, page 8 • QNX, page 9 • QOTD, page 10 • QQ-ACCOUNTS, page 11 • QQ-GAMES, page 12 • QQ-IM, page 13 • QQ-SERVICES, page 15 • QQLIVE, page 16 • QRH, page 17 • QUIC, page 18 • QUOTAD, page 19 • RADIUS, page 20 • RADMIN-PORT, page 22 • RAP, page 24 • RAKUTEN, page 26 • RCP, page 27 • RDA, page 28 • RDB-DBS-DISP, page 30 • RDP, page 31 • RDT, page 32 • REALMEDIA, page 34 NBAR2 Protocol Pack 25.0.0 1 Protocols: Q, R • REALM-RUSD, page 35 • REALTOR-COM, page 36 • REDIFF-COM, page 37 • RE-MAIL-CK, page 38 • REMOTEFS, page 40 • REMOTE-KIS, page 41 • REPCMD, page 42 • REPSCMD, page 43 • RESCAP, page 44 • RETAILMENOT, page 46 • REDIFF-COM, page 47 • REUTERS, page 48 • RHAPSODY, page 49 • RIP, page 51 • RIPNG, page 52 • RIS, page 54 • RIS-CM, page 56 • RJE, page 57 • RLP, page 59 • RLZDBASE, page 60 • RMC, page 61 • RMIACTIVATION, page 62 • RMIREGISTRY, page 64 • RMONITOR, page 65 • RMT, page 67 • ROTTEN-TOMATOES, page 68 • RPC2PORTMAP, page 69 • RRH, page 70 • RRP, page 71 • RSH-SPX, page 73 • RSVD, page 74 • RSVP, page 75 • RSVP_TUNNEL, page 77 NBAR2 Protocol Pack 25.0.0 2 Protocols: Q, R • RSVP-E2E-IGNORE, page 79 • RSVP-ENCAP-1, page 80 • RSVP-ENCAP-2, page 82 • RSYNC, page 84 • RTCP, page 85 • RTELNET, page 87 • RTIP, page 88 • RTMP, page 89 • RTMPE, page 90 • RTMPT, page 92 • RTP, page 94 • RTP-AUDIO, page 95 • RTP-VIDEO, page 97 • RTSP, page 99 • RTSPS, page 100 • RUSHD, page 102 • RVD, page 104 • RXE, page 106 NBAR2 Protocol Pack 25.0.0 3 Protocols: Q, R QBIKGDP QBIKGDP Name/CLI Keyword qbikgdp Full Name Qbik GDP Description Generic Discovery Protocol (GDP) is a protocol developed for finding or discovering Internet connectivity servers (such as WinGate). -

QBIKGDP Through RXE

QBIKGDP through RXE • QBIKGDP, page 4 • QFT, page 5 • QMQP, page 6 • QMTP, page 7 • QNX, page 8 • QOTD, page 9 • QQLIVE, page 10 • QRH, page 11 • QUOTAD, page 12 • RADIUS, page 13 • RADMIN-PORT, page 14 • RAP, page 15 • RCP, page 16 • RDA, page 17 • RDB-DBS-DISP, page 18 • RDP, page 19 • RDT, page 20 • REALMEDIA, page 21 • REALM-RUSD, page 22 • RE-MAIL-CK, page 23 • REMOTEFS, page 24 • REMOTE-KIS, page 25 • REPCMD, page 26 • REPSCMD, page 27 NBAR2 Protocol Pack 7.0.0 1 QBIKGDP through RXE • RESCAP, page 28 • RHAPSODY, page 29 • RIP, page 30 • RIPNG, page 31 • RIS, page 32 • RIS-CM, page 34 • RJE, page 35 • RLP, page 36 • RLZDBASE, page 37 • RMC, page 38 • RMIACTIVATION, page 39 • RMIREGISTRY, page 40 • RMONITOR, page 41 • RMT, page 42 • RPC2PORTMAP, page 43 • RRH, page 44 • RRP, page 45 • RSH-SPX, page 46 • RSVD, page 47 • RSVP, page 48 • RSVP_TUNNEL, page 49 • RSVP-E2E-IGNORE, page 50 • RSVP-ENCAP-1, page 51 • RSVP-ENCAP-2, page 52 • RSYNC, page 53 • RTCP, page 54 • RTELNET, page 55 • RTIP, page 56 • RTMP, page 57 • RTMPE, page 58 • RTMPT, page 59 • RTP, page 60 • RTSP, page 61 NBAR2 Protocol Pack 7.0.0 2 QBIKGDP through RXE • RTSPS, page 62 • RUSHD, page 63 • RVD, page 64 • RXE, page 65 NBAR2 Protocol Pack 7.0.0 3 QBIKGDP through RXE QBIKGDP QBIKGDP Name/CLI Keyword qbikgdp Full Name Qbik GDP Description Generic Discovery Protocol (GDP) is a protocol developed for finding or discovering Internet connectivity servers (such as WinGate). -

Media Streaming Over the Internet — an Overview of Delivery Technologies

WEBCASTING Media Streaming over the Internet — an overview of delivery technologies Franc Kozamernik EBU Technical Department This article reviews the basic concepts of media streaming over the Internet, particularly those associated with Internet Protocols (IP) and server technologies. The article concentrates on the delivery aspects of audio and video over the Internet but does not cover audio and video compression schemes nor media capturing/authoring/ publishing tools in any detail. These aspects will be covered in future editions of EBU Technical Review. The concept of streaming media is less than a decade old and yet it has experienced impressive growth. Using streaming technologies, the delivery of audio and video over the Internet now reaches many millions of people using their personal computers – offering live sport, music, news, entertainment and on-demand content. With broadband networks being deployed in many countries, and video/audio compression technologies advancing rapidly, the quality of audio and video services over the Internet is increasing rapidly. A variety of user termi- nals can now be deployed, ranging from office desktops to personal digital assistants (PDAs) and mobile phones. In this article, streaming stands for the real-time 1 transport of live or stored media (e.g. video, audio and any associated data) over the Internet, between the client and server computers. There are two modes for the transmission of media over the Internet: ! In the download mode, the user can play the downloaded file only after the whole file has been down- loaded from a server to his/her computer. The full file transfer, in the download mode, can often suffer unacceptably long transfer times, which depend on the size of the media file and the bandwidth of the transport channel. -

Tesis De Grado

ESCUELA SUPERIOR POLITÉCNICA DEL LITORAL FACULTAD DE INGENIERÍA EN ELECTRICIDAD Y COMPUTACIÓN “IMPLEMENTACIÓN DE UN SISTEMA DE VIGILANCIA REMOTA EN TERMINALES MOVILES UTILIZANDO TECNOLOGÍA WAP Y VIDEO STREAMING PARA VISUALIZACIÓN DE IMÁGENES” TESIS DE GRADO Previa a la Obtención del Título de: INGENIERO EN COMPUTACIÓN ESPECIALIZACIÓN EN SISTEMAS TECNOLÓGICOS Presentado por: DAVID EDUARDO ALAVA VÉLEZ JORGE LUIS GÓMEZ RODRIGUEZ MARIO HERNÁN CAISAPANTA ARAGONÉS GUAYAQUIL - ECUADOR 2008 AGRADECIMIENTO Nuestro más sincero agradecimiento a Dios por habernos dado la fortaleza para emprender este proyecto y por habernos permitido contar con el apoyo de personas muy importantes para el desarrollo de esta tesis. DEDICATORIA A nuestros inigualables padres. TRIBUNAL DE GRADUACIÓN ........................................................... ............................................................. ING. GUSTAVO BERMÚDEZ MSC. FRANCISCO NOVILLO Decano de la FIEC Director de Tesis ........................................................... ............................................................ MSC. REBECA ESTRADA MSC. JUAN CARLOS AVILÉS Miembro del Tribunal Miembro del Tribunal DECLARACIÓN EXPRESA “La responsabilidad por los hechos, ideas y doctrinas expuestos en esta tesis, nos corresponden exclusivamente; y el patrimonio intelectual de la misma, a la ESCUELA SUPERIOR POLITÉCNICA DEL LITORAL” (Reglamento de Exámenes y Títulos profesionales de la ESPOL). ........................................................... ............................................................ -

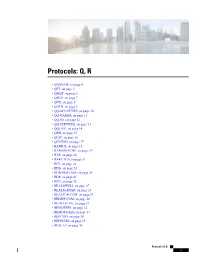

Protocols: Q, R

Protocols: Q, R • QBIKGDP, on page 4 • QFT, on page 5 • QMQP, on page 6 • QMTP, on page 7 • QNX, on page 8 • QOTD, on page 9 • QQ-ACCOUNTS, on page 10 • QQ-GAMES, on page 11 • QQ-IM, on page 12 • QQ-SERVICES, on page 13 • QQLIVE, on page 14 • QRH, on page 15 • QUIC, on page 16 • QUOTAD, on page 17 • RADIUS, on page 18 • RADMIN-PORT, on page 19 • RAP, on page 20 • RAKUTEN, on page 21 • RCP, on page 22 • RDA, on page 23 • RDB-DBS-DISP, on page 24 • RDP, on page 25 • RDT, on page 26 • REALMEDIA, on page 27 • REALM-RUSD, on page 28 • REALTOR-COM, on page 29 • REDIFF-COM, on page 30 • RE-MAIL-CK, on page 31 • REMOTEFS, on page 32 • REMOTE-KIS, on page 33 • REPCMD, on page 34 • REPSCMD, on page 35 • RESCAP, on page 36 Protocols: Q, R 1 Protocols: Q, R • RETAILMENOT, on page 37 • REDIFF-COM, on page 38 • REUTERS, on page 39 • RHAPSODY, on page 40 • RINGCENTRAL, on page 41 • RINGCENTRAL-AUDIO, on page 42 • RINGCENTRAL-CONTROL, on page 43 • RINGCENTRAL-MEDIA, on page 44 • RINGCENTRAL-VIDEO, on page 45 • RIP, on page 46 • RIPNG, on page 47 • RIS, on page 48 • RIS-CM, on page 49 • RJE, on page 50 • RLP, on page 51 • RLZDBASE, on page 52 • RMC, on page 53 • RMIACTIVATION, on page 54 • RMIREGISTRY, on page 55 • RMONITOR, on page 56 • RMT, on page 57 • ROTTEN-TOMATOES, on page 58 • RPC2PORTMAP, on page 59 • RRH, on page 60 • RRP, on page 61 • RSH-SPX, on page 62 • RSVD, on page 63 • RSVP, on page 64 • RSVP_TUNNEL, on page 65 • RSVP-E2E-IGNORE, on page 66 • RSVP-ENCAP-1, on page 67 • RSVP-ENCAP-2, on page 68 • RSYNC, on page 69 • RTCP, on page 70 • RTELNET, on page 71 • RTIP, on page 72 • RTMP, on page 73 • RTMPE, on page 74 • RTMPT, on page 75 • RTP, on page 76 • RTP-AUDIO, on page 77 • RTP-VIDEO, on page 78 • RTSP, on page 79 • RTSPS, on page 80 • RUSHD, on page 81 • RVD, on page 82 Protocols: Q, R 2 Protocols: Q, R • RXE, on page 83 Protocols: Q, R 3 Protocols: Q, R QBIKGDP QBIKGDP Name/CLI Keyword qbikgdp Full Name Qbik GDP Description Generic Discovery Protocol (GDP) is a protocol developed for finding or discovering Internet connectivity servers (such as WinGate). -

I.Wojnicki,Tech.Inter

Multimedia Igor Wojnicki Katedra Automatyki Akademia Górniczo-Hutnicza w Krakowie 18 czerwca 2012 I.Wojnicki, Tech.Inter. Igor Wojnicki (AGH, KA) Multimedia 18 czerwca 2012 1 / 34 Spis Tresci´ 1 Multimedia: Portale WWW Macromedia (Adobe) Flash Multimedia: aplety Java Inne 2 Streaming Audio/Wideo Przesyłanie Algorytmy 3 Voice Over IP Wprowadzenie Protokoły 4 HTML5 WprowadzenieI.Wojnicki, Tech.Inter. Igor Wojnicki (AGH, KA) Multimedia 18 czerwca 2012 2 / 34 Multimedia: Portale WWW Macromedia (Adobe) Flash Spis Tresci´ 1 Multimedia: Portale WWW Macromedia (Adobe) Flash Multimedia: aplety Java Inne 2 Streaming Audio/Wideo Przesyłanie Algorytmy 3 Voice Over IP Wprowadzenie Protokoły 4 HTML5 WprowadzenieI.Wojnicki, Tech.Inter. Igor Wojnicki (AGH, KA) Multimedia 18 czerwca 2012 3 / 34 Multimedia: Portale WWW Macromedia (Adobe) Flash Cechy Flash’a Dost˛epny na wiele platform OS/Hardware, Grafika skalowalna (wektorowa i rastrowa), Animacje, Dwukierunkowe Audio, Drukierunkowe Wideo. FLV: Flash Video, otwarty format przesyłu danych, kodeki juz˙ niekoniecznie. I.Wojnicki, Tech.Inter. Igor Wojnicki (AGH, KA) Multimedia 18 czerwca 2012 4 / 34 Multimedia: Portale WWW Macromedia (Adobe) Flash Osadzanie obiektów Flash <object type="application/x-shockwave-flash" data="filename.swf" width="200" height="200" id="movie1"> <param name="movie" value="filename.swf"> <param name="quality" value="high" /> <param name="bgcolor" value="#ffffff" /> <p>You need the Flash plugin.</p> <p><a href="http://www.macromedia.com/go/getflashplayer/"> Download Macromedia Flash Player</a></p> </object> I.Wojnicki, Tech.Inter. Igor Wojnicki (AGH, KA) Multimedia 18 czerwca 2012 5 / 34 Multimedia: Portale WWW Macromedia (Adobe) Flash Osadzanie z wykorzystaniem JavaScript http://blog.deconcept.com/swfobject/ <script type="text/javascript" src="swfobject.js"></script> <div id="flashcontent"> This text is replaced by the Flash movie. -

Qoe of Video Streaming Over LTE Network

Master Thesis Electrical Engineering October 2013 QoE of Video Streaming over LTE Network Pradeep Uppu, Sushanth Kadimpati School of Computing Blekinge Institute of Technology 37179 Karlskrona Sweden This thesis is submitted to the School of Computing at Blekinge Institute of Technology in partial fulfilment of the requirements for the degree of Master of Science in Electrical Engineering. The thesis is equivalent to 20 weeks of full time studies. This Master Thesis is typeset using LATEX Contact Information Author(s): Pradeep Uppu Address: Karlskrona, Sweden E-mail: [email protected] Sushanth Kadimpati Address: Karlskrona, Sweden E-mail: [email protected] University advisor(s): Dr. Adrian Popescu, Prof. COM/BTH School of Computing Internet: www.bth.se/com Blekinge Institute of Technology Phone: +46 455 385000 371 79 KARLSKRONA SWEDEN SWEDEN Abstract In recent years, the mobile Internet has increased dramatically with the development of 3G and 4G technologies. Especially the usage of mobile broadband internet on the devices like cellular mobiles, Tablets and Laptops has skyrocketed. Among the multimedia applications video streaming is the most popular mobile application. But, making these services available to users in a cost effective way without compromising quality is a big challenge. The development of Long Term Evolution (LTE) technology in the mobile world made this task achievable. The features of LTE technology provide effective services in multimedia applications with high data rates and low latency. In this paper, we study and analyze the Quality of Experience (QoE) at the end user for Video on Demand (VoD) over the LTE network. To achieve this, we streamed High Definition (HD) videos based on H.264/AVC and these videos are delivered from source to destination using Transport Control Protocol (TCP) and User Datagram Protocol (UDP). -

IPTV É Uma Das Tecnologias Responsáveis Por Essa Convergência E Com Base Nessa Tecnologia Novas Oportunidades De Negócio Surgirão

Framework para "Personal TV" André Miguel Dias Claro Dissertação para obtenção do Grau de Mestre em Engenharia de Redes de Comunicações Júri Presidente: Professor Luis Eduardo Teixeira Rodrigues Orientador: Professor Paulo Rogério Barreiros D'Almeida Pereira Co-Orientador: Doutor Luís Miguel Serra da Costa Campos Vogal: Professor Mário Serafim dos Santos Nunes Novembro de 2008 Esta dissertação é dedicada ao meu Avô, Manuel Claro, que esteve, está e estará sempre no meu coração. ii Agradecimentos Agradeço em primeiro lugar, aos meus Pais, Jorge e Maria Esmeralda, por toda a ajuda, por todo o seu esforço e cooperação para que este objectivo e trabalho tenham sido possíveis, os quais nos momentos mais difíceis estiveram sempre ao meu lado. Agradeço também aos meus avós, que mesmo longe, nunca deixaram de me apoiar e motivar para que conseguisse cumprir este objectivo, e ao resto da minha família que esteve sempre comigo e sempre me apoiou, dos quais destaco o meus padrinhos, primos e a minha afilhada, Mariana. Em segundo lugar, agradeço de forma especial aos meus coordenadores, Professor Paulo Pereira e Dr. Luís Campos, que com as suas orientações e suas motivações me ajudaram a realizar este trabalho e com os quais apreendi bastante durante este último ano. Agradeço também a todos os meus amigos, colegas da universidade, colegas do Centro de Informática e Professores com os quais apreendi bastante e cresci imenso como pessoa. Em último lugar, o meu obrigado aos meus amigos, Carina Louro, Filipe Filipe e Guilherme Cardoso, pela sua ajuda na revisão desta dissertação. A todos o meu Muito Obrigado. -

Technische Universität Braunschweig Carl-Friedrich-Gauß-Fakultät Institut Für Betriebssysteme Und Rechnerverbund

Technische Universität Braunschweig Carl-Friedrich-Gauß-Fakultät Institut für Betriebssysteme und Rechnerverbund Collaborative Media Streaming Von der Carl-Friedrich Gauß-Fakultät der Technischen Universität Carolo-Wilhelmina zu Braunschweig zur Erlangung des Grades einer Doktor-Ingenieurin (Dr.-Ing.) genehmigte Dissertation von Verena Kahmann geboren am 8.4.1972 in Stuttgart Referent: Prof. Dr.-Ing. L. Wolf Korreferent: Prof. Dr.-Ing. J. Ott Eingereicht am 15. April 2008 Mündliche Prüfung am 22. Juli 2008 Dank Zum Gelingen dieser Arbeit haben einige Menschen wesentlich beigetragen. Bei ihnen allen möchte ich mich herzlich bedanken. An herausragender erster Stelle sei hier Herr Prof. Dr. Lars Wolf genannt, der meine Arbeit in jeglicher Hinsicht hervorragend betreut und mit zahlreichen wertvollen Hinweisen und fach- lichen Ratschlägen das Zustandekommen dieser Arbeit erst ermöglicht hat. Er hat mich als wissenschaftliche Mitarbeiterin am Institut für Telematik an der Universität Karlsruhe (TH) eingestellt und mich auch nach dem Wechsel an das Institut für Betriebssysteme und Rechnerver- bund der Technischen Universität Braunschweig stets gefördert. Besonders dankbar bin ich ihm für die Freiräume, die er mir gewährt hat, um Beruf und Familie vereinbaren zu können. Herrn Prof. Dr. Jörg Ott von der Universität Helsinki danke ich für die freundliche Übernahme des Korreferates sowie für die hilfreichen Anmerkungen zur Arbeit. Die Zusammenarbeit mit den Kollegen, zunächst am Institut für Telematik, dann am Institut für Betriebssysteme und Rechnerverbund, war ebenfalls von großer Bedeutung für das Gelingen meiner Arbeit. An beiden Instituten herrschte ein angenehmes und offenes Arbeitsklima, zu dem viele Kollegen ihren Teil beigetragen haben. Für das Institut für Telematik seien stellvertretend Herr Dr. Elmar Dorner, der mich als Betreuer meiner studentischen Arbeiten für das Gebiet der Rechnerkommunikation begeistert hat, und die Herren Kollegen der Engesserstraße, Dr. -

Internet Broadcasters Information Handbook Second Edition

Internet Broadcasters Information Handbook Second Edition Written By David Childers www.scvi.net Creative Common License This body of work is released under the Attribution-ShareAlike version 3.0, Creative Common License. The work may be freely distributed or modified for commercial or non commercial purposes. If this work is modified, compliance with the Attribution-ShareAlike version 3.0, Creative Common License is required. These requirements include: - Any derivatives of this work must be attributed to David Childers. - Alterations, transforming, or building upon this work requires distributing the resulting work only under the same, similar or a compatible license. For the complete legal code, please refer here: www.creativecommons.org/licenses/by-sa/3.0/legalcode Cover photograph - RCA Indian Head Test Card ca. 1940, Public Domain image. en.wikipedia.org/wiki/File:TESTPATTERN_RCA_3.jpg About The Author David Childers is the Content Manager and Senior Editor for the International Broadcasting portal www.BroadcastingWorld.net. He is also the webmaster of the SHOUTcast video streaming information resource, www.scvi.net. He is very active in the Internet broadcast industry. Mr. Childers work has been cited in several national and International publications, such as: Five Essays on Copyright In the Digital Era Turrer Publishing Research On High-Profile Digital Video Production Digital Content Association of Japan Video Podcasting in Perspective: The History, Technology, Aesthetics and Instructional Uses of a New Medium Journal of Educational