„MPEG-4 Und Seine Derivate“

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Quality Assessment for HEVC Encoded Videos: Study of Transmission and Encoding Errors

Master Thesis Electrical Engineering November 2016 Quality Assessment for HEVC Encoded Videos: Study of Transmission and Encoding Errors Sohaib Ahmed Siddiqui Yousuf Hameed Ansari Published : Blekinge Tekniska Högskola URL: http//www.bth.se This thesis is submitted to Blekinge Institute of Technology in partial fullfillment of the requirements for the degree of Masters of Science in Electrical Engieering. Contact Information: Author(s): Yousuf Hameed Ansari E-mail: [email protected] Sohaib Ahmed Siddiqui E-mail: [email protected] Supervisor: Benny Lövström TISB, Blekinge Institute of Technology Muhammad Shahid TISB, Blekinge Institute of Technology External Supervisor: Muhammad Arslan Usman WENS, Kumoh National Institute of Technology Gumi, South Korea Examiner: Dr. Sven Johansson TISB, Blekinge Institute of Technology Published : Blekinge Tekniska Högskola URL: http//www.bth.se i Quality Assessment for HEVC Encoded Videos: Study of Transmission and Encoding Errors Abstract There is a demand for video quality measurements in modern video applications specifically in wireless and mobile communication. In real time video streaming it is experienced that the quality of video becomes low due to different factors such as encoder and transmission errors. HEVC/H.265 is considered as one of the promising codecs for compression of ultra- high definition videos. In this research, full reference based video quality assessment is performed. The raw format reference videos have been taken from Texas database to make test videos data set. The videos are encoded using HM9 reference software in HEVC format. Encoding errors has been set during the encoding process by adjusting the QP values. To introduce packet loss in the video, the real-time environment has been created. -

QTAKE HD User Guide V1.1.097 6

QTAKE HD User Guide Version 1.1.097 Content QTAKE HD 6 PROJECTS 25 CODEC 26 ABOUT 6 AUTO-LOAD 26 SOFTWARE VERSIONS AND MODULES 7 SOFTWARE REQUIREMENTS 7 USER OPTIONS 27 STATUS BAR 28 HARDWARE 7 IMPORT QT MOVIES 29 QTAKE HDx1 HARDWARE RECOMMENDATIONS 8 LINK QT MOVIES 29 QTAKE HDx1 Apple MacBook Pro 8 QTAKE LITE HARDWARE RECOMMENDATIONS 9 FILENAME PARSING 30 QTAKE LITE Apple MacBook Pro 9 IMPORT CDL 31 QTAKE HDx2 HARDWARE RECOMMENDATIONS 10 IMPORT/LINK FROM QTAKE 32 QTAKE HDx2 Apple MacPro 10 EXPORT 33 QTAKE HDx2 Apple MacBook Pro 11 EXPORT TO FCP 33 QTAKE HDx4 HARDWARE RECOMMENDATIONS 12 Final Cut Pro 7 33 QTAKE HDx4 Apple MacPro 12 Final Cut Pro X 33 VIDEO CARDS 13 EXPORT TO AVID ALE 34 CONNECTION DIAGRAM 14 EXPORT EDL 35 INSTALLATION 15 EXPORT TO QTAKE XML 36 BEFORE YOU START 15 LICENSE INFO 37 PROJECT INFO 37 TOUCHSCREEN UI 16 BIT DEPTH 38 USER INTERFACE 16 FULL RANGE VIDEO 38 SCREEN ZONES 19 PDF REPORT 39 CUSTOM UI LAYOUT 21 SCREENSHOT 39 VISUAL KEYBOARDS 22 DUAL SCREENSHOT 39 KEYBOARD SHORTCUTS 23 CREW 39 ROOMS 23 CAMERA METADATA COMPARISON TABLE 40 FILE 23 RED CAMERA SUPPORT 41 SHOOT 23 ARRI CAMERA SUPPORT 42 EDIT 23 SONY CAMERA SUPPORT 43 COMPOSITE 23 CANON CAMERA SUPPORT 44 STUDIO 23 SCOPES 45 TERADEK CUBE Support 46 FILE ROOM 24 NET LINK 47 QTAKE 24 GPI 48 USERS 24 GPI INPUT 48 Content GPI OUTPUT 49 DEINTERLACE 71 VIDEOHUB 50 VIDEO RANGE 71 VIDEOHUB SETUP 51 ZOOM 72 REMOTE CONTROL 52 PATCH - INTERNAL MATRIX SWITCHER 73 REMOTE CONTROL SETUP 53 AUDIO 74 TALKBACK 53 RECORDING 74 CONTROL SURFACES 54 RECORD SYNC 74 C-MOTION 54 RECORD -

Video Datotečni Formati

Video datotečni formati VIDEO DATOTEČNI FORMAT Je metadatoteka, ki podaja kako so podatki in meta-podatki shranjeni – ne kako so kodirani. Video je pakiran v datoteko, ki vsebuje še dodatne informacije. Naprednejši formati podpirajo več hkratnih avdio in video strujanj, podnapise, meta-podatke, sinhronizacijske informacije. Eden pomembnih elementov pri video datoteki je tudi stiskanje. Kodek (compressor/decompressor) je nabor navodil, ki identificirajo uporabljeno metodo stiskanja. Mediainfo – program, ki prikazuje imena, formate, velikost, kodeke, dolžino datoteke. Primeren je za video: MKV, OGM, AVI, DivX, WMV, QuickTime, Real, Mpeg-1, MPEG-2, MPEG-4, DVD (VOB), DivX, XviD, MSMPEG4, ASP, H.264 (Mpeg-4 AVC); avdio: OGG, MP3, WAV, RA, AC3, DTS, AAC, M4A, AU, AIFF; podnapise: SRT, SSA, ASS, SAMI. Ločuje bit rate, sample rate in frame rate. Izbira formata video datoteke je odvisna od tega, v katerem procesu ga uporabljamo. • Zajemanje videa: format izvorne datoteke iz video kamere, • montaža videa: kakšne vrste datotek sprejema program za montažo, • distribucija: najustreznejši format za distribucijo. Kriterij za ocenjevanje ustreznosti formata: • dolžina datoteke (za internet so zaželene manj obsežne datoteke (manjše hitrosti strujanja)), • ločljivost in splošne značilnosti datoteke in • kompatibilnost datoteke. Splošni formati za zajemanje videa: • DV, • DVCPRO, • MPEG4-AVC, • AVCHD, • HDV, • DVCPRO HD, • HD, • XDCAM HD, • MPEG2. VIDEO DATOTEKE AVCHD (Advanced Video Codec High Definiton) HD format za domače video sisteme (uporablja ga precej novejših video kamer). Datoteke so obsežne, za začetno fazo projekta in za montažo – ni primeren za izmenjavo na spletu. Je razmeroma nov (razvila sta ga Sony in Panasonic), problem podpore pri nekaterih programih za montažo. Za predvajanje je potrebna precejšnja količina RAM-a in procesna moč. -

Lossy Video Compression Using Well Known Mathematical Functions and a Limited Set of Reference Values

Popular and Democratic Republic of Algeria Ministry of Higher Education and Scientific Research Colonel Ahmed Draia University of Adrar Faculty of Sciences and Technology Department of Mathematics and Computer Science A Thesis Presented to Fulfill the Partial Requirement for Master’s Degree in Computer Science Option: Networks and Intelligent Systems Title: Lossy Video compression using well known mathematical functions and a limited set of reference values Prepared by Miss. Leyla OULAD BENSAID Supervised by Dr. Mohammed OMARI Academic year 2016/2017 ABSTRACT Nowadays the amount of digital video applications is rapidly increasing. The amount of raw video data is very large which makes storing, processing, and transmitting video sequences very complex tasks. Furthermore, while the demand for enhanced user experience is growing, the sizes of devices capable of performing video processing operations are getting smaller. This further increases the practical limitations encountered when handling these large amounts of data, and makes research on video compression systems and standards very important. For this reason, many compression techniques have been proposed; some of these have been effective in some areas and failed in others. In this thesis we propose a new lossy video compression technique using well known mathematical functions and a limited set of reference values. Our approach is based on finding a compressed value whose corresponding pair of the corresponding mathematical function and reference value, aiming to produce shorter expressions compared to the regular form. In addition, we integrated an approach that utilizes binary search algorithm in order to efficiently find a better compressed value with shorter reduced form that does not harm the original image quality. -

QTAKE User Guide V1.3 7

QTAKE User Guide Version 1.3 Content QTAKE! 7 BEFORE YOU START! 20 ABOUT! 7 TOUCHSCREEN UI! 21 QTAKE MODULES! 7 USER INTERFACE! 21 BASE! 7 SCREEN ZONES! 24 EDIT! 7 CUSTOM UI LAYOUT! 26 COMPOSITE! 7 OUTPUT! 8 VISUAL KEYBOARDS! 27 EXPORT! 8 KEYBOARD SHORTCUTS! 28 LINK! 8 ROOMS! 28 X2! 8 FILE! 28 MUXER! 8 SHOOT! 28 STREAM! 8 EDIT! 28 SCOPES! 8 COMPOSITE! 28 X4! 9 STUDIO! 28 STUDIO! 9 CGI! 9 FILE ROOM! 29 GRADE! 9 QTAKE! 29 4K! 9 USERS! 29 QTAKE SHOP! 10 PROJECTS! 30 SOFTWARE REQUIREMENTS! 11 CREATE NEW PROJECT! 30 Recommended versions of QTAKE Monitor and QTAKE Server! 11 CODEC! 32 HARDWARE! 11 AUTO-LOAD! 32 CONNECTION DIAGRAM! 12 USER OPTIONS! 33 QTAKE HDx1 Apple MacBook Pro! 13 STATUS BAR! 34 QTAKE LITE HARDWARE RECOMMENDATIONS! 14 IMPORT QT MOVIES! 35 QTAKE LITE Apple MacBook Pro! 14 LINK QT MOVIES! 35 QTAKE 4K HARDWARE RECOMMENDATIONS! 15 DRAG AND DROP IMPORT AND LINK! 35 QTAKE 4K Apple MacPro! 15 DISK SELECTION! 35 QTAKE HDx2 HARDWARE RECOMMENDATIONS! 16 FILENAME PARSING! 36 QTAKE HDx2 Apple MacPro! 16 3D LAYOUT! 36 QTAKE HDx2 Apple MacBook Pro! 17 STILL IMAGES! 37 QTAKE HDx4 HARDWARE RECOMMENDATIONS! 18 IMPORT CDL! 37 QTAKE HDx4 Apple MacPro! 18 IMPORT/LINK FROM QTAKE! 38 VIDEO CARDS! 19 EXPORT! 39 INSTALLATION! 20 EXPORT TO FCP! 39 Content Final Cut Pro 7! 39 FIRMWARE! 59 Final Cut Pro X! 39 RESET! 59 EXPORT TO AVID ALE! 40 REMOTE CONTROL! 60 EXPORT EDL! 41 MONITOR! 60 EXPORT TO QTAKE XML! 42 REMOTE CONTROL SETUP! 61 LICENSE INFO! 43 TALKBACK! 62 PROJECT INFO! 44 CONTROL SURFACES! 62 BIT DEPTH! 44 C-MOTION! 62 FULL RANGE VIDEO! 44 -

1. Operating Systems: 1

1 Krishna: 9849010760 Hi all, If u want any Software Cd’s or DVD’s call : +91 98490 10760 Or Mail : [email protected] 1. Operating Systems: 1. Windows 98 SE Boot CD ……… …………………………………….……….…….…100/- 2. Windows 95 Boot CD.……………………………………………….……………………100/- 3. Windows ME Boot CD ………………………………………………………….……..…100/- 4. Windows NT Server4.0 Boot CD ………………………………………….…….….……100/- 5. Windows NT Workstation Boot CD …………………………………..………………….100/- 6. Windows 2000 Prof Boot CD …………………………………………….…….….…….100/- 7. Windows 2000 Server Boot CD …………………….……………………..……..………100/- 8. Windows 2000 Adv Server Boot CD …………………………………………………….100/- 9. Windows XP Prof. Boot CD …………………………………………………….……..…100/- 10. Windows XP Prof. With Service Pack 1 (SP1) Boot CD…....……………………………100/- 11. Windows XP Prof. With Service Pack 2 (SP2) Boot CD…………………………..……..100/- 12. Windows 2003 Server Ent. Full Version Boot CD ……………………………………….100/- 13. Dos6.22 , WinNT Server, Win ME, Win97, Win98Se, Win NT Workstation……………100/- 14. Red hat Linux 7.2 Boot ……………………..……….………3 CD’s……………………150/- 15. Red hat Linux 8.0 Boot ……………..……………….……… 4 CD’s…………..…….….250/- 16. Red hat Linux 9.0 Boot ………………….….……….………7 CD’s……………………400/- 17. Fedora Core 1 (RH Linux 10.0) …………………………….. 5 CD’s………………..…..300/- 18. FEDORA CORE 3…………………………………………... 4 CD’s……………………250/- 19. Red Hat Linux Advanced Server 2.1AS …………………… 4 CD’s………………..…..250/- 20. Red Hat Enterprise Linux 3.0……………….……..…………4 CD’s……….……….…..300/- 21. SUSE Linux 8.0 Boot ……………………………… ……… 3 CD’s……..……………..200/- 22. Suse Linux 9.1 Prof …………………………….……………5 CD’s….………………..300/- 23. Sco-Unix 5.05. Boot ……………………………………………….……………………..100/- 24. Sco-Unix 7.1.1 Boot ……………………………………..…. 4 CD’s…….…….………..300/- 25. Novel Netware 6.0 ……………………………….…………. 3 CD’s……………..……..250/- 26. -

Tivo Hacks by Raffi Krikorian

This document is created with the unregistered version of CHM2PDF Pilot ÿØÿà This document is created with the unregistered version of CHM2PDF Pilot This document is created with the unregistered version of CHM2PDF Pilot TiVo Hacks By Raffi Krikorian Publisher: O'Reilly Pub Date: August 2003 ISBN: 0-596-00553-9 Copyright Credits About the Author Contributors Preface What Is a TiVo? How to Use This Book Caveat Hacker How This Book Is Organized Conventions Used in This Book How to Contact Us Chapter 1. TiVo Remote Control Hacks Section 1.1. Hacks #1-19 Section 1.2. Remote Control Hacks Section 1.3. Backdoor Hacks Hack 1. Swinging TiVo Hack 2. Must-Skim TV Hack 3. Navigation Shortcuts Hack 4. The 30-Second Skip Hack 5. An Onscreen Clock Hack 6. Making the Play Bar Disappear Faster Hack 7. What's Your TiVo Doing? Hack 8. Opening the Backdoor Hack 9. Italicizing Everything Hack 10. Sorting the Now Playing List Hack 11. Turning Off Overshoot Protection Hack 12. Controlling Overshoot Protection Hack 13. Pushing Fast Forward to Eleven Hack 14. Viewing Suggestions in the To Do List Hack 15. Viewing "Hidden" Recordings Hack 16. Activating the Node Navigator Hack 17. Enabling Advanced WishLists Hack 18. Turning Off the TiVo Software Hack 19. Applaud the TiVo Team Chapter 2. Adding More Hours Section 2.1. Hacks #20-28 Section 2.2. Basic Assumptions Section 2.3. Gathering Some Information Section 2.4. Getting Everything Together Hack 20. Opening the Box Hack 21. Removing TiVo's Hard Drive or Drives Hack 22. -

MASTER's THESIS Integrating Video Support Into the New Woize SIP-Client

2007:201 CIV MASTER'S THESIS Integrating Video Support into the New Woize SIP-client Fredrik Karlsson Luleå University of Technology MSc Programmes in Engineering Media Technology Department of Computer Science and Electrical Engineering Division of Media Technology 2007:201 CIV - ISSN: 1402-1617 - ISRN: LTU-EX--07/201--SE Integrating video support into the new Woize SIP-client Fredrik Karlsson May 15, 2007 Abstract With VoIP services becoming more and more popular and, even beginning to compete with the PSTN (Public Switched Telephone Network) in terms of prices and wide use, companies that provides this service has to evolve to keep their customers and be competitive. Woize Ltd. is one of these companies and as a mean to strengthen their position on the market they want to integrate video call support and video conferencing to their new VoIP-client. This thesis is aimed at helping Woize Ltd. choosing an appropriate video codec and finding an appropriate API for integrating video into their new SIP-powered VoIP-client. The decisions and paths taken in this work are all a product of Woize Ltd's requirements and preferences. In this report there is a description of how and why the codec and API were chosen. The report then describes the API, its features and, the problems that were encountered when setting it up on two of the platforms Woize Ltd are aiming for. Different encoding tweaks of the Theora codec are also tried out to see what quality is acceptable with different bitrates. These are the main objectives. Further on an attempt on implementing a reference model for streaming video on different platforms are conducted, which proved to be more problematic than was expected in the beginning. -

Endpoint Product Matrix

Endpoint Product Matrix © 2014 Cisco and/or its affiliates. All rights reserved. 1 © 2014 Cisco and/or its affiliates. All rights reserved. Collboration Room Systems Desk Immersive IP Phones Peripherals MX200 G2 MX300 G2 MX700 MX800 SX10 Quick Set SX20 Quick Set SX80 Feature/Functionality Form Factor One 42-inch screen integrated One 55-inch screen integrated Dual 55-inch screen integrated system Single 70-inch scren integrated system Camera-in-codec unit with Camera and codec with Codec only; integrator packages system system microphone and remote control; microphone and remote control; available with Touch control and monitor not included monitor not included camera options Integrator packages: Ȥ Cisco SX80 Codec, PHD 1080p 4x Camera, and Touch 10 Ȥ Cisco SX80 Codec, Precision 60 Camera, and Touch 10 Ȥ Cisco SX80 Codec, SpeakerTrack60 Microphone Array, and Touch10 Category Collaboration Endpoints - Room Collaboration Endpoints - Room Collaboration Endpoints - Room System Collaboration Endpoints - Room System Collaboration Endpoints - Collaboration Endpoints - Collaboration Endpoints - Room-based System System Room-based Solution Room-based Solution Solution Key Features 42-inch screen endpoint o!ers 55-inch endpoint o!ers high-quality, Dual 55-inch LED sceen system turns any 70 inch LED screen system turns SX10 Quick Set is an all-in-one SX20 Quick Set is designed to SX80 is a powerful codec platform to high-quality, easy-to-use video easy-to-use video collaboration medium-to-large meeting room into a video any medium-to-large meeting -

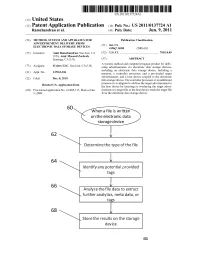

\ Identity Any Potential Provided \ Tags

US 20110137724Al (19) United States (12) Patent Application Publication (10) Pub. No.: US 2011/0137724 A1 Ramchandran et al. (43) Pub. Date: Jun. 9, 2011 (54) METHOD, SYSTEM AND APPARATUS FOR Publication Classi?cation ADVERTISEMENT DELIVERY FROM (51) Int Cl ELECTRONIC DATA STORAGE DEVICES G06Q 30/00 (200601) Inventors: (US); Ramchandran’Amir Masoud Zarkesh, San Jose’ US. Cl- . .. Saratoga, CA (US) (57) ABSTRACT _ _ _ A system, method and computer program product for deliv (73) Asslgnee' lcelero LLC’ San Jose’ CA (Us) ering advertisements via electronic data storage devices, _ including an electronic data storage device, including a (21) Appl' NO" 12/963’306 memory, a controller processor, and a pre-loaded target (22) Filed Dec 8 2010 advertisement; and a host device coupled to the electronic . , data storage device. The controller processor or an additional . processor is con?gured to deliver the target advertisement to Related U's' Apphcatlon Data the host device by inserting or overlaying the target adver (60) Provisional application No, 61/285,1 17 , ?led on Dec, tisement in a target ?le as the host device reads the target ?le 9, 2009. from the electronic data storage device. When a file is written on the electronic data storage device \ Determine the type of the ftte 64 \ identity any potential provided \ tags 66 . \ Anatyze the tlte data to extract \ further analytics, meta data, or tavs \ Store the resutts on the storage device Patent Application Publication Jun. 9, 2011 Sheet 1 0f 4 US 2011/0137724 A1 m 18 2426 1 FIG.1 Patent Application Publication Jun. -

„ Wo 2011/072044 A2

(12) INTERNATIONAL APPLICATION PUBLISHED UNDER THE PATENT COOPERATION TREATY (PCT) (19) World Intellectual Property Organization International Bureau „ (10) International Publication Number (43) International Publication Date _ . ... , _ 16 June 2011 (16.06.2011) WO 2011/072044 A2 (51) International Patent Classification: (81) Designated States (unless otherwise indicated, for every G06Q 30/00 (2006.01) kind of national protection available): AE, AG, AL, AM, AO, AT, AU, AZ, BA, BB, BG, BH, BR, BW, BY, BZ, (21) International Application Number: CA, CH, CL, CN, CO, CR, CU, CZ, DE, DK, DM, DO, PCT/US2010/0595 1 DZ, EC, EE, EG, ES, FI, GB, GD, GE, GH, GM, GT, (22) International Filing Date: HN, HR, HU, ID, IL, IN, IS, JP, KE, KG, KM, KN, KP, 8 December 2010 (08.12.2010) KR, KZ, LA, LC, LK, LR, LS, LT, LU, LY, MA, MD, ME, MG, MK, MN, MW, MX, MY, MZ, NA, NG, NI, (25) Filing Language: English NO, NZ, OM, PE, PG, PH, PL, PT, RO, RS, RU, SC, SD, (26) Publication Language: English SE, SG, SK, SL, SM, ST, SV, SY, TH, TJ, TM, TN, TR, TT, TZ, UA, UG, US, UZ, VC, VN, ZA, ZM, ZW. (30) Priority Data: 61/285,1 17 9 December 2009 (09.12.2009) US (84) Designated States (unless otherwise indicated, for every kind of regional protection available): ARIPO (BW, GH, (71) Applicant (for all designated States except US): GM, KE, LR, LS, MW, MZ, NA, SD, SL, SZ, TZ, UG, ICELERO LLC [US/US]; 1190 Saratoga Ave., Suite ZM, ZW), Eurasian (AM, AZ, BY, KG, KZ, MD, RU, TJ, 240, San Jose, CA 95 129 (US).