Intelligent Information Retrieval and Web Search

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Leaving Reality Behind Etoy Vs Etoys Com Other Battles to Control Cyberspace By: Adam Wishart Regula Bochsler ISBN: 0066210763 See Detail of This Book on Amazon.Com

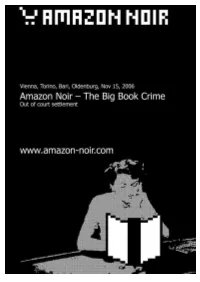

Leaving Reality Behind etoy vs eToys com other battles to control cyberspace By: Adam Wishart Regula Bochsler ISBN: 0066210763 See detail of this book on Amazon.com Book served by AMAZON NOIR (www.amazon-noir.com) project by: PAOLO CIRIO paolocirio.net UBERMORGEN.COM ubermorgen.com ALESSANDRO LUDOVICO neural.it Page 1 discovering a new toy "The new artist protests, he no longer paints." -Dadaist artist Tristan Tzara, Zh, 1916 On the balmy evening of June 1, 1990, fleets of expensive cars pulled up outside the Zurich Opera House. Stepping out and passing through the pillared porticoes was a Who's Who of Swiss society-the head of state, national sports icons, former ministers and army generals-all of whom had come to celebrate the sixty-fifth birthday of Werner Spross, the owner of a huge horticultural business empire. As one of Zurich's wealthiest and best-connected men, it was perhaps fitting that 650 of his "close friends" had been invited to attend the event, a lavish banquet followed by a performance of Romeo and Juliet. Defiantly greeting the guests were 200 demonstrators standing in the square in front of the opera house. Mostly young, wearing scruffy clothes and sporting punky haircuts, they whistled and booed, angry that the opera house had been sold out, allowing itself for the first time to be taken over by a rich patron. They were also chanting slogans about the inequity of Swiss society and the wealth of Spross's guests. The glittering horde did its very best to ignore the disturbance. The protest had the added significance of being held on the tenth anniversary of the first spark of the city's most explosive youth revolt of recent years, The Movement. -

The People Who Invented the Internet Source: Wikipedia's History of the Internet

The People Who Invented the Internet Source: Wikipedia's History of the Internet PDF generated using the open source mwlib toolkit. See http://code.pediapress.com/ for more information. PDF generated at: Sat, 22 Sep 2012 02:49:54 UTC Contents Articles History of the Internet 1 Barry Appelman 26 Paul Baran 28 Vint Cerf 33 Danny Cohen (engineer) 41 David D. Clark 44 Steve Crocker 45 Donald Davies 47 Douglas Engelbart 49 Charles M. Herzfeld 56 Internet Engineering Task Force 58 Bob Kahn 61 Peter T. Kirstein 65 Leonard Kleinrock 66 John Klensin 70 J. C. R. Licklider 71 Jon Postel 77 Louis Pouzin 80 Lawrence Roberts (scientist) 81 John Romkey 84 Ivan Sutherland 85 Robert Taylor (computer scientist) 89 Ray Tomlinson 92 Oleg Vishnepolsky 94 Phil Zimmermann 96 References Article Sources and Contributors 99 Image Sources, Licenses and Contributors 102 Article Licenses License 103 History of the Internet 1 History of the Internet The history of the Internet began with the development of electronic computers in the 1950s. This began with point-to-point communication between mainframe computers and terminals, expanded to point-to-point connections between computers and then early research into packet switching. Packet switched networks such as ARPANET, Mark I at NPL in the UK, CYCLADES, Merit Network, Tymnet, and Telenet, were developed in the late 1960s and early 1970s using a variety of protocols. The ARPANET in particular led to the development of protocols for internetworking, where multiple separate networks could be joined together into a network of networks. In 1982 the Internet Protocol Suite (TCP/IP) was standardized and the concept of a world-wide network of fully interconnected TCP/IP networks called the Internet was introduced. -

BACHELORARBEIT Browser Und Ihr Einfluss Auf Die Entwicklung Des

BACHELORARBEIT im Studiengang Informatik/Computer Science Browser und ihr Einfluss auf die Entwicklung des Web Ausgeführt von: Thomas Greiner Personenkennzeichen: 0910257037 BegutachterIn: Dipl.-Ing. Dr. Gerd Holweg Gols, 15.01.2012 Eidesstattliche Erklärung „Ich erkläre hiermit an Eides statt, dass ich die vorliegende Arbeit selbständig angefertigt habe. Die aus fremden Quellen direkt oder indirekt übernommenen Gedanken sind als solche kenntlich gemacht. Die Arbeit wurde bisher weder in gleicher noch in ähnlicher Form einer anderen Prüfungsbehörde vorgelegt und auch noch nicht veröffentlicht. Ich versichere, dass die abgegebene Version jener im Uploadtool entspricht.“ Gols, 15.01.2012 Ort, Datum Unterschrift Kurzfassung Der Browser ist von heutigen Computern nicht mehr wegzudenken. Seit der Entstehung des World Wide Web und mit ihm des ersten Browsers gab es Ereignisse, die die Geschichte beider maßgeblich verändert haben. Vom Ursprung des Web, über den ersten Browser Krieg zwischen Microsoft und Netscape und die folgende Ära des Internet Explorer 6, bis hin zu den Anfängen des heute noch vorherrschenden zweiten Browser Krieges, war es stets ein Auf und Ab, wenn es darum ging, das Web zu dem zu formen, wie wir es heute kennen. Die Frage, die sich hierbei auftut, ist doch, wie viel Einfluss die Browser tatsächlich auf die Entwicklung des Web gehabt haben oder ob möglicherweise sogar das Web die Entwicklung der Browser beeinflusst hat. Das ist die zentrale Frage hinter dieser Arbeit. Diese wird durch die Kombination aktueller Zahlen über die Marktanteile der jeweiligen Browser und Aussagen einflussreicher Personen wie Steve Jobs, Eric Schmidt und Mitchell Baker, sowie die Meinungen zweier österreichischer Unternehmer, die von ihren Erfahrungen mit dem Web berichten, beantwortet. -

List of Internet Pioneers

List of Internet pioneers Instead of a single "inventor", the Internet was developed by many people over many years. The following are some Internet pioneers who contributed to its early development. These include early theoretical foundations, specifying original protocols, and expansion beyond a research tool to wide deployment. The pioneers Contents Claude Shannon The pioneers Claude Shannon Claude Shannon (1916–2001) called the "father of modern information Vannevar Bush theory", published "A Mathematical Theory of Communication" in J. C. R. Licklider 1948. His paper gave a formal way of studying communication channels. It established fundamental limits on the efficiency of Paul Baran communication over noisy channels, and presented the challenge of Donald Davies finding families of codes to achieve capacity.[1] Charles M. Herzfeld Bob Taylor Vannevar Bush Larry Roberts Leonard Kleinrock Vannevar Bush (1890–1974) helped to establish a partnership between Bob Kahn U.S. military, university research, and independent think tanks. He was Douglas Engelbart appointed Chairman of the National Defense Research Committee in Elizabeth Feinler 1940 by President Franklin D. Roosevelt, appointed Director of the Louis Pouzin Office of Scientific Research and Development in 1941, and from 1946 John Klensin to 1947, he served as chairman of the Joint Research and Development Vint Cerf Board. Out of this would come DARPA, which in turn would lead to the ARPANET Project.[2] His July 1945 Atlantic Monthly article "As We Yogen Dalal May Think" proposed Memex, a theoretical proto-hypertext computer Peter Kirstein system in which an individual compresses and stores all of their books, Steve Crocker records, and communications, which is then mechanized so that it may Jon Postel [3] be consulted with exceeding speed and flexibility. -

Use of Theses

THESES SIS/LIBRARY TELEPHONE: +61 2 6125 4631 R.G. MENZIES LIBRARY BUILDING NO:2 FACSIMILE: +61 2 6125 4063 THE AUSTRALIAN NATIONAL UNIVERSITY EMAIL: [email protected] CANBERRA ACT 0200 AUSTRALIA USE OF THESES This copy is supplied for purposes of private study and research only. Passages from the thesis may not be copied or closely paraphrased without the written consent of the author. The Irony of the Information Age: US Power and the Internet in International Relations Madeline Carr May, 2011 A thesis submitted for the degree of Doctor of Philosophy of The Australian National University Acknowledgements What a journey! It feels amazing to be writing this page. This has been an exercise in patience, perseverance and personal growth and I'm extremely grateful for the lessons I have learned throughout the past few years. Writing a doctoral thesis is challenging on many levels but I also considered it to be an extraordinary privilege. It is a time of reading, thinking and writing which I realize I was very fortunate to be able to indulge in and I have tried to remain very aware of that privilege. I began my PhD candidature with four others - Lacy Davey, Jason Hall, Jae·Jeok Park and Tomohiko Satake. The five of us spent many, many hours together reading one another's work, challenging one another's ideas and supporting one another through the ups and downs of life as a PhD candidate. We established a bond which will last our lifetimes and I count them dearly amongst the wonderful outcomes of this experience. -

World Wide Web - Wikipedia, the Free Encyclopedia

World Wide Web - Wikipedia, the free encyclopedia http://en.wikipedia.org/w/index.php?title=World_Wide_Web&printabl... World Wide Web From Wikipedia, the free encyclopedia The World Wide Web , abbreviated as WWW and commonly known as The Web , is a system of interlinked hypertext documents contained on the Internet. With a web browser, one can view web pages that may contain text, images, videos, and other multimedia and navigate between them by using hyperlinks. Using concepts from earlier hypertext systems, British engineer and computer scientist Sir Tim Berners Lee, now the Director of the World Wide Web Consortium, wrote a proposal in March 1989 for what would eventually become the World Wide Web. [1] He was later joined by Belgian computer scientist Robert Cailliau while both were working at CERN in Geneva, Switzerland. In 1990, they proposed using "HyperText [...] to link and access information of various kinds as a web of nodes in which the user can browse at will",[2] and released that web in December. [3] "The World-Wide Web (W3) was developed to be a pool of human knowledge, which would allow collaborators in remote sites to share their ideas and all aspects of a common project." [4] If two projects are independently created, rather than have a central figure make the changes, the two bodies of information could form into one cohesive piece of work. Contents 1 History 2 Function 2.1 What does W3 define? 2.2 Linking 2.3 Ajax updates 2.4 WWW prefix 3 Privacy 4 Security 5 Standards 6 Accessibility 7 Internationalization 8 Statistics 9 Speed issues 10 Caching 11 See also 12 Notes 13 References 14 External links History Main article: History of the World Wide Web In March 1989, Tim BernersLee wrote a proposal [5] that referenced ENQUIRE, a database and 1 of 13 2/7/2010 02:31 PM World Wide Web - Wikipedia, the free encyclopedia http://en.wikipedia.org/w/index.php?title=World_Wide_Web&printabl.. -

The Making of Netscape

The Making of Netscape This case was written by Professor Rajeev Kohli, Graduate School of Business, Columbia University, for class discussion rather than to illustrate either effective or ineffective handling of an administrative situation. 1 The Making of Netscape Marc Andreessen started working on the Mosaic web browser in 1992. He was a computer science student at the University of Illinois, but he spent a lot more time at the NCSA, the University’s supercomputing center, than he did in the classroom. “Working at NCSA was fascinating,” says Andreessen. “The super-computing program in the mid-1980's originated because the government thought it was crucial that a powerful computing infrastructure be provided for scientists. An interesting thing happened around 1990: all the supercomputing centers essentially stopped running supercomputers. They shut down the Crays. They could no longer afford to keep them running, especially with the advent of more cost efficient microprocessors. Since it no longer made sense to run a supercomputer, what do you do? And so networking quickly became a very big part of NCSA, the theory being that the next stage would be to link together everything -- especially scientists and educators who up until that point had been using the Crays. Networking had arrived so fast, and everything was happening so rapidly, that people just hadn't yet gotten around to making it accessible.” The Internet phenomenon had been gaining momentum for a decade, but its use was still limited to a small group of skilled programmers. “People had also been talking about hypertext for a long time, and it finally happened at NCSA,” says Andreessen. -

The Internet Governance Network Transcript of Interview with Vint Cerf

The Internet Governance Network Transcript of Interview with Vint Cerf Guest: Vint Cerf, Vice President and Chief Internet Evangelist for Google. He is responsible for identifying new enabling technologies and applications on the Internet and other platforms for the company. Widely known as a “Father of the Internet,” Vint is the co-designer with Robert Kahn of TCP/IP protocols and basic architecture of the Internet. In 1997, President Clinton recognized their work with the U.S. National Medal of Technology. Interviewers: Don Tapscott, Executive Director of Global Solution Networks and one of the world’s leading authorities on innovation, media and the economic and social impact of technology. He is CEO of the think tank The Tapscott Group and has authored 14 widely read books. In 2013, the Thinkers50 organization named him the 4th most important living business thinker. Steve Caswell, principal researcher, Global Solution Networks. An early pioneer of the digital age, he was founding editor of the Electronic Mail and Message Systems (EMMS) newsletter in 1977, author of the seminal book Email in 1988, and a principal architect of the AutoSkill Parts Locating Network. Steve teaches business and technology. The Interview: Cerf: By way of background, I can tell you that your GSN work is of particular interest to me, not simply because of my historical involvement in the Internet, but I've been charged by ICANN with organizing a committee to examine the Internet ecosystem and the institutions that are part of it and to speak to the role that those institutions have collectively and individually in maintaining this, you know, extraordinary global system. -

Web Authoring

Web Authoring A Brief History of the Internet 1The Internet today is a widespread information infrastructure, the initial prototype of what is often called the National (or Global or Galactic) Information Infrastructure. Its history is complex and involves many aspects - technological, organizational, and community. And its influence reaches not only to the technical fields of computer communications but throughout society as we move toward increasing use of online tools to accomplish electronic commerce, information acquisition, and community operations. A Brief History of the World Wide Web A global collection of text, graphics and sound resources on the Internet. At the end of the 1980s, one man's vision of a new way to store and retrieve data launched the technological journey to where we are today. BEFORE THE DAWN 1945 Vannevar Bush wrote in Atlantic Monthly about a memory extension — Memex — which was a photo-electrical- mechanical device that linked documents on microfiche. 1958 In response to the launch of Sputnik, the U.S. Defense Department established Advanced Research Projects Agency (ARPA), which eventually would focus on computer networking and communications technology. 1962 Doug Engelbart devised NLS — "oNLine System" — for browsing and editing information. In the process, he invented the computer mouse. 1965 Ted Nelson coined the name hypertext for a complex, changing, indeterminate file structure. Donald Davies at the UK National Physical Laboratory coined the terms packet and packet switching. 1969 ARPA started what would become the Internet when it created ARPANET connecting the University of California at Los Angeles (UCLA) with SRI International at Menlo Park, California, and then the University of California at Santa Barbara and the University of Utah. -

Moore's Law, Metcalfe'slaw, and Gilder's

Computing, Communication, and Cognition Three Laws that define the internet society: Moore’s, Gilder’s, and Metcalfe’s Dr. Jack M. Wilson Distinguished Professor of Higher Education, Emerging Technologies, and Innovation © 2012ff -Jack M. Wilson, Distinguished Professor Case: Moore’s, Metcalfe’s and Gilder’s Law 1 Moore’s Law • In 1965 Gordon Moore, co-founder of Fairchild Semiconductor and Intel wrote that the number of components on a computer chip were doubling every year. – Moore’s Law: https://en.wikipedia.org/wiki/Moore's_law • In 1975 he revised that to a two year doubling period, but as we look back at the data we can see that it was closer to 18 months. The exact number is not as important as the fact that the power of the computer chip was DOUBLING in a comparatively short time. This meant that: – Things that are hard to do today are easy tomorrow. – The cost of equivalent computing power is halving on a similar time scale. The cost is going down. – Designer need to plan ahead for implementations or risk being obsolete when introduced to the market! • Do not design for today. • Design for the deployment date. © 2012ff -Jack M. Wilson, Distinguished Professor Case: Moore’s, Metcalfe’s and Gilder’s Law 2 Moore’s Law • Moore’s Law is an expression of basic physics on silicon wafers on which computer chips are constructed. • It means the number of components double on each chip • It means that the device size gets smaller on each chip allowing more to be put in the same space. -

Who Invented the Internet? 1958-1961: Connect Computers?

How did the Internet come to be? ❒ It started as a research project to experiment with connecting computers together with packet switched 2: Internet History networks. It was developed with funding and leadership of the Defense Last Modified: Department’s Advanced Research Projects Agency (ARPA). 1/20/2003 12:46:58 PM -1 -2 Who invented the Internet? 1958-1961: Connect Computers? ❒ Al Gore? No ☺ ❒ 1958 – After USSR launches Sputnik, first artificial earth satellite, US forms the Advanced ❒ Leonard Kleinrock who did early work in Research Projects Agency (ARPA), the following packet switching? year, within the Department of Defense (DoD) to ❒ Vint Cerf and Robert Kahn who defined the establish US lead in science and technology "Internet Protocol" (IP) and participated in applicable to the military the development of TCP? ❒ 1961 – First published work on packet switching ❒ (“Information Flow in Large Communication Nets”, Tim Berners-Lee developed HTTP to Leonard Kleinrock, MIT graduate student) support a global hyper-text system he ❒ 1964 – other independent work in packet switching called the World Wide Web? (Internet vs at RAND Institute and National Physics the World Wide Web?) Laboratory in England -3 -4 1966 –1968: Connect 1969: First Connections Computers? Funded ❒ 1966 – Lawrence Roberts (colleague of ❒ 4/7/1969 – First RFC (“Host Software” by Kleinrock from MIT) publishes overall plan Steve Crocker) basis for the Network for an ARPAnet, a proposed packet switch Control Protocol(NCP) network ❒ 9/2/1969 – Leonard Kleinrock’s computer -

An Archetype for Outsiders in Technology Commercialization

AN ARCHETYPE FOR OUTSIDERS IN TECHNOLOGY COMMERCIALIZATION By Shane Greenstein Chapter for William Aspray, Historical Studies in Computing, Information, and Society: Insights from the Flatiron Lectures. (Springer history of computing series.) Springer Publishing; Cham, Switzerland. I. INTRODUCTION Many confrontations between insiders and outsiders have garnered attention in technology markets over several decades. What can we learn from these prominent confrontations? Is there anything common to them? This chapter presents an archetype of confrontations that highlights the distinctive perspective of an outsider. In this archetype insider refers to an established leading firm in a specific market, while outsiders are startups or historical non-participants in the insider’s market. The chapter interprets events as a conflict between the outsider’s novel point of view and the insider’s established point of view. To support this interpretation, the chapter examines numerous illustrations. In each, the outsider takes actions to gain customers, which leads to a reaction from the established firm. The archetype directs attention towards commercialization, the act of translating technical knowledge into valuable products and services, hereafter referred to as product(s). In this context valuable or value refers to market value, such as the price of a product and the profits of a firm, while commercialization is the less glamorous sibling to invention that translates inventions into value. Here the spotlight of inquiry focuses on the range of activities affiliated with designing the product’s attributes, as well as producing and distributing it – that is, offering it for sale, competing with others for buyer attention, and doing this at scale.