CEPH, Zarafa, Samba & Co

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Zentyal, El Servidor Linux Para Pymes

Zentyal, el servidor Linux para PYMEs Olvide las tareas complejas y repetiti- Zentyal es un servidor Linux para PYMEs, la alternativa en software libre a Windows Small vas para el manejo Business Server. Basado en Ubuntu, Zentyal permite administrar todos los servicios de una red informática, tales como el acceso a Internet, la seguridad y la infraestructura de la red, los de su red informática recursos compartidos o las comunicaciones, a través de una única plataforma. Todas estas funcionalidades están estrechamente integradas, automatizando la mayoría de las tareas y ahorrando tiempo en la administración de sistemas. El código abierto está ampliamente difundido Características clave Zentyal es un software de código abierto, el cual se puede descargar libremente de Internet. Gestiona fácilmente toda la infraestructura TIC de una Actualmente, existen decenas de miles de implantaciones en todo el mundo, superando las PYME 30.000 descargas mensuales y con una comunidad de unos 2.500 colaboradores activos. Igualmente, Zentyal (antes conocido como eBox Platform) es parte integral de la distribución Acceso al correo de la empresa Ubuntu desde 2008, lo que ayuda a aumentar su difusión y credibilidad como producto tec- desde el celular, el portátil o la nológico. Su uso está extendido a prácticamente todos los países del globo, siendo Estados web independientemente de su Unidos, Alemania, España, Italia y Brasil los países que cuentan con más instalaciones. Zentyal ubicación se usa principalmente en PYMEs, pero también en otros entornos como -

Guida a Ubuntu Server

Capitolo 6. Amministrazione remota Ci sono diversi modi per amministrare un server Linux da remoto; questa sezione illustra due dei metodi più comuni, come OpenSSH e Puppet. 81 Amministrazione remota 1. Server OpenSSH 1.1. Introduzione Questa sezione della Guida a Ubuntu server introduce una serie di potenti strumenti per il controllo remoto di computer e per il trasferimento di dati tra i computer in rete chiamata OpenSSH. Vengono spiegate alcune delle possibili impostazioni dell'applicazione server OpenSSH e come modificarne la configurazione in Ubuntu. OpenSSH è una versione libera della famiglia di protocolli e strumenti SSH (Secure SHell) per il controllo remoto di un computer o per il trasferimento di file tra computer. Gli strumenti tradizionali usati per svolgere queste funzioni, come telnet o rcp, sono insicuri e quando utilizzati trasmettono la password dell'utente in chiaro. OpenSSH fornisce un demone server e degli strumenti lato client per facilitare operazioni di controllo remoto e trasferimento di file in sicurezza e con crittografia, sostituendo in modo completo gli strumenti tradizionali. Il componente server di OpenSSH, sshd, è in ascolto continuo per le connessioni in arrivo dei client, qualunque sia lo strumento usato sui client. Quando avviene una richiesta di connessione, per mezzo di sshd viene impostata la corretta connessione in base allo strumento utilizzato dal client. Per esempio, se il computer remoto sta effettuando una connessione con l'applicazione client ssh, il server OpenSSH imposta, dopo l'autenticazione, una sessione di controllo remoto. Se un utente remoto si connette a un server OpenSSH con scp, il demone server OpenSSH inizializza, dopo l'autenticazione, una procedura di copia sicura di file tra il server e il client. -

Ubuntu Server Guide Ubuntu Server Guide Copyright © 2016 Contributors to the Document

Ubuntu Server Guide Ubuntu Server Guide Copyright © 2016 Contributors to the document Abstract Welcome to the Ubuntu Server Guide! It contains information on how to install and configure various server applications on your Ubuntu system to fit your needs. It is a step-by-step, task-oriented guide for configuring and customizing your system. Credits and License This document is maintained by the Ubuntu documentation team (https://wiki.ubuntu.com/DocumentationTeam). A list of contributors is below. This document is made available under the Creative Commons ShareAlike 3.0 License (CC-BY-SA). You are free to modify, extend, and improve the Ubuntu documentation source code under the terms of this license. All derivative works must be released under this license. This documentation is distributed in the hope that it will be useful, but WITHOUT ANY WARRANTY; without even the implied warranty of MERCHANTABILITY or FITNESS FOR A PARTICULAR PURPOSE AS DESCRIBED IN THE DISCLAIMER. A copy of the license is available here: Creative Commons ShareAlike License1. Contributors to this document are: • Members of the Ubuntu Documentation Project2 • Members of the Ubuntu Server Team3 • Contributors to the Community Help Wiki4 • Other contributors can be found in the revision history of the serverguide5 and ubuntu-docs6 bzr branches available on Launchpad. 1 https://creativecommons.org/licenses/by-sa/3.0/ 2 https://launchpad.net/~ubuntu-core-doc 3 https://launchpad.net/~ubuntu-server 4 https://help.ubuntu.com/community/ 5 https://bazaar.launchpad.net/~ubuntu-core-doc/serverguide/trunk/changes 6 https://bazaar.launchpad.net/~ubuntu-core-doc/ubuntu-docs/trunk/changes Table of Contents 1. -

Ingeniero En Sistemas Informáticos Tema: Virtual

UNIVERSIDAD TECNOLÓGICA ISRAEL TRABAJO DE TITULACIÓN EN OPCIÓN AL GRADO DE: INGENIERO EN SISTEMAS INFORMÁTICOS TEMA: VIRTUALIZACIÓN DE LOS SERVICIOS TECNOLÓGICOS CON SOFTWARE LIBRE EN EL HOSPITAL GERIÁTRICO DR. BOLÍVAR ARGUELLO PROAÑO DE LA CIUDAD DE RIOBAMBA (“HGBA”). AUTORES: SILVA PILLAJO RICHARD JESÚS GALLARDO DELGADO FELIPE ESTEBAN TUTOR: MG. IVÁN FERNANDO ANDOCILLA OLEAS QUITO, ECUADOR 2018 DECLARACIÓN DE AUTORÍA El documento de tesis con título: “VIRTUALIZACIÓN DE LOS SERVICIOS TECNOLÓGICOS CON SOFTWARE LIBRE EN EL HOSPITAL GERIÁTRICO DR. BOLÍVAR ARGUELLO PROAÑO DE LA CIUDAD DE RIOBAMBA (“HGBA”)”, ha sido desarrollado por los señores GALLARDO DELGADO FELIPE ESTEBAN y SILVA PILLAJO RICHARD JESÚS con C.C. No. 1725483349 y C.C. No 1712161106 respectivamente, personas que poseen los derechos de autoría y responsabilidad, restringiéndose la copia o utilización de la información de esta tesis sin previa autorización. ________________ FELIPE ESTEBAN GALLARDO DELGADO ________________ RICHARD JESÚS SILVA PILLAJO i UNIVERSIDAD TECNOLÓGICA ISRAEL APROBACIÓN DEL TUTOR En mi calidad de tutor del trabajo de titulación certifico: Que el trabajo de titulación VIRTUALIZACIÓN DE LOS SERVICIOS TECNOLÓGICOS CON SOFTWARE LIBRE EN EL HOSPITAL GERIÁTRICO DR. BOLÍVAR ARGUELLO PROAÑO DE LA CIUDAD DE RIOBAMBA (“HGBA”). Presentado por los señores: GALLARDO DELGADO FELIPE ESTEBAN, SILVA PILLAJO RICHARD JESÚS estudiantes de la carrera de Sistemas de Información, reúnen los requisitos y méritos suficientes para ser sometidos a la evaluación del Tribunal de Grado, que se designe, para su correspondiente estudio y calificación. Quito D.M. Junio del 2018 TUTOR ……………………………. Ing. Iván Andocilla ii DEDICATORIA En cada una de las letras de este proyecto va dedicado a nuestros padres quienes nos apoyaron para seguir adelante en la vida, y a los profesores de la Universidad Tecnológica Israel quienes en todo este tiempo nos supieron instruir en valores y conocimientos. -

Zentyal Server Offers Native Microsoft® Exchange and Active Directory® Protocols on Linux

Zentyal Server Zentyal Server offers native Microsoft® Exchange and Active Directory® protocols on Linux. Zentyal Mail Native interoperability with Microsoft® Exchange Server Protocols and Microsoft Active Directory® means your Outlook® just works. It makes integration easy and saves you money. + Native compatibility with Microsoft® Exchange Server Protocols. + Native compatibility with Microsoft Active Directory®. + Multiple Virtual Mail Domains. + Email, Calendars & Contacts. + Native Microsoft Outlook® Support. + Support for Mobile Devices. Zentyal Directory Includes Native compatibility with Microsoft Active Directory®. You can control your IT infrastructure from a single point of user management, regardless of the different offices and locations your business has. + Native compatibility with Microsoft Active Directory®. + Central Management of Users & Groups. + Native Support for Windows® hosts. Request your trial at www.zentyal.com/trial Zentyal Server www.zentyal.com | [email protected] Technical Specifications Zentyal Mail Zentyal Directory Native compatibility with Microsoft® Exchange Server Protocols Native compatibility with Microsoft Active Directory® Software integrated: OpenChange®, Postfix, Dovecot, Sieve, Fetchmail Central domain directory management Native compatibility with Microsoft Active Directory® Users, Security Groups, Distribution Lists, Contacts Single Sign-On (SSO) authentication Multiple Organizational Units (OUs) & Group Policy Objects (GPOs) Administration through Zentyal or Microsoft Active Directory® NETLOGON -

Activesync Compatibility (Z-Push)

Zarafa Mobile Compatibility – September 2013 BlackBerry Enterprise Server (BES) ActiveSync compatibility (Z-Push) Delft | Hannover | Stuttgart | Belo Horizonte Elektronicaweg 20, 2628 XG Delft | T: +31 15 2517715 | www.zarafa.com | [email protected] Zarafa Mobile Compatibility – September 2013 Introduction Zarafa enables end users to work with mobile devices using different technologies. Our main focus is to provide the best mobile experience and integration of ActiveSync compatible devices over Z-Push (http://z-push.sf.org ) for push mail, calendars tasks and notes. BlackBerry BlackBerry has enabled Activesync support in their latest series with the BlackBerry 10 operating system. Z-Push development followed this move and provides full support of this device class. Zarafa equally adjusted to the changed strategy and will not support BES for these newer series. Older BlackBerry devices can be integrated over RIM infrastructure using the BlackBerry Enterprise Server (BES) version 4 and 5, BlackBerry Professional Software (BPS) version 4 and BlackBerry Enterprise Server Express. See a brief overview of the supported versions below. Other informations and additional informations about the BlackBerry integration can be found in the Zarafa wiki . Please check the supported BES version list before installation: Supported versions 4.1.0 to 4.1.3 Unknown 4.1.4 to 4.1.6 Known to work 4.1.7 Does not work 5.0.1 to 5.0.2 Working with ZCP 6.30.15+, 6.40.x and 7.0 5.0.3 Working with ZCP 6.40.10+, 7.0.1+ and 7.1.x Later versions Not supported anymore. Please use Z-Push synchronization. -

Beyond Technical Fulfillment

Beyond Technical Fulfillment SambaXP 2014 May 15th, 2014 Julien Kerihuel [email protected] Contents ● About me ● Introduction ● Yesterday: since SambaXP 2013 ● Today ● Tomorrow 2 of 42 www.openchange.org 15/05/14 OpenChange The World Julien Kerihuel - Zentyal CTO @jkerihuel OpenChange Project Founder > 10 years of my life Free Software foundations: wireshark, samba December 2003 – February 2005: OpenChange - End of Study Project 3 of 42 www.openchange.org 15/05/14 OpenChange The World Introduction 4 of 42 www.openchange.org 15/07/2013 OpenChange The World What is OpenChange? ● Started in 2004 ● Free Software released under GPLv3 or later ● Portable Implementation of Microsoft Exchange Server and Exchange protocols ● Complete solution to interoperate with Microsoft Outlook clients and Microsoft Exchange Servers ● Plugin for Samba4 NO OUTLOOK PLUGIN REQUIRED 5 of 42 www.openchange.org 15/05/14 OpenChange The World Interoperability and coverage ● OpenChange server works with: MICROSOFT MICROSOFT MICROSOFT MICROSOFT OUTLOOK 2003 OUTLOOK 2007 OUTLOOK 2010 OUTLOOK 2013 ● OpenChange client stack works with: EXCHANGE 5.5 EXCHANGE 2000 EXCHANGE 2003 EXCHANGE 2007 SBS 2003 SBS 2007 SBS 2010 EXCHANGE 2010 EXCHANGE 2013 6 of 42 www.openchange.org 15/05/14 OpenChange The World Server Architecture Overview 7 of 42 www.openchange.org 15/05/14 OpenChange The World Yesterday Since SambaXP 2013 8 of 42 www.openchange.org 15/07/2013 OpenChange The World The nightmare ● Full OpenChange deployment required: Dovecot Postfix MySQL or SOGo Courier-IMAP -

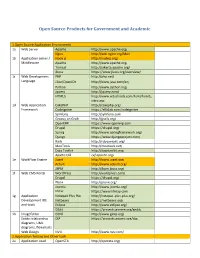

Open Source Products for Government and Academic

Open Source Products for Government and Academic 1.Open Source Application Environment 1a Web Server Apache http://www.apache.org/ Nginx http://wiki.nginx.org/Main 1b Application server / Node.js http://nodejs.org/ Middleware Apache http://www.apache.org/ Tomcat http://jakarta.apache.org/ Jboss https://www.jboss.org/overview/ 1c Web Development PHP http://php.net/ Language J2ee/OpenJDK http://www.java.com/en/ Python http://www.python.org/ Jquery http://jquery.com/ HTML5 http://www.w3schools.com/html/html5_ intro.asp 1d Web Application CakePHP http://cakephp.org/ Framework CodeIgniter https://ellislab.com/codeigniter Symfony http://symfony.com Groovy on Grails http://grails.org/ OpenERP https://www.openerp.com Drupal https://drupal.org/ Spring http://www.springframework.org/ Django https://www.djangoproject.com/ Rails http://rubyonrails.org/ MooTools http://mootools.net/ Dojo Toolkit http://dojotoolkit.org/ Apache CXF cxf.apache.org/ 1e WorkFlow Engine Joget http://www.joget.org/ Activiti http://www.activiti.org/ JBPM http://jbpm.jboss.org/ 1f Web CMS Portal WordPress http://wordpress.com/ Drupal https://drupal.org/ Plone http://plone.org/ Joomla http://www.joomla.org/ Liferay https://www.liferay.com 1g Application Notepad Plus Plus http://notepad-plus-plus.org/ Development IDE Netbeans https://netbeans.org/ and tools Eclipse http://www.eclipse.org/ GEdit https://projects.gnome.org/gedit/ 1h ImageEditor GIMP http://www.gimp.org/ Entity relationship DIA https://projects.gnome.org/dia/ diagrams, UML diagrams, flowcharts Web Design NVU http://www.nvu.com/ -

Autor: Aicniel López Pérez. Tutor: M.Sc. Manuel Castro Artiles

Departamento De Computación Título: Propuesta de servicios básicos de redes con software libre. Autor: Aicniel López Pérez. Tutor: M.Sc. Manuel Castro Artiles Curso 2017-2018 "Año 60 de la Revolución" Este documento es Propiedad Patrimonial de la Universidad Central “Marta Abreu” de Las Villas, y se encuentra depositado en los fondos de la Biblioteca Universitaria “Chiqui Gómez Lubian” subordinada a la Dirección de Información Científico Técnica de la mencionada casa de altos estudios. Se autoriza su utilización bajo la licencia siguiente: Atribución- No Comercial- Compartir Igual Para cualquier información contacte con: Dirección de Información Científico Técnica. Universidad Central “Marta Abreu” de Las Villas. Carretera a Camajuaní. Km 5½. Santa Clara. Villa Clara. Cuba. CP. 54 830 Teléfonos.: +53 01 42281503-1419 El que suscribe Aicniel López Pérez, hago constar que el trabajo titulado Propuesta de servicios básicos de redes con software libre. fue realizado en la Universidad Central “Marta Abreu” de Las Villas como parte de la culminación de los estudios de la especialidad de Licenciatura en Ciencia de la Computación, autorizando a que el mismo sea utilizado por la institución, para los fines que estime conveniente, tanto de forma parcial como total y que además no podrá ser presentado en eventos ni publicado sin la autorización de la Universidad. ______________________ Firma del Autor Los abajo firmantes, certificamos que el presente trabajo ha sido realizado según acuerdos de la dirección de nuestro centro y el mismo cumple con los requisitos que debe tener un trabajo de esta envergadura referido a la temática señalada. ____________________________ ___________________________ Firma del Tutor Firma del Jefe del Laboratorio PENSAMIENTO Hay hombres que luchan un día y son buenos. -

Ups, Firstboot, Ip6tables, Isdn, Sendmail, Iptables Y Yum-Updatesd

UNIVERSIDAD POLITÉCNICA SALESIANA SEDE QUITO-CAMPUS SUR CARRERA INGENIERÍA DE SISTEMAS MENCIÓN (ROBÓTICA E INTELIGENCIA ARTIFICIAL) INVESTIGACIÓN, ANÁLISIS E IMPLEMENTACIÓN DE UN SERVIDOR DE VIRTUALIZACIÓN DEDICADO PARA INTEGRAR UN SERVIDOR DE CORREO ZIMBRA VIRTUALIZADO CON UN SERVIDOR MULTITAREA ZENTYAL FÍSICO COMO CONTROLADOR DE DOMINIO, FIREWALL Y PROXY UTILIZANDO HERRAMIENTAS COMO TECNOLOGÍAS DE SOFTWARE LIBRE. HENRRY ROLANDO PADILLA CEVALLOS DIRECTOR: RENATO CUMBAL Quito, Junio 2012 1 DECLARACIÓN Yo Henrry Rolando Padilla Cevallos declaro bajo juramento que el trabajo aquí descrito es de autoría propia, por ser auspiciado por la Empresa Movidatos para su realización. El proyecto de tesis que no ha sido previamente presentada para ningún grado o calificación profesional. A través de la presente declaración concedo los derechos de propiedad intelectual correspondientes a este trabajo, a la Universidad Politécnica Salesiana, según lo establecido por la Ley de Propiedad Intelectual, por su Reglamento y por la normatividad institucional vigente. Henrry Rolando Padilla Cevallos. 2 No hay metas inalcanzables ni tampoco sueños imposibles de realizar, cada logro en tu vida es una meta cumplida y cada sueño realizado es un logro en la misma, los sueños que se cumplen en el camino de la vida nos ayuda a ser cada vez mejores por que lograr una meta es cumplir un ciclo en la vida. 3 CERTIFICACIÓN. Certifico que el presente trabajo fue desarrollado por Henrry Rolando Padilla Cevallos bajo mi dirección y el cual se ha concluido a entera satisfacción su Tesis de Grado. ------------------------------------------------------ Ing. Renato Cumbal. DIRECTOR DE TESIS ------------------------------------------------------ Ing. Daniel Díaz. LECTOR DE TESIS 4 AGRADECIMIENTO Doy gracias a Dios por darme salud, vida, corazón para seguir adelante ya que siempre será mi guía, mi fortaleza. -

![Zentyal Linux Small Business Server 2013 Julien Kerihuel – Zentyal CTO [ Jkerihuel@Zentyal.Com ] What Is Zentyal?](https://docslib.b-cdn.net/cover/2517/zentyal-linux-small-business-server-2013-julien-kerihuel-zentyal-cto-jkerihuel-zentyal-com-what-is-zentyal-5992517.webp)

Zentyal Linux Small Business Server 2013 Julien Kerihuel – Zentyal CTO [ [email protected] ] What Is Zentyal?

Zentyal Linux small business server 2013 Julien Kerihuel – Zentyal CTO [ [email protected] ] What is Zentyal? 2 of 26 5/22/13 Linux small business server www.zentyal.com What is Zentyal? Linux server for SMBs ● Full-featured server to manage all IT infrastructure ● Easy-to-use graphical user interface ● Secure and reliable ● Fully supported at an affordable price Alternative to Microsoft infrastructure ● Windows SBS, Windows Server ● Microsoft Exchange ● Windows Forefront ● and other UTMs (Checkpoint, Fortigate, Sonicwall, Webmarshall) 3 of 26 5/22/13 Linux small business server www.zentyal.com Why to choose Zentyal? Total solution ● All-in-one solution made for SMBs ● Guarantee system security and uptime ● Fully supported by Ubuntu | Canonical Affordable ● Save license costs ● Rationalize spending Easy ● No need to worry about IT infrastructure management ● Focus on your customers and your core-business 4 of 26 5/22/13 Linux small business server www.zentyal.com Working Together 5 of 26 5/22/13 Linux small business server www.zentyal.com Who uses Zentyal? Small-medium businesses and organizations ● +20,000 subscribed servers ● Regardless of sector, industry or location Large businesses and organizations ● Banks, hospitals, manufacturers, supermarket chains... Public administrations ● Education, IT, health, taxation, police, military... 6 of 26 5/22/13 Linux small business server www.zentyal.com The Zentyal project ● 9 years (started in 2004) ● 100% open source GPL-2 ● In Ubuntu repositories since 2007 ● 8,000 community members and -

Curriculum Vitae

CURRICULUM VITAE Personal Information Name: Koen Diels Date of birth: December 25, 1988 Nationality: Belgian Location: Mechelen Marital status: Married Phone: +3215804321 E-mail: jobs @koendiels.be MBTI: INTJ Employment 2018-2019 Site Reliability Engineer FEDNOT - Replacing the existing Red Hat Satellite 6.2 with a new and highly automated Satellite 6.3 and upgraded afterwards to 6.4 - Designing and implementing a Linux provisioning setup using Preseed/Kickstart/ Satellite/Ansible that is UEFI compatible and also uses SecureBoot and full disk encryption on the company laptops - Designing and implementing a security compliance strategy for the Linux (Ubuntu/RedHat/CentOS/Debian/SUSE) based landscape using OpenScap - Creating a workflow for Linux patching - Setting up fully automated deployment for Ubuntu based desktop environments with central management using ansible-pull - Reorganizing, sanitizing and making an inventory of the legacy servers - Creating Linux training environments - Setting up central access management using KeyManager - Creating the deployment pipeline/test environment for Bamboo/Nexus/Git/Docker - Started to move applications and services to containers - Setting up Kubernetes environment for development - Started the Site Reliability Team - Audited the infrastructure and created a list of potential budget cuts accordingly 2018 Infrastructure Engineer Ypto NV (IT provider for the National Railway Company of Belgium) - Replacing the existing Red Hat Satellite 6.1 with a new and highly automated Satellite 6.3 - Designing