A Method for Indexing

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Ontotext Platform Documentation Release 3.4 Ontotext

Ontotext Platform Documentation Release 3.4 Ontotext Apr 16, 2021 CONTENTS 1 Overview 1 1.1 30,000ft ................................................ 2 1.2 Layered View ............................................ 2 1.2.1 Application Layer ...................................... 3 1.2.1.1 Ontotext Platform Workbench .......................... 3 1.2.1.2 GraphDB Workbench ............................... 4 1.2.2 Service Layer ........................................ 5 1.2.2.1 Semantic Objects (GraphQL) ........................... 5 1.2.2.2 GraphQL Federation (Apollo GraphQL Federation) ............... 5 1.2.2.3 Text Analytics Service ............................... 6 1.2.2.4 Annotation Service ................................ 7 1.2.3 Data Layer ......................................... 7 1.2.3.1 Graph Database (GraphDB) ........................... 7 1.2.3.2 Semantic Object Schema Storage (MongoDB) ................. 7 1.2.3.3 Semantic Objects for MongoDB ......................... 8 1.2.3.4 Semantic Object for Elasticsearch ........................ 8 1.2.4 Authentication and Authorization ............................. 8 1.2.4.1 FusionAuth ..................................... 8 1.2.4.2 Semantic Objects RBAC ............................. 9 1.2.5 Kubernetes ......................................... 9 1.2.5.1 Ingress and GW .................................. 9 1.2.6 Operation Layer ....................................... 10 1.2.6.1 Health Checking .................................. 10 1.2.6.2 Telegraf ....................................... 10 -

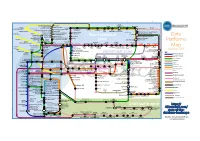

Data Platforms Map from 451 Research

1 2 3 4 5 6 Azure AgilData Cloudera Distribu2on HDInsight Metascale of Apache Kaa MapR Streams MapR Hortonworks Towards Teradata Listener Doopex Apache Spark Strao enterprise search Apache Solr Google Cloud Confluent/Apache Kaa Al2scale Qubole AWS IBM Azure DataTorrent/Apache Apex PipelineDB Dataproc BigInsights Apache Lucene Apache Samza EMR Data Lake IBM Analy2cs for Apache Spark Oracle Stream Explorer Teradata Cloud Databricks A Towards SRCH2 So\ware AG for Hadoop Oracle Big Data Cloud A E-discovery TIBCO StreamBase Cloudera Elas2csearch SQLStream Data Elas2c Found Apache S4 Apache Storm Rackspace Non-relaonal Oracle Big Data Appliance ObjectRocket for IBM InfoSphere Streams xPlenty Apache Hadoop HP IDOL Elas2csearch Google Azure Stream Analy2cs Data Ar2sans Apache Flink Azure Cloud EsgnDB/ zone Platforms Oracle Dataflow Endeca Server Search AWS Apache Apache IBM Ac2an Treasure Avio Kinesis LeanXcale Trafodion Splice Machine MammothDB Drill Presto Big SQL Vortex Data SciDB HPCC AsterixDB IBM InfoSphere Towards LucidWorks Starcounter SQLite Apache Teradata Map Data Explorer Firebird Apache Apache JethroData Pivotal HD/ Apache Cazena CitusDB SIEM Big Data Tajo Hive Impala Apache HAWQ Kudu Aster Loggly Ac2an Ingres Sumo Cloudera SAP Sybase ASE IBM PureData January 2016 Logic Search for Analy2cs/dashDB Logentries SAP Sybase SQL Anywhere Key: B TIBCO Splunk Maana Rela%onal zone B LogLogic EnterpriseDB SQream General purpose Postgres-XL Microso\ Ry\ X15 So\ware Oracle IBM SAP SQL Server Oracle Teradata Specialist analy2c PostgreSQL Exadata -

Benchmarking RDF Query Engines: the LDBC Semantic Publishing Benchmark

Benchmarking RDF Query Engines: The LDBC Semantic Publishing Benchmark V. Kotsev1, N. Minadakis2, V. Papakonstantinou2, O. Erling3, I. Fundulaki2, and A. Kiryakov1 1 Ontotext, Bulgaria 2 Institute of Computer Science-FORTH, Greece 3 OpenLink Software, Netherlands Abstract. The Linked Data paradigm which is now the prominent en- abler for sharing huge volumes of data by means of Semantic Web tech- nologies, has created novel challenges for non-relational data manage- ment technologies such as RDF and graph database systems. Bench- marking, which is an important factor in the development of research on RDF and graph data management technologies, must address these challenges. In this paper we present the Semantic Publishing Benchmark (SPB) developed in the context of the Linked Data Benchmark Council (LDBC) EU project. It is based on the scenario of the BBC media or- ganisation which makes heavy use of Linked Data Technologies such as RDF and SPARQL. In SPB a large number of aggregation agents pro- vide the heavy query workload, while at the same time a steady stream of editorial agents execute a number of update operations. In this paper we describe the benchmark’s schema, data generator, workload and re- port the results of experiments conducted using SPB for the Virtuoso and GraphDB RDF engines. Keywords: RDF, Linked Data, Benchmarking, Graph Databases 1 Introduction Non-relational data management is emerging as a critical need in the era of a new data economy where heterogeneous, schema-less, and complexly structured data from a number of domains are published in RDF. In this new environment where the Linked Data paradigm is now the prominent enabler for sharing huge volumes of data, several data management challenges are present and which RDF and graph database technologies are called to tackle. -

Graphdb-Free.Pdf

GraphDB Free Documentation Release 8.5 Ontotext Jun 17, 2019 CONTENTS 1 General 1 1.1 About GraphDB...........................................2 1.2 Architecture & components.....................................2 1.2.1 Architecture.........................................2 1.2.1.1 RDF4J.......................................3 1.2.1.2 The Sail API....................................4 1.2.2 Components.........................................4 1.2.2.1 Engine.......................................4 1.2.2.2 Connectors.....................................5 1.2.2.3 Workbench.....................................5 1.3 GraphDB Free............................................5 1.3.1 Comparison of GraphDB Free and GraphDB SE......................6 1.4 Connectors..............................................6 1.5 Workbench..............................................6 2 Quick start guide 9 2.1 Run GraphDB as a desktop installation...............................9 2.1.1 On Windows........................................ 10 2.1.2 On Mac OS......................................... 10 2.1.3 On Linux.......................................... 10 2.1.4 Configuring GraphDB................................... 10 2.1.5 Stopping GraphDB..................................... 11 2.2 Run GraphDB as a stand-alone server................................ 11 2.2.1 Running GraphDB..................................... 11 2.2.1.1 Options...................................... 11 2.2.2 Configuring GraphDB................................... 12 2.2.2.1 Paths and network settings........................... -

Remote Sensing

Remote Sens. 2015, 7, 9473-9491; doi:10.3390/rs70709473 OPEN ACCESS remote sensing ISSN 2072-4292 www.mdpi.com/journal/remotesensing Article Improving the Computational Performance of Ontology-Based Classification Using Graph Databases Thomas J. Lampoltshammer 1,2,* and Stefanie Wiegand 3 1 School of Information Technology and Systems Management, Salzburg University of Applied Sciences, Urstein Süd 1, Puch, Salzburg 5412, Austria 2 Department of Geoinformatics (Z_GIS), University of Salzburg, Schillerstrasse 30, Salzburg 5020, Austria 3 IT Innovation Centre, University of Southampton, Gamma House, Enterprise Road, Southampton SO16 7NS, UK; E-Mail: [email protected] * Author to whom correspondence should be addressed; E-Mail: [email protected]; Tel.: +43-50-2211 (ext. 1311); Fax: +43-50-2211 (ext. 1349). Academic Editors: Ioannis Gitas and Prasad S. Thenkabail Received: 31 March 2015 / Accepted: 17 July 2015 / Published: 22 July 2015 Abstract: The increasing availability of very high-resolution remote sensing imagery (i.e., from satellites, airborne laser scanning, or aerial photography) represents both a blessing and a curse for researchers. The manual classification of these images, or other similar geo-sensor data, is time-consuming and leads to subjective and non-deterministic results. Due to this fact, (semi-) automated classification approaches are in high demand in affected research areas. Ontologies provide a proper way of automated classification for various kinds of sensor data, including remotely sensed data. However, the processing of data entities—so-called individuals—is one of the most cost-intensive computational operations within ontology reasoning. Therefore, an approach based on graph databases is proposed to overcome the issue of a high time consumption regarding the classification task. -

Ontop: Answering SPARQL Queries Over Relational Databases

Undefined 0 (0) 1 1 IOS Press Ontop: Answering SPARQL Queries over Relational Databases Diego Calvanese a, Benjamin Cogrel a, Sarah Komla-Ebri a, Roman Kontchakov b, Davide Lanti a, Martin Rezk a, Mariano Rodriguez-Muro c, and Guohui Xiao a a Free University of Bozen-Bolzano {calvanese,bcogrel, sakomlaebri,dlanti,mrezk,xiao}@inf.unibz.it b Birkbeck, University of London [email protected] c IBM TJ Watson [email protected] Abstract. In this paper we present Ontop, an open-source Ontology Based Data Access (OBDA) system that allows for querying relational data sources through a conceptual representation of the domain of interest, provided in terms of an ontology, to which the data sources are mapped. Key features of Ontop are its solid theoretical foundations, a virtual approach to OBDA that avoids materializing triples and that is implemented through query rewriting techniques, extensive optimizations exploiting all elements of the OBDA architecture, its compliance to all relevant W3C recommendations (including SPARQL queries, R2RML mappings, and OWL 2 QL and RDFS ontologies), and its support for all major relational databases. Keywords: Ontop, OBDA, Databases, RDF, SPARQL, Ontologies, R2RML, OWL 1. Introduction vocabulary, models the domain, hides the structure of the data sources, and can enrich incomplete data with Over the past 20 years we have moved from a background knowledge. Then, queries are posed over world where most companies had one all-knowing this high-level conceptual view, and the users no longer self-contained central database to a world where com- need an understanding of the data sources, the relation panies buy and sell their data, interact with several between them, or the encoding of the data. -

Annotation of Existing Databases Using Semantic Web Technologies: Making Data More FAIR

Annotation of existing databases using Semantic Web technologies: making data more FAIR Johan van Soest1,2, Ananya Choudhury1, Nikhil Gaikwad1, Matthijs Sloep1, Michel Dumontier2, Andre Dekker1 1 Department of Radiation Oncology (MAASTRO), GROW School for Oncology and Devel- opmental Biology, Maastricht University Medical Centre+, Maastricht, the Netherlands 2 Institute of Data Science, Maastricht university, Maastricht, The Netherlands *[email protected] Abstract. Making data FAIR is an elaborate task. Hospitals and/or departments have to invest into technologies usually unknown and often do not have the re- sources to make data FAIR. Our work aims to provide a framework and tooling where users can easily make their data (more) FAIR. This framework uses RDF and OWL-based inferencing to annotate existing databases or comma-separated files. For every database, a custom ontology is build based on the database schema, which can be annotated to describe matching standardized terminolo- gies. In this work, we describe the tooling developed, and the current imple- mentation in an institutional datawarehouse pertaining over 3000 rectal cancer patients. We report on the performance (time) of the extraction and annotation process by the developed tooling. Furthermore, we do show that annotation of existing databases using OWL2-based reasoning is possible. Furthermore, we show that the ontology extracted from existing databases can provide a descrip- tion framework to describe and annotate existing data sources. This would tar- get mostly the “Interoperable” aspect of FAIR. Keywords: FAIR, annotations, terminologies, linked data. 1 Introduction Semantic interoperability has been a topic in medical informatics since the introduc- tion of the digital patient chart [1]. -

Graphs: Use Cases, Analytics and Linking

Big Knowledge Graphs: Use Cases, Analytics and Linking Company Importance and Similarity Demo Atanas Kiryakov LAMBDA Big Data School, Belgrade, June, 2019 Presentation Outline o Introduction o GraphDB o Use Cases o Market Intelligence Vision o Concept and Entity Awareness via Big Knowledge Graphs o FactForge: Showcase KG with 2B Statements o KG Analytics: Similarity and Importancе Mission We help enterprises to get better insights by interlinking: o Diverse databases & Unstructured information o Proprietary & Global data We master Knowledge graphs, combining several AI technologies: o Graph analytics, Text mining, Computer vision o Symbolic reasoning & Machine learning Essential Facts o Leader ✓ Semantic technology vendor established year 2000 ✓ Part of Sirma Group: 400 persons, listed at Sofia Stock Exchange o Profitable and growing ✓ HQ and R&D in Sofia, Bulgaria ✓ More than 70% of the commercial revenues from London and New York o Innovator: Attracted more than €10M in R&D funding o Trendsetter ✓ Member of: W3C, EDMC, ODI, LDBC, STI, DBPedia Foundation, Pistoia Alliance Ontotext GraphDB™ - Flagman Product Source: db-engines.com popularity ranking of graph databases Note: This is not ranking by revenues – such information is not available for most of the vendors Fancy Stuff and Heavy Lifting o We do advanced analytics: We predicted BREXIT ✓ 14 Jun 2016 whitepaper: #BRExit Twitter Analysis: More Twitter Users Want to Split with EU and Support #Brexit https://ontotext.com/white-paper-brexit-twitter-analysis/ o But most of the time we -

Graphdb Free Documentation Release 8.8

GraphDB Free Documentation Release 8.8 Ontotext Mar 13, 2019 CONTENTS 1 General 1 1.1 About GraphDB...........................................2 1.2 Architecture & components.....................................2 1.2.1 Architecture.........................................2 1.2.1.1 RDF4J.......................................3 1.2.1.2 The Sail API....................................4 1.2.2 Components.........................................4 1.2.2.1 Engine.......................................4 1.2.2.2 Connectors.....................................5 1.2.2.3 Workbench.....................................5 1.3 GraphDB Free............................................5 1.3.1 Comparison of GraphDB Free and GraphDB SE......................6 1.4 Connectors..............................................6 1.5 Workbench..............................................6 2 Quick start guide 9 2.1 Run GraphDB as a desktop installation...............................9 2.1.1 On Windows........................................ 10 2.1.2 On Mac OS......................................... 10 2.1.3 On Linux.......................................... 10 2.1.4 Configuring GraphDB................................... 10 2.1.5 Stopping GraphDB..................................... 11 2.2 Run GraphDB as a stand-alone server................................ 11 2.2.1 Running GraphDB..................................... 11 2.2.1.1 Options...................................... 11 2.2.2 Configuring GraphDB................................... 12 2.2.2.1 Paths and network settings........................... -

Graphdb SE Documentation Release 7.2

GraphDB SE Documentation Release 7.2 Ontotext Oct 28, 2016 CONTENTS 1 General 1 1.1 About GraphDB...........................................2 1.2 Architecture & components.....................................2 1.2.1 Architecture.........................................2 Sesame............................................3 The SAIL API........................................4 1.2.2 Components.........................................4 Engine............................................4 Connectors..........................................5 Workbench..........................................5 1.3 GraphDB SE.............................................5 1.3.1 Comparison of GraphDB Free and GraphDB SE......................6 1.4 GraphDB SE in the cloud......................................6 1.4.1 Overview..........................................6 1.4.2 Amazon Web Services...................................6 1.4.3 Pricing details........................................7 1.4.4 Setup and usage.......................................7 1.5 Connectors..............................................7 1.6 Workbench..............................................7 1.6.1 How to use it........................................8 2 Quick start guide 9 2.1 Start the database...........................................9 2.1.1 Run GraphDB as a stand-alone server...........................9 Running GraphDB......................................9 Configuring GraphDB....................................9 Stopping the database.................................... 10 2.2 Set -

Downloaded from ORCA, Cardiff University's Institutional Repository

This is an Open Access document downloaded from ORCA, Cardiff University's institutional repository: http://orca.cf.ac.uk/105344/ This is the author’s version of a work that was submitted to / accepted for publication. Citation for final published version: Hippolyte, J.-L., Rezgui, Y., Li, H., Jayan, B. and Howell, S. 2018. Ontology-driven development of web services to support district energy applications. Automation in Construction 86 , pp. 210- 225. 10.1016/j.autcon.2017.10.004 file Publishers page: http://dx.doi.org/10.1016/j.autcon.2017.10.004 <http://dx.doi.org/10.1016/j.autcon.2017.10.004> Please note: Changes made as a result of publishing processes such as copy-editing, formatting and page numbers may not be reflected in this version. For the definitive version of this publication, please refer to the published source. You are advised to consult the publisher’s version if you wish to cite this paper. This version is being made available in accordance with publisher policies. See http://orca.cf.ac.uk/policies.html for usage policies. Copyright and moral rights for publications made available in ORCA are retained by the copyright holders. Ontology-driven development of web services to support district energy applications J.-L. Hippolytea,∗, Y.Rezguia, H. Lia, B. Jayana, S. Howella aBRE Trust Centre for Sustainable Engineering, Cardiff School of Engineering, Queens Buildings, The Parade, Cardiff, CF24 3AA, United Kingdom Abstract Current urban and district energy management systems lack a common se- mantic referential for effectively interrelating intelligent sensing, data models and energy models with visualization, analysis and decision support tools. -

RDF Triplestores and SPARQL Endpoints

RDF triplestores and SPARQL endpoints Lecturer: Mathias Bonduel [email protected] LDAC summer school 2019 – Lisbon, Portugal Lecture outline • Storing RDF data: RDF triplestores o Available methods to store RDF data o RDF triplestores o Triplestore applications – databases – default graph – named graphs o List of triplestore applications o Comparing triplestores o Relevant triplestore settings o Communication with triplestores • Distributing RDF data: SPARQL endpoints o Available methods to distribute RDF data o SPARQL endpoints o Reuse of SPARQL queries o SPARQL communication protocol: requests and responses June 18, 2019 RDF triplestores and SPARQL endpoints | Mathias Bonduel 2 Storing RDF data June 18, 2019 RDF triplestores and SPARQL endpoints | Mathias Bonduel 3 Available methods to store RDF data • In-memory storage (local RAM) o Working memory of application (e.g. client side web app, desktop app) o Frameworks/libraries: RDFLib (Python), rdflib.js (JavaScript), N3 (JavaScript), rdfstore-js (JavaScript), Jena (Java), RDF4J (Java), dotNetRDF (.NET), etc. o Varied support for SPARQL querying • Persistent storage (storage drive) o RDF file/dump (diff. RDF serializations): TTL, RDF/XML, N-Quads, JSON-LD, N-triples, TriG, N3, TriX, RDFa (RDF embedded in HTML), etc. o RDF triplestore o (ontology editing applications: Protégé, Topbraid Composer, etc.) June 18, 2019 RDF triplestores and SPARQL endpoints | Mathias Bonduel 4 RDF triplestores “a database to store and query RDF triples” • Member of the family of graph/NoSQL databases • Data structure: RDF • Main query language: SPARQL standards • Oftentimes support for RDFS/OWL/rules reasoning • Data storage is typically persistent June 18, 2019 RDF triplestores and SPARQL endpoints | Mathias Bonduel 5 Triplestore applications – databases - default graph - named graphs • An RDF triplestore instance (application) can have one or multiple databases (repositories) • Each database has one default graph and zero or more named graphs o a good practice is to place TBox in a separate named graph.