Modeling Distant Pointing for Compensating Systematic Displacements

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Worship and Devotions

License, Copyright and Online Permission Statement Copyright © 2018 by Chalice Press. Outlines developed by an Editorial Advisory Team of outdoor ministry leaders representing six mainline Protestant denominations. Purchase of this resource gives license for its use, adaptation, and copying for programmatic use at one outdoor ministry or day camp core facility/operation (hereinafter, “FACILITY”) for up to one year from purchase. Governing bodies that own and operate more than one FACILITY must buy one copy of the resource for each FACILITY using the resource. Copies of the files may be made for use only within each FACILITY for staff and volunteer use only. Each FACILITY’s one-year permission now includes the use of this material for one year at up to three additional venues to expand the FACILITY’s reach into the local community. Examples would include offering outdoor ministry experiences at churches, schools, or community parks that are not part of your core FACILITY program. Copies of the files are for programming use only by staff and volunteers, and distribution for resale is strictly prohibited in any form electronically or in hard copy such as printing, copying, website posting/re-posting, emails, etc. Use of sí se puede® is by permission from United Farmworkers Union and Cesar Chavez Foundation. Use of this phrase outside of camp activities is not covered by this purchase and must be negotiated directly with UFW. Use of “May Peace Prevail on Earth” is by permission from World Peace Prayer Society. It can be freely used to promote peace but not for any commercial venture. -

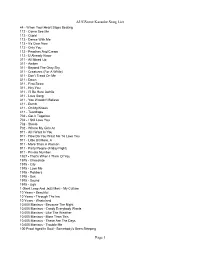

Augsome Karaoke Song List Page 1

AUGSome Karaoke Song List 44 - When Your Heart Stops Beating 112 - Come See Me 112 - Cupid 112 - Dance With Me 112 - It's Over Now 112 - Only You 112 - Peaches And Cream 112 - U Already Know 311 - All Mixed Up 311 - Amber 311 - Beyond The Gray Sky 311 - Creatures (For A While) 311 - Don't Tread On Me 311 - Down 311 - First Straw 311 - Hey You 311 - I'll Be Here Awhile 311 - Love Song 311 - You Wouldn't Believe 411 - Dumb 411 - On My Knees 411 - Teardrops 702 - Get It Together 702 - I Still Love You 702 - Steelo 702 - Where My Girls At 911 - All I Want Is You 911 - How Do You Want Me To Love You 911 - Little Bit More, A 911 - More Than A Woman 911 - Party People (Friday Night) 911 - Private Number 1927 - That's When I Think Of You 1975 - Chocolate 1975 - City 1975 - Love Me 1975 - Robbers 1975 - Sex 1975 - Sound 1975 - Ugh 1 Giant Leap And Jazz Maxi - My Culture 10 Years - Beautiful 10 Years - Through The Iris 10 Years - Wasteland 10,000 Maniacs - Because The Night 10,000 Maniacs - Candy Everybody Wants 10,000 Maniacs - Like The Weather 10,000 Maniacs - More Than This 10,000 Maniacs - These Are The Days 10,000 Maniacs - Trouble Me 100 Proof Aged In Soul - Somebody's Been Sleeping Page 1 AUGSome Karaoke Song List 101 Dalmations - Cruella de Vil 10Cc - Donna 10Cc - Dreadlock Holiday 10Cc - I'm Mandy 10Cc - I'm Not In Love 10Cc - Rubber Bullets 10Cc - Things We Do For Love, The 10Cc - Wall Street Shuffle 112 And Ludacris - Hot And Wet 12 Gauge - Dunkie Butt 12 Stones - Crash 12 Stones - We Are One 1910 Fruitgum Co. -

Look Says: the CITY STATE BANK the Reaular Meeting of the Clover Chas

mmM i* 1bHiii I'ii i' ii'i iiin(ii t>,rM #r ,OUf t,m , thrt« or four timtt Circolation gMAtts" t avaiUbU to• Circolation greatest available to Low«ll •dvortiatn. Lowell advertfeert. VOL. XXV LOWELL, MICHIGAN, MAR. No. 41 REPORT OF THE CONDITION OF GatsU Enjoyed the Opera Bohcmitn C. F. Kyser Building Sorghum Mill Girl Last Bveaisf. in Lowell. Look Says: THE CITY STATE BANK The reaular meeting of the Clover Chas. F. Kyser is installing a Leaf dub was held at the High sorghum mill in Lowell on Main school building Wednesday evening, street east, with a eapacity suflicient Our line of Easter Cards is large and very at Lowell, Michigan, at the close of business to take eare of all business tribu- March 30. After a short business complete. Why not send one to each of our March 4,1918, as called for by the Commissioner session and the reading from the tary to this seetion. collect for club women led by the As an aid to those who have not boys in training. They don't cost much and grown sorghum, Mr. Kyser prepared of the Banking Department. resident of the visiting dub. Mrs. the boys will surely appreciate it. Elutchinson; Mrs. P. C. Peckham, the following directions for growing UK801IBCES chairman of the musical committee and harvesting, which it will he well for those interested to preserve .1147,410.56 of the C. L. C., announced that we .We are going to have some big specials in Loans and Discountg would be entertained by the rend- for reference during the season. -

Death, Mourning and the Expression of Sorrow on White-Ground Lêkythoi

Portraits of Grief: Death, Mourning and the Expression of Sorrow on White-Ground Lêkythoi Molly Evangeline Allen Submitted in partial fulfillment of the requirements for the degree of Doctor of Philosophy under the Executive Committee of the Graduate School of Arts and Sciences COLUMBIA UNIVERSITY 2017 © 2017 Molly Evangeline Allen All rights reserved ABSTRACT Portraits of Grief: Death, Mourning and the Expression of Sorrow on White-Ground Lêkythoi Molly Evangeline Allen In Athens in the early 5th century BCE, a new genre of funerary vase, the white-ground lêkythos, appeared and quickly grew to be the most popular grave gift for nearly a century. These particular vases, along with their relatively delicate style of painting, ushered in a new funerary scene par excellence, which highlighted the sorrow of the living and the merits of the deceased by focusing on personal moments of grief in the presence of a grave. Earlier Attic funerary imagery tended to focus on crowded prothesis scenes where mourners announced their grief and honored the dead through exaggerated, violent and frenzied gestures. The scenes on white-ground lêkythoi accomplished the same ends through new means, namely by focusing on individual mourners and the emotional ways that mourners privately nourished the deceased and their memory. Such scenes combine ritual activity (i.e. dedicating gifts, decorating the grave, pouring libations) with emotional expressions of sadness, which make them more vivid and relatable. The nuances in the characteristics of the mourners indicate a new interest in adding an individual touch to the expression, which might “speak” to a particular moment or variety of sadness that might relate to a potential consumer. -

Elite Karaoke Draft by Artist 2 Pistols Feat

Elite Karaoke Draft by Artist 2 Pistols Feat. Ray J You Know Me (Hed) Planet Earth 2 Pistols Feat. T-Pain & Tay Bartender Dizm Blackout She Got It Other Side 2 Play Feat. Thomas Jules & Renegade Jucxi D 10 Years Careless Whisper Actions & Motives 2 Unlimited Beautiful No Limit Drug Of Choice Twilight Zone Fix Me 20 Fingers Fix Me (Acoustic) Short Dick Man Shoot It Out 21 Demands Through The Iris Give Me A Minute Wasteland 21 Savage Feat. Offset, Metro 10,000 Maniacs Boomin & Travis Scott Because The Night Ghostface Killers Candy Everybody Wants 2Pac Like The Weather Changes More Than This Dear Mama These Are The Days How Do You Want It Trouble Me I Get Around 100 Proof (Aged In Soul) So Many Tears Somebody's Been Sleeping Until The End Of Time 101 Dalmations 2Pac Feat. Dr. Dre Cruella De Vil California Love 10cc 2Pac Feat. Elton John Dreadlock Holiday Ghetto Gospel Good Morning Judge 2Pac Feat. Eminem I'm Not In Love One Day At A Time The Things We Do For Love 2Pac Feat. Eric Williams Things We Do For Love Do For Love 112 2Pac Feat. Notorious B.I.G. Dance With Me Runnin' Peaches & Cream 3 Doors Down Right Here For You Away From The Sun U Already Know Be Like That 112 Feat. Ludacris Behind Those Eyes Hot & Wet Citizen Soldier 112 Feat. Super Cat Dangerous Game Na Na Na Duck & Run 12 Gauge Every Time You Go Dunkie Butt Going Down In Flames 12 Stones Here By Me Arms Of A Stranger Here Without You Far Away It's Not My Time (I Won't Go) Shadows Kryptonite We Are One Landing In London 1910 Fruitgum Co. -

Waller Extends Disaster Order

UIL MODIFYING CONTINGENCY PLANS SPORTS | B1 Q&A WITH CEO OF MEMORIAL HERMANN’S KATY, CYPRESS HOSPITALS Katy Times PAGE A3 VOLUME 108, ISSUE 15 THE GREATER KATY AREA'S NEWS SOURCE SINCE 1912 n katytimes.com THURSDAY, APRIL 9, 2020 Waller extends A grim milestone disaster order By R. HANS MILLER SENIOR REPORTER Waller County Judge Trey Duhon has extended his county’s disaster declaration, as autho- rized by the Waller County Com- missioners Court April 1, through to April 30, matching a statewide order issued by Tex. Governor Greg Abbott. “Waller County residents should remain at home as much as possible and limit trips outside of their residence for essential The Cybersecurity and items or to provide essential ser- Infrastructure Security Agency – vices. Only one person per house- referred to as CISA – executes the Secretary hold should obtain essential of Homeland Security’s directives to secure items at any one retail location at critical infrastructure. Federal, state and a time,” Duhon said via Facebook. county authorities – including Harris County The order, which supersedes – follow CISA’s guidelines to identify essential industries the one issued by Duhon March during health crises like the COVID-19 pandemic. 25, generally matches that put out by Abbott in regards to restric- tions placed on Waller County residents, including those living in the portion of Katy that lies in Duhon’s county. Businesses that Hidalgo amends Harris Co. Stay Home, Work are considered essential must make accommodations to ensure social distancing – maintaining at Safe order as death toll reaches double digits least six feet between customers – can be maintained. -

Docoaxaca.2020.07

Doc Oaxaca by William K. Eley 1 [email protected] © 2019 Registered US Copyright Office Library of Congress 1-8089850731 All rights reserved 2 To Carroll Behrhorst, 1923 – 1990 Helen Caldicott, 1938 - present Obie Minter, 1946 - 1978 George Guess, 1947 - present and Jude, Saul, PJ, Alan, Peter, Lucretia, Patty, Susie, Tommy, Meg, Carol, Carlton, Nancy, Henrietta, Patch and the many other friends and denizens of the Rockpile, Wherever you may be And to many more who shared those fabulous times on the gringo trail "Medicine is a social science, and politics nothing but medicine on a grand scale… Doctors are the natural advocates of the poor, and social problems are … their jurisdiction." -- Karl Virchow, 1880 3 Invocation So. This is the end. Let it go, you tell yourself. Accept this moment, this alert painless paralysis. Watch that feather cloud of black razors, hovering, grim, seductive. And think: at least it’s me, and not John. At least fate isn’t fool enough to lose the doctor just to save the writer. You’ve heard of John? Maybe you only know the legend of Doc Oaxaca. And maybe it is crazy to write about him, and to conjure up that grinning ghost from our misdiagnosed era. Cowards love silence. God damn them anyway. Draw the brave and hollow circle. Lean forward and light the fire. Listen to that wind, as it blows sheets of stinging rain through this soul, and go back, again, to that moment. 4 Part I San Jose Chapter 1 San Jose, Sangre de Christo mountains, Mexico Sometime in the late 20th century Thunder startled me at dawn, and the smell of coffee, bubbling on the camp stove, banished a lingering dream of home in Virginia. -

Songs by Artist

Chansons en anglais - Songs in English ARTIST / ARTISTE TITLE / TITRE ARTIST / ARTISTE TITLE / TITRE 10 Years Through The Iris 21 Demands Give Me A Minute Wasteland 2Unlimited No Limit 10,000 Maniacs Because The Night 3 Doors Down Away From The Sun More Than This Be Like That These Are The Days Duck And Run Trouble Me Every Time You Go 100 Proof Aged In Soul Somebody'S Been Sleepin Here By Me 101 Dalmations Cruella De Vil Here Without You 10Cc Donna It'S Not My Time Dreadlock Holiday Krypnotite I'M Not In Love Landing In London Rubber Bullets Let Me Be Myself The Things We Do For Let Me Go Love Live For Today The Wall Street Shuffle Loser 112 Come See Me Road I'M On Dance With Me The Road I'M On It'S Over Now Train Only You When I'M Gone Peaches And Cream 3 Of Hearts Arizona Rain 12 Stones We Are One Love Is Enough 1910 Fruit Gum Co. 1,2,3 Red Light 30 Seconds To Mars The Bury Me Kill Simon Says The Kill 2 Live Crew Doo Wah Diddy 30H!3 & Katy Perry Starstrukk Me So Horny 30H!3 And Katy Perry Starstrukk We Want Some Pussy 311 All Mixed Up 2 Pac Changes Down Thugz Mansion I'Ll Be Here Awhile Until The End Of Time You Wouldn'T Believe 2 Pac & Eminem One Day At A Time 38 Special Caught Up In You 2 Pistols And Ray J You Know Me Hold On Loosely 20 Fingers Short Dick Man If I'D Been The One Page 1 of/de 329 Chansons en anglais - Songs in English ARTIST / ARTISTE TITLE / TITRE ARTIST / ARTISTE TITLE / TITRE 38 Special Rockin' Into The Night 50 Cent And Ayo Technology Timberlake Second Chance 50 Cent Feat.Ne-Yo Baby By Me Wildeyed Southern Boys, -

Pdf): 978-3-95796-187-7 Isbn (Epub): 978-3-95796-188-4 Doi: 10.14619/1860

Touchscreen Archaeology Touchscreen Archaeology: Tracing Histories of Hands-On Media Practices Wanda Strauven Funded by the Bibliographical Information of the German National Library The German National Library lists this publication in the Deutsche National bibliografie (German National Bibliogra- phy); detailed bibliographic information is available online at http://dnb.d-nb.de. Published in 2021 by meson press, Lüneburg, Germany www.meson.press Design concept: Torsten Köchlin, Silke Krieg Cover image: Detail from Una storia (2014) by Federica Barbieri Copy editing: Kyle Stine The print edition of this book is printed by Lightning Source, Milton Keynes, United Kingdom. ISBN (Print): 978-3-95796-186-0 ISBN (PDF): 978-3-95796-187-7 ISBN (EPUB): 978-3-95796-188-4 DOI: 10.14619/1860 The digital editions of this publication can be downloaded freely at: www.meson.press This Publication is licensed under a CC BY-SA 4.0 (Creative Commons Attribution ShareAlike 4.0 International) license. To view a copy of this license, visit: http://creativecommons.org/ licenses/by-sa/4.0/. To my daughter Contents Foreword 9 Introduction: Is This a Touchscreen? 11 PART ONE: TOUCH AS MEDIA PRACTICE [ 1 ] A Little History of Hands-On Film Spectatorship 53 Two Founding Myths of the Early Film Spectator The Early Rube Films Ali Barbouyou and Don Quixote Michel-Ange’s Lure or Pretend Play The Avant-Garde Rube of the 1920s Expanded Cinema Rubes The Technological Rube of the Twenty-First Century Today’s Children as Rubes [ 2 ] Early Museum’s Hands-On Ethos 83 Please -

TUTOR201.Pdf

Julie Klassen 5 _Klassen_TutorsDaughter_KS_djm.indd 3 9/28/12 3:19 PM These websites are hyperlinked. www.bakerpublishinggroup.com www.bakeracademic.com www.brazospress.com www.chosenbooks.com www.revellbooks.com www.bethanyhouse.com © 2012 by Julie Klassen Published by Bethany House Publishers 11400 Hampshire Avenue South Bloomington, Minnesota 55438 www.bethanyhouse.com Bethany House Publishers is a division of Baker Publishing Group, Grand Rapids, Michigan Printed in the United States of America All rights reserved. No part of this publication may be reproduced, stored in a retrieval system, or transmitted in any form or by any means—for example, electronic, photocopy, recording— without the prior written permission of the publisher. The only exception is brief quotations in printed reviews. Library of Congress Cataloging-in-Publication Data Klassen, Julie. The tutor’s daughter / Julie Klassen p. cm. ISBN 978-0-7642-1069-3 (pbk.) 1. Regency fiction. 2. Love stories. 3. Christian fiction. I. Title. PS3611.L37T88 2012 813 .6—dc23 2012034244 Scripture quotations are from the King James Version of the Bible. This is a work of historical reconstruction; the appearances of certain historical figures are therefore inevitable. All other characters, however, are products of the author’s imagination, and any resemblance to actual persons, living or dead, is coincidental. Cover design by Jennifer Parker Cover photography by Mike Habermann Photography, LLC Author represented by Books and Such Literary Agency 12 13 14 15 16 17 18 7 6 5 4 3 2 1 _Klassen_TutorsDaughter_KS_djm.indd 4 9/28/12 3:19 PM With love to my uncles, Al, Ed, Hank & John And in loving memory of Uncle Bill _Klassen_TutorsDaughter_KS_djm.indd 5 9/28/12 3:19 PM YOUNG GENTLEMEN are boarded and instructed in English, Writing, and Arithmetic, at Eighteen Guineas per Annum. -

Gary Gygax's Extraordinary Book of Names

ACKNOWLEDGEMENTS Author: Malcom Bowers Contributing Authors: (d20 Onomancer)Troy; (Lejendary Adventures Onomancer) Gary Gygax Cover Artist: Matt Milberger Titles & Cover Design: Mac Golden Production: Troll Lord Games Editors: Davis Chenault, Gary Gygax Series Editor: Gary Gygax Troll Lord Games Or on the web at PO Box 251171 www.trolllord.com Little Rock, AR 72225 [email protected] This book is published and distributed by Chenault and Gray LLC d/b/a Troll Lord Games. All text in this book, othan than Public Domain Artwork originally this title page concerning the Open Game License, is Copyright © 2004 Trigee Enterprises Company. All trade dress is appeared in these sources: Copyright © 2004 Troll Lord Games, L.L.C. All Rights Reserved. Lejendary Adventure, the Lejendary Adventure logo, and Platt, Colin. The Atlas of Medieval Man, Gary Gygax’s Extraordinary Book of Names are Trademarks of Trigee Enterprises Company. All Rights Reserved. Troll Lord Crescent Books, New York 1979, pg 2. Games and the Troll Lord Games logo are Trademarks of Troll Lord Games, L.L.C. All Rights Reserved. Lacroix, Paul. The Arts in the Middle ‘D20 System’ and the ‘D20 System’ logo are Trademarks owned by Wizards of the Coast and are used according to the terms Ages, J.S.Virtue & Co., London. of the D20 System License version 3.0. A copy of this License can be found at www.wizards.com/d20. Dungeons and Casson, Lionel. Great Ages of Man: Dragons® and Wizards of the Coast® are Registered Trademarks of Wizards of the Coast, and are used with permission. Please Ancient Egypt, Time Life Books 1977. -

Here Be Monsters: Body Imagery in the Poetry of Sylvia Plath

Here Be Monsters: Body Imagery in the Poetry of Sylvia Plath A thesis presented by David M. A. Francis (Student number 198820395) (ORCID iD 0000-0003-3916-1920) for the Degree of Doctor of Philosophy February 2018 The School of Culture and Communication Faculty of Arts The University of Melbourne The thesis is submitted in total fulfilment of the degree and has not been completed under a jointly awarded degree. 2 The reflection of life in poetry and in art of all kinds gave me joy and I enjoyed watching life through the mirror of art. –––from A Confession and Other Religious Writings, Leo Tolstoy (1879) 3 ABSTRACT My thesis, entitled Here be Monsters: Body Imagery in the Poetry of Sylvia Plath, is 50% Dissertation and 50% Creative Writing. Poetry is a bridge between the experience of individual realities and a world of representation, making possible expression of what otherwise would be articulated mundanely or with difficulty. Sylvia Plath (1932-1963) was a poet of the Confessional school, and her poetry contains many references, both literal and metaphoric, to the human body. My hypothesis is that symbolic sublimation, through imagery and metaphors of the body, provided Plath with a distinctively personal and emotional poetic mode of expressing her desire for self-transformation. The literature review considers: Plath's psychological disorder and its possible impact on her writing; the Confessional school of poetry and Plath's place as a Confessional poet; theories of metaphor and how Plath used metaphor and imagery in her poetry; and the factors that may have influenced her to use the body as a major trope.