Integrating Reinforcement Learning and Automated Planning for Playing Video-Games TRABAJO FIN DE MASTER

Total Page:16

File Type:pdf, Size:1020Kb

Load more

Recommended publications

-

Rétro Gaming

ATARI - CONSOLE RETRO FLASHBACK 8 GOLD ACTIVISION – 130 JEUX Faites ressurgir vos meilleurs souvenirs ! Avec 130 classiques du jeu vidéo dont 39 jeux Activision, cette Atari Flashback 8 Gold édition Activision saura vous rappeler aux bons souvenirs du rétro-gaming. Avec les manettes sans fils ou vos anciennes manettes classiques Atari, vous n’avez qu’à brancher la console à votre télévision et vous voilà prêts pour l’action ! CARACTÉRISTIQUES : • 130 jeux classiques incluant les meilleurs hits de la console Atari 2600 et 39 titres Activision • Plug & Play • Inclut deux manettes sans fil 2.4G • Fonctions Sauvegarde, Reprise, Rembobinage • Sortie HD 720p • Port HDMI • Ecran FULL HD Inclut les jeux cultes : • Space Invaders • Centipede • Millipede • Pitfall! • River Raid • Kaboom! • Spider Fighter LISTE DES JEUX INCLUS LISTE DES JEUX ACTIVISION REF Adventure Black Jack Football Radar Lock Stellar Track™ Video Chess Beamrider Laser Blast Asteroids® Bowling Frog Pond Realsports® Baseball Street Racer Video Pinball Boxing Megamania JVCRETR0124 Centipede ® Breakout® Frogs and Flies Realsports® Basketball Submarine Commander Warlords® Bridge Oink! Kaboom! Canyon Bomber™ Fun with Numbers Realsports® Soccer Super Baseball Yars’ Return Checkers Pitfall! Missile Command® Championship Golf Realsports® Volleyball Super Breakout® Chopper Command Plaque Attack Pitfall! Soccer™ Gravitar® Return to Haunted Save Mary Cosmic Commuter Pressure Cooker EAN River Raid Circus Atari™ Hangman House Super Challenge™ Football Crackpots Private Eye Yars’ Revenge® Combat® -

List of Intellivision Games

List of Intellivision Games 1) 4-Tris 25) Checkers 2) ABPA Backgammon 26) Chip Shot: Super Pro Golf 3) ADVANCED DUNGEONS & DRAGONS 27) Commando Cartridge 28) Congo Bongo 4) ADVANCED DUNGEONS & DRAGONS 29) Crazy Clones Treasure of Tarmin Cartridge 30) Deep Pockets: Super Pro Pool and Billiards 5) Adventure (AD&D - Cloudy Mountain) (1982) (Mattel) 31) Defender 6) Air Strike 32) Demon Attack 7) Armor Battle 33) Diner 8) Astrosmash 34) Donkey Kong 9) Atlantis 35) Donkey Kong Junior 10) Auto Racing 36) Dracula 11) B-17 Bomber 37) Dragonfire 12) Beamrider 38) Eggs 'n' Eyes 13) Beauty & the Beast 39) Fathom 14) Blockade Runner 40) Frog Bog 15) Body Slam! Super Pro Wrestling 41) Frogger 16) Bomb Squad 42) Game Factory 17) Boxing 43) Go for the Gold 18) Brickout! 44) Grid Shock 19) Bump 'n' Jump 45) Happy Trails 20) BurgerTime 46) Hard Hat 21) Buzz Bombers 47) Horse Racing 22) Carnival 48) Hover Force 23) Centipede 49) Hypnotic Lights 24) Championship Tennis 50) Ice Trek 51) King of the Mountain 52) Kool-Aid Man 80) Number Jumble 53) Lady Bug 81) PBA Bowling 54) Land Battle 82) PGA Golf 55) Las Vegas Poker & Blackjack 83) Pinball 56) Las Vegas Roulette 84) Pitfall! 57) League of Light 85) Pole Position 58) Learning Fun I 86) Pong 59) Learning Fun II 87) Popeye 60) Lock 'N' Chase 88) Q*bert 61) Loco-Motion 89) Reversi 62) Magic Carousel 90) River Raid 63) Major League Baseball 91) Royal Dealer 64) Masters of the Universe: The Power of He- 92) Safecracker Man 93) Scooby Doo's Maze Chase 65) Melody Blaster 94) Sea Battle 66) Microsurgeon 95) Sewer Sam 67) Mind Strike 96) Shark! Shark! 68) Minotaur (1981) (Mattel) 97) Sharp Shot 69) Mission-X 98) Slam Dunk: Super Pro Basketball 70) Motocross 99) Slap Shot: Super Pro Hockey 71) Mountain Madness: Super Pro Skiing 100) Snafu 72) Mouse Trap 101) Space Armada 73) Mr. -

Newagearcade.Com 5000 in One Arcade Game List!

Newagearcade.com 5,000 In One arcade game list! 1. AAE|Armor Attack 2. AAE|Asteroids Deluxe 3. AAE|Asteroids 4. AAE|Barrier 5. AAE|Boxing Bugs 6. AAE|Black Widow 7. AAE|Battle Zone 8. AAE|Demon 9. AAE|Eliminator 10. AAE|Gravitar 11. AAE|Lunar Lander 12. AAE|Lunar Battle 13. AAE|Meteorites 14. AAE|Major Havoc 15. AAE|Omega Race 16. AAE|Quantum 17. AAE|Red Baron 18. AAE|Ripoff 19. AAE|Solar Quest 20. AAE|Space Duel 21. AAE|Space Wars 22. AAE|Space Fury 23. AAE|Speed Freak 24. AAE|Star Castle 25. AAE|Star Hawk 26. AAE|Star Trek 27. AAE|Star Wars 28. AAE|Sundance 29. AAE|Tac/Scan 30. AAE|Tailgunner 31. AAE|Tempest 32. AAE|Warrior 33. AAE|Vector Breakout 34. AAE|Vortex 35. AAE|War of the Worlds 36. AAE|Zektor 37. Classic Arcades|'88 Games 38. Classic Arcades|1 on 1 Government (Japan) 39. Classic Arcades|10-Yard Fight (World, set 1) 40. Classic Arcades|1000 Miglia: Great 1000 Miles Rally (94/07/18) 41. Classic Arcades|18 Holes Pro Golf (set 1) 42. Classic Arcades|1941: Counter Attack (World 900227) 43. Classic Arcades|1942 (Revision B) 44. Classic Arcades|1943 Kai: Midway Kaisen (Japan) 45. Classic Arcades|1943: The Battle of Midway (Euro) 46. Classic Arcades|1944: The Loop Master (USA 000620) 47. Classic Arcades|1945k III 48. Classic Arcades|19XX: The War Against Destiny (USA 951207) 49. Classic Arcades|2 On 2 Open Ice Challenge (rev 1.21) 50. Classic Arcades|2020 Super Baseball (set 1) 51. -

Using Deep Learning to Create a Universal Game Player

Using Deep Learning to create a Universal Game Player Tackling Transfer Learning and Catastrophic Forgetting Using Asynchronous Methods for Deep Reinforcement Learning Joao˜ Manuel Godinho Ribeiro Thesis to obtain the Master of Science Degree in Information Systems and Computer Engineering Supervisors: Prof. Francisco Antonio´ Chaves Saraiva de Melo Prof. Joao˜ Miguel De Sousa de Assis Dias Examination Committee Chairperson: Prof. Lu´ıs Manuel Antunes Veiga Supervisor: Prof. Francisco Antonio´ Chaves Saraiva de Melo Member of the Committee: Prof. Manuel Fernando Cabido Peres Lopes October 2018 Acknowledgments This dissertation is dedicated to my parents and family, who supported me not only throughout my academic career, but throughout all the difficulties I’ve encountered in life. To my two advisers, Francisco and Joao,˜ for not only providing all the necessary support, patience and availability, throughout the entire process, but especially for this wonderful opportunity to work in the scientific area for which I am most passionate about. To my beautiful girlfriend Margarida, for always believing in me in times of great doubt and adversity, and without whom the entire process would have been much tougher. Thank you for your strength. Finally, to my friends and colleagues which accompanied me throughout the entire process and without whom life wouldn’t have the same meaning. Thank you all for always being there for me. Abstract This dissertation introduces a general-purpose architecture that allows a learning agent to (i) transfer knowledge from a previously learned task to a new one that is now required to learned and (ii) remember how to perform the previously learned tasks as it learns the new one. -

A Page 1 CART TITLE MANUFACTURER LABEL RARITY Atari Text

A CART TITLE MANUFACTURER LABEL RARITY 3D Tic-Tac Toe Atari Text 2 3D Tic-Tac Toe Sears Text 3 Action Pak Atari 6 Adventure Sears Text 3 Adventure Sears Picture 4 Adventures of Tron INTV White 3 Adventures of Tron M Network Black 3 Air Raid MenAvision 10 Air Raiders INTV White 3 Air Raiders M Network Black 2 Air Wolf Unknown Taiwan Cooper ? Air-Sea Battle Atari Text #02 3 Air-Sea Battle Atari Picture 2 Airlock Data Age Standard 3 Alien 20th Century Fox Standard 4 Alien Xante 10 Alpha Beam with Ernie Atari Children's 4 Arcade Golf Sears Text 3 Arcade Pinball Sears Text 3 Arcade Pinball Sears Picture 3 Armor Ambush INTV White 4 Armor Ambush M Network Black 3 Artillery Duel Xonox Standard 5 Artillery Duel/Chuck Norris Superkicks Xonox Double Ender 5 Artillery Duel/Ghost Master Xonox Double Ender 5 Artillery Duel/Spike's Peak Xonox Double Ender 6 Assault Bomb Standard 9 Asterix Atari 10 Asteroids Atari Silver 3 Asteroids Sears Text “66 Games” 2 Asteroids Sears Picture 2 Astro War Unknown Taiwan Cooper ? Astroblast Telegames Silver 3 Atari Video Cube Atari Silver 7 Atlantis Imagic Text 2 Atlantis Imagic Picture – Day Scene 2 Atlantis Imagic Blue 4 Atlantis II Imagic Picture – Night Scene 10 Page 1 B CART TITLE MANUFACTURER LABEL RARITY Bachelor Party Mystique Standard 5 Bachelor Party/Gigolo Playaround Standard 5 Bachelorette Party/Burning Desire Playaround Standard 5 Back to School Pak Atari 6 Backgammon Atari Text 2 Backgammon Sears Text 3 Bank Heist 20th Century Fox Standard 5 Barnstorming Activision Standard 2 Baseball Sears Text 49-75108 -

Download 80 PLUS 4983 Horizontal Game List

4 player + 4983 Horizontal 10-Yard Fight (Japan) advmame 2P 10-Yard Fight (USA, Europe) nintendo 1941 - Counter Attack (Japan) supergrafx 1941: Counter Attack (World 900227) mame172 2P sim 1942 (Japan, USA) nintendo 1942 (set 1) advmame 2P alt 1943 Kai (Japan) pcengine 1943 Kai: Midway Kaisen (Japan) mame172 2P sim 1943: The Battle of Midway (Euro) mame172 2P sim 1943 - The Battle of Midway (USA) nintendo 1944: The Loop Master (USA 000620) mame172 2P sim 1945k III advmame 2P sim 19XX: The War Against Destiny (USA 951207) mame172 2P sim 2010 - The Graphic Action Game (USA, Europe) colecovision 2020 Super Baseball (set 1) fba 2P sim 2 On 2 Open Ice Challenge (rev 1.21) mame078 4P sim 36 Great Holes Starring Fred Couples (JU) (32X) [!] sega32x 3 Count Bout / Fire Suplex (NGM-043)(NGH-043) fba 2P sim 3D Crazy Coaster vectrex 3D Mine Storm vectrex 3D Narrow Escape vectrex 3-D WorldRunner (USA) nintendo 3 Ninjas Kick Back (U) [!] megadrive 3 Ninjas Kick Back (U) supernintendo 4-D Warriors advmame 2P alt 4 Fun in 1 advmame 2P alt 4 Player Bowling Alley advmame 4P alt 600 advmame 2P alt 64th. Street - A Detective Story (World) advmame 2P sim 688 Attack Sub (UE) [!] megadrive 720 Degrees (rev 4) advmame 2P alt 720 Degrees (USA) nintendo 7th Saga supernintendo 800 Fathoms mame172 2P alt '88 Games mame172 4P alt / 2P sim 8 Eyes (USA) nintendo '99: The Last War advmame 2P alt AAAHH!!! Real Monsters (E) [!] supernintendo AAAHH!!! Real Monsters (UE) [!] megadrive Abadox - The Deadly Inner War (USA) nintendo A.B. -

New Joysticks Available for Your Atari 2600

May Your Holiday Season Be a Classic One Classic Gamer Magazine Classic Gamer Magazine December 2000 3 The Xonox List 27 Teach Your Children Well 28 Games of Blame 29 Mit’s Revenge 31 The Odyssey Challenger Series 34 Interview With Bob Rosha 38 Atari Arcade Hits Review 41 Jaguar: Straight From the Cat’s 43 Mouth 6 Homebrew Review 44 24 Dear Santa 46 CGM Online Reset 5 22 So, what’s Happening with CGM Newswire 6 our website? Upcoming Releases 8 In the coming months we’ll Book Review: The First Quarter 9 be expanding our web pres- Classic Ad: “Fonz” from 1976 10 ence with more articles, games and classic gaming merchan- Lost Arcade Classic: Guzzler 11 dise. Right now we’re even The Games We Love to Hate 12 shilling Classic Gamer Maga- zine merchandise such as The X-Games 14 t-shirts and coffee mugs. Are These Games Unplayable? 16 So be sure to check online with us for all the latest and My Favorite Hedgehog 18 greatest in classic gaming news Ode to Arcade Art 20 and fun. Roland’s Rat Race for the C-64 22 www.classicgamer.com Survival Island 24 Head ‘em Off at the Past 48 Classic Ad: “K.C. Munchkin” 1982 49 My .025 50 Make it So, Mr. Borf! Dragon’s Lair 52 and Space Ace DVD Review How I Tapped Out on Tapper 54 Classifieds 55 Poetry Contest Winners 55 CVG 101: What I Learned Over 56 Summer Vacation Atari’s Misplays and Bogey’s 58 46 Deep Thaw 62 38 Classic Gamer Magazine December 2000 4 “Those who cannot remember the past are condemned to Issue 5 repeat it” - George Santayana December 2000 Editor-in-Chief “Unfortunately, those of us who do remember the past are Chris Cavanaugh condemned to repeat it with them." - unaccredited [email protected] Managing Editor -Box, Dreamcast, Play- and the X-Box? Well, much to Sarah Thomas [email protected] Station, PlayStation 2, the chagrin of Microsoft bashers Gamecube, Nintendo 64, everywhere, there is one rule of Contributing Writers Indrema, Nuon, Game business that should never be X Mark Androvich Boy Advance, and the home forgotten: Never bet against Bill. -

![Arxiv:2010.02193V3 [Cs.LG] 3 May 2021](https://docslib.b-cdn.net/cover/1525/arxiv-2010-02193v3-cs-lg-3-may-2021-1671525.webp)

Arxiv:2010.02193V3 [Cs.LG] 3 May 2021

Published as a conference paper at ICLR 2021 MASTERING ATARI WITH DISCRETE WORLD MODELS Danijar Hafner ∗ Timothy Lillicrap Mohammad Norouzi Jimmy Ba Google Research DeepMind Google Research University of Toronto ABSTRACT Intelligent agents need to generalize from past experience to achieve goals in complex environments. World models facilitate such generalization and allow learning behaviors from imagined outcomes to increase sample-efficiency. While learning world models from image inputs has recently become feasible for some tasks, modeling Atari games accurately enough to derive successful behaviors has remained an open challenge for many years. We introduce DreamerV2, a reinforcement learning agent that learns behaviors purely from predictions in the compact latent space of a powerful world model. The world model uses discrete representations and is trained separately from the policy. DreamerV2 constitutes the first agent that achieves human-level performance on the Atari benchmark of 55 tasks by learning behaviors inside a separately trained world model. With the same computational budget and wall-clock time, Dreamer V2 reaches 200M frames and surpasses the final performance of the top single-GPU agents IQN and Rainbow. DreamerV2 is also applicable to tasks with continuous actions, where it learns an accurate world model of a complex humanoid robot and solves stand-up and walking from only pixel inputs. 1I NTRODUCTION Atari Performance To successfully operate in unknown environments, re- inforcement learning agents need to learn about their 2.0 Model-based Model-free environments over time. World models are an explicit 1.6 way to represent an agent’s knowledge about its environ- ment. Compared to model-free reinforcement learning 1.2 Human Gamer that learns through trial and error, world models facilitate 0.8 generalization and can predict the outcomes of potential actions to enable planning (Sutton, 1991). -

WHAT GAMES ARE on a 2600 CONSOLE with 160 GAMES BUILT-IN? ****** AUTHOR: Graham.J.Percy EMAIL

******* WHAT GAMES ARE ON A 2600 CONSOLE WITH 160 GAMES BUILT-IN? ****** AUTHOR: Graham.J.Percy EMAIL: [email protected] PHONE: +61 (0) 432 606 491 FAQ Version 1.0a, 10th June, 2014. Copyright (c) 2014 Graham.J.Percy All rights reserved. This document may be reproduced, in whole or in part, provided the copyright notice remains intact and no fee is charged. The data contained herein is provided for informational purposes only. No warranty is made with regards to the accuracy of the information. This is the best info I can give on the ATARI console with 160 GAMES BUILT IN! If you see any errors or omissions or wish to comment, please email me at the above address. WHERE PURCHASED:- This unit was purchased second hand at a flea market around the early 90s. DESCRIPTION:- The 160 game unit is based on the later 4 switch variant of the original Atari 2600 VCS with "blackout" treatment. The Atari logo does not appear anywhere on the unit. Although still identified as "channel 2-3", the channel select switch has been replaced with a 3-position game-group select switch. As well as being soldered directly to the motherboard the game select switch is connected to EPROM pins and motherboard by a number of patch wires. The following words are printed in the lower right corner of the switch/socket facia:- 160 GAMES BUILT IN Internally the motherboard is a fright! Apart from switch and socket locations the layout of the board bears little resemblence to the Atari product. There is no shielding over the CPU or VLSI's, only a small metal shield over the RF modulator. -

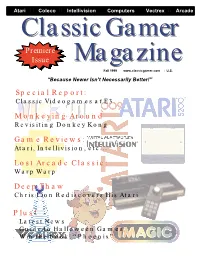

Premiere Issue Monkeying Around Game Reviews: Special Report

Atari Coleco Intellivision Computers Vectrex Arcade ClassicClassic GamerGamer Premiere Issue MagazineMagazine Fall 1999 www.classicgamer.com U.S. “Because Newer Isn’t Necessarily Better!” Special Report: Classic Videogames at E3 Monkeying Around Revisiting Donkey Kong Game Reviews: Atari, Intellivision, etc... Lost Arcade Classic: Warp Warp Deep Thaw Chris Lion Rediscovers His Atari Plus! · Latest News · Guide to Halloween Games · Win the book, “Phoenix” “As long as you enjoy the system you own and the software made for it, there’s no reason to mothball your equipment just because its manufacturer’s stock dropped.” - Arnie Katz, Editor of Electronic Games Magazine, 1984 Classic Gamer Magazine Fall 1999 3 Volume 1, Version 1.2 Fall 1999 PUBLISHER/EDITOR-IN-CHIEF Chris Cavanaugh - [email protected] ASSOCIATE EDITOR Sarah Thomas - [email protected] STAFF WRITERS Kyle Snyder- [email protected] Reset! 5 Chris Lion - [email protected] Patrick Wong - [email protected] Raves ‘N Rants — Letters from our readers 6 Darryl Guenther - [email protected] Mike Genova - [email protected] Classic Gamer Newswire — All the latest news 8 Damien Quicksilver [email protected] Frank Traut - [email protected] Lee Seitz - [email protected] Book Bytes - Joystick Nation 12 LAYOUT/DESIGN Classic Advertisement — Arcadia Supercharger 14 Chris Cavanaugh PHOTO CREDITS Atari 5200 15 Sarah Thomas - Staff Photographer Pong Machine scan (page 3) courtesy The “New” Classic Gamer — Opinion Column 16 Sean Kelly - Digital Press CD-ROM BIRA BIRA Photos courtesy Robert Batina Lost Arcade Classics — ”Warp Warp” 17 CONTACT INFORMATION Classic Gamer Magazine Focus on Intellivision Cartridge Reviews 18 7770 Regents Road #113-293 San Diego, Ca 92122 Doin’ The Donkey Kong — A closer look at our 20 e-mail: [email protected] on the web: favorite monkey http://www.classicgamer.com Atari 2600 Cartridge Reviews 23 SPECIAL THANKS To Sarah. -

August 21-22, 2004

San .Jose, California August 21-22, 2004 $5.00 Welcome to Classic Gaming Expo 2004!!! When this show first opened in 1998 no one really knew what to expect. The concept of "retro" gaming was still relatively new and was far from mainstream. It was a brave new world , where gaming fans worked to bring everyone together for a fun-filled weekend reminding us of how we got so excited about videogames in the first place. This year's event feels like that first time. For the last six years Classic Gaming Expo has taken residence in the glamorous confines of sin city, Las Vegas. It was a great run but recently we began to notice that Las Vegas is, in fact, an island . We could promote the show 24/7 for months but the one thing we could not change is that there are very few native gamers in the area. Everyone attending Classic Gaming Expo was in Las Vegas specifically to attend this show - so unless you were prepared to take a vacation on that weekend , you were going to miss it year in and year out. The move to San Jose not only brings the excitement of a fun-filled gaming weekend to a brave new world, but this brave new world also happens to be the home of videogaming itself. The roots of everything you know and love about this industry sprang not far from this very building. We think it's time to sow some new seeds and build a new home. A place where we can all experience the games, the people, and the excitement that filled our youth, all over again . -

Stephen M. Cabrinety Collection in the History of Microcomputing, Ca

http://oac.cdlib.org/findaid/ark:/13030/kt529018f2 No online items Guide to the Stephen M. Cabrinety Collection in the History of Microcomputing, ca. 1975-1995 Processed by Stephan Potchatek; machine-readable finding aid created by Steven Mandeville-Gamble Department of Special Collections Green Library Stanford University Libraries Stanford, CA 94305-6004 Phone: (650) 725-1022 Email: [email protected] URL: http://library.stanford.edu/spc © 2001 The Board of Trustees of Stanford University. All rights reserved. Special Collections M0997 1 Guide to the Stephen M. Cabrinety Collection in the History of Microcomputing, ca. 1975-1995 Collection number: M0997 Department of Special Collections and University Archives Stanford University Libraries Stanford, California Contact Information Department of Special Collections Green Library Stanford University Libraries Stanford, CA 94305-6004 Phone: (650) 725-1022 Email: [email protected] URL: http://library.stanford.edu/spc Processed by: Stephan Potchatek Date Completed: 2000 Encoded by: Steven Mandeville-Gamble © 2001 The Board of Trustees of Stanford University. All rights reserved. Descriptive Summary Title: Stephen M. Cabrinety Collection in the History of Microcomputing, Date (inclusive): ca. 1975-1995 Collection number: Special Collections M0997 Creator: Cabrinety, Stephen M. Extent: 815.5 linear ft. Repository: Stanford University. Libraries. Dept. of Special Collections and University Archives. Language: English. Access Access restricted; this collection is stored off-site in commercial storage from which material is not routinely paged. Access to the collection will remain restricted until such time as the collection can be moved to Stanford-owned facilities. Any exemption from this rule requires the written permission of the Head of Special Collections.